Neurosphere

Enthusiast

Thread Starter

- Mitglied seit

- 06.11.2008

- Beiträge

- 4.324

nVidia GF100/Geforce 4xx [Speku-, News- & Diskussionsthread]

Dies ist der Neustart des nVidia GT300 (40nm) DirectX 11 [Speku-, News- & Diskussionsthread] Part 4

Was ist bisher bekannt:

Beim Start verfügbare Karten: 480 GTX/470 GTX (News zu der Namensgebung)

Vorstellung der Karten am 26. März (News dazu)

Chip: GF100

Takt: Unbekannt

Speicher: vermutlich erstmal bis zu 1,5GB

Speicherart: GDDR5

Stromversorgung: 6+8 Pin (max. 300 Watt)

TDP: unbekannt

Länge der Karten: 267mm

Release: Derzeit unbekannt. Vermutungen gibt es aber das es zur Cebit neue Infos oder evtl sogar einen Launch geben könnte. (Cebit 2.-6. März, NV Standinfos,NVs Seite zur Cebit)

Der GF100 (aka Fermi)

Innerer Aufbau:

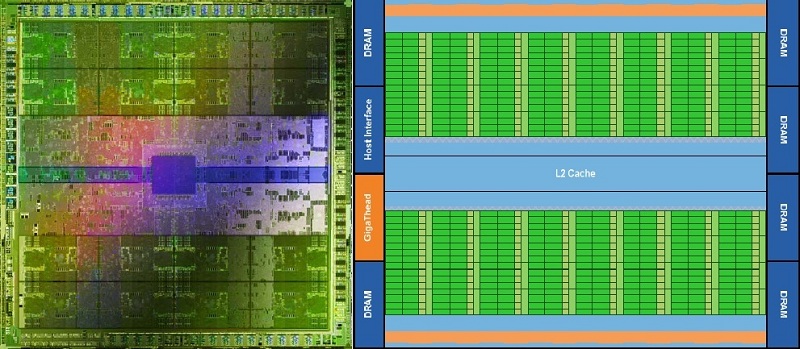

Die GPCs:

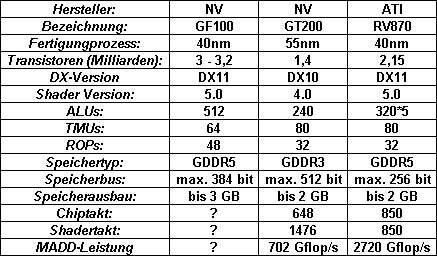

Der GF100 besteht aus Graphics Processing Clusters (kurz GPCs). Jeder GPC besteht aus 4 Streaming-Multiprocessors (SM),

in denen jeweils 4 Texture Mapping Units (TMUs) und 32 Arithmetic Logic Units (ALUs) untergebracht sind.

Nach derzeitigen Informationen kann der GF100 maximal 4 GPCs verwalten, womit er auf die besagten 512 "Cuda-Cores" (ALUs) und 64 TMUs kommt.

Besonders beim GF100 ist, das jeder GPC auf eine eigene Raster-Engine zurückgreifen kann. Alle bisherigen Designs und Architekturen hatten nur eine Raster-Engine die vor den Shaderclustern lag. Dadurch erhöht sich die Pixelleistung auf 32 Pixel pro Takt (4 GPCs x 8 Pixel) wodurch ein Flaschenhals aller bisherigen Architekturen beseitigt wurde und die Geometrieleistung überdurchschnittlich steigt. Deutlich zu sehen bekommt man dies an der Tesselationsleistung des GF100, nach NV-eigenen Folien ist diese zwischen 2 bis mehr als 6 mal so hoch wie die der 5870 von ATI.

Nun weiter zu den SM:

Zu jeder ALU gesellt sich eine Floating Point Unit (FPU). Der GF100 ist IEEE 754-2008-Standard kompatibel was ihn für GPGPU Aufgaben interessant macht.

Anders als der GT200 führt der GF100 pro Takt keine MADD+MUL Berechnung mehr aus sondern eine FMA. Das schmälert zwar auf den ersten Blick etwas die Rechenleistung pro ALU, allerdings erreicht FMA eine höhere Genauigkeit bei den Nachkommastellen, was ebenfalls wieder wichtig für GPGPU ist.

Die TMUs:

Auf den ersten Blick hat NV hier weniger verbaut als beim GT200. Allerdings soll die Taktrate nicht über den Chiptakt laufen sondern evtl in Richtung des Shadertaktes gehen, des weiteren soll die Effizienz aufgrund des größeren L1 (12 Kb Texture Cache + 64 Kb L1/Shared-Cache) und L2 Caches (768 Kb) weiter gesteigert worden sein. NV gibt für die TMUs bis zu 1,6 mal soviel Leistung wie beim GT200 an.

Die ROPs:

Die Raster Operation Processors (ROPs) wurden beim GF100 dahingehend überarbeitet, das es nun sechs ROP-Partitions gibt in denen jeweils 8 ROPs enthalten sind. Eine ROP kann nach einem Takt ein 32-Bit-Integer-Pixel, ein 16-Bit-Floating-Point-Pixel nach zwei Takten oder ein 32-Bit-FP-Pixel nach vier Takten ausgeben.

An Jeder ROP-Partition ist ein 64 Bit Speicherinterface angeschlossen womit der GF100 auf ein insgesammt 384bit breites Interface kommt.

Speicher und Interface:

NV gönnt dem GF100 ein 384 bit breites Speicherinterface (siehe oben) mit dem er maximal 6 GB Videospeicher ansprechen könnte. Die Speicherbandbreite wird dadurch gewährleistet das schneller GDDR5 verwendung findet. Die Taktrate des Speichers ist noch nicht bekannt, allerdings dürfte die Bandbreite bei über 200 GB/s liegen.

Features:

3D Vision Surround:

Der GF100 wird NVs neusten streich, 3D Vision Surround unterstützen. Damit ermöglicht der GF100 Stereoscopic 3D auf bis zu 3 Monitoren, allerdings nur wenn man zwei Karten sein eigen nennen kann.

32x CSAA:

Fermi bietet mit 32x CSAA einen neuen Antialiasing-Modus der auf 8x MSAA beruht. Jener soll laut NV eine bessere Bildqualität bieten als bisherige Modi. Ob NV in Zukunft SSAA anbieten wird ist unbekannt.

Blu-ray 3D:

Laut NV wird der GF100 die Dekodierung eines Blu-ray-3D-Films zu 100% übernehmen können.

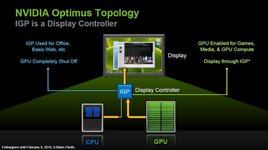

Optimus:

Optimus ist der Nachfolger von Hybrid-Power und wird mit allen Intel Notebook-Chipsätzen lauffähig sein. Dadurch ist es möglich die dedizierte Grafikkarte abzuschalten sobald diese nicht gebraucht wird und auf die Chipsatzgrafik zurückzugreifen. Dadurch erreicht man einen geringeren Stromverbrauch und längere Akkulaufzeiten.

Linkliste:

Neu:

Artikel:

Artikel auf CB zum GF100

Artikel auf PCGH

News:

TSMC hat Fertigungsprobleme behoben

Lauffähiges Fermisystem gesichtet

Sammelnews auf PCGH

Fermi debüt auf der Cebit

Die meisten Fermi-Karten im Q2 2010

News zu NVs kleineren ablegern auf 3DCenter (ursprung xbit Labs)

Geklaute 480er von Heise (Cebit)

Supermicro "Supercomputer" mit 4x Fermi (Cebit)

CB zum Fermi (Cebit)

Offizielles:

Deutsche Infoseite von NV zum GF100

NVs Facebook Seite

Zum Optimus Feature

Alte Links aus dem nVidia GT300 (40nm) DirectX 11 [Speku-, News- & Diskussionsthread]:

Artikel:

Artikel auf CB zum GF100

Artikel auf PCGH

News:

TSMC hat Fertigungsprobleme behoben

Lauffähiges Fermisystem gesichtet

Sammelnews auf PCGH

Fermi debüt auf der Cebit

Die meisten Fermi-Karten im Q2 2010

News zu NVs kleineren ablegern auf 3DCenter (ursprung xbit Labs)

Geklaute 480er von Heise (Cebit)

Supermicro "Supercomputer" mit 4x Fermi (Cebit)

CB zum Fermi (Cebit)

Offizielles:

Deutsche Infoseite von NV zum GF100

NVs Facebook Seite

Zum Optimus Feature

Alte Links aus dem nVidia GT300 (40nm) DirectX 11 [Speku-, News- & Diskussionsthread]:

http://www.hardware-infos.com/news.php?news=2663

http://www.fudzilla.com/index.php?option=com_content&task=view&id=11666&It emid=65

http://www.pcgameshardware.de/aid,6...iermal-so-schnell-wie-heute/Grafikkarte/News/

http://www.hartware.de/news_46678.html

http://www.computerbase.de/news/har...9/april/erste_direct3d-11-karte_nvidia_q4_09/

http://www.fudzilla.com/index.php?option=com_content&task=view&id=13002&It emid=65

http://www.hardware-infos.com/news.php?news=2871

http://www.hardware-infos.com/news.php?news=2891

http://www.hartware.de/news_46774.html

http://www.brightsideofnews.com/new...00-specifications-revealed---its-a-cgpu!.aspx

http://www.hardwareluxx.de/community/showthread.php?t=607119

http://www.hardware-infos.com/news.php?news=2904

http://www.computerbase.de/news/har...pril/kommt_nvidias_gt300_512_shadereinheiten/

http://www.hardware-infos.com/news.php?news=2930

http://www.computerbase.de/news/hardware/grafikkarten/nvidia/2009/mai/nvidia_gt300_512_bit_gddr5/

http://www.hardware-infos.com/news.php?news=2944

http://www.hardware-infos.com/news.php?news=2952

http://www.hardware-infos.com/news.php?news=2954

http://www.hardware-infos.com/news.php?news=2997

http://www.hartware.de/news_47143.html

http://www.computerbase.de/news/hardware/grafikkarten/2009/juni/gt300_rv870_wann_chips/

http://www.hardware-infos.com/news.php?news=3117

http://www.hartware.de/news_47452.html

http://www.hardware-infos.com/news.php?news=3225

http://www.hardware-infos.com/news.php?news=3226

http://www.hardware-infos.com/news.php?news=3227

http://www.hardware-infos.com/news.php?news=3228

http://www.hartware.de/news_47713.html

http://www.computerbase.de/news/hardware/grafikkarten/nvidia/2009/oktober/offiziell_fermi_gt300/

http://www.fudzilla.com/index.php?option=com_content&task=view&id=11666&It emid=65

http://www.pcgameshardware.de/aid,6...iermal-so-schnell-wie-heute/Grafikkarte/News/

http://www.hartware.de/news_46678.html

http://www.computerbase.de/news/har...9/april/erste_direct3d-11-karte_nvidia_q4_09/

http://www.fudzilla.com/index.php?option=com_content&task=view&id=13002&It emid=65

http://www.hardware-infos.com/news.php?news=2871

http://www.hardware-infos.com/news.php?news=2891

http://www.hartware.de/news_46774.html

http://www.brightsideofnews.com/new...00-specifications-revealed---its-a-cgpu!.aspx

http://www.hardwareluxx.de/community/showthread.php?t=607119

http://www.hardware-infos.com/news.php?news=2904

http://www.computerbase.de/news/har...pril/kommt_nvidias_gt300_512_shadereinheiten/

http://www.hardware-infos.com/news.php?news=2930

http://www.computerbase.de/news/hardware/grafikkarten/nvidia/2009/mai/nvidia_gt300_512_bit_gddr5/

http://www.hardware-infos.com/news.php?news=2944

http://www.hardware-infos.com/news.php?news=2952

http://www.hardware-infos.com/news.php?news=2954

http://www.hardware-infos.com/news.php?news=2997

http://www.hartware.de/news_47143.html

http://www.computerbase.de/news/hardware/grafikkarten/2009/juni/gt300_rv870_wann_chips/

http://www.hardware-infos.com/news.php?news=3117

http://www.hartware.de/news_47452.html

http://www.hardware-infos.com/news.php?news=3225

http://www.hardware-infos.com/news.php?news=3226

http://www.hardware-infos.com/news.php?news=3227

http://www.hardware-infos.com/news.php?news=3228

http://www.hartware.de/news_47713.html

http://www.computerbase.de/news/hardware/grafikkarten/nvidia/2009/oktober/offiziell_fermi_gt300/

Demovideos:

Ich bitte alle User die am Thread teilnehmen sich an eine gewisse Netiquette zu halten. Bitte lasst den Thread auch nicht zu einem Flamewar Rot gegen Grün verkommen sondern Spekuliert aufgrund bekannter Fakten über den GF100. Versucht eigene Meinungen so wenig wie möglich in euren Post einfließen zu lassen, ebenso sind eure Wünsche und Kaufpläne evtl für andere User uninteressant.

Zuletzt bearbeitet:

sogar frühzeitigiger wie geplant

sogar frühzeitigiger wie geplant