Was meine Frage ist: Dabei geht dann nur die Schreibrate runter , die Leserate bzw die Geschwindigkeit beim lesen (was ja wichtiger ist) bleibt enthalten

Die Leserate der SSD selbst kann bei einigen SSDs leiden, einfach weil sie wenn sie sehr voll sind die Daten nicht optimal über die NAND Dies verteilt schreiben können und damit danach nicht so schnell lesen können, denn die Geschwindigkeit kommt ja schon der Parallelität, aber bei SATA SSDs ist dies weniger ein Problem als bei NVMe SSDs und je mehr NAND Dies sie hat, umso weniger als bei solchen mit kleineren Kapazitäten, also weniger NAND Dies.

SSD werkelt aber im Hintergrund und optimiert sich selbst - evtl. ein Störfaktor. Sequentielle Leserate bleibt aber gleich, jedoch die Random/4K- Leserate geht ebenfalls runter,

Wieso sollte die 4k Leserate runtergehen? Hast Du dazu Belege? Es wird eher die sequentielle Leserate leiden, eben wegen der möglichen Einschränkungen bei der Verteilung beim Schreiben und die korrigieren die Controller in der Idle-GC nicht unbedingt, da dies die WA erhöhen würde und dazu kommt noch der Effekt des Filesystems. Denn je voller das Filesystem wird, umso mehr fragmentiert es die Dateien, die Fragmentierung ist einzig und alleine eine Sache des Filesystems und hat gar nichts damit zu tun wie die SSD die Daten intern speichert!

Wenn eine Datei fragmentiert ist, bedeutet dies das diese Dateie nicht im Stück ab einem bestimmten Cluster auf den darauffolgenden Cluster des Filesystems gespeichert wurd, sondern wie viele kleine Daten an unterschiedlichen Adressen abgelegt werden müssen, weil es keine Lücke in der Belegung gab die groß genug gewesen wäre sie am Stück aufzunehmen. Je mehr Dateien davon betroffen sind, umso höher ist der Fragmentierungsgrad des Filesystems. Die Aufteilung der Dateien auf die Cluster des Filesystems kann der Controller der SSD nicht beeinflussen, dies verwaltet alleine das Betriebssystem des Rechners und es Einfluss auf die Art der Zugriffe beim Lesen (und natürlich auch beim Schreiben) der betroffenen Datei, denn jedes Fragment muss einzeln gelesen werden, als wäre es eine eigene Datei. Damit werden statt einiger langer viele kürzere Zugriffe nötig um sie zu lesen und bei kurzen Zugriffen lesen SSDs langsamer als bei langen Zugriffen, vergleiche nur mal die 4k Lesend, der kürzeste Zugriff mit den seq. Lesenraten. Aber im Vergleich zu einer HDD muss die Fragmentierung bei einer SSD schon sehr stark sein um spürbar weniger Leseperformance zu ergeben, die Datei muss also wirklich in viele kleine Fragmente aufgeteilt sein, bevor man dies merken würde, zumal bei einer SSD mit vollem DRAM Cache. Bei einer DRAM less wäre es schlimmer, weil dann deren Controller schlimmstenfalls für jeden Cluster an dem Ein Fragment beginnt, erst den passenden Teil der Mappingtabelle aus dem NAND nachladen müsste.

Fragmentierung gibt es also SSDs genauso wie bei HDDs, weil es eben eine Sache des Filesystems und nicht des Mediums ist, weshalb aus die Idle-GC daran nichts ändern kann, sie beeiflusst ja nicht die Zuordnung der Dateien auf die Cluster des Filesystems, sondern nur wo die Daten für eine bestimmte externe Adrese im NAND stehen. Der Einfluss der Fragmentierung auf die Performance ist aber bei SSD ungleich geringer als bei HDDs.

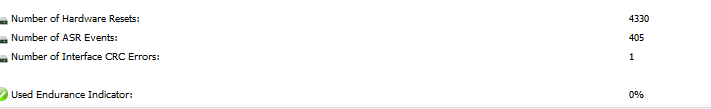

Bei HWINFO wird mir 1 Interface CRC Error angezeigt ..wie der Zustande gekommen ist ..eine Ahnung ?

Schau mal mit

CrystalDiskInfo auf den Rohwert vom Attribut C7, der dürfte bei Dir 1 sein und wenn er nicht weiter steigt, ist alles in Ordnung. Wenn er mit der Zeit ansteigt, gibt es ein Problem mit dem SATA Datenkabel, ggf. der Backplane eines Hot-Swap Rahmens, sollte Du sowas nutzen. Meist ist nur ein Steckt des Kabels nicht wirklich fest, aber manchmal hat das Kabel auch einen Schaden, dies passiert schnell wenn man mal am Kabel statt am Stecker gezogen hat, was ja auch manchmal schwer zu vermeiden ist. Diese Schäden sieht man den Kabeln nicht an, aber sie erzeugen halt hinterher dann Übertragungsfehler und genau diese zählt der Rohwert vom Attribut 0xC7. Es ist ein Lebenszeitzähler, er sollte also nicht steigen, denn wenn er steigt, dann bedeutet dies das neue Fehler aufgetreten sind. Wurde das Problem behohen, dann fällt er nicht wieder auf 0 zurück, was aber nicht schlimm ist, er darf nur nicht ansteigen.

:

: