Werbung

Mit den kommenden beiden neuen GPU-Architekturen bzw. "Graphics Core Next"-Ausbaustufen konzentriert sich vieles auf eine schnellere Speicheranbindung. AMD wird vermutlich in wenigen Wochen die "Fiji"-GPU vorstellen, die auf High Bandwidth Memory der 1. Generation setzt und damit auf eine Speicherbandbreite von 640 GB pro Sekunde kommt. Damit sprechen wir von einer Verdopplung der Speicherbandbreite gegenüber der aktuellen GPU-Generation mit schnellem GDDR5-Speicher. Mit der 2. Generation von HBM soll sich dieser Trend sogar noch weiter steigern und über 1 TB pro Sekunde möglich sein.

Offen ist derzeit aber die Frage, in wie weit die nächsten Grafikkarten von dieser hohen Speicherbandbreite profitieren werden. Bereits bei den aktuellen Karten führt der Blick immer wieder auf den Speicherausbau und dessen Anbindung. Bei der GeForce GTX 980 (Hardwareluxx-Artikel) haben wir dies untersucht und konnten keine echte Limitierung durch das nur 256 Bit breite Speicherinterface feststellen. Die Speicherkomprimierung der "Maxwell"-Architektur spielt bei NVIDIA in diesem Bereich offenbar aber auch eine entscheidende Rolle. Mit der GeForce GTX Titan X (Hardwareluxx-Artikel) und ihrem Speicherausbau von 12 GB spielte dann weniger die Anbindung als schlichtweg die Kapazität die entscheidende Rolle. Mehr als 6 oder 8 GB an Grafikspeicher, wie AMD es für die beiden "Fiji"-Karten plant, dürften auf absehbare Zeit wenig sinnvoll sein. Die 12 GB der GeForce GTX Titan X konnten wir nicht auslasten.

Doch zurück zu HBM: Die hohe Speicherbandbreite ist sicherlich einer der wichtigsten, aber nicht der alleinstehende Grund für den Einsatz dieses Speichers. Aktuelle GPU-Architekturen sowie der dazugehörige Speicher bzw. dessen Anbindung sind aufeinander abgestimmt. Es macht daher kaum Sinn ein aktuelles GPU-Design auf den schnelleren HBM zu übertragen und hier entsprechende Simulationen oder Hochrechnungen durchzuführen. Die weiteren Einflüssen von HBM sind weitestgehend unbekannt und lassen sich auch nicht simulieren. Sowohl AMD als auch NVIDIA haben sich bereits zum Einsatz von HBM geäußert und auch schon einige Details verraten, die wir uns nun etwas genauer anschauen wollen.

1. HBM hat eine geringere Leistungsaufnahme

Rückt der Speicher derart dicht in die Nähe der GPU, wird die Leistungsaufnahme zu einem entscheidenden Faktor, da die Abwärme auch irgendwie abgeführt werden muss. Einsparungen beim Stromverbrauch sind also weniger für den Nutzer auf der Stromrechnung interessant, als vielmehr für die Entwicklung der Grafikkarten bzw. GPUs. NVIDIA vergleicht die Leistungsaufnahme zwischen DRAM und HBM und kommt auf etwa 18-22 pJ/Bit bei DRAM und 6-7 pJ/Bit bei HBM. Dies entspricht einer Reduzierung auf 33 Prozent des ursprünglichen Verbrauchs.

2. HBM arbeitet mit niedrigeren Latenzen

Neben der Speicherbandbreite spielen auch möglichst geringe Latenzen eine wichtige Rolle. Dies kennen wir bereits in Form der Timings von klassischem Arbeitsspeicher. Aufgrund seines Aufbaus kann HBM mit unterschiedlichen Taktraten und Timings für die verschiedenen Stacks und Channel arbeiten. Diese unterschiedlichen Timings (tRC, tRRD, tRP, tFAW, etc.) könne entsprechend den Anforderungen unterschiedlich eingestellt und genutzt werden.

3. Single Refresh Bank/Cell bei HBM:

Klassischer DRAM-Speicher setzt in vorher definierten Zeiträumen eine Refresh-Operation voraus, welche den Inhalt des Speichers weiterhin nutzbar macht. Üblicherweise erfolgt dies in Zeiträumen von etwa 1 µs. Da während der Refresh-Operation keine anderen Operationen auf dem Speicher ausgeführt werden können, führt dies zu einem Overhead von 5 bis 10 % über der insgesamt zur Verfügung stehenden Speicherbandbreite. Je größer die Speicherkapazität wird, desto größer wird auch der Overhead durch die Refresh-Operationen.

Beim HBM kümmern sich die Controller einer Speicherbank eigenständig um die Refresh-Operationen und müssen diese auch nicht mehr simultan ausführen. Bis auf die Ebene einer einzelnen Speicherzelle herunter wäre ein eigenständiges Verhalten in dieser Hinsicht denkbar, aber nicht immer sinnvoll. Der Single Refresh Bank birgt also noch weiteres Optimierungspotenzial für AMD und NVIDIA bei der Verwaltung des Speichers.

4. Flexible Nutzung von ECC:

Sowohl AMD als auch NVIDIA bieten Grafikkarten mit Error-Correcting Code (ECC) Speicher an. Dabei werden eventuelle Übertragungsfehler oder solche in der Vorhaltung der Daten im Speicher erkannt und können auch wieder korrigiert werden. Allerdings sind diese Prozesse auch rechenintensiv und verschlingen einen Teil der zur Verfügung stehenden Speicherbandbreite bzw. des Speicherplatzes. Mit HBM können die einzelnen Stacks untereinander eigenständig operieren und für sich selbst festlegen, ob sie ECC verwenden oder nicht. Verwendet eine GPU demnach 8 GB an Grafikspeicher, können 4 GB durch ECC geschützt sein und die weiteren 4 GB verbleiben ohne Schutz durch ECC. Weiterhin sollen dabei die vollen 640 GB pro Sekunde an Speicherbandbreite zur Verfügung stehen.

5. Split Command Interfaces

Für jeden der 128 Bit breiten Channel können nicht nur unterschiedliche Frequenzen verwendet werden, sondern diese verwenden auch jeweils Command Interfaces, die unabhängig voneinander sind. Unterteilt sind diese in "Column Commands" (Read/Write) und "Row Commands" (ACT/PRE). Theoretisch ist der Speichercontroller damit in der Lage die Command-Bandbreite komplett zu saturieren, was letztendlich zu einer höheren Speicherbandbreite führt, ohne das zu viele weitere Commands übertragen werden müssen. Es erlaubt auch den Speichercontroller in der GPU im Aufbau einfacher zu gestalten - dazu kommen wir später noch.

6. HBM benötigt weniger komplexe Anbindung der GPU:

Speichercontroller in modernen GPUs kommen mit ihrem 256 oder 384 Bit breiten Speicherinterface auf eine beachtliche Komplexität innerhalb einer GPU-Architektur. Aber nicht nur die Komplexität spielt eine Rolle, sondern auch der Platz, den sie inzwischen im Design und bei der Fertigung benötigen. Mit HBM sollen die Bandbreiten und die Leistung generell steigen, dies wird aber nicht mit komplexeren Speichercontrollern erkauft, sondern diese sollen im Gegenteil sogar weniger komplex werden.

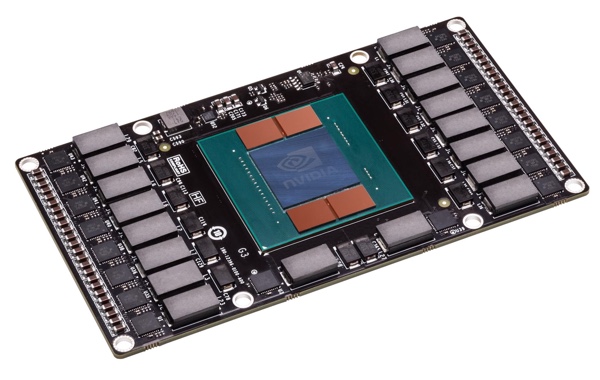

Dabei spielt auch die physikalische Anbindung eine Rolle, die nicht mehr über ein Ball Grid Array (BGA) erfolgt, sondern über Through-silicon Via (TSV) bzw. eine andere direkte physikalische Verbindung in direkter Nähe zwischen GPU und Speicher. Da HBM zunächst im 2,5D-Design neben der GPU untergebracht sein wird, werden diese Verbindungen direkt innerhalb des Interposer ausgeführt.

Zur Versorgung und Kommunikation mit Bauteilen oder Schnittstellen außerhalb des Trägers auf dem sich Speicher und GPU befinden, werden weiterhin Verbindungen über ein BGA verwendet.

7. Temperaturverhalten von HBM:

Durch eine geringere Speicherspannung sowie weitere Maßnahmen besitzt HBM nicht nur eine geringere Leistungsaufnahme, sondern produziert dementsprechend auch weniger Abwärme. Dazu werden sogenannte Thermal Dummy Bumps verwendet, welche das Abführen von Abwärme aus dem Inneren der Stacks erleichtern.

Die eben erwähnten Refresh-Operationen sind auch abhängig von der Temperatur (je wärmer der Speicher wird, desto häufiger müssen diese ausgeführt werden) und daher unterstützt HBM auch Temperature Compensated Self Refresh. Die Refresh Operationen werden dazu in bestimmten Temperaturbereiche eingeteilt, in denen sie unterschiedlich oft ausgeführt werden. Temperatursensoren im Speicher messen die aktuelle Temperatur und passen die Refresh Operationen dementsprechend an.

[h3]Vorläufiges Fazit[/h3]

High Memory Bandwidth ist also viel mehr als nur eine gestiegene Speicherbandbreite oder eine höhere Speicherkapazität. HBM bringt für Hersteller wie AMD und NVIDIA noch weitere Vorteile, die sich hinter den zugegebenermaßen wichtigen Standard-Kennzahlen (Speicherbandbreite und Speicherausbau) verstecken. Allerdings werden manche technische Teilbereiche auch deutlich komplexer, was auf Seiten des Speicherherstellers (bisher wird nur SK Hynix im Zusammenhang mit AMD und NVIDIA genannt) sowie der beiden Hersteller der GPUs für einen deutlichen Mehraufwand bei der Entwicklung sorgen wird bzw. schon gesorgt hat.

Schlussendlich wollen wir festhalten, dass aktuell Vergleiche (oder besser gesagt Simulationen und Hochrechnungen) zwischen 320 und 640 GB pro Sekunde oder 4 GB GDDR5 vs. 8 GB HBM wenig aussagekräftig sind. Das Zusammenspiel von GPU und Speicher ist inzwischen weitaus komplexer und da genügt es nicht an nur einer Stellschraube zu drehen. Wir werden also abwarten müssen, bis die ersten Karten mit HBM auf dem Markt sind und vermutlich werden uns AMD und NVIDIA noch genauer erklären, worin die Vorteile von HBM ihrer Meinung nach noch liegen. Einen ersten Ansatz haben wir versucht zu vermitteln. Letztendlich fehlt uns aber der tiefere Einblick in die Materie.