-

Hardwareluxx führt derzeit die Hardware-Umfrage 2025 (mit Gewinnspiel) durch und bittet um eure Stimme.

-

-

tcg antwortete auf das Thema Neuer AI-Server.Mal kurz ein ganz anderes Thema: Wollen wir mal einen KI-Laberthread aufmachen ? Finden neue evtl. einfacher. Ich hab aber auch kein...

tcg antwortete auf das Thema Neuer AI-Server.Mal kurz ein ganz anderes Thema: Wollen wir mal einen KI-Laberthread aufmachen ? Finden neue evtl. einfacher. Ich hab aber auch kein... -

tcg antwortete auf das Thema Neuer AI-Server.Gemma3:27b hat wohl ein Leak... Wie auch immer das bei LLMs geht...

tcg antwortete auf das Thema Neuer AI-Server.Gemma3:27b hat wohl ein Leak... Wie auch immer das bei LLMs geht... -

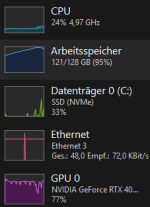

tcg antwortete auf das Thema Neuer AI-Server.hab den context erhöht, ja, aber das braucht vram, nicht gpu power... alles soweit original...

tcg antwortete auf das Thema Neuer AI-Server.hab den context erhöht, ja, aber das braucht vram, nicht gpu power... alles soweit original... -

tcg antwortete auf das Thema Neuer AI-Server.da ist die 4090 mit ~37 tps bei mir nicht so viel schneller ;-)

tcg antwortete auf das Thema Neuer AI-Server.da ist die 4090 mit ~37 tps bei mir nicht so viel schneller ;-) -

tcg antwortete auf das Thema Neuer AI-Server.Wie schnell rennt das denn bei dir ? Das ist bei mir brutal langsam ! Auch das 1b ist seeehr langsam. geht hier nur das 27b...

tcg antwortete auf das Thema Neuer AI-Server.Wie schnell rennt das denn bei dir ? Das ist bei mir brutal langsam ! Auch das 1b ist seeehr langsam. geht hier nur das 27b... -

tcg antwortete auf das Thema [Sammelthread] Gigabyte MC12-LE0 (AM4, B550, servertauglich: IPMI, Dual Lan, ECC).seh ich das richtig, kann man die stacken ??? also z.b. 2 davon für 4x4x4x4 ?

tcg antwortete auf das Thema [Sammelthread] Gigabyte MC12-LE0 (AM4, B550, servertauglich: IPMI, Dual Lan, ECC).seh ich das richtig, kann man die stacken ??? also z.b. 2 davon für 4x4x4x4 ? -

tcg antwortete auf das Thema Neuer AI-Server.mit 24GB kommst du schonmal recht weit ...

tcg antwortete auf das Thema Neuer AI-Server.mit 24GB kommst du schonmal recht weit ... -

tcg antwortete auf das Thema Neuer AI-Server.schöne karte, wahrscheinlich auch angenehm schnell. wenn man es schaffen würde auch die performance aufzuaddieren... dann wären 3 *...

tcg antwortete auf das Thema Neuer AI-Server.schöne karte, wahrscheinlich auch angenehm schnell. wenn man es schaffen würde auch die performance aufzuaddieren... dann wären 3 *... -

tcg antwortete auf das Thema Neuer AI-Server.mit einer 5070ti/16gb kommst du schon recht weit. damit gehen übliche 14b modelle schon mal. allerdings: wenn du context willst brauchst...

tcg antwortete auf das Thema Neuer AI-Server.mit einer 5070ti/16gb kommst du schon recht weit. damit gehen übliche 14b modelle schon mal. allerdings: wenn du context willst brauchst... -

tcg antwortete auf das Thema Neuer AI-Server.also chatgpt lokal benutzen und einfach mal spielen ;-) wie ich auch... ja, der gedanke passt soweit. ich hatte mir mal die 4060/16gb...

tcg antwortete auf das Thema Neuer AI-Server.also chatgpt lokal benutzen und einfach mal spielen ;-) wie ich auch... ja, der gedanke passt soweit. ich hatte mir mal die 4060/16gb... -

tcg antwortete auf das Thema Neuer AI-Server.Im Prinzip ja. Du kannst GPUs "stacken" (ich hab hier 10 im Server) und dann größere Modelle laufen lassen. Was genau hast du vor ...

tcg antwortete auf das Thema Neuer AI-Server.Im Prinzip ja. Du kannst GPUs "stacken" (ich hab hier 10 im Server) und dann größere Modelle laufen lassen. Was genau hast du vor ... -

tcg antwortete auf das Thema Neuer AI-Server.hab mal gefragt, aber meine frau hat gesagt 50k sind gerade nicht drin :-(

tcg antwortete auf das Thema Neuer AI-Server.hab mal gefragt, aber meine frau hat gesagt 50k sind gerade nicht drin :-( -

tcg antwortete auf das Thema Neuer AI-Server.ich tippe eher auf 30-50k

tcg antwortete auf das Thema Neuer AI-Server.ich tippe eher auf 30-50k -

tcg antwortete auf das Thema Neuer AI-Server.Ja, hab schon mehrere Versuche durch... Bis auf ollama selbst compilieren. Ich hoffe ja noch dass es irgendwann läuft.

tcg antwortete auf das Thema Neuer AI-Server.Ja, hab schon mehrere Versuche durch... Bis auf ollama selbst compilieren. Ich hoffe ja noch dass es irgendwann läuft. -

tcg antwortete auf das Thema Neuer AI-Server.Die sind gar nicht mal so langsam... "Wormhole™ n300 performs at up to 466TFLOPS (FP8)." (Zum Vergleich: 4090 = 661 FP8-TFLOPS) Die...

tcg antwortete auf das Thema Neuer AI-Server.Die sind gar nicht mal so langsam... "Wormhole™ n300 performs at up to 466TFLOPS (FP8)." (Zum Vergleich: 4090 = 661 FP8-TFLOPS) Die...

-

-

Laden...

-

Laden...