besterino

Legende

Thread Starter

- Mitglied seit

- 31.05.2010

- Beiträge

- 7.637

- Desktop System

- Rechenknecht

- Laptop

- Lenovo Legion 5 (Intel, 4080, 32GB)

- Details zu meinem Desktop

- Prozessor

- Intel i9-13900KS@6300

- Mainboard

- ASUS Maximus Z790 Hero

- Kühler

- Kryo Next S1700, 2xMora 420, Tube 150, 2x Apex VPP, Aquaero 6 Pro, DFS High Flow USB, Farbwerk360

- Speicher

- 32GB (2x16GB @7600)

- Grafikprozessor

- Inno3D RTX 4090 Frostbite

- Display

- 55" OLED (Dell AW5520QF)

- SSD

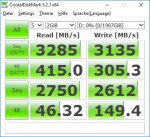

- 2x4TB NVME PCIe 5.0, Rest (~12TB NVME) über SMB Direct

- HDD

- Näh. Technik von gestern.

- Opt. Laufwerk

- Näh. Technik von gestern.

- Soundkarte

- Cambridge Audio DacMagic 200M

- Gehäuse

- Lian-Li DK-05F

- Netzteil

- Corsair 1000HXi

- Keyboard

- Keychron Q6 Pro, Maxkeyboard Custom Caps, Black Lotus / Dolphin Frankenswitch, Everest Pads

- Mouse

- Swiftpoint Z2

- Betriebssystem

- Windows 11 Pro for Workstations (SMB Direct - yeah baby)

- Sonstiges

- Mellanox ConnectX-4 (Dual 100Gbit Netzwerk + WaKü), Rode NT-USB, Nubert ampX uvm. ...

Wahrscheinlich für unsere Community nicht so richtig passend und generell wohl auch ein eher schwieriges / spezielles Thema.

Aber ich versuch' das mal trotzdem:

Auch wir beschäftigen uns gerade mit der Frage, was in Sachen Digitalisierung "so geht" bzw. so kommen könnte. Und wenn man sowas macht, dann kann man ja bei der Gelegenheit eben auch ein oder zwei Schritte weiter denken (und dann ggf. auch gehen) und mal grübeln, welche geschäftlichen Betätigungsfelder zukünftig nicht mehr zwingend von Menschen erledigt werden müssen.

Die Erkenntnis im Haus geht schon in die Richtung, dass da "irgendwas" für uns Relevantes kommen wird und wir uns da wohl durchaus "irgendwie" engagieren müssen. Und müssen. Und wenn man so konkrete Vorstellungen hat (Achtung Ironie), muss man mit dem Ganzen ja auch mal in die Umsetzung...

Nun denn.

Die erste Marktübersicht habe ich immerhin. Jedenfalls soweit das überhaupt möglich ist, da ja quasi täglich neue Startups entstehen. Aber: so richtig marktreif - für unser Betätigungsfeld - ist da noch nichts. Insgesamt stecken ja Technik und Anwendungen noch in den Kinderschuhen, so dass man hier schnell auf Ebene "Grundlagenforschung" unterwegs ist, als über konkrete Applikationen zu sprechen. Macht aber nichts, kann ja auch Spaß machen...

Vor dem Hintergrund sind wir uns auch bewusst, dass es hier um (ggf. signifikatne) Investitionen geht, wo der "Return" durchaus zweifelhaft ist.

Gibt es hier andere, die sich mit der Materie (professionell) beschäftigen?

Hängt bei Euch bereits ein DGX-1 oder der neue Power 8 im Rack, nutzt Ihr IBM's Watson (Explorer), habt Ihr dafür was in der Cloud oder steckt Ihr noch in den nVidia Tutorials?

Aber ich versuch' das mal trotzdem:

Auch wir beschäftigen uns gerade mit der Frage, was in Sachen Digitalisierung "so geht" bzw. so kommen könnte. Und wenn man sowas macht, dann kann man ja bei der Gelegenheit eben auch ein oder zwei Schritte weiter denken (und dann ggf. auch gehen) und mal grübeln, welche geschäftlichen Betätigungsfelder zukünftig nicht mehr zwingend von Menschen erledigt werden müssen.

Die Erkenntnis im Haus geht schon in die Richtung, dass da "irgendwas" für uns Relevantes kommen wird und wir uns da wohl durchaus "irgendwie" engagieren müssen. Und müssen. Und wenn man so konkrete Vorstellungen hat (Achtung Ironie), muss man mit dem Ganzen ja auch mal in die Umsetzung...

Nun denn.

Die erste Marktübersicht habe ich immerhin. Jedenfalls soweit das überhaupt möglich ist, da ja quasi täglich neue Startups entstehen. Aber: so richtig marktreif - für unser Betätigungsfeld - ist da noch nichts. Insgesamt stecken ja Technik und Anwendungen noch in den Kinderschuhen, so dass man hier schnell auf Ebene "Grundlagenforschung" unterwegs ist, als über konkrete Applikationen zu sprechen. Macht aber nichts, kann ja auch Spaß machen...

Vor dem Hintergrund sind wir uns auch bewusst, dass es hier um (ggf. signifikatne) Investitionen geht, wo der "Return" durchaus zweifelhaft ist.

Gibt es hier andere, die sich mit der Materie (professionell) beschäftigen?

Hängt bei Euch bereits ein DGX-1 oder der neue Power 8 im Rack, nutzt Ihr IBM's Watson (Explorer), habt Ihr dafür was in der Cloud oder steckt Ihr noch in den nVidia Tutorials?

Bin wieder aufs Forum gestoßen, da ich plane mir eine kleine Workstation mit ein wenig GPU-Power zu bauen.

Bin wieder aufs Forum gestoßen, da ich plane mir eine kleine Workstation mit ein wenig GPU-Power zu bauen.

,...)

,...)