HWL News Bot

News

Thread Starter

- Mitglied seit

- 06.03.2017

- Beiträge

- 115.245

... weiterlesen

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: this_feature_currently_requires_accessing_site_using_safari

. Ist die Bildqualität denn immer identisch bei gleichter Bitrate ?

. Ist die Bildqualität denn immer identisch bei gleichter Bitrate ?Ist die Bildqualität denn immer identisch bei gleichter Bitrate ?

Die Bildqualität ist nicht zu unterscheiden.

Nennst du das nicht zu unterscheiden: https://snipboard.io/Run9kH.jpg ? Übrigens siehts in Bewegung noch schlimmer aus. Und bei Realvideo ist es noch schlimmer: Nvenc gegen x264 software 2-passDie Bildqualität ist quasi nicht zu unterscheiden.

Ja klarGeht mit NVENC eigentlich 2pass?

Eigentlich nicht, die hatten Cuda und OpenCL seit der letzten Eiszeit. Und an den Settings bzw. der letztlich finalen Qualität haben die keinen Einfluss ist von der Version des Hardware Encoders abhängig.Das halte ich für ein Gerücht. Bei gleicher Bitrate sind je nach Settings teilweise massive Unterschiede zu erkennen. Trotz NVENC, was übrigens schon seit längerem möglich ist, hängt Adobe Premiere z.b. Da Vinci Resolve noch immer hinterher (Was Hardwarenutzung angeht)

Die 2080ti hat ja den Volta NVENC, wie alle Turings mit Ausnahme der GTX 1650. Ist schon möglich das man fast nichts mehr erkennt. Minimaler Vorteil vllt. noch bei exakt den selben Einstellungen für die CPU, dabei halt je nach Setup deutlich schneller. GeForce 2080Ti ist schon ein Monster, wenn man so Sachen wie madVr und die AI Scaler noch mit ins Boot nimmt, wird die mit entsprechender Software zum Alleskönner.Die Bildqualität ist quasi nicht zu unterscheiden.

Sieht nicht nach Volta Encoder aus, von wann bzw. wo ist dieses Bild ? Ich würde es nicht so ausdrücken wie Don, aber der Nvidia Encoder entspricht in etwa x264 preset middle, wenn nicht noch höher ab Turing, sprich je nach Bitrate fast nicht mehr sichtbar ob GPU-oder-CPU.Nennst du das nicht zu unterscheiden: https://snipboard.io/Run9kH.jpg ? Übrigens siehts in Bewegung noch schlimmer aus. Und bei Realvideo ist es noch schlimmer: Nvenc gegen x264 software 2-pass

Nein, die Radeons haben auch unterschiedliche Decoder Level. Daher hat man bei AMD wohl auch den erweiterten Pro Support der 7 gekappt bzw. nicht geliefert, die Karte müsste für deutlich weniger Geld die WX 8200 beispielsweise stehen lassen eigentlich.Das ist auch Unsinn.... Radeon Pro Karten haben den gleichen Encoder wie die Consumer Varianten.

@Namenlos

Es geht auch das beides gleich aussieht, allerdings muss man denn mit den GOPs usw. spielen. Aber das bei gleichen Settings die Qualität gleich ist stimmt einfach nicht!

@Infi88

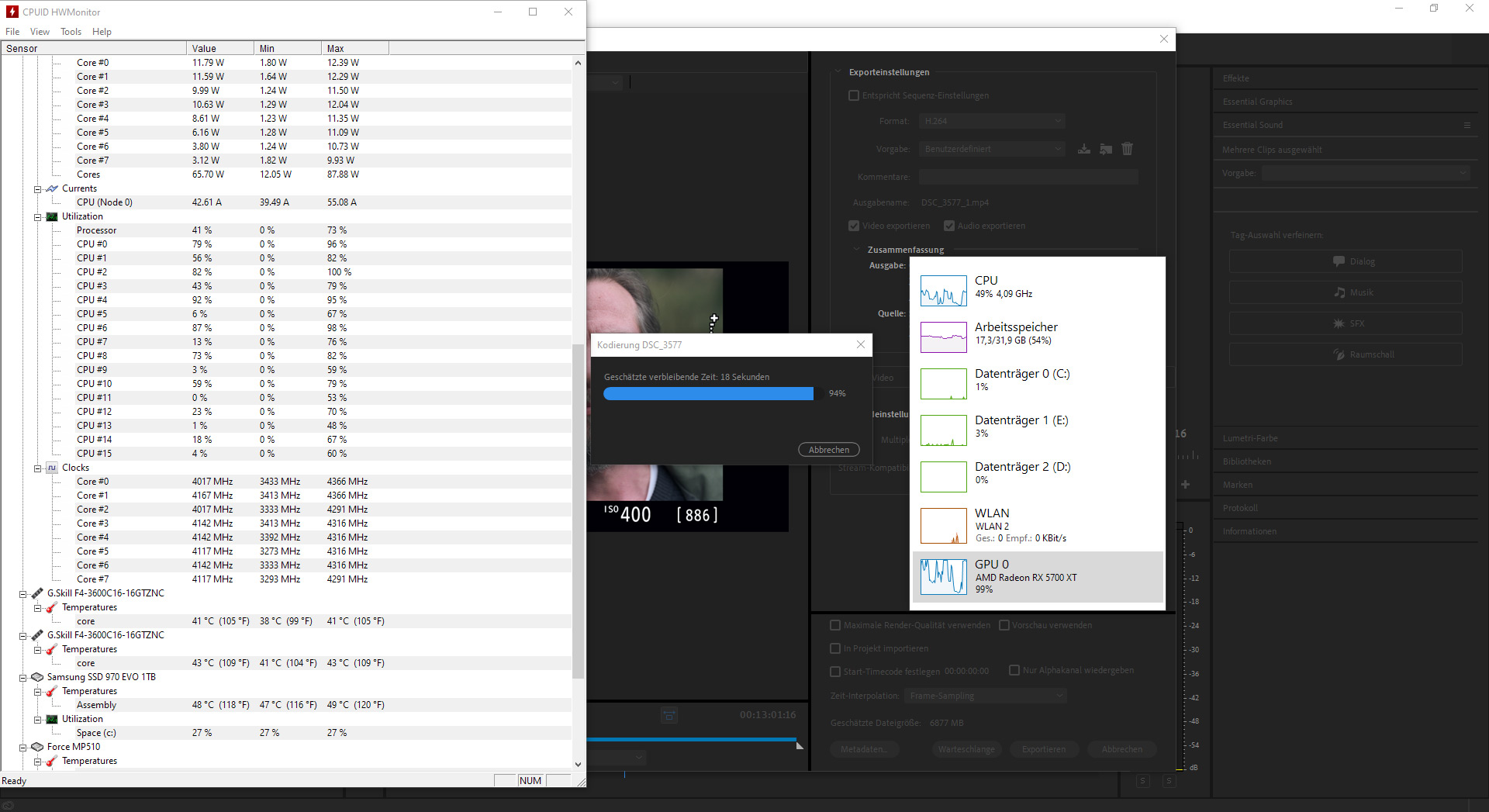

Also bei meiner Vega VII und der RadeOn Pro 9100WX sind die Encoder identisch. Ebenso ist der Encoder der 5700XT identisch mit den der W5700X. Und ja, Adobe setzt seit Ewigkeiten auf CUDA bzw. OpenCL in der Timeline, und auch da nur bei bestimmten Operationen. Bei DaVinci Resolve wird bei fast allen die GPU mit genutzt. Editieren, Korrekturen, Transformationen, Encoding usw. Schau dir mal Test an "Premiere vs FinalCut vs DaVinci" Da landet Premiere teilweise um Faktor 3 hinter den Anderen.

FinalCut ist doch MacOS. Wen interessiert die Software beim Hardware-Encoding und FFmpeg, da kannste jede Russensoftware in den Ring werfen und dich tot vergleichen. Wenn die Parameter gesetzt sind wird das Ergebnis das selbe sein, zumindest in der Bildqualität/Bitrate/Zeit, außer die Karte hat ein anderen Encoder/Decoder verbaut der in der GPU hängt.@Infi88

Also bei meiner Vega VII und der RadeOn Pro 9100WX sind die Encoder identisch. Ebenso ist der Encoder der 5700XT identisch mit den der W5700X. Und ja, Adobe setzt seit Ewigkeiten auf CUDA bzw. OpenCL in der Timeline, und auch da nur bei bestimmten Operationen. Bei DaVinci Resolve wird bei fast allen die GPU mit genutzt. Editieren, Korrekturen, Transformationen, Encoding usw. Schau dir mal Test an "Premiere vs FinalCut vs DaVinci" Da landet Premiere teilweise um Faktor 3 hinter den Anderen.

, wie sollen die bitte hinterher hängen ? Wer sollte die Hardware Decoder sonst nutzen, das ist mit die am weitesten verbreiteste Software dafür, macht für mich keinen Sinn was du schreibst.

, wie sollen die bitte hinterher hängen ? Wer sollte die Hardware Decoder sonst nutzen, das ist mit die am weitesten verbreiteste Software dafür, macht für mich keinen Sinn was du schreibst.Lmao, natürlich. https://www.hardwareluxx.de/index.p...kommt-radeon-pro-software-unterstuetzung.html.Du kannst es gerne nachschauen dass die professionellen AMD Karten auf die gleichen EnCoder setzen wie die Spielekarten. Auch vom Treiber wird da nicht beschnitten. Bei den Karten von AMD wird kein unterschied gemacht ob Spielekarte oder professionelle Karte.

Du hast ihn wieder nicht verstanden...Dafür gibt es ja jetzt die Pro 7 https://www.hardwareluxx.de/index.p...ro-vii-mit-vega-20-gpu-und-16-gb-hbm-vor.html.

Mit der Instinct M150 baugleich, die R7 wurde nur als Spielerkarte vermarktet im Prinzip ist es eine HPC Karte mit Treiberflaggs für Spiele und mehr Clockspeed.

Die 5700XT kam zumindest vor der Radeon Pro 7, ist Navi und hat VCN 2.0, kein VCE 4.1 +2x UVD 7.2, verhalten sich völlig unterschiedlich.

Die hier zum Vergleich ran gezogene Radeon Pro WX8200 hat ebenfalls logischerweise ihre eigenen Specs, können aber auch beim encoding einen Unterschied machen, nix überall das selbe Kollege.

Wen interessiert deine Haarspalterei. Ich habe sie selbst alle gelistet um zu verdeutlichen das es der selbe Chip ist, aber die R7 ein anderes Verhalten an den Tag legen wird beispielsweise weil es eine Spielerkarte ist die Beschränkungen hat.Du hast ihn wieder nicht verstanden...

Zunächst mal: Die Instinct heißt MI50, das ist ein großes i für Instinct, die 50 steht für die Rechenleistung, das ist kein 150 (du hättest also die Rechenleistung mal eben verdreifacht). Und die Karte nutzt die Vega20 GPU, genau wie die Radeon VII, die MI60 und jetzt neu die Pro7. Alle haben daher auch keinen Unterschied in der Video Einheit.

Und bei der 5700XT kommt Navi10 zum Einsatz. Der hat natürlich eine andere Video Einheit als Vega20. Aber Navi10 ist nicht nur in der 5700XT, 5700 und 5600XT, sondern auch in der W5700X, welches eine Pro Karte ist. Daher haben diese Karten wiederum alle die baugleiche Video-Einheit.

Entscheidend ist daher der zugrunde liegende Grafikchip. Der muss entsprechend unterstützt werden. Egal ist hingegen, ob es eine Pro oder Consumer Karte ist, da in beiden Bereichen die selben Chips verbaut werden und die Treiber keine Einschränkung machen.

Ich stimme @Namenlos da zu. NVENC ist echt schnell aber das geht auf die Bildqualität. Zum Streamen (was wohl der Haupteinsatzzweck ist) ist es gut. Aber für z. B. Handbrake, was ich regelmäßig nutze, ist es für die Tonne. Qualität ist ein riesen unterschied zu ffmpeg, was über CPU dann eben läuft.Die Bildqualität ist quasi nicht zu unterscheiden.

"Some" ist in diesem Kontext ziemlich untertrieben.HandBrake also includes support for AMD VCE, Intel QSV, and Nvidia NVENC hardware encoders. These encoders produce H.264 and/or H.265 video at extremely high speed, at the expense of some quality and larger file sizes.

Wen interessiert deine Haarspalterei. Ich habe sie selbst alle gelistet um zu verdeutlichen das es der selbe Chip ist, aber die R7 ein anderes Verhalten an den Tag legen wird beispielsweise weil es eine Spielerkarte ist die Beschränkungen hat.

Die Karten heißen und kosten deutlich unterschiedlich weil sie eben Software und Treibersupport haben, inklusive eigenem Süppchen für Apple. Die hier verwendete Radeon Pro WX8200 hat aber andere Specs inklusive Hardwareencoder = anderes Ergebnis, daher die Erwähnung.

Romsky meinte die Software würde hinterherhinken und hat ne Radeon 7 die eben keinen Pro-Support bietet. Da kann es schon mal glitchen, aber auch das spielt eigentlich keine Rolle vorausgesetzt das anwerfen des Encoders funktioniert beim Vergleich eines Videos. Eine Radeon Pro 7 hätte aber ein völlig anderes Ergebnis, weil ein anderer Hardwareencoder drin ist, der macht den meisten Anteil aus bei GPUs im Bezug auf Qualität/Bitrate/Zeit.

Die ganze Geschichte vom Pro Treiber beruht lediglich auf besagte "Pro Software" wie Catia, SolidWorks, Maya und co.

Die ganze Geschichte vom Pro Treiber beruht lediglich auf besagte "Pro Software" wie Catia, SolidWorks, Maya und co.Api und Treiber sind fundamental für so etwas, Nvidia hat sogar spezial Treiber dafür, ODE für stabile längere Zeit und QNF mit mehr Risiko und etwas schneller, du hast glaube ich noch nie Treibercode gesehen in deinem Leben.Dann lasse ich dich mal, in dem Falle, Irrglauben.

Das die Spielekarten im Bezug auf den Encoder, und nur um den geht es hier, keinerlei Beschränkungen hat und auch von der Hardware komplett gleich ist habe ich dir gesagt und konnte ich auch schon testen. Im Bereich Encoding/Decoding gibt es keinerlei Unterschiede, weder in HW noch in SW. Die Workstationkarten haben Ihre Vorzüge im Bereich von SolidWorks, Maya, CAD und co, da wo zum Beispiel der OpenGL Treiber zum Einsatz kommt. Das tut er meist nur im Viewport.

Die RadeOn Pro 7 hat den gleichen Encoder wie die Vega VII... komplett identisch. Den Unterschied macht nur der Treiber, welcher beim Encoding nicht zum Einsatz kommt, siehe meine Ausführungen in Bezug auf OpenGL usw. Und noch was, in Bezug auf Pro Software.... die Adobe Produkte profitieren da genau "0,0" von!Die ganze Geschichte vom Pro Treiber beruht lediglich auf besagte "Pro Software" wie Catia, SolidWorks, Maya und co.

Der Hardware-Encoder ist entscheidend Brudi, sonst gehen der GPU zu viele Informationen abhanden.Ich stimme @Namenlos da zu. NVENC ist echt schnell aber das geht auf die Bildqualität. Zum Streamen (was wohl der Haupteinsatzzweck ist) ist es gut. Aber für z. B. Handbrake, was ich regelmäßig nutze, ist es für die Tonne. Qualität ist ein riesen unterschied zu ffmpeg, was über CPU dann eben läuft.

Aber ich lass dich jetzt mal in deinem Glauben, da ich merke dass es einfach nichts bringt. Teste es einfach selber aus, so wie ich es gemacht habe, und du wirst ganz schnell merken dass du auf dem Holzweg bist.

Aber ich lass dich jetzt mal in deinem Glauben, da ich merke dass es einfach nichts bringt. Teste es einfach selber aus, so wie ich es gemacht habe, und du wirst ganz schnell merken dass du auf dem Holzweg bist.Verstehe, also ist der Nachfolger dennoch besser sodas dieser mit weniger Bitrate die selbe leistung wie mit ner gtx 1060 erreichen kann. Das ist ja sehr interessant. Achja die gtx 1660 hat übrigens den selben Decoder wie bei den rtx Grafikkarten, sofern diese Infos ja richtig sei.genau richtig erkannt gpu zwar schneller aber braucht zwingend mehr bitrate um dasselbe Ergebnis zu haben wie mit cpu

Und ja der gpu encoder kann nur so schnell sein wie der höchst taktende cpu kern

eine gtx1060 hat im übrigen denselben encoder wie eine gtx1080ti

Andere modelle wie turing rtx haben einen Neuen hardware encoder der effizienter ist und somit weniger bitrate braucht aber immer noch nicht auf de niveau einer crf oder cq cpu encoding

Crf 18 ist übertrieben

Im übrigen das flimmern kommt vom interlaced, dies sollte per gpu automatisch entfernt werden in playern (vlc und co)

mein rat mit lanzos auf progressiv umwandeln

Daher nehme ich für den schnitt vegas pro oder movie studio ab 2015 (beides dieselbe softwarebasis)

Und rendere alles in rgb uncompressed um dann progressiv in meine endergebnisse umzuwandeln

meist hevc 406p und 720p 25-50hz

Und ja der gpu encoder kann nur so schnell sein wie der höchst taktende cpu kern