HWL News Bot

News

Thread Starter

- Mitglied seit

- 06.03.2017

- Beiträge

- 115.245

... weiterlesen

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: this_feature_currently_requires_accessing_site_using_safari

www.hardwaretimes.com

www.hardwaretimes.com

Mit dem nächsten Treiber Update macht meine 5 Euro Kaffeemaschine auch nen Espresso ;DBzgl. FidelityFX gibt es ja Gerüchte, dass es bald mit einem neuen Treiber kommen soll:

AMD FidelityFX Super Resolution and Enhanced Radeon Boost Coming in Spring Adrenaline Update | Hardware Times

Ever since the RDNA based graphics cards were launched, AMD has been working on the software side of its GPU Eco-system. The Radeon Software Adrenaline 2020 Edition was one of the largest revamps of the control panel in years. Radeon Boost which is essentially a driver-centric implementation of...www.hardwaretimes.com

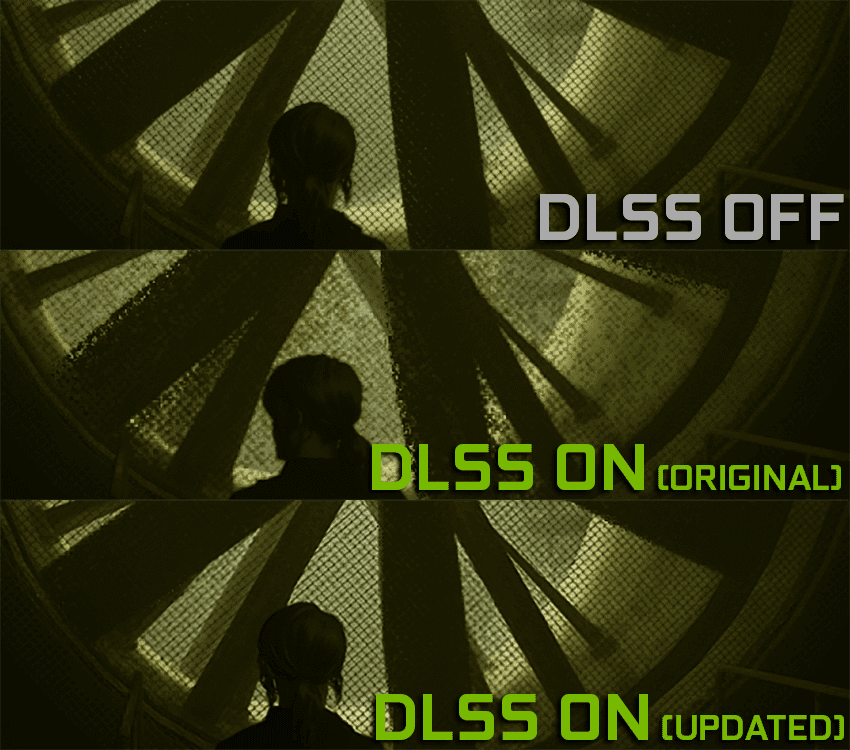

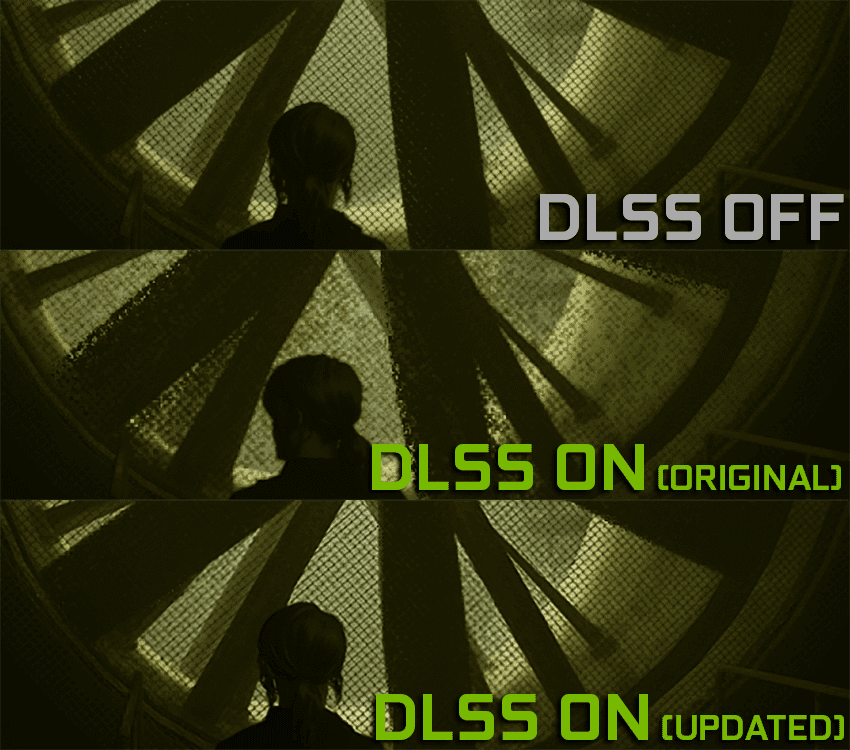

DLSS 1.0 war ja zu anfang auch voll der rotz aber nun ist das ja wirklich richtig gut.

Die Unreal Engine soll DLSS bald unterstützen. Da wird man sehen was kleinere Studios damit dann erreichen können.habe da aber mal gelesen das es wohl recht komplex sein soll DLSS richtig zu implementieren.

Das tut sie inzwischen out of the box schon bzw. per Plugin war das schon länger möglich. Die Liste der Titel mit DLSS wächst beinahe täglich.Die Unreal Engine soll DLSS bald unterstützen. Da wird man sehen was kleinere Studios damit dann erreichen können.

Im Besten Fall gibt es dann eine gleichwertige Einstellung für Nvidia und für AMD.Die Unreal Engine soll DLSS bald unterstützen. Da wird man sehen was kleinere Studios damit dann erreichen können.

Was AMDs Lösung angeht - sie werden sich beweisen müssen. Alle Platformen zu unterstützen kann leider auch ein Nachteil sein weil...

Ich fürchte sie könnten das Selbe spiel wie mit Freesync abspulen: Günstiger und freier/verbreiteter, aber dafür eben nicht ganz an der Konkurenz ran.

Problem ist, Karten werden sehr lange nicht die Games mit 4k mit ALLEN Reglern rechts rendern können. Ich rechne mit 5-7 Jahren. Bis dahin ist so eine Technik durchaus eine gute Alternative.Ich lese immer nur:

Seht her unsere Grafikkarten sind zu langsam, deshalb gibts jetzt ein Buzzword-Upscaler und gegen das Matchebild dann den Buzzword-Nachschärfer...

Sobald die Karten dann mal schnell genug sind wird das Zeug wieder eingestapft weil es einen Mehraufwand bedeutet.

was mit DLSS eingespart werden kann, sollte lieber dahin fließen.

Ich finde DLSS sieht nicht besser aus, sobald man mehr als die erste Stufe hinzugefügt, fängt das Bild an sich teilweise zu verfälschen... Es ist nicht schlecht um um nochmal einen Performance Boost zu bekommen ohne optische Einschlüsse zu erhalten, aber zu viel DLSS bringt zwar krasse Performance aber auch krasse Veränderung, es ist noch weit entfernt optimal zu sein. Vor allem wenn Spieleentwickler soviel Zeit rein stecken müssen damit es nutzbar wird.

Denn das trifft es perfekt. Ich glaube nicht das Cyberpunk wirklich schlecht ist, es ist einfach noch nicht marktreif. Gleiches gilt auch für Kommende Releases wie ME:Legendary, da darf man sich getrost zurücklehnen und andere Betatesten lassen, ansonsten darf man sich nicht beschweren wenn die die ME-Andromeda-Masche wieder durchziehen. Heute noch zu erwarten dass ein Spiel bei Launch spielbar ist wäre utopisch.DLSS & RT hilft mir auch nix wenn das Spiel scheisse ist.