Also 5W im Leerlauf (single Monitor 3.840 × 2.160, 60 Hz) für die 7600 ist wohl spitze. Aber wenn beim Fenster bewegen eine 7600 25W braucht und eine 4090 27W, aber 6650 XT 14W und eine 4060 Ti 16W, dann kann ich emotional nur die Nase rümpfen, 3.840 × 2.160, 60 Hz.

Oder Dual-Monitor 3.840 × 2.160, 60 Hz + 144 Hz eine 7600 32W will, eine 4090 31W und eine 4060 Ti 17W, dann sind emotional die 31W einer 4090 völlig super und eine 7600 erscheint dabei als richtig schlecht.

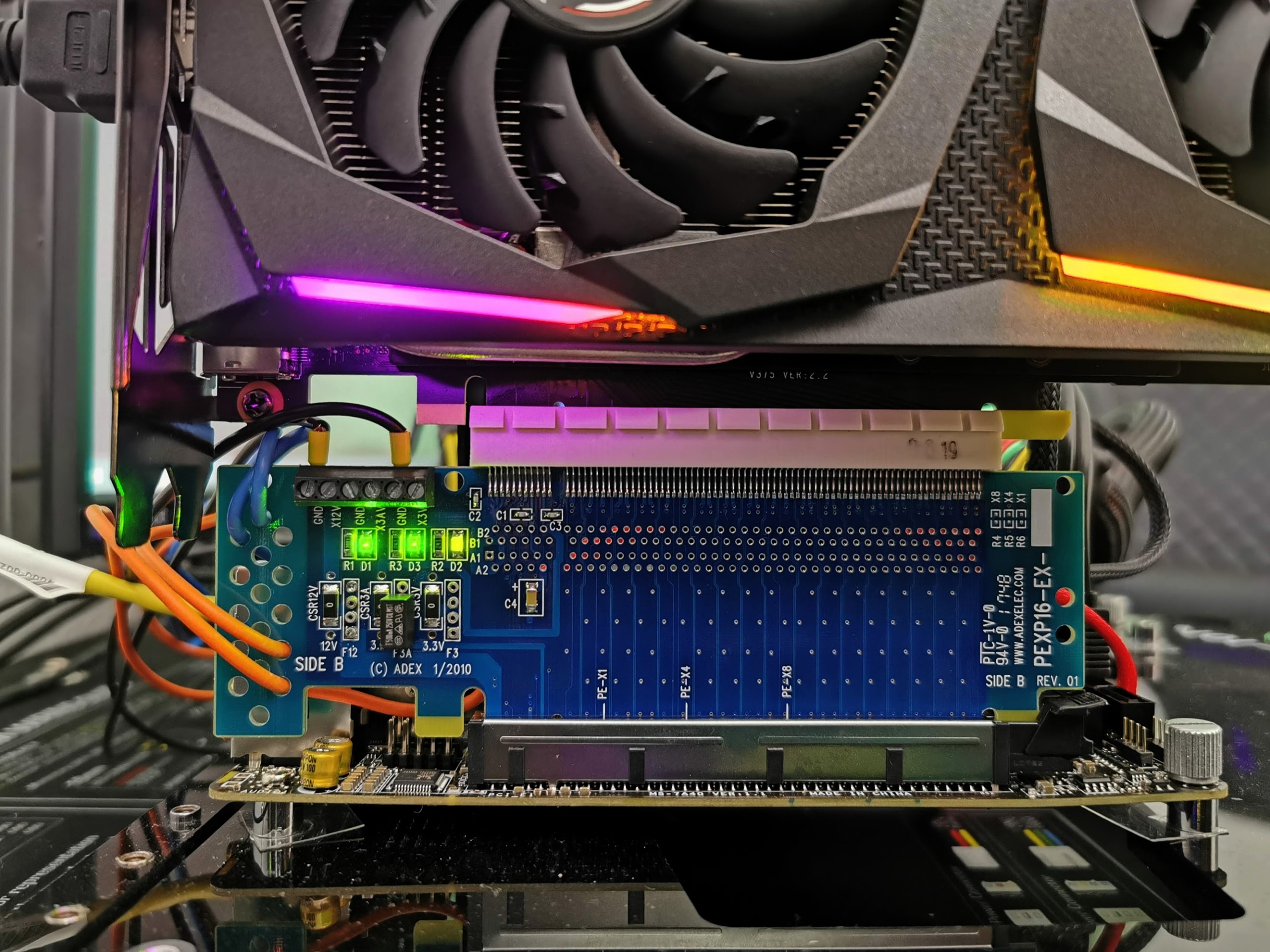

Ich habe auf Computerbase für meine MSI Radeon 6800 Z Trio im Linux Teil etwas gepostet.

Sowohl in gnu gentoo linux als auch Windows 11 Pro musste ich die Monitoreinstellungen per Hand programmieren.

Den Rest kann man dort gerne nachlesen.

Kurzfassung.

Vorher bis zu 35Watt egal wo im Leerlauf

Nachher 5 bis max 8 Watt im Leerlauf

-

Persönliche Meinung. Wenn jemand neue Hardware nicht ordentlich einrichtet, dem ist nicht zu helfen. Funktion gehört immer überprüft, Stabilitätstests und Verbrauchsmessungen.

Ob es jetzt an dem "Fehlerhaften" Asus Monitor liegt oder an der MSI Grafikkarte ist für mich belanglos.

Ich hatte es als Laie relativ rasch die Lösung gefunden innerhalb einer Stunde sehr gut aufgerundet.

Und in der nächsten Stunde alles gepostet für den nächsten, mit dem Problem.

ASUS, nur mein Einzelfall, liefert Schrott ab, egal ob Mainboard, mein Einzelfall, oder Monitor, auch mein Einzelfall. Ich behaupte mal, das EDID von meinem ASUS Proart Monitor wird, 350€ 27Zoll WHQD, wird nicht optimal sein für niedrigen Verbrauch. Hardware muss sich auf das EDID verlassen

Referenz:

https://de.wikipedia.org/wiki/Extended_Display_Identification_Data

--

Ich behaupte mal, das diese Thematik sehr viele AMD Grafikkarten betreffen wird. Nicht nur diese MSI Radeon 6800 Z Trio