Sandolo

Neuling

Thread Starter

- Mitglied seit

- 28.09.2023

- Beiträge

- 47

- Ort

- Berlin

- Laptop

- Acer Aspire 5050 @AMD Turion TL-62 / 4 GB RAM / 120 GB SSD

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 5700X

- Mainboard

- Asus RoG Strix B550-F Gaming

- Kühler

- Be Quiet Dark Rock 4 Slim + 2 x Silent Wings 3 120

- Speicher

- 32 GB (4 x 8 GB) GSkill Trident Z RGB / 3600 CL16

- Grafikprozessor

- Sapphire Pulse RX 6700 XT

- Display

- Acer KG271C (27"/FHD/144 Hz)

- SSD

- Corsair Force MP600 1TB + Crucial P3 Plus 1 TB

- Gehäuse

- Be Quiet Pure Base 500 schwarz + Glasfenster

- Netzteil

- Be Quiet Straight Power 11 750 W (Gold)

- Keyboard

- Logitech K800 + Logitech G610 Orion red

- Mouse

- Logitech MX Master 2S + Logitech G502 Hero SE

- Betriebssystem

- Windows 11 Pro

- Webbrowser

- brave

- Sonstiges

- 4 x Silent Wings 3 140 / 2 x upHere LED-Leiste / CableMod Pro ModMesh schwarz-blutrot

- Internet

- ▼50 Mbit ▲10 Mbit

Leider komme ich einfach nicht weiter. Entweder gibt es nur halbe Erklärungen oder sie sind auf Englisch (was ich nun nicht so beherrsche). Vermutlich basieren viele Guides auch nur auf HörenSagen.

System:

Asus Prime X370-Pro (aktuelles UEFI)

- SVM aktiviert

- IOMMU aktiviert

Ryzen 7 5750G

512GB NVME als Systemplatte für OS und VM

Software:

Proxmox 8 als OS (aktuelles Update)

TrueNas Scale als VM (aktuelles Update)

Einstellungen in Proxmox:

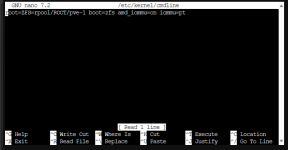

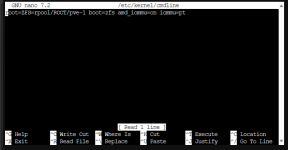

nano /etc/kernel/cmdline

root=ZFS=rpool/ROOT/pve-1 boot=zfs amd_iommu=on iommu=pt

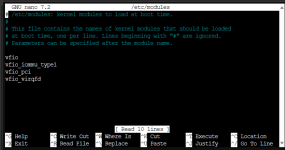

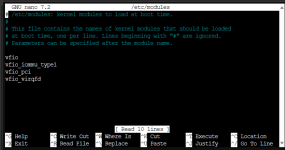

nano /etc/ moduls

vfio

vfio_iommu_type1

vfio_pci

vfio_virqfd

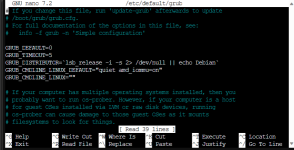

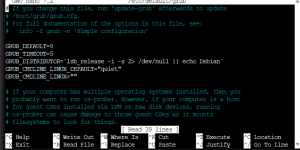

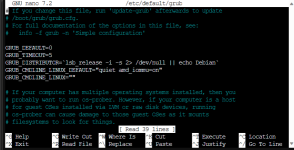

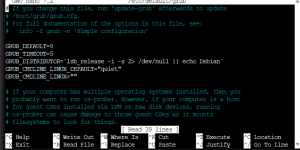

nano /etc/default/grub

wahlweise

GRUB_CMDLINE_LINUX_DEFAULT="quiet amd_iommu=on"

oder

GRUB_CMDLINE_LINUX_DEFAULT="quiet"

Bis hierher auch alles normal / ok.

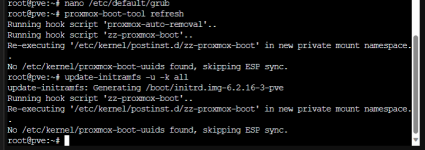

Abschließend noch folgende Eingaben gemacht:

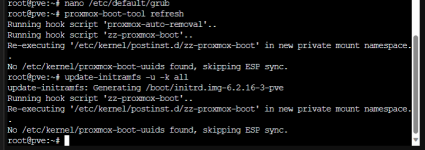

proxmox-boot-tool- refresh

und

update-initramfs -u -k all

und hier kommen die ersten Fehlermeldungen. Bei beiden Eingaben kommt:

No /etc/kernel/proxmox_uuids found, scipping ESP sync.

Bis hier lässt sich TrueNas auch noch starten.

Aber sobald ich den SATA-Controler in Proxmox an TrueNas durchreiche, hängt sich alles auf.

Ich weiß jetzt nicht mehr weiter und hoffe, dass es hier noch jemanden gibt, der was von der Materie versteht.

Ansonsten werde ich wohl statt zu Linux komplett zu wechseln, komplett auf kommerzielle Lösungen von MS setzen müssen.

System:

Asus Prime X370-Pro (aktuelles UEFI)

- SVM aktiviert

- IOMMU aktiviert

Ryzen 7 5750G

512GB NVME als Systemplatte für OS und VM

Software:

Proxmox 8 als OS (aktuelles Update)

TrueNas Scale als VM (aktuelles Update)

Einstellungen in Proxmox:

nano /etc/kernel/cmdline

root=ZFS=rpool/ROOT/pve-1 boot=zfs amd_iommu=on iommu=pt

nano /etc/ moduls

vfio

vfio_iommu_type1

vfio_pci

vfio_virqfd

nano /etc/default/grub

wahlweise

GRUB_CMDLINE_LINUX_DEFAULT="quiet amd_iommu=on"

oder

GRUB_CMDLINE_LINUX_DEFAULT="quiet"

Bis hierher auch alles normal / ok.

Abschließend noch folgende Eingaben gemacht:

proxmox-boot-tool- refresh

und

update-initramfs -u -k all

und hier kommen die ersten Fehlermeldungen. Bei beiden Eingaben kommt:

No /etc/kernel/proxmox_uuids found, scipping ESP sync.

Bis hier lässt sich TrueNas auch noch starten.

Aber sobald ich den SATA-Controler in Proxmox an TrueNas durchreiche, hängt sich alles auf.

Ich weiß jetzt nicht mehr weiter und hoffe, dass es hier noch jemanden gibt, der was von der Materie versteht.

Ansonsten werde ich wohl statt zu Linux komplett zu wechseln, komplett auf kommerzielle Lösungen von MS setzen müssen.