HWL News Bot

News

Thread Starter

- Mitglied seit

- 06.03.2017

- Beiträge

- 115.253

... weiterlesen

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: this_feature_currently_requires_accessing_site_using_safari

Bis die GPUs der beiden Konkurrenten am Markt angekommen sind kann man eig. gleich auf Hopper wartenGeht jetzt die nächste Katastrophe los ? Müsste, könnte, man vermutet..... Lass das Ding rauskommen, ärgert euch über die Verfügbarkeit und in ein paar Monaten sind Nvidia und AMD in der Realität angekommen.

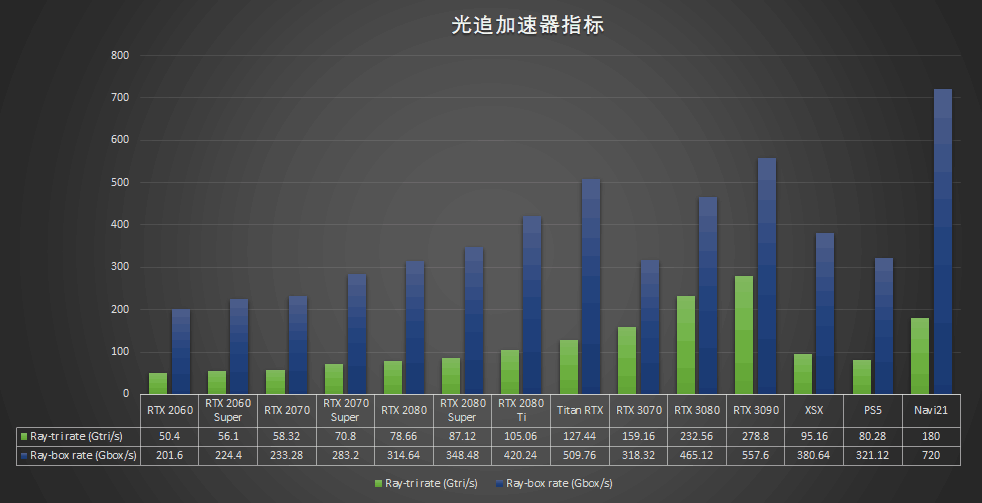

nun, wenn 20 cu von 80 cu für rt verwendet werden können beim zuschalten von rt, bedeutet das für mich im umkehrschluss bei eingeschaltetem rt ein leistungsverlust von ~33%.

mit blick auf die rtx 3080 verliert diese 35% in uhd und 32% in wqhd. also scheint mir die amd lösung potentiell nicht langsamer zu sein als nvidias.

also 20 von 80 sind immer noch 25%....

Hab mich mal mit ein paar Leuten unterhalten, die mehr davon verstehen als ich und das soll eine dynamische Zahl sein. Das sind keine festen CUs die "reserviert" werden, sondern je nach Szene/Auslastung etc werden die eben dafür verwendet. Die ~20CUs (ganz wichtig das "~") sind ein Durchschnittswert, kein Festwert. Da AMD die Shader nie zu 100% ausgelastet bekommen hat, ist das auch ne ziemlich clevere Methode brach liegende Rechenpower anderweitig zu nutzen. Der Leistungsverlust wird entsprechend weniger radikal sein, als dargestellt.nun, wenn 20 cu von 80 cu für rt verwendet werden können beim zuschalten von rt, bedeutet das für mich im umkehrschluss bei eingeschaltetem rt ein leistungsverlust von ...