Hallo zusammen,

ich bin eigentlich sicher dass meine Frage schonmal behandelt worden sein müsste, kann aber keinen Thread finden:

Taugen große Platten angesichts URE als Backup?

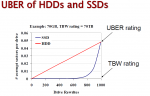

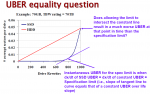

Auf der Suche für einer 4TB Backup Platte für meinen HomeServer (im Moment 2x 2TB, ohne RAID) bin ich über die SpecSheets von WD Festplatten gestolpert. Diese weisen einen URE (nichtkorrigierbaren Lesefehler) <1*10^14 Bits aus.

Ich möchte hier keinen Flamewar auslösen ob die Gefahr real ist oder nicht. Ich halte sie für real, da wohl sonst die HDD Hersteller nichts dergleichen in ihre SpecSheets schreiben würden. Ich möchte daher wissen, wie ihr damit umgeht.

Als sinnvollste Lösung betrachte ich im Moment wirklich wichtigen Daten (wie Dokumente) auf ein paar Datenträger zu sichern, vielleicht sogar in die Cloud zu laden und Bitfehler bei seinen MultiMedia-Daten wie Urlaubsfotos einfach in Kauf zu nehmen, da ein wirklich potenter Schutz gegen Bitfehler meinem Kenntnisstand nach ziemlich ins Geld geht (erfordert bei der Plattengröße zwei RAID6 Systeme oder ein Bandlaufwerk). Bei meinen 4TB hätte ich dann bei komplettem Datenverlust durch z.B. Blitzschlag eine Chance von 32% auf ein defektes Foto. Wäre OK für mich (zumal mir der Server jetzt auch falsche Daten liefern dürfte, ohne dass ich es überhaupt merke).

Wie sieht eure Lösung aus, oder ignoriert ihr das Thema?

ich bin eigentlich sicher dass meine Frage schonmal behandelt worden sein müsste, kann aber keinen Thread finden:

Taugen große Platten angesichts URE als Backup?

Auf der Suche für einer 4TB Backup Platte für meinen HomeServer (im Moment 2x 2TB, ohne RAID) bin ich über die SpecSheets von WD Festplatten gestolpert. Diese weisen einen URE (nichtkorrigierbaren Lesefehler) <1*10^14 Bits aus.

Ich möchte hier keinen Flamewar auslösen ob die Gefahr real ist oder nicht. Ich halte sie für real, da wohl sonst die HDD Hersteller nichts dergleichen in ihre SpecSheets schreiben würden. Ich möchte daher wissen, wie ihr damit umgeht.

Als sinnvollste Lösung betrachte ich im Moment wirklich wichtigen Daten (wie Dokumente) auf ein paar Datenträger zu sichern, vielleicht sogar in die Cloud zu laden und Bitfehler bei seinen MultiMedia-Daten wie Urlaubsfotos einfach in Kauf zu nehmen, da ein wirklich potenter Schutz gegen Bitfehler meinem Kenntnisstand nach ziemlich ins Geld geht (erfordert bei der Plattengröße zwei RAID6 Systeme oder ein Bandlaufwerk). Bei meinen 4TB hätte ich dann bei komplettem Datenverlust durch z.B. Blitzschlag eine Chance von 32% auf ein defektes Foto. Wäre OK für mich (zumal mir der Server jetzt auch falsche Daten liefern dürfte, ohne dass ich es überhaupt merke).

Wie sieht eure Lösung aus, oder ignoriert ihr das Thema?