Ich halte das zwar immer noch für Fragwürdig, in dieser Richtung zu übertreiben, aber... ich bin total offen dafür und neugierig:

=> Wie isn das mit den VHD(X), kann man die z.B. mit CrystalDiskMark benchen? SMB-Shares mags ja nicht.

Wenn ja, mach mal Benches von deiner Freigabe vs. lokale SSD... würde mich interessieren... speziell Richtung IOPS und kleinere random Zugriffe...

Ich sehe das nicht als Übertreiben, sondern als einen möglichen logisch nächsten Schritt, wenn man ein schnelles Netz (ab 10Gbit) zu Hause hat. Im RZ ist das Konzept schon ewig gang und gäbe und sowas von praxiserprobt wie sonst kaum etwas. Ob sich das für einen zu Hause lohnt, muss und darf sich jeder anhand der ganz persönlichen Anforderungen selbst überlegen/entscheiden.

Für mich funktioniert's prima und ist an vielen Stellen (nicht allen!) ein guter Kompromiss. Und ich find's halt auch einfach kewl.

Muss aber natürlich nicht für Dich oder sonst jemanden gelten. Wie gesagt, ich zeige nur Optionen aus meinen persönlichen Erfahrungen auf. Meine Erfahrungen kommen übrigens an echtes Profi-Wissen sicherlich nicht heran, bin der erste der das sofort zugibt. Ich würde aber doch soweit gehen, dass mein Erfahrungsschatz über das Standardwissen des 08/15 PC-Anwenders hinaus geht. Einfach weil ich die Themen "Netze" und "Storage" extrem spannend finde, über die Jahre verdammt viel Zeit damit verplempert, viel selbst herumgespielt, gelesen und letztendlich eine vielleicht "leicht over the top" aber für mich sehr sexy Lösung gefunden habe.

Und nur mal als zwei Beispiele aus diesen "Erfahrungen":

1. CDM mag SMB-Shares sehr wohl, wenn man über "Select Folder" geht und dann im Pfad mal einfach "\\Server-IP\SMBFreigabename" eintippert.

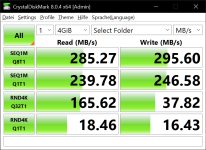

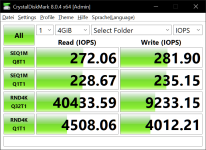

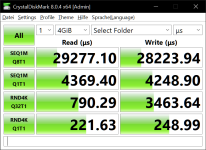

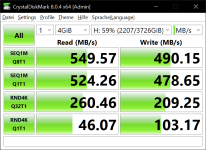

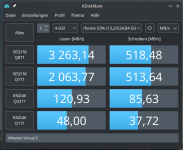

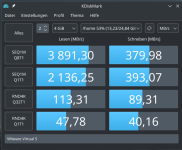

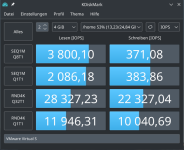

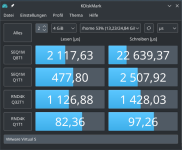

2. Benches in der angefragten Art hab ich bereits

oben in #5 verlinkt, gerne aber auch nochmal hier:

hier oder

hier, die lokalen vergleichswerte von CDM findest Du

hier ebenfalls im verlinkten Thread weiter unten.

Wie gesagt, mein Fokus liegt aktuell mehr bei ZFS bzw. RDMA, aber ein paar Infos zu SMB lokal vs. übers Netz sind auch dabei. Aus meinen Postings dort ergibt sich auch, dass sich eingebundene VHD(x) auch problemlos mit CDM benchen lassen. =) Hab auch noch mehr Benches in anderen Freds hier, bin aber gerade zu faul, die rauszusuchen. Am besten machst Du die Dich interessierenden Vergleiche eh selbst (und postest gerne irgendwo die Ergebnisse!).

Zum Thema PCIe4 bzw. 5: auch wenn die NIC x16 kann/will, funktioniert sie auch mit x8 oder x4 - und ob das dann ein Flaschenhals ist, hängt vor allem davon ab, wie viele Daten man über den Bus bringen muss. Für einen 100Gbit-Port reichen also x8@PCIe4 locker (wenn man nicht gerade full duplex saturieren will). Aber ich werde nicht müde zu betonen, dass alles um real erreichte 1GB/s über's Netz schon verdammt gut ist und für nahezu alle Einsatzzwecke @home locker ausreicht. Das packt sogar x2@PCIe3. Ob ein Spiel zum Laden jetzt 1 Sekunde oder 3 Sekunden braucht, macht das Kraut nun nicht wirklich fett.

Die Einrichtung von iSCSI ist auf Client-Seite auch nicht wesentlich komplexer als ein SMB-Share zu verbinden: im Zweifel nur iSCSI Initiator aufrufen, IP-Adresse des Servers eintragen, fertig. Der Rest funktioniert dann wie eine physische Disk. iSCSI ist halt auf Server-Seite u.U. etwas komplexer. Aber das nehmen einem die modernen Fertig-NASen von Synology, QNAP & Co. als "Server" inzwischen auch meist sehr komfortabel ab. Ich hab zu Hause tatsächlich für 4 Familienrechner den Speicherbedarf für Games & Co. mit iSCSI auf dem Homeserver im Keller "zentralisiert": Wenn einem Rechner der lokale Speicherplatz ausging, hab ich halt anstatt neue SSDs dazu zu stecken einfach neue iSCSI-Shares angelegt und verbunden. Feddisch. Mein Hauptrechner ist per 100gbit angebunden, 2 mit 10Gbit und 1 nur mit 1gbit. Mit 1gbit sind die Ladezeiten natürlich schon spürbar langsamer als mit lokalen SSDs, aber auch nicht schlechter als mit lokalen HDDs.

Die Einrichtung von iSCSI ist auf Client-Seite auch nicht wesentlich komplexer als ein SMB-Share zu verbinden: im Zweifel nur iSCSI Initiator aufrufen, IP-Adresse des Servers eintragen, fertig. Der Rest funktioniert dann wie eine physische Disk. iSCSI ist halt auf Server-Seite u.U. etwas komplexer. Aber das nehmen einem die modernen Fertig-NASen von Synology, QNAP & Co. als "Server" inzwischen auch meist sehr komfortabel ab. Ich hab zu Hause tatsächlich für 4 Familienrechner den Speicherbedarf für Games & Co. mit iSCSI auf dem Homeserver im Keller "zentralisiert": Wenn einem Rechner der lokale Speicherplatz ausging, hab ich halt anstatt neue SSDs dazu zu stecken einfach neue iSCSI-Shares angelegt und verbunden. Feddisch. Mein Hauptrechner ist per 100gbit angebunden, 2 mit 10Gbit und 1 nur mit 1gbit. Mit 1gbit sind die Ladezeiten natürlich schon spürbar langsamer als mit lokalen SSDs, aber auch nicht schlechter als mit lokalen HDDs.

Wie gesagt, mein Fokus liegt aktuell mehr bei ZFS bzw. RDMA, aber ein paar Infos zu SMB lokal vs. übers Netz sind auch dabei. Aus meinen Postings dort ergibt sich auch, dass sich eingebundene VHD(x) auch problemlos mit CDM benchen lassen. =) Hab auch noch mehr Benches in anderen Freds hier, bin aber gerade zu faul, die rauszusuchen. Am besten machst Du die Dich interessierenden Vergleiche eh selbst (und postest gerne irgendwo die Ergebnisse!).

Wie gesagt, mein Fokus liegt aktuell mehr bei ZFS bzw. RDMA, aber ein paar Infos zu SMB lokal vs. übers Netz sind auch dabei. Aus meinen Postings dort ergibt sich auch, dass sich eingebundene VHD(x) auch problemlos mit CDM benchen lassen. =) Hab auch noch mehr Benches in anderen Freds hier, bin aber gerade zu faul, die rauszusuchen. Am besten machst Du die Dich interessierenden Vergleiche eh selbst (und postest gerne irgendwo die Ergebnisse!).