Vorsicht vor dem Tri-Mode Geraffel, so einfach ist das alles nicht, mal begonnen beim benötigten proprietären Kabelwerk dafür, meine Posts sind ein paar Threads weiter zu finden.

Ich tu seit ner Zeit immer wieder mit einem 9400-16i herum, das ist alles not that easy, wie es klingt... und wenn ich den Themen-Start lese, bin ich mir sicher, dass so ein Tri-Mode-Controller ein teurer Bauchfleck wird.

Da muss man verdammt aufpassen, auch wenn was von "supports Tri-Mode" steht...

Da brauchst du fix die richtigen Breakout-Kabel von Broadcom, die du erstens so schnell nicht finden wirst ohne irgend nem Vertrieb, der weiss, was er dir anbietet und du sie zweitens nicht wirst bezahlen wollen, da bin ich mir auch recht sicher.

Imho wird der einfachste/zuverlässigste weg sein eine HEDT Plattform zu nehmen, also einen "kleinen" Xeon/Threadripper/Epyc mitsamt simplen Adapterkarten (Asus Hyper oder so).

Mainboard selber (TRX50) ist "billig" (~700€).

CPU Preise sind leider bissl fies (1350€ fürn kleinen 24 Core Zen 4....).

RAM ist so lala, ~800€ für 128gb, ist aber immerhin schneller ECC...

Funktioniert auf jeden Fall nicht, du kannst die Lanes nicht beliebig aufteilen, wenn Mainboard/CPU nur x4 x4 x4 x4 können (bei Intel Desktop noch nicht mal das) kannst du keine 8 Geräte dran hängen.

Du bräuchtest wenn so ne M.2 Raid Card mit einem "Switch" drin:

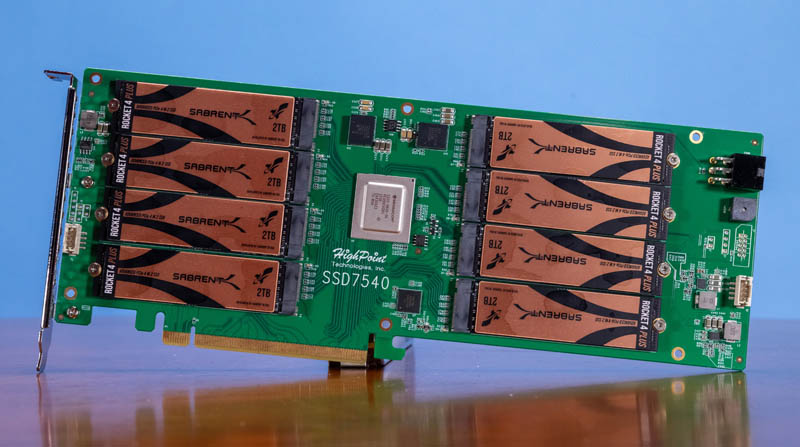

The HighPoint SSD7540 puts 8x PCIe Gen4 NVMe SSDs into a single PCIe Gen4 x16 slot increasing capacity and performance. We test it out

www.servethehome.com

Ist zwar nur PCIe 4.0, aber du siehst hier zumindest Benchmarks und so Kram.

Wirklich ohnen tut das ja alles selten, die Random 4k sind genau so toll wie bei einem einzelnen Drive, die Latenz wird davon nicht besser.

Ob die M.2 jetzt direkt auf der Karte sind oder du per OcuLink irgendwas drehst ist nicht so das Thema, es geht ja um den teuren "PCIe-Switch".

Imho isn HEDT/WS Board/CPU der beste (und trotz allem ws. billigste) Weg "dort hin", wenn man denn wirklich "dort hin" will.