freeman303

Enthusiast

Thread Starter

- Mitglied seit

- 01.08.2006

- Beiträge

- 631

Hallo,

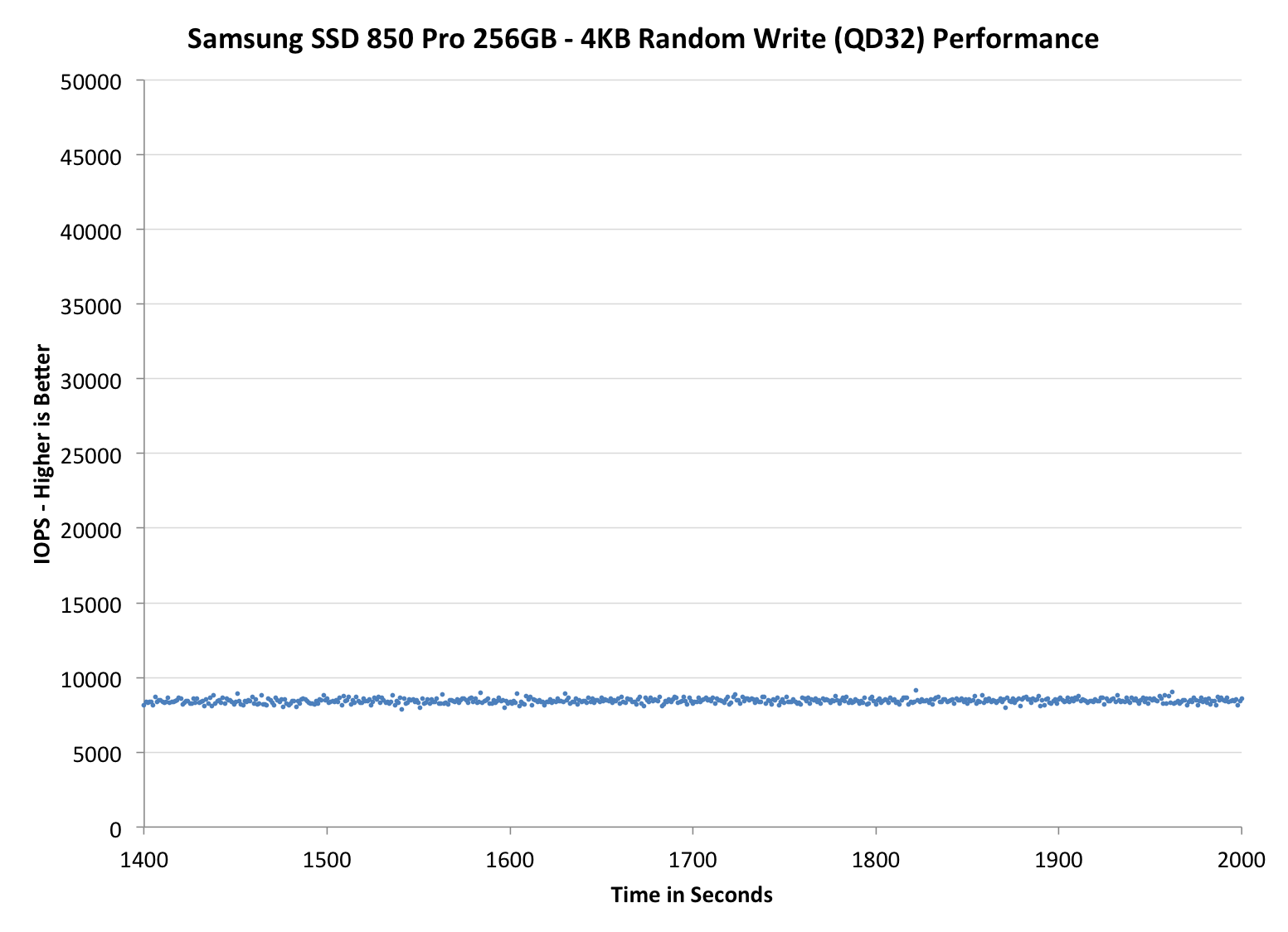

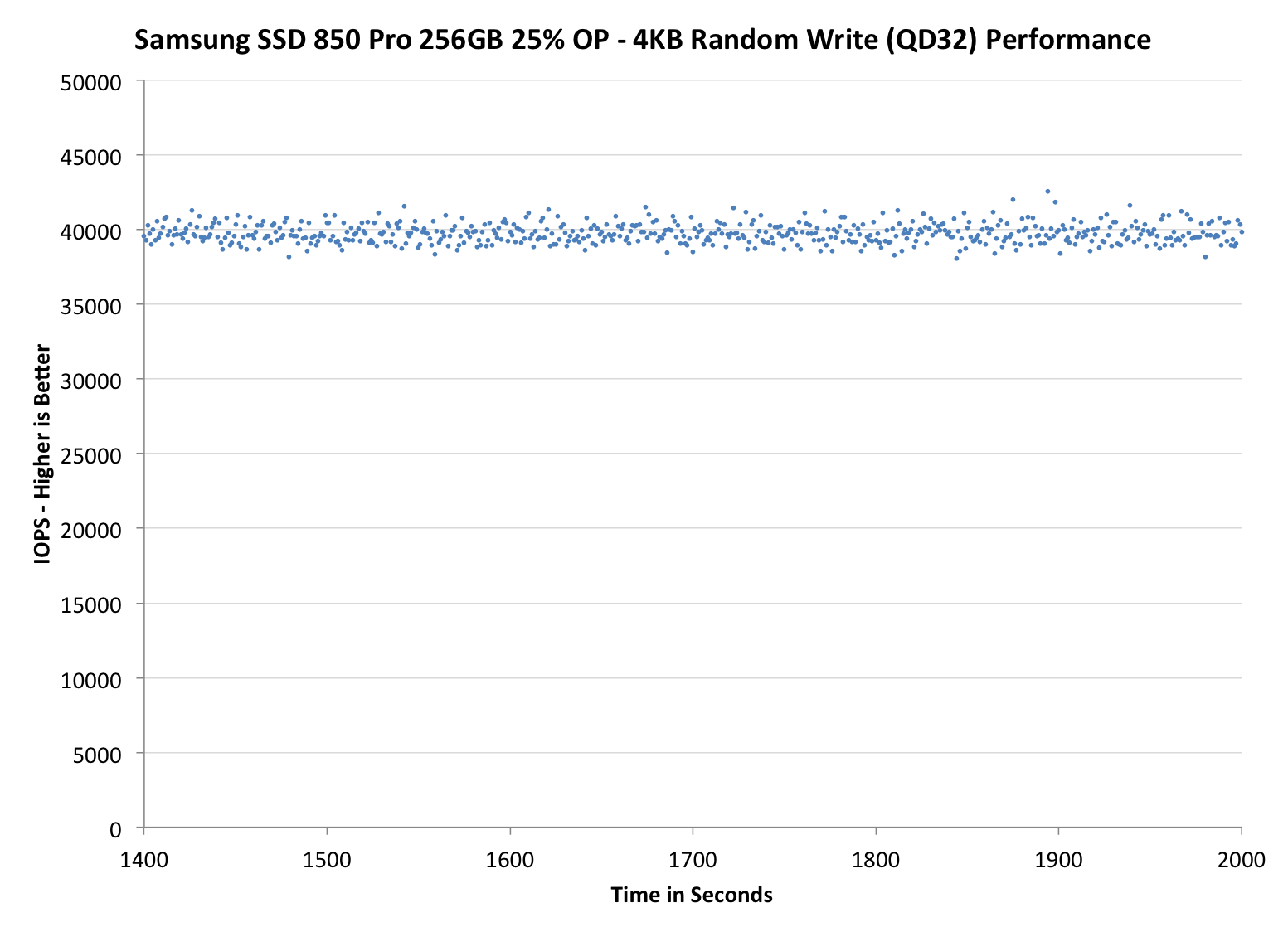

macht ein Overprovisioning bei einer Samsung 850 PRO überhaupt Sinn?

Angenommen es wird Win7 mit TrueCrypt Voll-Datenträger-Verschlüsselung eingesetzt.

Die aktuelle C'T schreibt, dass man bei aktuellen SSDs und der Samsung 850 Pro keine Overprovisionierung mehr benötigt, weil der Controller und der vom Hersteller eingerichtete freie Speicherbereich ausreichend wären. Außerdem stand im Artikel, dass auch bei einem durch Overprovisioning eingerichtetem Freiraum hinter der letzten Partition, dieser Freiraum eben trotzdem von dem Controller der SSD für die reguläre Datenablage genutzt würde, somit das Overprovisioning gar nichts nutzen würde.

Stimmt das so?

Ich meine, die C'T war auch schon mal besser - vor Jahren - daher stelle ich diese Frage hier zur Diskussion. Muss ja einen Grund haben, warum z.B. die Samsungs PM863 und SM863 andere GB-Größen haben. Wohl weil dort eben ein größeres Overprovisioning von Samsung eingerichtet wird.

Gruss

Freeman303

macht ein Overprovisioning bei einer Samsung 850 PRO überhaupt Sinn?

Angenommen es wird Win7 mit TrueCrypt Voll-Datenträger-Verschlüsselung eingesetzt.

Die aktuelle C'T schreibt, dass man bei aktuellen SSDs und der Samsung 850 Pro keine Overprovisionierung mehr benötigt, weil der Controller und der vom Hersteller eingerichtete freie Speicherbereich ausreichend wären. Außerdem stand im Artikel, dass auch bei einem durch Overprovisioning eingerichtetem Freiraum hinter der letzten Partition, dieser Freiraum eben trotzdem von dem Controller der SSD für die reguläre Datenablage genutzt würde, somit das Overprovisioning gar nichts nutzen würde.

Stimmt das so?

Ich meine, die C'T war auch schon mal besser - vor Jahren - daher stelle ich diese Frage hier zur Diskussion. Muss ja einen Grund haben, warum z.B. die Samsungs PM863 und SM863 andere GB-Größen haben. Wohl weil dort eben ein größeres Overprovisioning von Samsung eingerichtet wird.

Gruss

Freeman303

Zuletzt bearbeitet: