Hyrasch

Banned

Thread Starter

- Mitglied seit

- 10.12.2012

- Beiträge

- 2.649

Moin,

da die meisten das Video von Digital Foundry gesehen haben, müsste ich wohl nicht der Einzige sein dem aufgefallen ist, dass zwischen den Werten auf der offiziellen nvidia Präsentationsfolie (Relative Performance) und dem was DF zeigt, ein (kleiner aber feiner) Unterschied von 10 - 15 % (min. max) besteht (in Doom bis 15 %). Im Durchschnitt sind es mit ~ 10 % weniger.

In 1440p/4k uhd ist die rtx 2080 ~ 7 -10 % schneller als die rtx 2070S (letztere mit höherem Takt), rtx 2080S wiederum ~ 5 - 7 % schneller als rtx 2080.

Hier die Präsentationsfolie.

Hier nun die Zahlen im Diagramm dargestellt.

Rtx 2070S (dunkelblauer Balken als Basis 0). Davon ausgehend wie viel % mehr Leistung von x zu y es jeweils gibt.

Also "2070S -> 3070" heißt "Wie viel % an Leistung packt 3070 auf 2070S oben drauf).

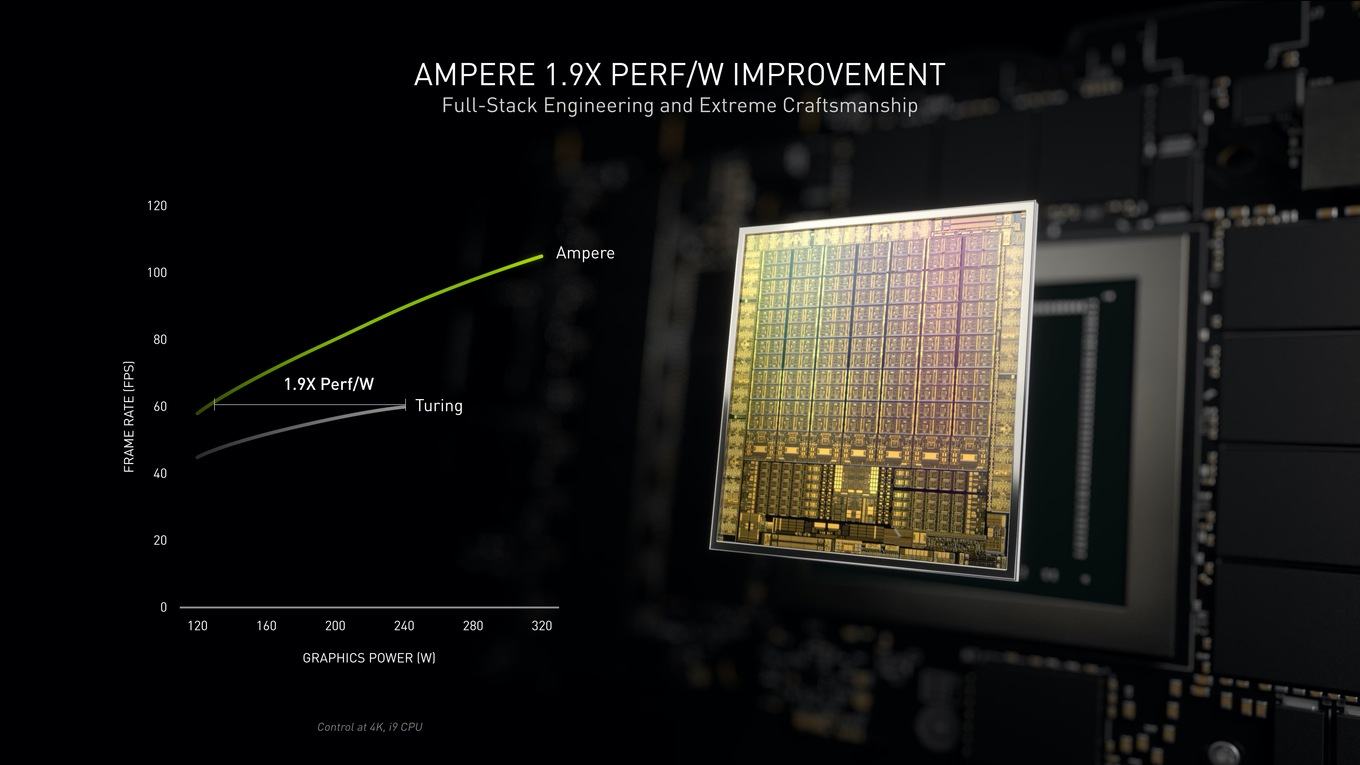

Und noch was zum Thema Verbrauch (Leistung/Watt).

Die "x1.9" ist natürlich irgendein theoretischer Wert.

Edit: Sollen bei der rtx 3070 doch 220 W sein. Tabelle geändert; damit verändert sich einiges!

Die rtx 3070 soll nun effizienter als die rtx 3080 sein. Von 4 - 11 %, im Mittelwert 7 %.

Es sind nun in den Vergleichen zwischen 20 - 28 %, 22 - 35 %, 35 - 40 % in den gezeigten non-rtx Spielen.

Man sieht deutlich das 2080S und 3080 auf Kante genäht sind, bzw. prozentual mehr vebrauchen.

In rtx-Spielen sind es nun je nach Vergleich 28 - 32 %, 30 - 35 % oder 35 - 40 %,.

47, 49 und 54 % in Minecraft!

Das ist dann doch deutlich besser als die vor der Präsentation kursierten 10 - 15 %. Die erwarteten Werte aus der Kombination "beinahe full-node-Sprung" des 8 nm Prozesses und dem Generations-Sprung gibt es dennoch nicht.

Der 8 nm Fertigungsprozess müsste eig 10 nm+ lauten (Gruß an Intel)

https://fuse.wikichip.org/news/1443/vlsi-2018-samsungs-8nm-8lpp-a-10nm-extension/

https://semiwiki.com/semiconductor-...undry/7442-samsung-10nm-8nm-and-7nm-at-vlsit/

Den größten Effizienzsprung gibt es ganz deutlich in Minecraft, zwischen 42 - 54 %. Das ist ein ganz eindeutiger Nvidia-Titel und wird so natürlich gerne als Vergleich genommen

Und zu guter Letzt ein Bussi von Mr. Lederjacke 😙 ❤

Und nicht vergessen, an alle Pascal-Freunde: The more you buy, the more you save!

Hab es mal editiert. Rtx 3070 soll doch 220 W Verbrauchen.

Damit verändert sich einiges!

da die meisten das Video von Digital Foundry gesehen haben, müsste ich wohl nicht der Einzige sein dem aufgefallen ist, dass zwischen den Werten auf der offiziellen nvidia Präsentationsfolie (Relative Performance) und dem was DF zeigt, ein (kleiner aber feiner) Unterschied von 10 - 15 % (min. max) besteht (in Doom bis 15 %). Im Durchschnitt sind es mit ~ 10 % weniger.

In 1440p/4k uhd ist die rtx 2080 ~ 7 -10 % schneller als die rtx 2070S (letztere mit höherem Takt), rtx 2080S wiederum ~ 5 - 7 % schneller als rtx 2080.

Hier die Präsentationsfolie.

Hier nun die Zahlen im Diagramm dargestellt.

Rtx 2070S (dunkelblauer Balken als Basis 0). Davon ausgehend wie viel % mehr Leistung von x zu y es jeweils gibt.

Also "2070S -> 3070" heißt "Wie viel % an Leistung packt 3070 auf 2070S oben drauf).

Und noch was zum Thema Verbrauch (Leistung/Watt).

Die "x1.9" ist natürlich irgendein theoretischer Wert.

Edit: Sollen bei der rtx 3070 doch 220 W sein. Tabelle geändert; damit verändert sich einiges!

Die rtx 3070 soll nun effizienter als die rtx 3080 sein. Von 4 - 11 %, im Mittelwert 7 %.

Es sind nun in den Vergleichen zwischen 20 - 28 %, 22 - 35 %, 35 - 40 % in den gezeigten non-rtx Spielen.

Man sieht deutlich das 2080S und 3080 auf Kante genäht sind, bzw. prozentual mehr vebrauchen.

In rtx-Spielen sind es nun je nach Vergleich 28 - 32 %, 30 - 35 % oder 35 - 40 %,.

47, 49 und 54 % in Minecraft!

Das ist dann doch deutlich besser als die vor der Präsentation kursierten 10 - 15 %. Die erwarteten Werte aus der Kombination "beinahe full-node-Sprung" des 8 nm Prozesses und dem Generations-Sprung gibt es dennoch nicht.

Der 8 nm Fertigungsprozess müsste eig 10 nm+ lauten (Gruß an Intel)

https://fuse.wikichip.org/news/1443/vlsi-2018-samsungs-8nm-8lpp-a-10nm-extension/

https://semiwiki.com/semiconductor-...undry/7442-samsung-10nm-8nm-and-7nm-at-vlsit/

Den größten Effizienzsprung gibt es ganz deutlich in Minecraft, zwischen 42 - 54 %. Das ist ein ganz eindeutiger Nvidia-Titel und wird so natürlich gerne als Vergleich genommen

Und zu guter Letzt ein Bussi von Mr. Lederjacke 😙 ❤

Und nicht vergessen, an alle Pascal-Freunde: The more you buy, the more you save!

Beitrag automatisch zusammengeführt:

Hab es mal editiert. Rtx 3070 soll doch 220 W Verbrauchen.

Damit verändert sich einiges!

Zuletzt bearbeitet:

In 2 Wochen dann jedoch gehts rund und ich hoffe sehr, dass sich alles bestätigt und die Karten top sind.

In 2 Wochen dann jedoch gehts rund und ich hoffe sehr, dass sich alles bestätigt und die Karten top sind. ... alles was schneller als Pascal ist und weniger als Turing kostet ist BOMBE

... alles was schneller als Pascal ist und weniger als Turing kostet ist BOMBE  !!! Warum so einen riesen Aufriss???? Einfach mal bis zum 16.09 warten, dann hört diese ständige Spekulation auf, ist doch alles nichts Halbes und nichts Ganzes.... keiner hat wirklich was handfestet, nur Gerüchte, Leaks, und Gewäsch.

!!! Warum so einen riesen Aufriss???? Einfach mal bis zum 16.09 warten, dann hört diese ständige Spekulation auf, ist doch alles nichts Halbes und nichts Ganzes.... keiner hat wirklich was handfestet, nur Gerüchte, Leaks, und Gewäsch.