Bitte was?

Könntest du das etwas ausführen?

Habe ich doch bereits mit einem Test belegt, welcher zwei gleiche Monitore im Idle testet und mit einer Hawai AMD Karte kombiniert?

Was soll ich noch ausführen? Könntest du das konkretisieren, dann mach ich das.

Und da ich auch mit Prozessorbenchmarks kommen kann zu GTA5, die genau das Gegenteil sagen:

GTA V: Grafikkarten- und Prozessor-Benchmarks (Seite 2) - ComputerBase

"Beim Autofahren durch die Stadt stellt GTA V keine allzu hohen Anforderungen an aktuelle Intel-Prozessoren. Solange vier CPU-Kerne vorhanden sind, spielt die Taktrate weder auf der GeForce GTX 980, noch auf der Radeon R9 290 eine Rolle."

@ Storm

Wie lange hast du eigentlich gesucht, um den polnischen Link zu finden?

Ich vermute mal stark dass dort etwas nicht gepasst hat. Ein alter i3 oder i7 860 auf dem Niveau eines OC 9590?

Absoluter Unsinn, vor allem weil das Spiel ja mehr als 2 Kerne nutzt und PCGH und Computerbase keine Probleme im CPU Limit feststellen.

Ich hab deine Links schon gesehen, verwertbares ist dort nicht dabei.

http://www.computerbase.de/2015-12/just-cause-3-grafikkarten-benchmarks/

Computerbase schreibt AMD Karten im CPU Limit, belegen tun sie es nicht, es deutet eigentlich alles darauf hin, dass es nicht so ist, warum?

R9 390 und GTX 970 liegen in Full HD gleichauf.

Eine R9 Fury X liegt in Full HD 9% vor einer r9 390x und in 4K ebenso nur 13%.

Wenn es ein CPU Limit wäre, würde die Fury X in WHQD und in 4K viel stärker zulegen und normalerweise 25 bis 30% schneller sein.

Das was Sache ist, ist, dass die Fury X nicht richtig ausgelastet ist, weder in Full HD, noch in 4K.

http://www.computerbase.de/2015-10/star-wars-battlefront-erste-benchmarks-der-open-beta/#abschnitt_prozessorbenchmarks

Erstens trifft das Problem ausschließlich auf die Fury X zu und nicht auf eine Hawai Grafikkarte.

Zudem ist die Skalierung völlig untypisch für ein CPU Limit oder einen Directx11 Overhead, das sieht man alleine schon sofort an der Skalierung.

Von 2,5 auf 3,5 ghz sind es 13% Zunahme und von 3,5 auf 4,4 sind es plötzlich 18%. WTF?

Von 2,5 auf 3,5 sind prozentuel erheblich mehr als von 3,5 auf 4,4, der Unterschied dazwischen ist höher als 30%, es springen aber nochmal 40% mehr FPS heraus?

Ne, da kann was nicht stimmen, außerdem liegen die FPS in Bereichen wo eine r9 390 gar nicht hinkommt in FUll HD, somit ist dein aufgreifen des Overheads hier sowieso sinnfrei.

2,5 ghz eines Intel Prozessors entsprechen in etwa der Leistungsfähigkeit eines 3,5ghz FX.

Also kannst du ganz gut ablesen, dass der Prozessor da eine 390 nicht bremsen wird.

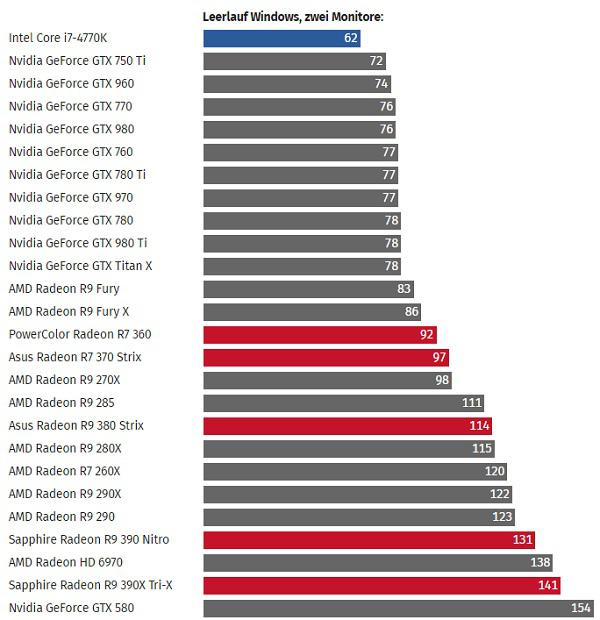

sollte dass mittlerweile tatsächlich so sein das die karten problemlos heruntertakten wenn zwei identische monitor verwendet werden

Das ist schon seit Release 2013 so und daher müsstest du das auch wissen, wenn du so aktiv hier in der Kaufberatung tätig bist.

280(x) - günstig,flink unter dx12, unter dx11 in kombination mit deiner verhältnismäßig lahmen cpu eher suboptimal,

Dafür dass es eigentlich sogut wie keine Hinweise dafür gibt, dass eine 280x mit einem FX8120 in Directx11 eine suboptimale Leistung bringen soll, lehnst du dich bei diesem Thema ziemlich weit aus dem Fenster.

Und dass die AMD Grafikkarten unter Directx12 flinker sind als unter Directx11 ist doch der absolute Abschuss.

Wieviele Benchmarks existieren eigentlich hierzu? Sogut wie keine...

interessant dass das bei ht4u funktioniert, bleibt nun die frage warum es bei combase und pcgh nicht funktioniert.

Weil diese Seiten mit unterschiedlichen Monitoren testen, es aber nicht erwähnen.

was in extremsettings und auflösungen hoher als 1080p irgendwann vllt mal dafür sorgen könnte das die karte etwas schlechter läuft als möglich

Die Auflösung nimmt auf den V-ramverbrauch sogut wie keinen Einfluss, das heißt, wenn die Spiele später am V-ram verhungern, wird das genauso in Full HD der Fall sein, in höheren Auflösungen sicherlich früher.

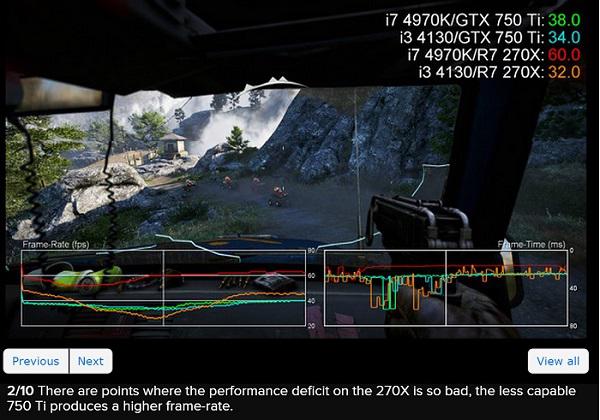

wie du hier sehen kannst sind die roten unter dx11 im cpu limit deutlich lahmer, unter dx12 dann genau so schnell wie die grünen.

Das ist ein Spiel im Early Access Modus. Das ziehst du wirklich dafür heran um Einschätzungen über die Directx12 Performance von AMD und Nvidia zu treffen und deine paar Links die keine belastbaren Informationen bezüglich dem Overhead einer 390 und eines FX8120 zeigen?

Egal.....

Der TE wird sich schon selbst informieren, hier wird einfach nur Meinungsmache betrieben und mit ein bisschen selektiver Wahrnehmung irgendetwas zusammengeschustert.