Bleifrei

Enthusiast

Thread Starter

- Mitglied seit

- 16.08.2007

- Beiträge

- 635

Hallo,

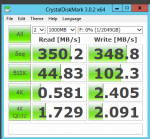

Bisher habe ich als Betriebssystem Windows Server eingesetzt und war auch ganz zufrieden. Das Dateisystem war zu 100% mit den Windows Clients kompatibel bzw. sogar identisch. Dateien konnten serverseitig indiziert werden(für Win 7 Bibliotheken notwendig). Die sequenziellen Transferraten bei einen Software RAID 0 waren super. Was mich allerdings gestört hat, waren die fehlende Leistungssteigerung bei einem RAID 1 sowie die IO /Random-Read und Write Performance bei allen RAIDs unter Windows.

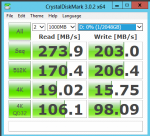

Nun hab ich vermehrt über ZFS gelesen und das hört sich ja in der Theorie traumhaft an: 4 Platten als RAID 10 bzw. Striped Mirrors konfiguriert sollen 4fache Read- und doppelte Write-Performance liefern. und das alles bei größerer Datensicherheit.

Die Praxiswerte, die ich mit FreeNAS und NAS4Free über die SMB Freigabe ermittelt habe, waren allerdings ein schlechter Witz. 60MB/s sequenzell, Random auf dem Niveau einer einzelnen Platte oder darunter.

RAM war ausreichend vorhanden und theoretisch könnte noch eine SSD für als Log- oder Cache Device eingerichtet werden. An der Hardware sollte es aktuell nicht liegen.

Nun hab ich gehört, die ZFS und SMB Performance soll unter FreeNAS nicht so doll sein. Welches Betriebssystem ist denn performant bei ZFS über SMB?

Oder reichen ein paar Einstellungen für einen Performanceschub aus?

Für Windows gibt es keine Möglichkeit die IO-Performance zu verbessern, oder?

Danke für eure Hilfe

Gruß

Bleifrei

Bisher habe ich als Betriebssystem Windows Server eingesetzt und war auch ganz zufrieden. Das Dateisystem war zu 100% mit den Windows Clients kompatibel bzw. sogar identisch. Dateien konnten serverseitig indiziert werden(für Win 7 Bibliotheken notwendig). Die sequenziellen Transferraten bei einen Software RAID 0 waren super. Was mich allerdings gestört hat, waren die fehlende Leistungssteigerung bei einem RAID 1 sowie die IO /Random-Read und Write Performance bei allen RAIDs unter Windows.

Nun hab ich vermehrt über ZFS gelesen und das hört sich ja in der Theorie traumhaft an: 4 Platten als RAID 10 bzw. Striped Mirrors konfiguriert sollen 4fache Read- und doppelte Write-Performance liefern. und das alles bei größerer Datensicherheit.

Die Praxiswerte, die ich mit FreeNAS und NAS4Free über die SMB Freigabe ermittelt habe, waren allerdings ein schlechter Witz. 60MB/s sequenzell, Random auf dem Niveau einer einzelnen Platte oder darunter.

RAM war ausreichend vorhanden und theoretisch könnte noch eine SSD für als Log- oder Cache Device eingerichtet werden. An der Hardware sollte es aktuell nicht liegen.

Nun hab ich gehört, die ZFS und SMB Performance soll unter FreeNAS nicht so doll sein. Welches Betriebssystem ist denn performant bei ZFS über SMB?

Oder reichen ein paar Einstellungen für einen Performanceschub aus?

Für Windows gibt es keine Möglichkeit die IO-Performance zu verbessern, oder?

Danke für eure Hilfe

Gruß

Bleifrei