HWL News Bot

News

Thread Starter

- Mitglied seit

- 06.03.2017

- Beiträge

- 112.696

... weiterlesen

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: this_feature_currently_requires_accessing_site_using_safari

X58, X79, X99 und X299

Das würde sich alles als HEDT einordnen. "Mainstream" wäre Socket 115x, 1200 und AM4X399, TRX4, 2066 "Mainstream" ist immer eine Ansichtssache.

Auf TRX4 wäre ja PCIe4 ggf. sowieso die bessere Alternative - wenn man so will, bieten sich eher die HEDT-Intel-Plattformen an...X399, TRX4, 2066 "Mainstream" ist immer eine Ansichtssache.

Technisch machbar ist vieles und sicherlich mehr als wir bei Consumer- oder gar Enterprise-SSDs sehen. Doch die Frage ist sicherlich, ob es denn einen Markt dazu gibt, denn die Preise würden sich dazu sicherlich exponentiell verhalten. Eine Diskussion dieser Art gab es vor einer Weile ebenfalls unter einem Review. Die Frage war, warum SATA(3) immer noch aktuell ist und keinen Nachfolger erhält. Meine Vermutung ist, dass es einfach keinen Grund gibt, die Schnittstelle abzulösen oder zu weiterentwickeln. Schauen wir uns die Benchmarks an, egal ob synthetisch oder eben alltagsnah - selten, dass ein Interface limitiert (und wenn, ist mit NVMe bereits die passende Lösung vorhanden, selbst mit Gen3 x2). Wann und in welchem Use-Case wäre denn eine SSD interessant, die PCIe4 x16 nutzt? Oder überhaupt x8 oder x4? Von wo sollen die Daten warum und wohin so schnell geschrieben oder gelesen werden?Ich verstehe nicht wo das Problem bei SSDs ist. Keine der SSDs genehmigt sich mehr als x4 PCIe und selten kommt Mal wer über die 3,5gb/s. Wo bleiben die x16 PCIe 4.0 SSDs? Kein Raid und so ein Schwachsinn, einfach eine Festplatte, 4TB und Datenraten jenseits von Gut und Böse.

Ist das technisch wirklich nicht machbar? Oder würde es die Hersteller zu viel kosten? Angeblich unterscheiden sich ja die Kosten für flashspeicher (SLC,MLC,TLC,etc.) Nicht sonderlich voneinander, lediglich die Preise für die Controller und das man mehr Chips für die gleiche Menge Speicher braucht.

Wenn es irgendwann einen Markt dafür gibt, wird es auch Hersteller dafür geben. Da 99,9 der derzeitigen Anwendungen keinen nennenswerten Vorteil aus der höheren Datenrate ziehen gibt es noch keinen Markt dafür.Wo bleiben die x16 PCIe 4.0 SSDs?

Ja richtig. Solange HDDs nicht an Grenzen der Übertragungsrate der SATA Schnittstelle anschlagen , gibt es keinen Grund etwas Neues für HDDs zu benutzen. Da die Übertragungsrate in erster Näherung mit der Quadratwurzel der Datendichte der Platte geht ist da die Grenze in etwa erreicht bei etwa 100TB Plattengröße ( mit 5 Plattern).Die Frage war, warum SATA(3) immer noch aktuell ist und keinen Nachfolger erhält. Meine Vermutung ist, dass es einfach keinen Grund gibt, die Schnittstelle abzulösen oder zu weiterentwickeln.

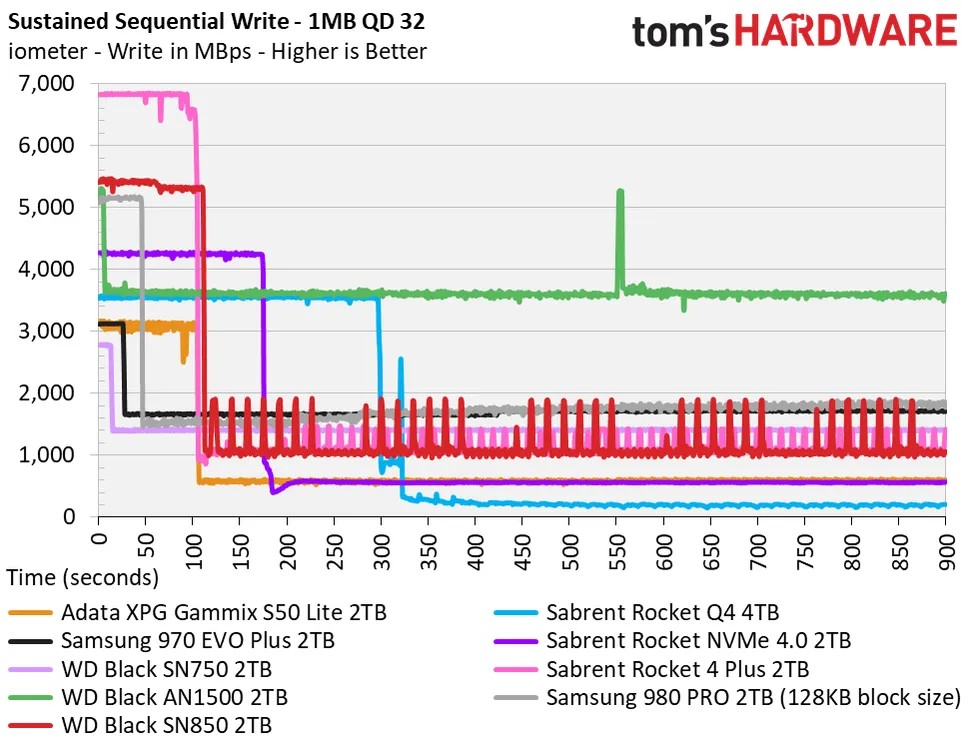

Zwar ist der vermeintliche SLC-Cache denkbar klein, doch eine Dauerleistung in der Größenordnung jenseits der 3 GB/s messen wir sonst nur bei SSDs während der SLC-Phase und nicht danach.

Zwar mag das Building Multi-Threading fähig sein, aber das Schreiben wird denke ich ganz normal sequentiell erfolgen. Davon abgesehen sprechen wir hier vermutlich nur von Sekunden, die du durch eine PCIe 4.0 einsparst, da in der Regel die CPU die Daten gar nicht so schnell berechnen kann wie die SSD sie verarbeiten könnte.Durch die vielen CPU-Cores (später kommt ein 5950x zum Einsatz) vermute ich, dass ein hoher iops-Wert beim Schreiben besser ist als hohe sequenzielle Transferraten

Absteits von AM4 bietet neben den TR3000ern auch Intels Rocket Lake PCIe 4.0 Lanes, sogar 4 für eine SSD zusätzlich zu den 16 für die Graka.Nutzern abseits moderner AM4-Mainboards

Aber dann bräuchte man einen teuren PCIe Lane Switch (aka PLX Chip) für PCIe 4.0.Wäre es nicht besser einen simplen M.2 auf PCIe 4.0 Adapter rauszubringen? Da der abwärtskompatibel zu PCIe 3.0 wäre, bräuchte man auch hier nur einen x8 Slot oder kann man die x4 von der M.2 nicht auf x8 verteilen?

Erstens braucht man dann sehr viele lange und dazu einige solcher Zugriffe parallel um überhaupt hohe Transferraten zu erreichen oder eben ein schnelleres Medium als NAND Flash, wo derzeit nur 3D XPoint in Frage kommt und Micron hatte schon genau so eine SSD gebaut, Micron X100. Aber die wurde wieder eingestellt nachdem ein paar Partner sie schon erhalten hatten:Wo bleiben die x16 PCIe 4.0 SSDs? Kein Raid und so ein Schwachsinn, einfach eine Festplatte, 4TB und Datenraten jenseits von Gut und Böse.

Es scheint keine Nachfrage danach gegeben zu haben, sonst hätte man es ja nicht eingestellt.

Wer behauptet denn den Blödsinn? Die Kosten für NAND hängen vor allem von der Chipfläche und mit 3D NAND auch der Anzahl der Layer ab, bei SLC speichert man dann nur ein Bit in einer Zelle und bei MLC 2, bekommt also die doppelte Kapazität aus dem gleichen Die und damit halbieren sich die Kosten pro Gb. Bei TLC speichert man 3 Bit in einer Zelle, hat also 50% mehr Kapazität bei der gleichen Anzahl an Zellen und damit spart man also gegeüber 2bpc ein Drittel der Kosten und bei QLC mit 4 Bit pro Zelle spart man gegenüber TLC immer noch 25% ein. Dies sind theoretische Werte, praktisch ist es wegen mehr Aufwand für zusätzliche ECC etwas weniger, aber wer behauptet die Kosten für SLC, MLC, TLC oder QLC würden sich nicht sonderlich unterscheiden, der hat etwas ganz grundlegendes über NAND nicht verstanden.Angeblich unterscheiden sich ja die Kosten für flashspeicher (SLC,MLC,TLC,etc.) Nicht sonderlich voneinander

Wie gut skaliert das überhaupt auf die Kerne?

Mit einer Ryzen 3900X-CPU sind diese 40 Minuten auch zu erreichen: https://www.vulnano.com/2020/06/aosp-build-time-on-ryzen-9-3900x.htmlAs of June 2021, Google is using 72-core machines with 64 GB of RAM internally, which take about 40 minutes for a full build [...].

By contrast, a 6-core machine with a similar amount of RAM takes 3 hours.

Ja, meinen Server habe ich vor Kurzem erneuert, hier geht es nur um die Workstation und die Frage nach einer geeigneten SSD, welche viele kleine Dateien schnell wegschreiben kann.Bleibt es eigentlich bei Dual Boot?

CrystalDiskInfo berücksichtigt für sein Temperaturwarnungen die individuellen Spezifikationen bzgl. der Temperatur der Laufwerke nicht und warnt pauschal ab einer bestimmten Temperatur, die sich eher an HDDs orientiert. Die meisten SSDs sind für bis zu 70°C oder sogar mehr spezifiziert.CrystalDiskInfo schlug gleich erstmal Alarm, Temperatur 65 Grad

Die Aussagen zur Kühlung kann man nie übertragen, da diese nur für den jeweiligen Rechner gelten. Je nach übriger Hardware, vor allem dem Gehäuse, den Lüftern darin, aber auch dem Mainboard und dem Slot in dem die SSD steckt, kann die Temperatur in jedem Rechner anderes ausfallen, auch massiv anderes. Auf der Rückseite eines Mini-ITX Boards wo kein Luftzug herrscht und die heiße Rückseite der CPU in der Nähe ist oder unter einer semipassiv gekühlten Graka, kann die Temperatur schon sehr hoch sein, auch wenn die SSD nur Idle ist, eben wenn es dort sehr heiß ist und kein kühlender Luftzug herrscht.ich habe nichts mit der SSD gemacht, hieß doch in den Tests die Kühlung reicht von WD