Werbung

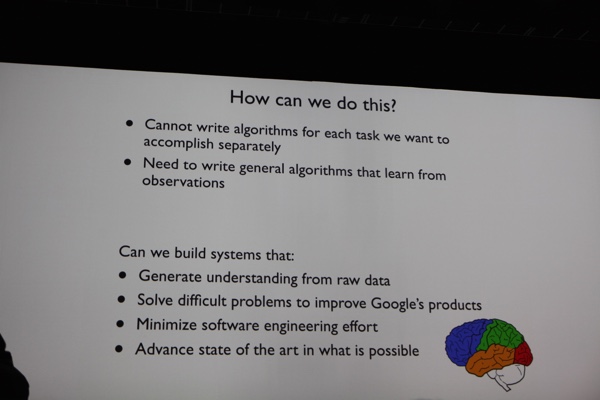

Google hat offensichtlich Ambitionen im Bereich Deep Learning. Dazu betrat Jeff Dean, Google Senior Fellow die Bühne und versuchte zu erklären, wie immer intelligentere Computer in diesem Bereich helfen können. Es geht nicht mehr darum, für jeden Fall den passenden Algorithmus vorliegen zu haben, sondern einfache Algorithmen zu entwickeln, die selbstständig lernen. Täglich werden weltweit im Internet Trillionen Wörter geschrieben, Milliarden Bilder hochgeladen und tausende Stunden Audio erzeugt. Diese Inhalte durchsuchen zu können ist sicherlich ein Anspruch, den Google hat. Hinzu kommen aber auch weitere Informationen wie die Nutzeraktivität. Google möchte Lernen wann eine Person wohin klickt, wie lange sie für bestimmte Informationen sucht, wie viele Seiten sie dazu besucht und vieles mehr.

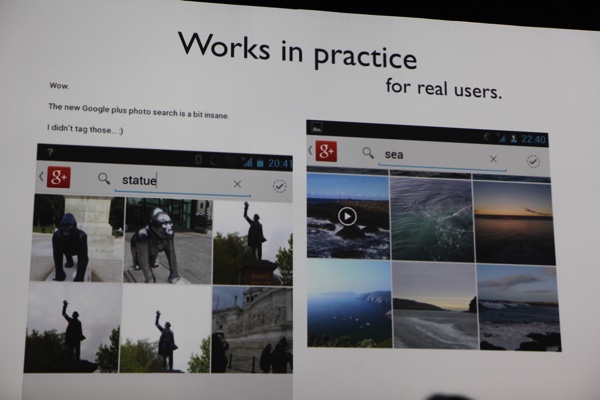

Ein wenig konkreter wurde es mit Google Maps und dem bestehenden Street-Street-View-Daten. Google arbeitet an automatischen Systemen, die aus den Bildern die Hausnummer erkennen. Dies klingt einfacher als es ist, denn auch wenn eine Texterkennung recht zuverlässig ist, so werden dennoch unterschiedlichste Größen, Farben und Formen für Zahlen verwendet, die unterschiedlicher nicht sein könnten und zuverlässig erkannt werden sollten. Gleiches gilt für Beschriftungen auf Hausfronten, aus denen Google gerne Informationen über die anliegenden Ladenlokale gewinnen möchte. Dies geht sogar so weit, dass Öffnungszeiten aus den Schildern der Street-View-Daten erkannt werden sollen.

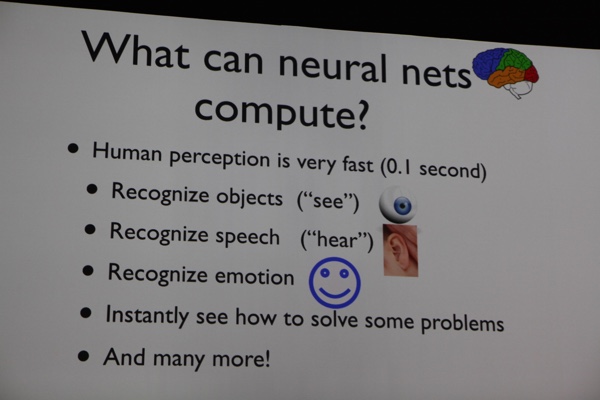

GPUs ermöglichen bei der Analyse und dem Aufbau solcher Deep Learning Netzwerke völlig neue Wege. An dieser Stelle bietet sich auch einmal mehr der Vergleich zum menschlichen Gehirn an. Neuronen sind in der Lage innerhalb von 0,1 Sekunden 10 Prozessor zu verarbeiten. Je nach Aufgabe arbeiten mehrere hundert Millionen oder Milliarden Neuronen gleichzeitig an einer Aufgabe wie dem erkennen von Fotos. Deep Learning Netzwerke mit 10 Layern und mehreren hundert GPUs erreichen diese Leistungswerte bereits heute. Eine Bild-, Text- und Audio-Erkennung wird von solchen Systemen bereits heute schneller und mit einer geringeren Fehlerrate ausgeführt, als vom menschlichen Gehirn.

Wichtiger Bestandteil des Deep Learning ist die Zeit, die es benötigt, ein Netzwerk zu trainieren. Große Datenbanken für Experimente aufzubauen sollte nicht länger als ein paar Stunden dauern. Sprechen wir hier bereits von Tagen oder gar Wochen, lohnt sich der Aufbau des Netzwerkes vielleicht schon nicht mehr. Hier kommen dann auch die GPUs in Spiel, die nicht nur bei der Auswertung von Daten aus solchen Netzwerkes durch eine Parallelisierung schneller arbeiten, als Hardware zuvor, sondern auch schon beim Aufbau solcher Netzwerke und dem Anlernen des Systems.

Sowohl beim Aufbau der Daten, der Analyse eines solchen Netzwerkes als auch bei der späteren Umsetzung mit weiteren Daten spielt die Parallelisierung also eine wichtige Rolle. Moderne GPUs sind eines der wichtigsten Hilfsmittel in diesem Bereich.