Werbung

In Kürze wird es eine neue Liste der Top500-Supercomputer geben und über die vergangenen Monate hinweg sind einige der bestehenden Systeme neu bestückt worden. Üblicherweise gibt es im Juni dann zahlreiche Neuankündigungen zu den Systemen – aus Japan kommen nun aber einmal gute und einmal schlechte Nachrichten.

Zunächst einmal aber wurde der Supercomputer Raiden (Riken AIp Deep Learning Environment) des japanische Forschungsinstitut Rikagaku Kenkyujo (Riken) mit neuer Hardware ausgestattet. Raiden besteht aus Komponenten von Fujitsu und war bereits mit einigen DGX-1-Clustern von NVIDIA ausgestattet. Diese waren bisher mit Tesla-P100-GPU-Beschleunigern auf Basis der Pascal-Architektur ausgestattet und haben nun ein Update auf Tesla-V100-GPUs auf Basis der Volta-Architektur erhalten. Außerdem wurde die Anzahl der DGX-1-Cluster von 24 auf 54 erhöht. Jeder DGX-1 besitzt acht GPU-Beschleuniger – nun eben die besagte Tesla V100. Diese kommen dank der Tensor Cores auf eine Rechenleistung von jeweils 119,2 TFLOPS. Bei acht Beschleunigern pro DGX-1 und 54 DGX-1-Clustern kommt das System auf eine Rechenleistung von 53,76 TFLOPS. Diese Rechenleistung lässt sich nun aber nicht direkt mit der andere Supercomputer vergleichen, da wir hier von INT8-Rechenoperationen sprechen. Gängiger bzw. für die Liste der Supercomputer vergleichbar wären FP32 oder FP64. Eine Tesla V100 kommt hier auf 15 TFLOPS für FP32 und 7,5 TFLOPS für FP64. Darauf aber dürfte der Raiden nicht ausgelegt sein.

Neben den GDX-1-Clustern verfügt der Raiden auch noch über weitere Hardware, die für allgemeinere Rechenaufgaben ausgelegt ist Die bereits bestehenden 32 Fujitsu Server Primergy RX2530 M2 wurden um 64 Primergy CX2550 M4 ergänzt.

Mit der neuen Liste der Supercomputer im Juni werden wir sicherlich die genaue Rechenleistung des Raiden kennen und können ihn dann auch sicherlich besser einordnen. Derzeit ist er einer der größten Supercomputer mit Tesla-V100-Beschleunigern und von daher für Machine-Learning-Anwendungen interessant.

Weiterer Supercomputer wegen Subventionsbetrug vom Netz genommen

Ein weiterer Supercomputer aus Japan wurde derweil vom Netz genommen. Als Grund wird Subventionsbetrug vom Netz genannt. Der Gyoukou, ein ZettaScaler-2.2 HPC-System, befindet sich derzeit auf Platz 4 der weltweit schnellsten Supercomputer. Offenbar aber gab es bei der Finanzierung Unregelmäßigkeiten. Präsident Motoaki Saito von Pezy Computing, der Hersteller des Systems, wurde bereits festgenommen. Der japanische Betreiber Agency for Marine-Earth Science and Technology (JAMSTEC) hat den Vertrag aufgelöst.

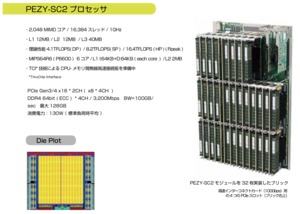

Aus technischer Sicht ist der Gyoukou besonders interessant. Er verwendet Xeon D-1571 mit 16 Kernen und zusätzliche Beschleuniger namens PEZY-SC2, die bisher noch nicht so weit oben in der Liste zu finden waren. Diese besitzen jeweils 2.048 MIMD-Einheiten (Multiple Instruction Multiple Data), die mit bis zu 1.000 MHz arbeiten können. Um effizienter zu sein, laufen sie im Gyoukou mit nur 700 MHz. Bei vollem Takt erreichen sie eine Rechenleistung von 4,1 TFLOPS bei doppelter Genauigkeit, 8,2 TFLOPS bei einfacher Genauigkeit und 16,4 TFLOPS für INT8-Berechnungen bzw. halber Genauigkeit. Dazu stehen jedem Rechenkern 64 kB an L1-Instruction-Cache und 64 kB an L1-Data-Cache zur Verfügung. Hinzu kommen 2 MB an L2-Cache. Pro Beschleunigerboard stehen außerdem vier DIMM-Steckplätze für DDR4-Speicher mit einer Bandbreite von 100 GB/s zur Verfügung. Die Leistungsaufnahme pro Board liegt bei 130 W.

Das als ZettaScaler-2.0 bezeichnete Gesamtsystem umfasst mehrere Dutzend solcher Beschleunigerboards. Diese werden in speziellen Gehäusen versenkt, in denen sich eine inerte Kühlflüssigkeit befindet. Dadurch soll die Hardware nicht nur besonders gut gekühlt werden, sondern auch als Gesamtsystem (inklusive Kühlung) besonders effizient arbeiten.