Werbung

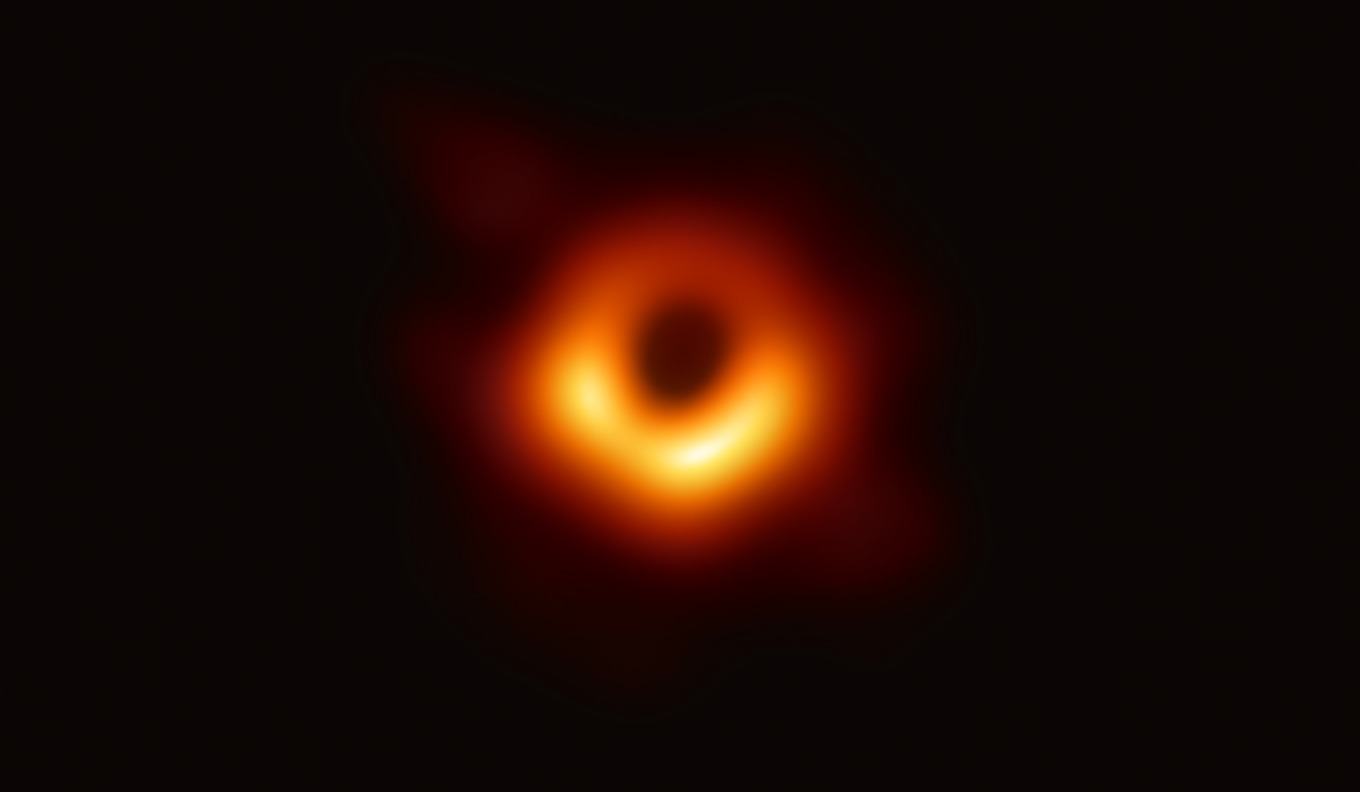

Die Enthüllung eines ersten Fotos eines Schwarzen Loches ist nach dem Nachweis der Gravitationswellen sicherlich eine der größten wissenschaftlichen Leistungen der vergangenen Jahre. Nun wollen und können wir uns nicht mit den wissenschaftlichen Erkenntnissen und weiteren Implikationen als solches auseinandersetzen, haben uns aber einmal angeschaut, welcher logistische Aufwand für die Verarbeitung all der Daten getrieben wurde, bis ein solch einfach aussehendes Foto möglich wurde.

Zunächst einmal aber etwas Hintergrund: Mit Hilfe des Event Horizon Telescope wurde das Supermassive Schwarze Loch im Kern der Galaxie Messier 87 aufgenommen. Das bisher nur als M87 bezeichnete Schwarze Loch soll noch einen besser greifbaren Namen bekommen, ist 55 Millionen Lichtjahre von der Erde entfernt und besitzt in etwa 6,5 Milliarden Sonnenmassen. Der Schwarzschildradius dieses Schwarzen Loches beträgt etwa 20 Milliarden Kilometer. Trotz dieser gigantischen Größe ist es gar nicht so einfach, ein Foto des Objektes zu machen, denn dies wäre vergleichbar damit von Berlin aus ein Foto eines Sandkorns zu machen, welches in New York liegt.

Um die Auflösung zu erhöhen, wird für das Event Horizon Telescope nicht nur ein Teleskop verwendet, sondern ein Array aus mehreren Teleskopen. Dies wären:

- NOEMA (Northern Extended Millimeter Array), Frankreich

- IRAM, Spanien

- Greenland Telescope Project, Grönland

- ALMA (Atacama Large Millimeter/submillimeter Array), Chile

- LMT (Large Millimeter Telescope Alfonso Serrano), Mexiko

- SMT (Submillimeter Telescope), USA

- KPNO (Kitt Peak National Observatory), USA

- CARMA (Combined Array for Research in Millimeter-wave Astronomy), USA

- CSO (Caltech Submillimeter Observatory), USA

- SPT (South Pole Telescope), Antarktis

All diese Teleskope mussten über den gleichen Zeitraum ihre Aufnahmen machen und dazu musste an allen Standorten das Wetter mitspielen. Alleine diese Voraussetzung zeigt schon recht gut, wie komplex die Aufgabe war.

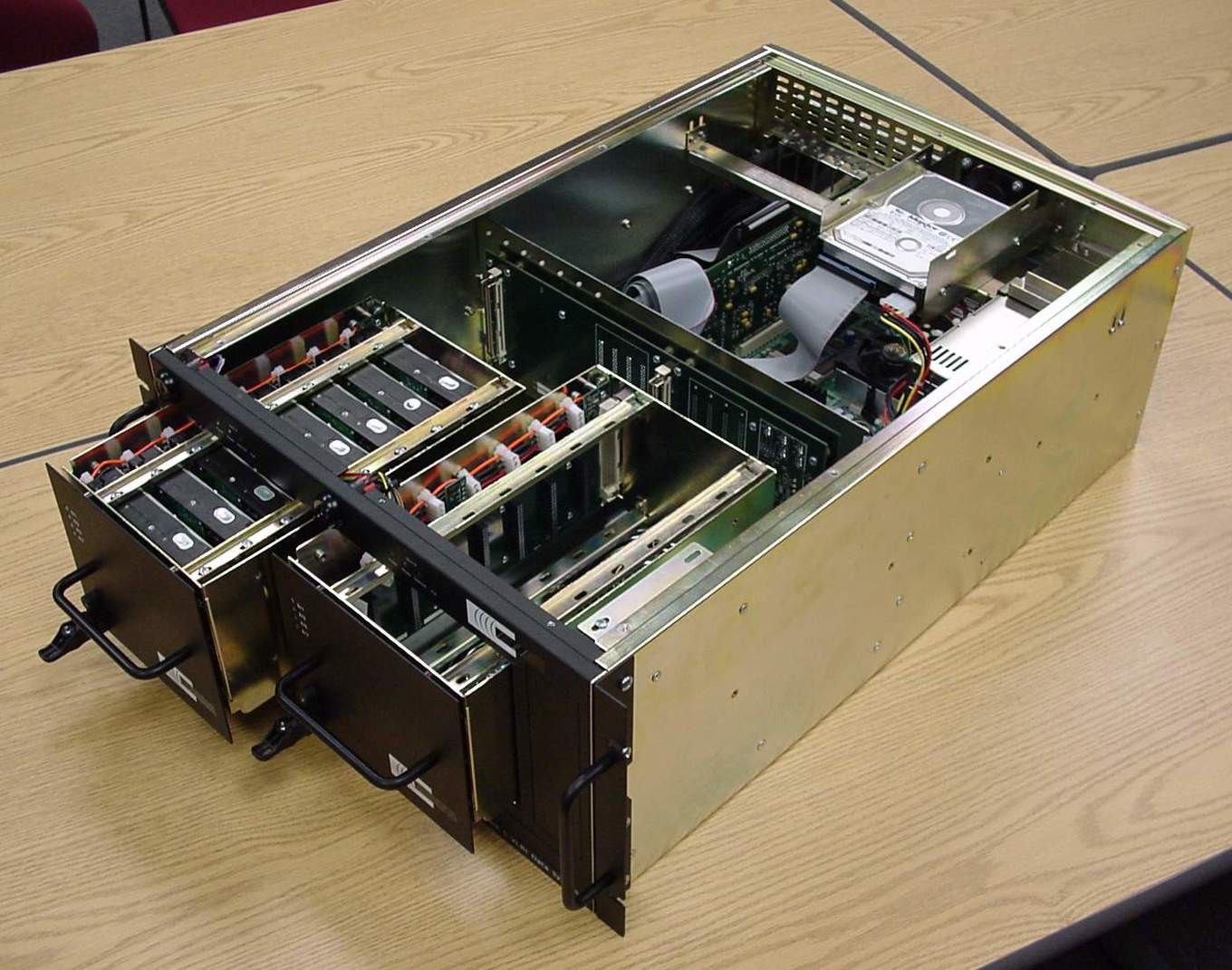

Nun aber zum technischen Teil: Jedes der Teleskope war mit einem sogenannten Mark6-Rekorder ausgestattet. Auf diesem wurden die Daten aus dem sogenannten ROACH Digital Backend (RDBE) mit 16 GBit/s geschrieben. Das RDBE sitzt am Teleskop selbst und ist an die entsprechenden Sensoren angeschlossen.

Der Mark6-Rekorder wurde für den Transport der Daten verwendet. In einem Mark6-Rekorder befinden sich 32 Festplatten, die in vier Modulen zu jeweils acht Festplatten aufgeteilt sind. Da manche Teleskope selbst aber schon ein Array aus mehreren Antennen sind und es zudem eine gewisse Redundanz in den Daten geben sollte, wurde an jedem Standort mit mindestens 64 GBit/s aufgezeichnet und auf jeweils vier Mark6-Rekorder geschrieben. Grob überschlagen sprechen wir also von mindestens 1.280 Festplatten unbekannter Kapazität, die zusammengetragen wurden.

Bei 64 GBit/s und einer Beobachtungszeit von fünf Tagen (in denen aber nicht an den vollen 24 Stunden eine Beobachtung stattfinden konnte, weil aufgrund der Erddrehung nicht immer alle Teleskope das Ziel ins Visier nehmen konnten), ergibt sich eine gewaltige Datenmenge, die verarbeitet werden musste. Gehen wir von grob zwölf Stunden Beobachtungszeit pro Standort aus und nehmen 64 GBit/s als Datenrate an, kommen wir auf eine Datenmenge von 1.728.000 GB oder rund 1,7 PB.

Update: Inzwischen ist die Datenmenge bekannt, die in der ersten Kampagne des Event Horizon Telescope gesammelt wurde. Insgesamt wurden 5 PB an Daten an den verschiedenen Standorten zusammengetragen.

Die Mark6-Rekorder wurden per Flugzeug und Schiff ins Max Planck Institut in Bonn und zum MIT-Haystack Observatory in Westford, Massachusetts, gebracht, um analysiert zu werden. Im Falle des South Pole Telescope musste mehrere Monate gewartet werden, bis ein Schiff die Mark6-Rekorder von der Antarktis abholen konnte. An den erwähnten Verarbeitungsstandorten wurden die Daten mittels eines DiFX-Korrelators analysiert und verarbeitet. Im Falle des Max Planck Institut findet dies auf folgender Hardware statt:

- 68 Compute Nodes: Jeder ausgestattet mit zwei Prozessoren zu wiederum jeweils 20 CPU-Kernen

- 1.175 TB an Festplattenspeicher

- 56 Gbps InfiniBand Interconnect

- 48 TB Festplattenplatz für die korrelierten Daten

- 40 TB Backup-Festplattenplatz

- 6 Anbindungspunkte für die Mark6-Rekorder (15 weitere für die älteren Mark5-Rekorde

- 1 GBit/s Anbindung an das Internet

Soweit die technischen Daten zur Hardware, die verwendet wurde. Unklar ist, welche Prozessoren genau zum Einsatz kommen und wie lange es dauert, bestimmte Berechnungen im Hinblick auf das erste Bild eines Schwarzen Loches zu erhalten.

Die Angaben zur Datenaufzeichnung und zur Serverinfrastruktur, die am Ende die Verarbeitung der Daten vorgenommen hat, zeigen aber sicherlich recht deutlich, welcher enorme Aufwand hier betrieben wurde. Neben dem Schwarzen Loch in Messier 87 hat das Event Horizon Telescope noch weitere Schwarze Löcher ins Visier genommen. Die Datenauswertung zu diesen Objekten läuft aber noch.

Aufgrund der Masse von M87 und der relativ geringen Bewegung des Objekts waren die Daten hier noch recht einfach auszuwerten. Aus dem enormen Datensatz wird es also sicherlich noch zahlreiche weitere Erkenntnisse geben.