Werbung

Nachdem wir uns die Pascal-Architektur gestern bereits genauer angeschaut und dabei jedes Detail beleuchtet haben – zumindest vieles über das NVIDIA derzeit spricht – wurden im Nachgang noch weitere Details angesprochen, die im Hinblick auf die zukünftige Auslegung der GP100-GPU interessant sein könnten.

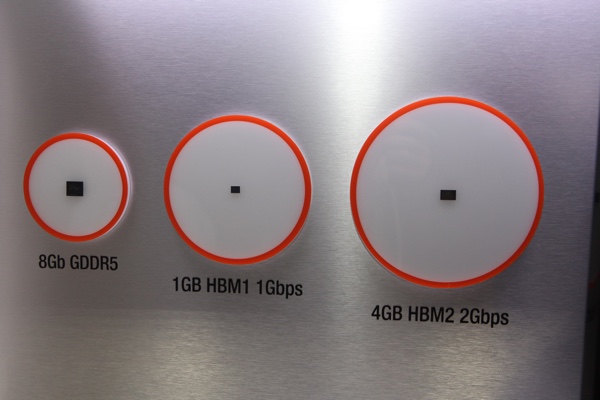

Zunächst einmal ging NVIDIA darauf ein, warum man sich für HBM2 entschieden hat und nicht beispielsweise für Hybrid Memory Cubes (HMC) wie dies beispielsweise Intel bei den Xeon-Phi-Beschleunigern auf Basis von Knights Landing gemacht hat. Laut NVIDIA bietet HBM2 aber ein größeres Potenzial hinsichtlich der Speicherbandbreite. Mit einem Takt von etwa 740 MHz und einer Speicherbandbreite von 720 GB/s nutzt man diese bei der Tesla P100 noch nicht einmal komplett aus, denn die JEDEC-Spezifikation zu HBM2 sieht einen Takt von bis zu 1.000 MHz vor. Übrigens erwähnt NVIDIA, dass es die GP100-GPU nicht mit einem HBM2 geben wird, der die vollen 1.000 MHz erreicht.

Ebenfalls noch einmal ein Thema war die Leistung der Interconnects und damit ist nicht zwangsläufig NVLink gemeint, denn durch eine GPU werden auch massenhaft Daten zwischen den Caches und Registern hin und her transportiert. Insgesamt sind diese Interconnects in der Lage bis zu 80 TB/s gleichzeitig zu übertragen. Diese enorme Bandbreite zeigt ganz deutlich, welcher Bedarf an schnellen Interconnects in einer GPU besteht und wie vergleichsweise langsam die Anbindung des Speichers mit 720 GB/s ist. Außerdem noch einmal eingegangen wurde auf die Fehlerkorrektur ECC, die sich durch die komplette Speicher-Infrastruktur zieht. Von den L1- und L2-Caches über die Register Files, Speichercontroller bis hin zum HBM2 selbst.

Im Ausstellungsbereich der GPU Technology Conference kann ein erster Blick auf einen DGX-1-Server geworfen werden, der acht Tesla P100 verwendet. Dort ist es auch möglich einen Blick auf die Tesla-P100-Module zu werfen. Es fällt auf, dass NVIDIA das Package aus GPU und den vier Speicherchips so aufbaut, dass diese eine plane Fläche ergeben. Bei AMD und der Fiji-GPU sind Höhenunterschiede zwischen der GPU und den Speicherchips vorhanden.

NVIDIA sieht einen Spacer vor, um den Höhenunterschied zwischen GPU und den Speicherchips auszugleichen. In einer Schnittansicht ist dieser Spacer deutlich zu erkennen und auch entsprechend beschriftet. Derzeit sieht NVIDIA den Einsatz von HBM2 mit 4 GB pro Chip vor. Samsung hat aber bereits angekündigt, auch HBM2 mit 8 GB pro Chip fertigen zu können. Mit der Massenproduktion dieser Chips hat man offenbar noch nicht begonnen. NVIDIA kann den Spacer aber entfernen oder die Dicke reduzieren und die höheren Chips im Package unterbringen. Tesla-Karten mit GP100-GPU und 32 GB HBM2 sind also durchaus denkbar.

Grafikspeicher von SK Hynix

Ebenfalls im Ausstellungsbereich zu sehen sind einige Speicherchips aus dem Hause SK Hynix. NVIDIA hat inzwischen bestätigt, dass der Speicher auf der GP100-GPU aus dem Hause Samsung stammt. SK Hynix spielt für HBM2 also zunächst einmal keine Rolle. GDDR5 von SK Hynix könnte aber auf zukünftigen Produkten zum Einsatz kommen. GDDR5X von Micron ist ebenfalls ein Kandidat für den Einsatz auf zukünftigen Grafikkarten.

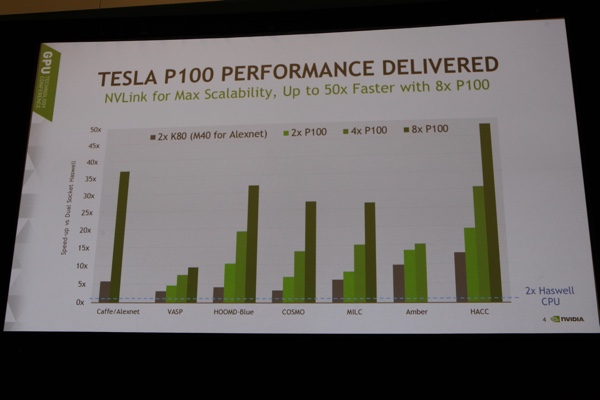

Bisher hat NVIDIA meist nur theoretische Werte für die Leistung von Tesla P100 veröffentlicht. Doch TFLOPS bei einfacher und doppelter Genauigkeit sind eben genau das, theoretische Werte. Jonah Alben, Senior Vice President of GPU Engineering bei NVIDIA, konnte aber mit einem Schmunzeln bestätigen, dass die Tesla P100 durchaus in der Lage ist Crysis 3 mit ausreichenden FPS darzustellen. Tesla P100 als Compute-Beschleuniger sieht aber natürlich ganz andere Anwendungsgebiete vor und darauf konzentrieren sich auch die ersten Benchmarks. Aus diesen lassen sich wohl kaum Rückschlüsse auf die Gaming-Leistung ziehen.