Werbung

Auf der GPU Technology Conference 2016 präsentierte NVIDIA überraschend nicht nur die Pascal-Architektur, sondern mit der Tesla P100 auch gleich einen dazugehörigen GPU-Beschleuniger. Die zunächst vorgestellten Tesla-P100-Module sind bislang aber nur als feste Octa-Konfiguration, z.B. im NVIDIA DGX-1, erhältlich und verwenden dort NVLink um untereinander und mit weiteren Komponenten zu kommunizieren.

Es war nur eine Frage der Zeit, bis auch eine PCI-Express-Variante vorgestellt wird und diesen Zeitpunkt haben wir mit dem heutigen Tage erreicht. Zunächst einmal aber wollen wir auf unsere Berichterstattung zur GPU Technology Conference 2016 verweisen, auf deren Keynote die Tesla P100 vorgestellt wurde. Außerdem schauten wir uns die Pascal-Architektur, besonders mit dem Fokus auf die Compute-Eigenschaften, an. Denn auch wenn die Pascal-Architektur in Form der GP104-GPU auf der GeForce GTX 1080 zum Einsatz kommt, so gibt es doch einige wichtige Unterschiede. Der Unified Memory, eine ECC-Absicherung des HBM2 sowie NVLink sind nur einige wenige Punkte. Wer sich die Octa-Konfiguration eines DGX-1 einmal etwas anschauen möchte, für den gibt es auch eine entsprechende Meldung bei uns.

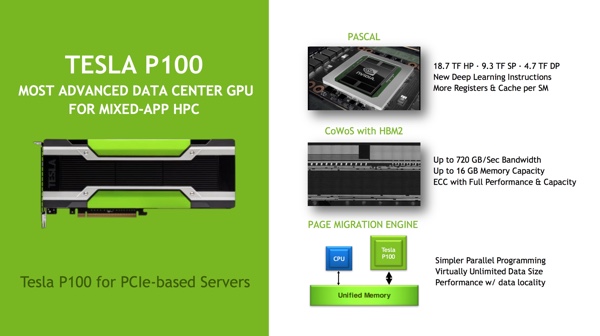

Doch zurück zur Tesla P100 mit PCI-Express-Interface. Sie bietet die identischen Ansätze zum Einsatzgebiet. Überall dort wo eine hohe Rechenleistung auf möglichst kleinen Raum gefragt ist, will NVIDIA mit der Tesla P100 das richtige Produkt bieten können. Im Fokus befinden sich dabei besonders Deep-Learning-Netzwerke, die im Trainings-Prozess von einer hohen FP16-Rechenleistung sowie der schnellen Speicheranbindung profitieren.

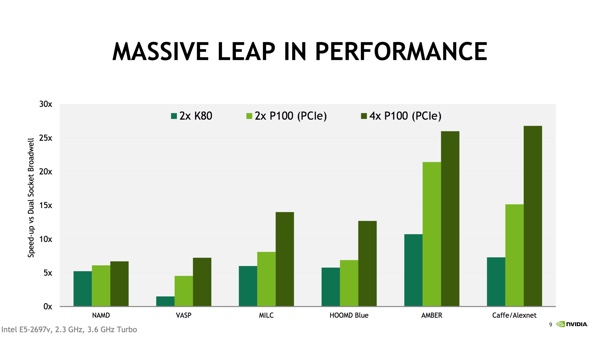

In nahezu allen Anwendungsbereichen zeigt die Tesla P100 deutliche Vorteile im Vergleich zu den GPU-Beschleunigern auf Basis der Maxwell-Architektur. Natürlich profitieren davon besonders solche Netzwerke, die auf die NVIDIA-Schnittstelle hin optimiert worden sein. Dazu gehören unter anderem Caffe und Alexnet.

NVIDIA Tesla P100

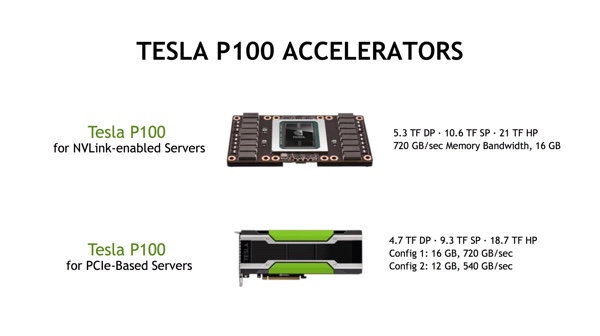

Hinsichtlich der Hardware gibt es einige Unterschiede zwischen der Tesla P100 in NVLink basierten Servern und der PCI-Express-Variante. So liegt die Rechenleistung der NVLink-Variante mit 5,3 TFLOPS bei doppelter und 10,6 TFLOPS bei einfacher Genauigkeit etwas höher, als bei den beiden PCI-Express-Varianten. Dies ist vermutlich dem Design der Kühlung sowie den Einschränkungen durch die PCI-Express-Spezifikation geschuldet. NVIDIA bietet aber auch unterschiedliche Speicherkonfigurationen an. Die Rechenleistung liegt bei 4,7 TFLOPS bei doppelter und 9,3 TFLOPS bei einfacher Genauigkeit . Die für Deep-Learning-Netzwerke wichtige FP16-Rechenleistung wird von 21 TFLOPS auf 18,7 TFLOPS reduziert.

Der Speicherausbau mit 16 GB HBM2 ist in der ersten Konfiguration bei einer Speicherbandbreite von 720 GB/s identisch. Die zweite Konfiguration sieht eine Ausstattung mit 12 GB bei einer Speicherbandbreite von 540 GB/s vor. Während die Tesla P100 mit NVLink theoretisch über 160 GB/s im Server angebunden werden kann, ist die Bandbreite bei PCI-Express auf 32 GB/s bidirektional limitiert. Dies ist wohl auch eine der wichtigen Einschränkungen der PCI-Express-Variante.

Die Tesla P100 mit PCI-Express-Interface soll im 4. Quartal erhältlich sein. NVIDIA nennt bei der Verfügbarkeit Partner wie Cray, Dell, Hewlett Packard Enterprise, IBM und SGI. Der Preis ist bisher unbekannt.