Werbung

Auch wen das Interesse an VR derzeit etwas abzuflachen droht, so glauben Hersteller wie AMD und NVIDIA weiter daran, dass dies keine kurzweilige Erscheinung bleiben wird. Stattdessen scheint einmal mehr das klassische Henne-Ei-Problem vorzuliegen, denn gerade auf dem PC fehlt es an Software bzw. Spielen, die den Spieler länger als nur ein paar Minuten an sich binden. Titel wie Resident Evil 7 oder The Journey haben es auf für die PlayStation VR vorgemacht.

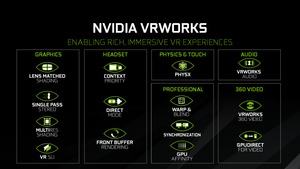

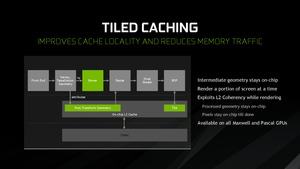

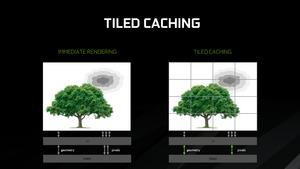

Damit VR-Spiele auf dem PC weiterhin das Maximum aus der zur Verfügung stehenden Hardware herausholen können, bietet NVIDIA mit VRWORKS eine Reihe von APIs an, die Entwickler bei der Entwicklung von Spielen unterstützen. Ähnlich wie Async Compute wendet NVIDIA dabei ein paar Tricks an, die unterstützt durch die Maxwell- und Pascal-Architektur am Ende zum Ziel führen sollen. Dazu gehören Techniken wie Multi Resolution Shading, Single Pass Stereo, Simultaneous Multi Projection oder Lens Match Shading. Diese wurden mit der Pascal-Architektur eingeführt, funktionieren aber teilweise auch mit der Maxwell-Generation.

Auf der GDC präsentierte NVIDIA nun noch einmal die Unterschiede von Lens Match Shading (LMS) und Multi Resolution Shading (MRS), bzw. zeigte den Unterschied, wenn keine dieser beiden Hilfsmittel genutzt werden. LMS und MRS machen sich dabei zu nutze, dass alle VR-Brillen eine Linse verwenden, um das Bild derart nahe am Auge des Betrachters darstellen zu können. Daher kommt es zu Verformungen in der Darstellung, die bereits beim Rendering mit eingeplant werden können. So wird die Auflösung an den Rändern, dort wo das Auge nur peripher wahrnimmt und wo ohnehin Teilbereiche letztendlich gar nicht dargestellt werden, reduziert. In der Mitte hingegen, dort wie der Spieler das Geschehen im Fokus hat, wird eine höhere Auflösung verwendet.

Geht man nun vom Standardfall ohne jegliche Anpassung aus, so müssen pro Auge 2,54 Millionen Pixel berechnet werden. Letztendlich für den Träger der Brille sichtbar sind aber nur 1,11 Millionen Pixel. Ein Großteil der Berechnungen fällt also unter den Tisch. Bereits ein einfaches LMS reduziert die berechneten Pixel auf 1,57 Millionen Pixel und sorgt gleichzeitig dafür, dass weniger überflüssige Pixel am Rand entstehen, dafür aber hochauflösender in der Mitte berechnet wird. Über Profile lässt sich LMS auch noch weiter anpassen, so dass mit unterschiedlich hohem Qualitätsverlust auch eine Reduzierung auf 1,17 bzw. 0,87 Millionen Pixel möglich ist.

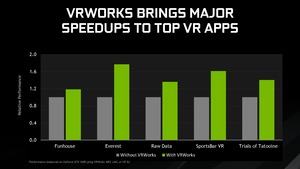

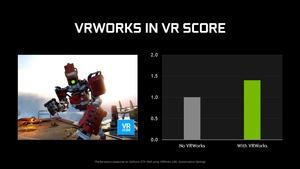

MRS schlägt in die gleiche Kerbe, funktioniert allerdings etwas anders. Letztendlich kann aber auch hier der Rechenaufwand bei gleichzeitiger Verbesserung der Darstellung deutlich verbessert werden. In einigen VR-Anwendungen hat NVIDIA auch gleich ein paar Zahlen parat, die dies unterstreichen sollen.

[h3]Frame Capture Analysis Tool für VR[/h3]

Mit einem VR-Headset ist es noch schwieriger als zuvor korrekte Leistungsmessungen zu machen. Zwar haben wir im Rahmen der ersten Erfahrung mit der HTC Vive bereits einige Benchmarks gemacht, dabei sind wir aber auf Tools der Entwickler angewiesen. Durch das VR-Headset als solchen kommt aber auch noch ein weiterer Faktor hinzu, der meist nicht mitgemessen werden kann. Eine Kombination aus Sensorik, die in der Brille platziert wird und dazugehöriger Software ermöglicht zwar exakte Messungen der Latenz, kann aber auch keinen detaillierten Verlauf aufzeigen und ermöglicht auch keine Analyse, ob es nun zu künstlich erstellen oder ausgelassenen Frames gekommen ist.

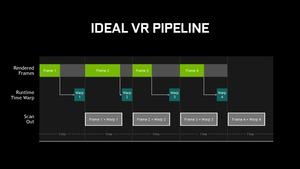

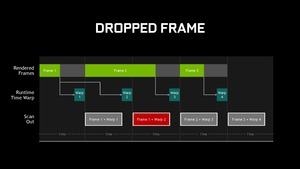

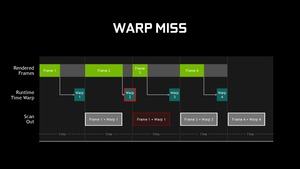

Wo genau liegt die Problematik für die Messung? Im Idealfall sollten VR-Spiele mit 90 FPS laufen. Dazu müssen bei einer Auflösung von 3.024 x 1.680 Pixel für beide Augen zusammengenommen aber 450 Millionen Pixel pro Sekunde berechnet werden. Nicht jede Hardware ist in der Lage dazu dies zu leisten. Im schlimmsten Fall kann es also dazu kommen, dass Frames ausgelassen werden. Spieler sind in der virtuellen Welt aber sehr anfällig für solche Fehler, denn das Gehirn erwartet ein Weiterführen von Bewegungen, was dann nicht mehr gegeben ist.

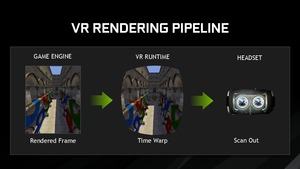

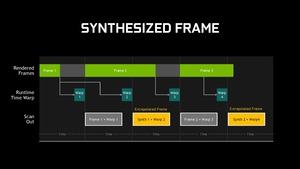

Die Entwickler haben sich daher einige Tricks ausgedacht, um dies zu verhindern. Dazu gehört das künstliche Erstellen eines Frames auf Basis der vorhandenen Informationen. Bewegt der Spieler gerade den Kopf in eine Richtung, ist davon auszugehen, dass er dies für den nächsten Frame auch tut und entsprechend kann dieser Frame in der Darstellung simuliert werden. Bei Oculus wird diese Technik Timewarp genannt. Über Tools wie FRAPS oder andere lassen sich solche ausgelassenen oder künstlich erstellen Frames aber nicht erkennen.

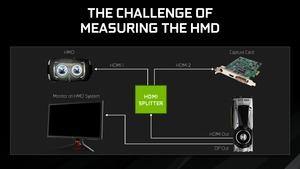

Messungen via Frame Capture Anaysis Tool (FCAT) ermöglichen bereits bei klassischen Benchmarks eine deutlich detailliertere Analyse. Ein solcher Messaufbau ist aber bereits in dieser Form eher als kompliziert zu bezeichnen und nimmt auch einiges an Zeit in Anspruch. Dem wird mit VR noch eine zusätzliche Ebene an Komplexität hinzugefügt. Dennoch macht NVIDIA solche Messungen möglich, in dem ein Overlay hinzugefügt wird, dass über bestimmte Farbcodes erkennt, ob es sich um einen neuen Frame handelt und ob hier ein neuer Frame dargestellt wird oder nicht.

NVIDIA hat nun ein Tool entwickelt, welches die Messungen für VR mittels Software ermöglicht, ohne Zuhilfenahme von Capture-Hardware oder eines komplizierten Signalaufbaus mit HDMI-Splitter und vielem mehr. FCAT VR Capture greift dabei auf die Performance-APIs von HTC und Oculus zurück, klinkt sich also an der richtigen Stelle in die Pipeline ein, um die korrekten Werte auslesen zu können. FCAT VR Capture erstellt eine CSV-Datei, in der sich alle relevanten Daten befinden.

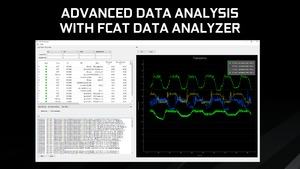

Zusätzlich bietet NVIDIA aber auch ein Programm namens FCAT Data Analyser an, der diese Daten grafisch aufbereitet. Hier lassen sich die Werte in Diagrammen aufbereitet und ermöglichen neben einer Analyse auch eine direkte Gegenüberstellung der selbigen. FCAT VR ist sicherlich kein Ansatz, der für Spieler eine große rolle spielen wird. Stattdessen können Entwickler und wir als Tester darauf zurückgreifen, um Messungen mit VR-Hard- und Software durchzuführen.

Datenschutzhinweis für Youtube

An dieser Stelle möchten wir Ihnen ein Youtube-Video zeigen. Ihre Daten zu schützen, liegt uns aber am Herzen: Youtube setzt durch das Einbinden und Abspielen Cookies auf ihrem Rechner, mit welchen Sie eventuell getracked werden können. Wenn Sie dies zulassen möchten, klicken Sie einfach auf den Play-Button. Das Video wird anschließend geladen und danach abgespielt.

Ihr Hardwareluxx-Team

Youtube Videos ab jetzt direkt anzeigen