Werbung

Früher einmal konnte man als klassischer Endkunde gerne einmal über einen PCI-Express-Switch stoßen, denn oftmals waren PCI-Express-Lanes Mangelware oder durch den Aufbau der Hardware notwendig. Bestes Beispiel sind sicherlich die Dual-GPU-Grafikkarten, die inzwischen gänzlich verschwunden sind. Die letzten Modelle waren die Radeon R9 295X2 (Test) und die Titan Z von NVIDIA. Hier wurden die PCI-Express-Switches dazu verwendet, die 16 zur Verfügung stehenden Lanes auf zweimal 16 (jeweils 16 für eine GPU) aufzuteilen.

Die Anwendungen gehen jedoch noch weiter. Das Supermicro C9Z390-PGW (Test) beispielsweise bietet einen PCI-Express-Switch-Chip, um zusätzliche PCI-Express-Lanes anbieten zu können. Für den LGA1200-, bzw. Z490-Chipsatz stellte man das Supero C9Z490-PGW vor. Abseits dieser Lösungen für den Endkundenbereich muss man aber schon länger suchen und wird eigentlich nur im Serverbereich für einen großflächigen Einsatz dieser Chips fündig.

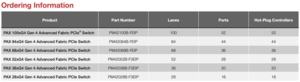

Neben Broadcom ist Microchip der zweite Hersteller solcher Chips. Hier will man in Kürze ebenfalls Varianten mit der Unterstützung von PCI-Express 4.0 anbieten. Die Anzahl der Lanes beläuft sich bei den Chips auf 28, 36, 52, 68, 84 und 100. Die Anzahl der einzelnen Controller liegt jeweils in etwa bei der Hälfte. So kann der Chip mit 100 Lanes insgesamt 52 einzelne Verbindungen umsetzen. Beim Chip mit 28 Lanes sind es 16 Ports. Über wie viele Lanes der einzelne Port verfügt, ist flexibel zu gestalten. So ist es möglich, 6x 16 Lanes plus 4x 1 Lane umzusetzen oder 50x 2 Lanes. Die Anzahl der Lanes pro Port muss sich auf x1, x2, x4, x8 oder x16 belaufen.

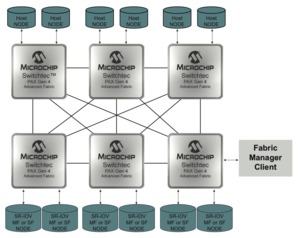

Es gibt also keine festgelegten Routen im Switch, sondern dieser besitzt ein Fabric, welches alle Lanes miteinander verbindet – ähnlich wie dies in Interconnect-Technologien in Prozessoren und GPUs der Fall ist oder wie NVIDIA dies beim NVSwitch umsetzt. Natürlich lassen sich mehrere dieser Switches miteinander verbinden. Für die größte Variante der Serie, den PM42100B-FEIP, sprechen wir bei 100 Lanes von einer Gesamtbandbreite von 174 GB/s.

Die PM42100-KIT-Serie soll in den kommenden Monaten auf den Markt kommen. Dass wir solche Chips auch in Endkunden-Produkten sehen werden, ist eher unwahrscheinlich. Stattdessen werden Server-OEMs von Dell, HPE und anderen solche Lösungen einsetzen, um beispielsweise ihre Storageserver mit mehr und mehr Laufwerken auszustatten, die allesamt NVMe-Laufwerke verwenden.