Werbung

Der Markt an Anbietern für AI im Datacenter-Segment wird um einen weiteren Hersteller erweitert. Allerdings ist Cambricon Technologies bereits an der Entwicklung der AI-IP im Kirin 970 von Huawei beteiligt gewesen, der unter anderem im Huawei Mate 10 Pro zum Einsatz kommt. Die Cambricon-1A getaufte IP (Intellectual Property) kann von weiteren SoC-Herstellern lizenziert wird, kommt bisher aber nur im Kirin 970 zum Einsatz.

Nun aber geht Cambricon Technologies den nächsten Schritt und stellt einen großen AI-Chip für den Einsatz im Datacenter vor. Die Eckdaten: 64 TFLOPS bei halber Genauigkeit, 128 TOPS bei INT8-Berechnungen. Bei Bedarf kann die Rechenleistung sogar noch gesteigert werden. Gefertigt wird der Cambricon MLUv01/MLU100 bei TSMC in 16 nm. Bei einem Takt von 1 GHz wird oben genannte Rechenleistung erreicht. Zum Vergleich: Eine NVIDIA Tesla V100 im SXM2-Format kommt auf 120 TFLOPS für INT8 und 30 TFLOPS bei halber Genauigkeit. Anders als der Cambricon MLU100 bietet NVIDIA hier aber auch einfache und doppelte Genauigkeit. Auf 1,3 GHz liefert der MLU100 83,2 TFLOPS für halbe Genauigkeit und 166,4 TOPS für INT8. Dann steigt die Leistungsaufnahme aber auch auf 110 W an.

An Speicher bietet der AI-Beschleuniger 16 oder 32 GB DDR4-3200, die über ein 256 Bit breites Speicherinterface angebunden sind, ECC-Unterstützung bieten und eine Speicherbandbreite von 102,4 GB/s erreichen. Die Speicherbandbreite ist also wesentlich geringer als bei den Konkurrenzprodukten.

| Modell | Cambricon MLU100 | Cambricon MLU100 Boost | NVIDIA Tesla V100 (SXM2) | NVIDIA Tesla V100 (PCIe) | Google TPU |

| Fertigung | 16 nm | 16 nm | 12 nm | 12 nm | - |

| Transistoren | - | - | 21 Milliarden | 21 Milliarden | - |

| Architektur | Cambricon-M | Cambricon-M | Volta | Volta | - |

| TDP | 80 W | 110 W | 300 W | 250 W | - |

| Kerne / Shader | - | - | 5.120 | 5.120 | - |

| Takt | 1,0 GHz | 1,3 GHz | 1.455 MHz | 1.370 MHz | - |

| Speicher | DDR4-3200 | DDR4-3200 | HBM2 | HBM2 | HBM2 |

| Speicherkapazität | 16 / 32 GB | 16 / 32 GB | 16 / 32 GB | 16 / 32 GB | 16 GB |

| Speicherinterface | 256 Bit | 256 Bit | 4.096 Bit | 4.096 Bit | - |

| Speicherbandbreite | 102,4 GB/s | 102,4 GB/s | 900 GB/s | 900 GB/s | 600 GB/s |

| Halbe Genauigkeit | 64 TFLOPS | 83,2 TFLOPS | 30 TFLOPS | 28 TFLOPS | - |

| Einfache Genauigkeit | - | - | 15 TFLOPS | 14 TFLOPS | - |

| Doppelte Genauigkeit | - | - | 7,5 TFLOPS | 7 TFLOPS | - |

| INT8 | 128 TOPS | 166,4 TOPS | 120 TOPS | 112 TOPS | 45 TOPS |

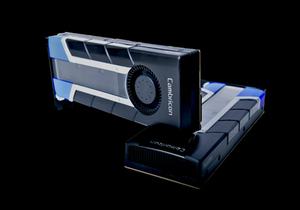

Der Cambricon MLU100 wird derzeit auf einer PCI-Express-Karte verbaut. Damit ist sie mit der NVIDIA Tesla V100 als PCI-Express-Variante vergleichbar. Lenovo scheint den Beschleuniger in sein ThinkSystem SR650 einzubauen. Die Server sind aber noch nicht verfügbar. Huawei betreibt aber auch eigene Server sowie AI-Forschung und wird die Cambricon MLU100 dort wohl ebenfalls schon einsetzen.

Noch ein paar Fragezeichen gibt es hinsichtlich der Softwareunterstützung. Es gibt SDKs für TensorFlow, Caffe und MXNe, doch in wie weit diese die Hardware auch vollständig ansprechen können, bleibt unbekannt. Natürlich arbeitet man auch schon an der nächsten Generation alias Cambricon-1M. Diese soll in 7 nm gefertigt werden und eine Effizienz von 5 TOPS/Watt aufweisen. Dies wäre eine deutliche Steigerung gegenüber den aktuellen 1,6 W/TOPS.