Werbung

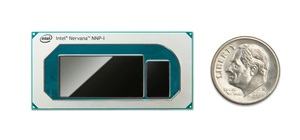

Auf dem AI Summit 2019 hat Intel seine neue Hardware im Bereich der AI-Beschleunigung vorgestellt. Bei diesen handelt es sich vor allem um die Nervana Neural Network Prozessoren (NNP). Der NNP-T1000 ist für das Training von neuronalen Netzen vorgesehen, der NNP-I1000 für das Inferencing. Die technischen Daten zu beiden Produkten hat Intel bereits in den vergangenen Monaten veröffentlicht, nun erfolgt der offizielle Start.

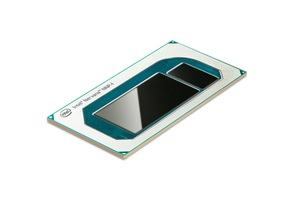

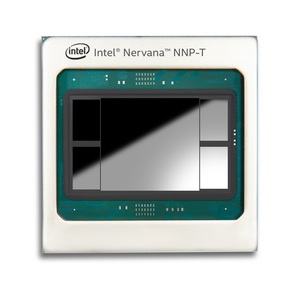

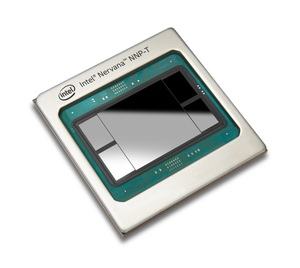

Der NNP-T1000 alias Spring Crest besteht aus 27 Milliarden Transistoren und besitzt 32 GB HBM2-Speicher. Dies alles packt Intel auf einen Interposer mit einer Fläche von 1.200 mm². Der ASIC besteht aus 24 Tensor Prozessoren (TPCs). Diese kommen auf eine Rechenleistung von 119 TOPS. Auf dem SoC befinden sich zudem 60 MB an on-chip Speicher (SRAM). Um möglichst viele Daten möglichst nahe an den TPCs zu haben, verbaut Intel vier HBM2-Speicherchips mit einer Kapazität von jeweils 8 GB – zusammen also 32 GB. Zusammen mit einem PCIe-4.0-Interface mit 16 Lanes sowie 64 SerDes (Serialisierer/Deserialisierer). Gefertigt wird der NNP-T von TSMC im 16-nm-Prozess (CLN16FF+).

Verpackt ist der NNP-T in einem 60 x 60 mm großen Package, welches ein BGA-Interface mit 3.325 Pins besitzt. Der NNP-T wird aber nicht in einem Sockel, sondern fest verlötet verwendet. Der NNP-T arbeitet mit einem Takt von 1,1 GHz und kann mit einer TDP von 150 bis 250 W konfiguriert werden.

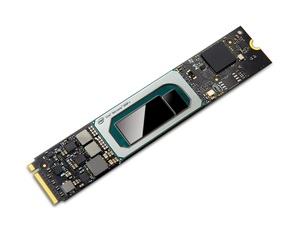

Etwas weniger bekannt ist zum NNP-I1000 alias Spring Hill. Hier verwendet Intel zwei in 10 nm gefertigte Sunny-Cove-Kerne. Per DL-Boost werden die entsprechenden Inferencing-Instruktionen beschleunigt. Hinzu kommen 12 Inference and Compute Units (ICE). Der NNP-I1000 kann mit einer TDP von 10 bis 50 W konfiguriert werden. Die Leistung bewegt sich dementsprechend zwischen 48 und 92 TOPS in INT8.

An Speicher vorhanden sind 3 MB an Tightly-Coupled Memory (TCM), der eine Bandbreite von 68 TB/s hat. Hinzu kommen 48 MB an SRAM, der eine Datenrate von 6,8 TB/s hat. Weitere 24 MB an Low Latency Cache (LLC) sind mit 680 GB/s angebunden. Schlussendlich können bis zu 32 GB an LPDDR4 verbaut werden, die mit 67,2 GB/s angebunden sind.

Intel packt den Chip samt Speicher in ein M.2-Format. Somit lassen sich die Beschleuniger extrem kompakt in die Systeme verbauen. In einen 2U-Server passen mehrere Dutzend dieser Beschleuniger.

Eine neue Movidius Vision Processing Unit (VPU) ist als Entwicklerlösung ebenfalls aktualisiert worden und soll in der zweiten Jahreshälfte 2020 verfügbar sein.