Werbung

Auf einem eigenen AI Day hat Tesla über die aktuellen und zukünftigen Entwicklungen im Bereich der Hard- und Software rund um die autonomen Systeme gesprochen. Das autonome Fahren ist in den verschiedenen Stufen zwar bereits in der Lage, einzelne Aufgaben und Strecken zu übernehmen, bis ein Fahrzeug aber in der Lage sein wird, sich komplett eigenständig von A nach B zu bewegen, wird es noch einige Zeit dauern.

Um solche autonomen Systeme betreiben zu können, bedarf es der notwenigen Sensorik. Die Systeme müssen aber auch verstehen, wie sie die Eingaben der Sensoren verarbeiten sollen. Dazu werden große Netzwerke mit echten Kameraaufnahmen trainiert. Ein solches Training wird auf Supercomputern ausgeführt, die dazu notwendige Hardware wird unter anderem von NVIDIA angeboten.

Ein Unternehmen von der Größe wie Tesla kann sich die Investition erlauben um die Hardware selbst zu entwickeln – ähnlich wie Amazon, Microsoft oder Google. Für das FSD (Full Self Driving) in den Fahrzeugen hat man dies bereits getan. In einem nächsten Schritt folgt nun die Trainings-Hardware.

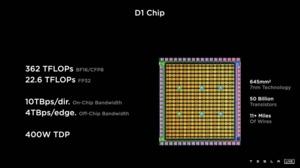

Der D1 ist Teslas erster eigener Chip für das Training von AI-Netzwerken. Dieser wird in den eigenen Rechenzentren zum Einsatz kommen. Der D1 ist ein Prozessor mit Matrix-Einheiten, einem SMT4 für die Kerne (64-Bit-Superscalar). Ausgelegt ist der Prozessor auf die Formate FP32, BFP16, CFP8, INT32, INT16 und INT8.

Der D1 wird in 7 nm bei TSMC gefertigt. Der Chip kommt auf 50 Milliarden Transistoren und eine Fläche von 645 mm². Die Rechenleistung soll bei 362 TFLOPS (BF16 und CFP8) bzw. 22,6 TFLOPS für FP32-Berechnungen liegen. Zum Vergleich: NVIDIAs A100 kommt auf 54,2 Milliarden Transistoren bei 826 mm² und wird ebenfalls in 7 nm gefertigt. Die Rechenleistung liegt hier bei 312 TFLOPS für die teilweise sparsamen Matrix-Berechnungen. Teslas D1 und der A100 können bis zu 400 W verbrauchen.

Doch nicht nur auf die Rechenleistung kommt es an. Die Daten müssen schnell zu den Recheneinheiten gelangen und dazu ist die Anbindung des Speichers und der Chips untereinander entscheidend. Der SRAM ist mit 1,5 MB vergleichsweise klein. Die chipinterne Bandbreite liegt bei 10 TB/s. Die externe Anbindung erfolgt am Randbereich des Chips über einen I/O-Ring, der über 576 Lanes mit jeweils 112 Gbit/s auf eine Off-Chip-Bandbreite von 4 TB/s kommt.

Um die Skalierbarkeit weiter fortzusetzen, kann Tesla 25 dieser Chips in einem 5x5-Layout in einem Modul unterbringen. Vieles erinnert dabei an die Wafer Scale Engine (WSE) von Cerebras. Allerdings fertigt Tesla die D1-Chips nicht direkt zusammengefasst als einen Wafer, sondern setzt die Module später zusammen. Dennoch erfolgen die Stromversorgung und Kühlung wie dies bei der WSE der Fall ist.

Einer dieser Trainings Tiles kommt auf eine Rechenleistung von 565 TFLOPS (FP32) und eine I/O-Bandbreite von 36 TB/s. Als 2x3x2-Anordnung organisiert, verwendet Tesla zwölf dieser Trainings Tiles in einem Rack und will zehn dieser Racks zum Project Dojo bzw. dem gleichnamigen Supercomputer zusammensetzen.

Tesla selbst betreibt bereits einen der schnellsten Supercomputer. Dieser besteht aus 720 Nodes, die jeweils acht NVIDIA A100 GPU-Beschleuniger besitzen. Wir kommen hier also schon einmal auf 5.760 der GPUs mit jeweils 80 GB an Grafikspeicher. Welche Prozessoren für die Nodes verwendet werden, bleibt hingegen offen.

Dojo soll dieses System bei weitem übertrumpfen. Genau 3.000 D1-Prozessoren ergeben eine Rechenleistung von 1,1 EFLOPS für BF16- und CFP8-Berechnungen bzw. 67,8 PFLOPS für FP32-Berechnungen. Das mit der NVIDIA-Hardware bestückte Cluster kommt zwar auf 1,8 EFLOPS (BF16 und CFP8), dazu sind aber wie gesagt 5.760 GPUs mit jeweils 400 W notwenig, während Dojo mit 3.000 D1 auskommt.

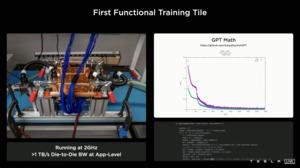

Noch ist das Project Dojo aber nicht abgeschlossen. Ein erster Testchip wird bei 2 GHz betrieben. Die Kühlung wäre in der Lage, 15 kW abzuführen. Im kommenden Jahr will Tesla den Dojo-Supercomputer in Betrieb nehmen.