Werbung

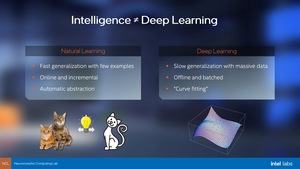

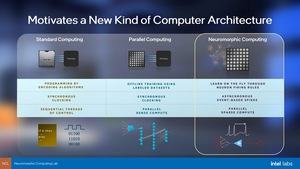

Vor drei Jahren stellte Intel die erste Generation der Hardware für das neuronale Computing vor: den Loihi. Der Chip verwendete rund 130.000 Neuronen aus Silizium und soll die Art und Weise, wie Deep-Learning-Netzwerke arbeiten effizienter machen und vor allem beschleunigen. Im Unterschied zu einem klassischen AI-Ansatz ist das neuronale Computing selbstlernend. Ein Netzwerk muss noch über mehrere hundert oder gar tausend Iterationen trainiert werden. Dieser Schritt fällt beim neuronalen Computing weg. So können Optimierungsprozesse oder das Antrainieren einer bestimmten Fähigkeit viel schneller geschehen.

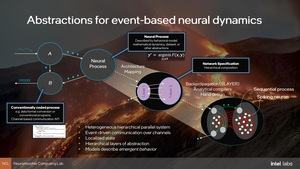

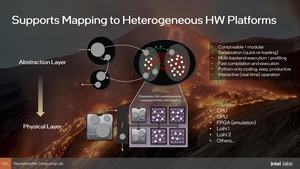

Aber die erste Generation an Hard- und Software hatte auch zahlreiche Limitierungen. Der Zugang zum Software-Ökosystem war nicht ganz einfach und eine Entwicklungsumgebung konnte alle Vorteile des neuronalen Computing ausnutzen, sodass Wissenschaftler, die damit arbeiten wollten, auch immer Kompromisse eingehen mussten. Die Veröffentlichung eines LAVA getauften SDKs soll Hard- und Software nun auf ein Niveau bringen, welches die Effizienz dieser Methodik vollends ausnutzen kann und den Zugang deutlich vereinfacht.

Einen großen Sprung macht zudem die Hardware, vor allem um bisherige Limitierungen des Designs zu umgehen.

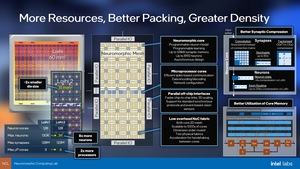

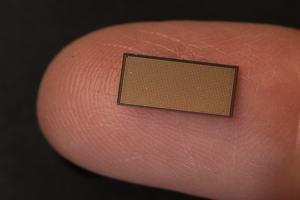

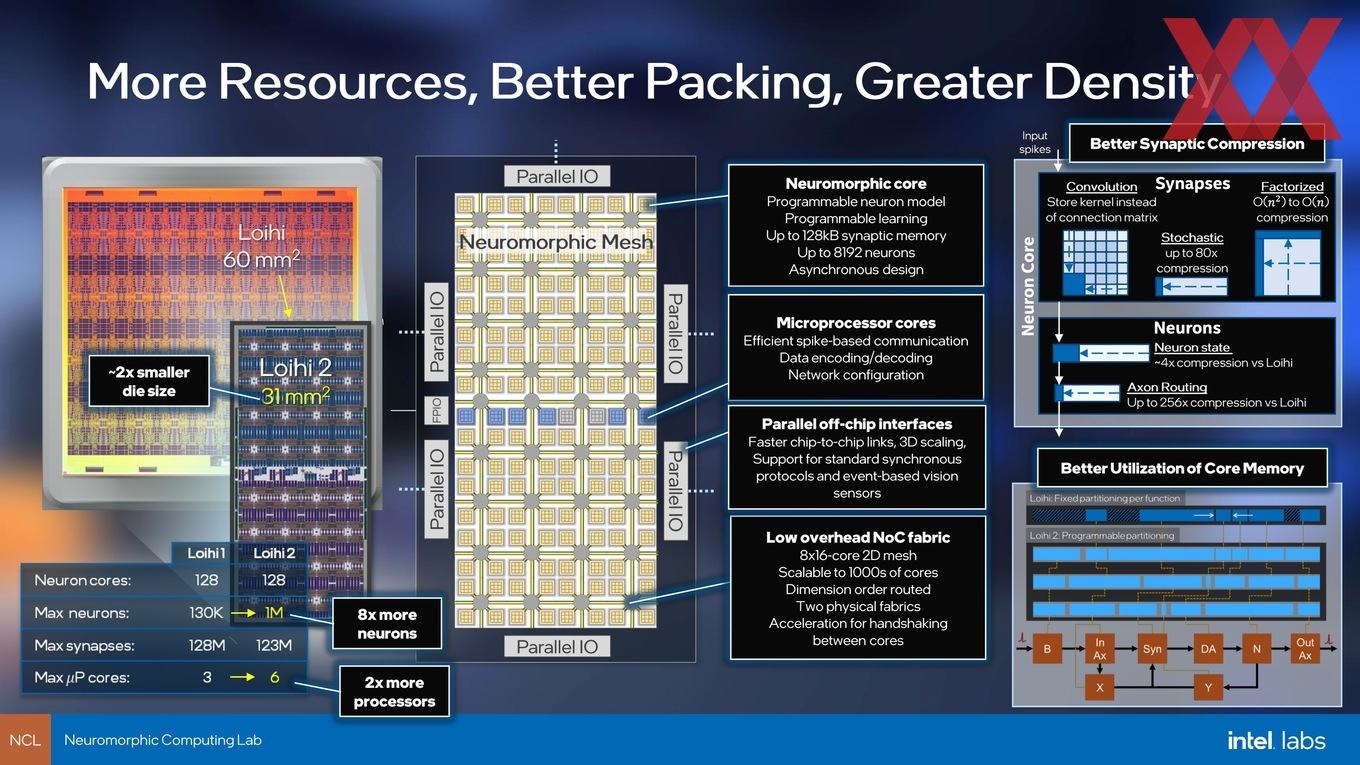

Der Loihi 2 besteht aus insgesamt 1.048.576 Neuronen, wobei jeweils 8.192 Neuronen in einem Neuromorphic Core zusammengefasst sind. In diesem Core gibt es zudem 128 kB an SRAM. Ein Loihi besteht aus 128 Neuromorphic Cores, die in einem 8x16 2D-Mesh organisiert sind. Theoretisch hätte Intel den Chip auch noch deutlich größer machen können. Am Ende aber befindet sich Intel noch immer in einer Erprobungsphase und legt es daher nicht unbedingt darauf an, besonders große Chips zu fertigen.

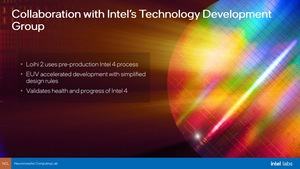

Apropos Fertigung: Diese findet in einem Pre-Production-Prozess von Intel 4 statt. So bezeichnet Intel seine bisher in 7 nm geplante Fertigung. Mithilfe der Loihi-2-Chips evaluiert die Entwicklung des Intel-4-Prozesses, sodass andere Chips, die dann ebenfalls in Intel 4 gefertigt werden sollen, von diesen Erfahrungen profitieren. Die Chipgröße des Loihi 2 liegt bei 31 mm². Der erste Loihi-Chip kam noch auf 60 mm² und wurde in 14 nm gefertigt. Mit 130.000 Neuronen war er aber auch nur 1/10 so komplex. Intel erreicht von 14 auf 7 nm hier also eine Skalierung um den Faktor 1,9.

Ein direkter Vergleich in der Funktionsweise zu einem Prozessor ist schwierig. Anstatt zahlreicher paralleler Recheneinheiten gibt es eine asynchrone Pipeline, die Neuronen, die über sogenannte Spikes ihre Informationen weitergeben. Während es bei Loihi binäre Spikes war, können bei Loihi 2 die Spikes auch Amplituden ausgeben bzw. werden von den benachbarten Neuronen erkannt und entsprechend verarbeitet. Damit steigt der Informationsgehalt der Spikes durch eine Gewichtung über die Amplitude natürlich deutlich an.

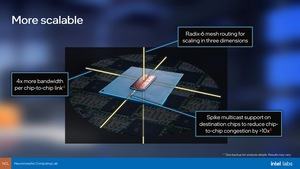

Auch die Kommunikation zwischen den Chips war mit Loihi ein limitierender Faktor. Diesen will Intel mit Loihi 2 ebenfalls behoben haben. Der Chip verfügt über mehr Ports um die Multi-Chip-Systeme zu beschleunigen. Zudem kommt hier eine Kompression zum Einsatz, bei der Spikes in der Übertragung zusammengefasst werden.

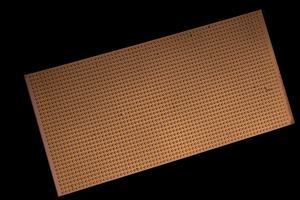

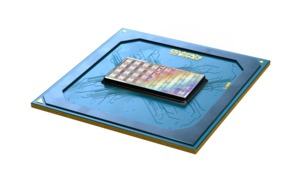

Loihi 2 wird es zunächst in zwei Designs geben: Ein Single-Chip-Module (Oheo Gulch) für die Evaluierung und dieses soll auch per Cloud-Zugriff für interessierte Wissenschaftler zugänglich sein. Außerdem soll es noch ein Kapoho Point getauftes Multi-Chip-Module mit bis zu acht Loihi-2-Chips auf einem 10 x 10 cm großen Board.

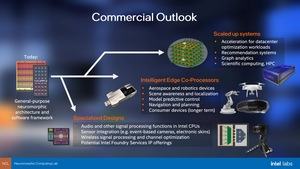

Trotz der enormen Effizienz und Geschwindigkeit des neuronalen Computings ist man bei Intel noch lange nicht soweit, daraus auch eine kommerziell nutzbare Lösung zu machen. Zunächst einmal erwartet man, dass es spezielle Designs geben wird, die darauf zurückgreifen werden. Das Audio und Signal Processing in kommenden Intel-Prozessoren könnte ein Einsatzgebiet sein. Die Auswertung von Sensor-Signalen verschiedenster Natur wäre ebenfalls denkbar.

Weiter in der Zukunft liegt der Einsatz des neuronalen Computing als Co-Prozessoren, die dann bestimmte Aufgaben im Endkunden-Segment übernehmen. Auch in der Industrie wäre der sogenannte Edge-Einsatz denkbar.

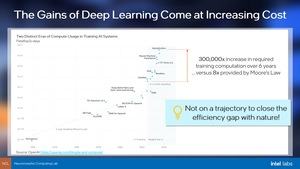

Erst viel später erwartet Intel den Einsatz im Rechenzentrum. Das Training von Deep-Learning-Netzwerken kostet immer mehr Zeit. Neue Hardware und effiziente Softwareansätze haben den Zeitaufwand bisher in riesigen Schritten reduzieren können. Doch Intel sieht hier eine natürliche Grenze, die irgendwann erreicht wird und dann kann nur noch das neuronale Computing eine weitere Beschleunigung ermöglichen. Außerdem wird es als Alternative zum Quantum Computing gesehen – wenngleich auch nicht in allen denkbaren Anwendungsfeldern.

Wie sich diese Technik weiterentwickeln wird, bleibt abzuwarten. Ob am Ende tatsächlich eine kommerzielle Nutzung erreicht werden kann, hängt vor allem davon ab, ob auch außerhalb Intels Wissenschafter und Designer von diesem Konzept überzeugt werden können.