Werbung

So langsam aber sicher beginnt Intel damit, die ersten offiziellen Brotkrumen an Informationen zu Meteor Lake zu verteilen. Nachdem dies im Rahmen der Client-Roadmap im Hinblick auf die Fertigung des Compute-Tile mit den eigentlichen CPU-Kernen aus der Intel-4-Fertigung geschehen ist, kommen für die weiteren Tiles teilweise ebenfalls eigene Fertigungstechnologien (zum Beispiel Intel 22FFL für den Base-Tile), aber auch externe Chips zum Einsatz (GPU-, I/O- und SoC-Tile von TSMC).

Bereits in der vergangenen Woche bestätigte Intel, dass für Meteor Lake eine VPU genutzt wird. Dies geschah im Rahmen der Build-Konferenz von Microsoft, die mit Windows 11 eine Schnittstelle bereitstellen wollen, die eben den Intel- auch AMD-Prozessoren unterstützen wird.

Die Notwendigkeit nach dedizierter AI-Hardware sehen fast alle Hersteller – sei es Intel, AMD oder NVIDIA. Während dies in bestimmten Segmenten bereits alltäglich genutzt wird (siehe DLSS von NVIDIA oder Bildanalyse-Software), sollen die Anforderungen in den kommenden Jahren weiter signifikant wachsen.

Dabei unterstützen auch die aktuellen Intel-Prozessoren bereits die Ausführung bestimmten Codes, der auf AI-Anwendungen hin optimiert ist. Für die Thread Detections Technology setzt Intel gewisse Hardware-Ressourcen ein. Gleiches gilt für das AI-Upsaling XeSS.

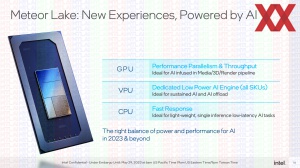

Zukünftig sollen die AI-Workloads auf gleich drei "Beschleuniger" bzw. Ressourcen zurückgreifen können. Die GPU wird weiterhin in der Lage sein, AI-Workloads in parallelisierter Art und Weise auszuführen und erreicht einen hohen Durchsatz. Dies ist ideal für Foto-, Video- und 3D-Inhalte, der per AI unterstützt oder bearbeitet werden.

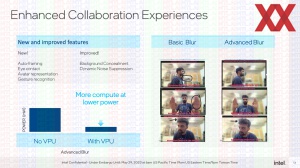

Auch die CPU-Kerne können leichte Inferencing-Aufgaben übernehmen. Die nun integrierte VPU übernimmt AI-Aufgaben, die in gewisser Weise ständig nebenher laufen. Dazu gehört die bereits eben erwähnte Thread Detection. Aber auch das Einblenden eines anderen Hintergrunds in einer Webkonferenz oder die Geräuschunterdrückung.

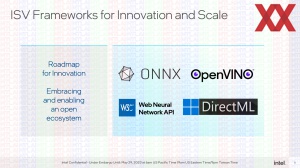

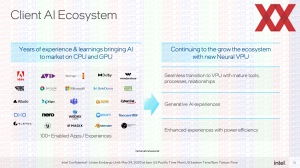

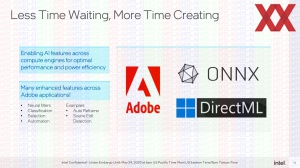

Zunächst einmal wird es darum gehen, das notwendige Ökosystem aufzubauen. ONNX, OpenVINO, W3C und DirectML stehen als Schnittstelle bzw. Framework zur Verfügung. Software von Adobe, Zoom, Blackmagic, Avid und viele mehr soll dann auf die dedizierte AI-Hardwarebeschleunigung zurückgreifen können.

In einem ersten Schritt wird dabei sozusagen hartkodiert festgelegt, welcher AI-Workload auf der GPU, der VPU oder auf den Kernen ausgeführt wird. Einen dynamischen Thread Schedular gibt es nicht. Bestimmte Workloads eigenen sich aber besonders gut für die VPU, andere wiederum laufen auf der GPU am besten – diese Festlegung wird von Intel zusammen mit den jeweiligen Softwareanbietern erfolgen.

Die Effizienz einer dedizierten AI-Hardware ist, wo diese punkten kann. Intel nennt noch keine konkreten Zahlen, der Einsatz einer VPU soll zum Beispiel für eine Videokonferenz mit mehreren Effekten und Optimierungen um mehrere Faktoren effizienter sein und hält somit auch Ressourcen frei.

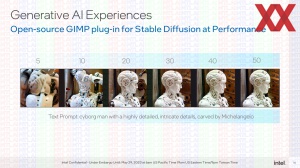

Am Beispiel von Stable Diffusion, einer AI-Bildgenerierung, demonstriert Intel die Ausführung auf Meteor Lake. Genutzt werden im ersten Teil der Demo die GPU, die CPU-Kerne und die VPU. In einem zweiten Teil der Demo kommt dann ausschließlich die VPU zum Einsatz.

Datenschutzhinweis für Youtube

An dieser Stelle möchten wir Ihnen ein Youtube-Video zeigen. Ihre Daten zu schützen, liegt uns aber am Herzen: Youtube setzt durch das Einbinden und Abspielen Cookies auf ihrem Rechner, mit welchen Sie eventuell getracked werden können. Wenn Sie dies zulassen möchten, klicken Sie einfach auf den Play-Button. Das Video wird anschließend geladen und danach abgespielt.

Ihr Hardwareluxx-Team

Youtube Videos ab jetzt direkt anzeigen

Gegen Ende des Jahres sollen die Meteor-Lake-Prozessoren offiziell vorgestellt werden. Ob sie exklusive für Notebooks angeboten werden, dazu gibt es immer wieder verschiedene Meldungen und Gerüchte. Offiziell hat sich Intel dazu noch nicht geäußert.