Werbung

Im Mai präsentierte Ampere Computing mit dem AmpereOne den ersten "Cloud Native Prozessor", der auf einem eigenen Design basierte. Der AmpereOne bietet bis zu 192 Kerne, acht DDR5-Speicherkanäle und 128 PCI-Express-Lanes.

Als einer der ersten großen Kunden wird Google nun Instanzen mit dem AmpereOne anbieten. Diese sind als C3A verfügbar und bieten 1 bis 80 vCPUs mit DDR5-Speicher, lokalem SSD-Speicherplatz und einer Netzwerkanbindung mit bis zu 100 GBit/s. Zielgruppe für die C3A-Instanzen sind vor allem VM-Anwendungen, für die Google eine Verfügbarkeit von 99,99 % angibt.

Mit der Produktion des AmpereOne wurde im Mai begonnen. Nach den ersten großen Cloud-Partnern wird Ampere Computing die Hardware auch den weiteren Partnern zur Verfügung stellen, so dass wir bald mehr belastbare Zahlen zur Leistung erwarten dürfen.

Das Thema Zahlen und Benchmarks spielt auch in unserem Update zu dieser News eine Rolle:

Update: Neue AI-Benchmarks

Zusammen mit der Ankündigung der ersten Cloud-Instanzen mit dem AmpereOne zeigt Ampere Computing auch neue/weitere Benchmarks bezüglich der AI-Leistung der eigenen Prozessoren. Wir konnten dazu mit Jeff Wittich, Amperes Chief Product Officer (CPO), auch ein kurzes Gespräch führen.

Als Cloud Native Prozessor ist das Anforderungsprofil an die Hardware ständig im Wandel. Natürlich hat Ampere Computing den AI-Trend der vergangenen Jahre ebenfalls auf dem Schirm gehabt und sich nicht nur auf die Aufgaben als VM-Host-Machine konzentriert. Das Inferencing ist unter den Top 5 der Anwendungen, die auf den Cloud-Instanzen ausgeführt werden. Ampere Computing hat daher schon vor einiger Zeit ein AI-Team gegründet, welches sich auf die Optimierung der Software (Ampere AI Optimizer (AIO)) in diesen Anwendungsbereich konzentriert hat.

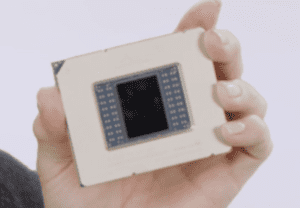

In den von Ampere Computing präsentierten Benchmarks stehen die Kosten und Effizienz (Performance/Watt und Performance/Dollar) im Fokus. Sicherlich gibt es hier Prozessoren und Beschleuniger die schneller sind, auf Performance/Watt und Performance/Dollar normiert sich sich Ampere mit dem Altra Max aber schon in Führung – noch besser dürfte dies mit dem AmpereOne aussehen.

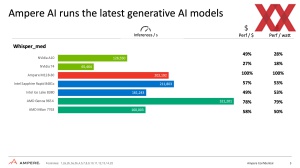

Aber nicht nur wenn der Prozessor das Inferencing übernimmt sollen die Ampere-CPUs die beste Wahl sein, auch wenn ein GPU-Beschleuniger hinzugenommen wird sieht sich Ampere Computing klar im Vorteil. Hier ist Performance/Watt die maßgebende Metrik.

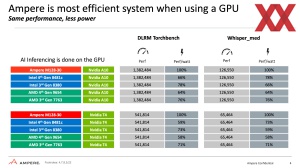

Für potentielle Kunden entscheidend ist der Blick auf die Leistung und Kosten der zur Verfügung stehenden Instanzen. Auch dazu liefert Ampere Computing zahlen mit dem noch aktuellem Ampere Altra im Vergleich zu einigen AWS-Instanzen mit EPYC- oder Graviton-Prozessor sowie den GPU-Beschleunigern von NVIDIA.

Die Zahlen und Benchmarks einzuschätzen ist nicht ganz einfach. Der Software-Stack und mögliche Optimierungen der Daten spielen hier immer wieder eine wichtige Rolle. Aber klar ist: Ampere Computing sieht sich weiter auf einem guten Weg gerade für Hyperscaler die richtige Hardware bieten zu können. Zwar arbeiten Amazon mit dem Graviton und Google mit den TPUs auch an eigener Hardware und setzen diese auch großflächig ein, aber Ampere Computing sieht diese mehr als Speziallösung im Cloud-Bereich, während man die eigenen Prozessoren auf den gesamten Anwendungsbereich in der Cloud auslegt.

Steam-on-Ampere

Ein ganz anderes Thema, aber ein interessantes Projekt namens Steam-on-Ampere ist auf GitHub zu finden. Das Repository wurde von AmpereComputing erstellt. Ziel ist es Steam auf einem arm64-System zu installieren.

Die Hardware-Basis in dieser Anleitung ist ein AADP32 mit 2x 16 GB an DDR4-Arbeitsspeicher sowie eine NVIDIA RTX 6000. Zunächst wurde ein Ubuntu auf dem System installiert, danach erfolgt die manuelle Installation des Arm-Treibers von NVIDIA für die Grafikkarte. Im nächsten Schritt musste die Emulationsschicht zwischen x86 und amd64 für arm64 eingerichtet werden.

Die komplette Anleitung ist wie gesagt auf GitHub zu finden.