Werbung

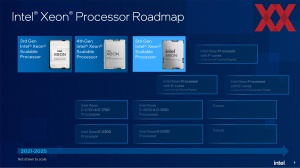

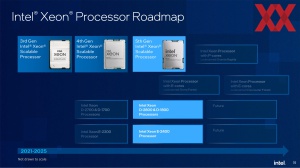

Nach nicht einmal einem Jahr präsentiert Intel heute den Nachfolger der 4. Xeon-Generation (Sapphire Rapids) alias Emeral Rapids, der wenig überraschend als 5. Xeon-Generation auf den Markt kommen wird. Allerdings hatte Sapphire Rapids auch mit zahlreichen Verzögerungen zu kämpfen und dennoch ist die beschleunigte Kadenz zwischen den Xeon-Generationen spürbar und wird sich im kommenden Jahr mit Sierra Forest als reine E-Kern-Serie sowie kurz darauf Granite Rapids als Nachfolger der Performance-Kern-Serie in dieser Geschwindigkeit auch fortsetzen.

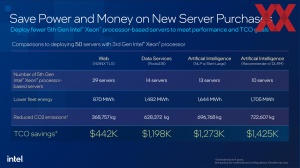

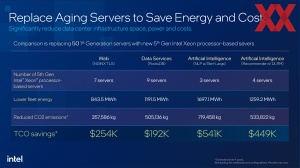

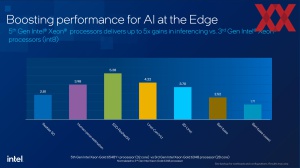

Intel sieht sich trotz oder gerade wegen des aktuellen KI-Booms in einer starken Position und fokussierte einen deutlichen Teil seiner Kommunikation zu Sapphire Rapids auf KI-Anwendungen. Mit Emerald Rapids wird diese Strategie nun fortgesetzt und auch wenn sich der KI-Markt gerade um die schnellen KI-Beschleuniger fast schon prügelt oder zumindest horrende Preise dafür aufgerufen werden, so sieht sich Intel in einer guten Position hier ebenfalls seine entsprechende Hardware an den Mann zu bringen – auch ohne Gaudi 2 als dedizierte KI-Hardware an dieser Stelle ansprechen zu wollen. Laut Intel ist ein reines Xeon-Rechenzentrum deutlich flexibler, da hier sowohl Standard- wie auch KI-Anwendungen ausgeführt werden können und gerade solche gemischten Workloads die eigentlichen Stärken der Xeon-Prozessoren sind.

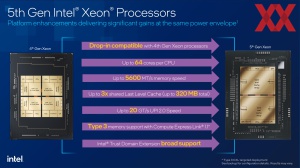

Gemeinsam mit Sapphire Rapids bildet Emerald Rapids die Eagle-Stream-Plattform. Server, die einen Sapphire-Rapids-Prozessor verwenden, können auf Emerald Rapids umgestellt werden. Es bleibt also insgesamt bei 80 PCI-Express-5.0-Lanes sowie den acht DDR5-Speicherkanälen, wenngleich es hier ein paar Verbesserungen zu vermelden gibt.

Einige der Änderungen in der 5. Xeon-Generation überführt Intel von der bereits veröffentlichten Desktop-Plattform alias Raptor Lake.

Weiterhin Intel 7, aber neue Kerne

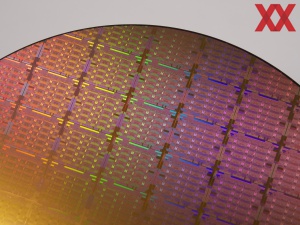

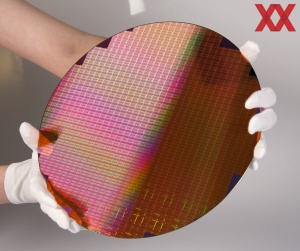

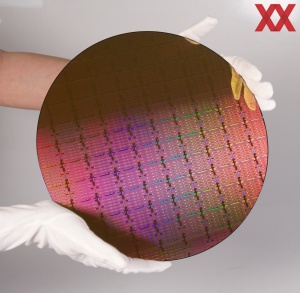

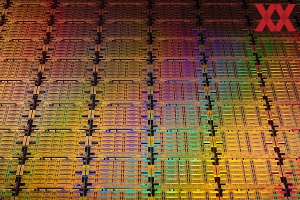

Die Fertigung der drei Chips für die Emerald-Rapids-Prozessoren findet weiterhin in Intel 7 statt. Wie auch bei den Desktop-Prozessoren spricht Intel aber von einer verbesserten Fertigung alias "Intel 7 Ultra". Man hat die Kanal-Mobilität im Halbleiterprozess verbessert, sodass man sich auf anderen Betriebspunkten der Spannungs-Takt-Kurve bewegen kann. Damit sollen auch die Xeon-Prozessoren effizienter arbeiten können, was man auch mit den entsprechenden Zahlen belegen will.

Die Mikroarchitektur basiert aber nicht mehr auf dem Willow-Cove-Design, sondern auf Raptor Cove mit 2 MB an privatem L2-Cache pro Kern sowie dem verbesserten Scheduling.

Die maximale Ausbaustufe von Emerald Rapids kommt nun auf 64 anstatt bisher 60 Kerne. Dafür setzt Intel auch nur noch zwei XCC-Dies anstatt wie bisher derer gleich vier ein. Zum Packaging kommen wir aber noch. Hinsichtlich des Taktes der einzelnen Kerne gibt es wenig Neuerungen. Wir bewegen und noch immer bei maximal 4,1 GHz für den Boost-Takt.

Für den DDR5-Speicher geht es von 4.800 MT/s bei Sapphire Rapids auf nun 5.600 MT/s bei Emerald Rapids. Dies gilt aber nicht für alle Modelle, denn wie auch schon bei der 4. Xeon-Generation gibt es hier Abstufungen. Die Speicherbandbreite steigt aber theoretisch um 16 %. Die weitaus größere Neuerung aber ist der Last Level Cache (LLC), der von bisher maximal 105 MB auf 320 MB anwächst. Dies kommt vor allem Anwendungen zugute, die ihre Daten fast komplett in den Cache ablegen können. Von hier aus sind sie dann schnell verfügbar, was unter anderem bei Inferencing-Anwendungen der Fall ist.

Für die Kommunikation zwischen zwei oder mehr Sockeln setzt Intel auf Ultra Path Interconnect (UPI). Bei Emerald Rapids beschleunigt Intel die UPI-2.0-Links von 16 auf 20 GT/s. Allerdings sei bereits an dieser Stelle darauf verwiesen, dass es in der 5. Xeon-Generation keinerlei Prozessoren für 4S- oder 8S-Systeme geben wird. Emerald Rapids konzentriert sich also ausschließlich auf 1S- und 2S-Server. Für solche mit vier oder mehr Sockel wird man weiterhin auf Sapphire Rapids zurückgreifen müssen.

Keinerlei Änderungen gibt es in der Anzahl der IP der Beschleuniger. Der XCC-Die bietet in einem Accelerator Cluster:

- 4x DSA

- 4x QAT

- 4x DLB

- 4x IAA

Der MCC- und EE-LCC-Die kommt auf:

- 1x DSA

- 2x QAT

- 2x DLB

- 1x IAA

An dieser Stelle wollen wir die Funktion der einzelnen Beschleuniger noch einmal erläutern:

- QAT (QuickAssist Technology): Ist nun Teil des Kerns und für Verschlüsselung und Kompression von Datenstreams vorgesehen. Network Secure Gateways und Content Delivery Networks sind zwei der denkbaren Anwendungen für QAT.

- DLB (Dynamic Load Balancer): Der DLB sorgt für ein besseres Load Balancing und eine bessere Auslastung der Kerne auch für wenig anspruchsvolle Workloads. Als eine QoS können bestimmte Pakete in der Pipeline auch priorisiert werden.

- DSA (Data Streaming Accelerator): Speicherzugriffe laufen nicht mehr über die Kerne, sondern teilweise ausgelagert werden. Dies kann für eine Datenanalyse und Distributive-Storage-Dienste sinnvoll sein.

- IAA (In-Memory Advanced Analytics Accelerator): Daten werden aus dem Speicher gelesen und in diesen geschrieben, die Dekompression und Kompression erfolgen im IAA und werden von dort in den LLC übertragen. In-Memory Datenbanken, Datenanalyse oder Datenbanken allgemein sind Anwendungsfelder von den IAA.

Daneben gibt es noch die Advanced Matrix Extensions (AMX) und AVX-Befehlssatzerweiterungen, die sich in den Kernen befinden, während die Beschleuniger als Bestandteil des Accelerator-Clusters extern angebunden sind.

Schlankeres Package für geringere Latenzen

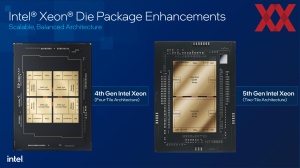

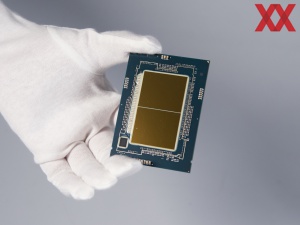

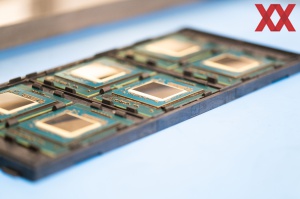

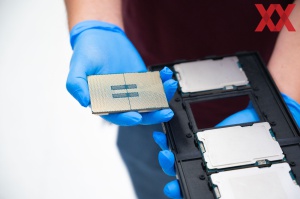

Die 4. Xeon-Generation alias Sapphire Rapids bestand aus vier XCC-Dies (Extreme Core Count) oder einem MCC-Die (Medium Core Count). Für Emerald Rapids vereinfacht Intel das Package in der Form, dass nun maximal zwei XCC-Dies zum Einsatz kommen.

Pro XCC-Tile vorhanden sind 33 Kerne, von denen aber maximal 32 aktiv sind. Somit kommt das Modell mit der höchsten Kernanzahl eben auf 64 Kerne. Es gibt einen South-Die und einen North-Die, die gespiegelt zueinander aufgebaut sind. Miteinander verbunden sind die zwei Tiles über drei EMIB-Schnittstellen.

Der MCC-Tile kommt auf maximal 32 Kerne, auch wenn rein technisch 34 Kerne vorhanden wären. Aber auch hier schaltet Intel zur Steuerung der Fertigung maximal 32 Kerne frei. Mit der 5. Xeon-Generation bringt Intel auch den EE LCC (Edge Enhanced Low Core Count) zurück. Dieser bietet bis zu 20 Kerne und wird bei nur wenigen Modellen zum Einsatz kommen.

Zu den Größen der Tiles macht Intel keinerlei Angaben. Für den MCC-Die darf man aber davon ausgehen, dass Intel die aktuell maximale Größe von fast 700 mm² aber sicherlich fast ausschöpft.

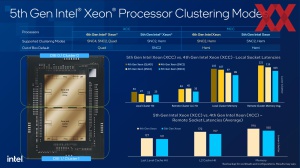

Die Reduzierung von vier auf zwei Tiles hat für die entsprechenden Modelle einige Vorteile, auch wenn die einzelnen Chips größer werden. So reduzieren sich die Latenzen für die Kommunikation und den Datenaustausch zwischen den Chips. Der größere LLC ermöglicht zudem eine höhere Hitrate, was wiederum den Datenverkehr reduziert und damit effizienter gestaltet. Für das Sub-NUMA Clustering geht Intel Out of the Box auf ein SNC2.

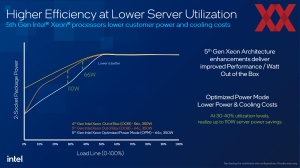

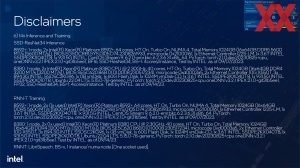

In der Teillast effizienter

Bereits mit der 4. Xeon-Generation führte Intel den Optimized Power Mode (OPM) ein, der für die Teilllastbereiche eine Reduzierung der Leistungsaufnahme ermöglichen sollte. Für Emerald Rapids hat Intel den OPM nun weiter optimiert und reduziert die Leistungsaufnahme bei 50 % Last und weniger noch einmal deutlich. Für diesen Bereich und den Idle-Betrieb spricht Intel von bis zu 110 W an Einsparung.

Aber auch die Interconnect-Lösungen, die Meshes sowie die FIVR (Fully Integrated Voltage Regulator) wurden weiter optimiert. Die Prozessoren sollen ihre Betriebspunkte schneller wechseln und damit effizienter arbeiten können.

Was auf den ersten Blick nach nicht viel aussieht kann sich in einem Rechenzentrum mit hunderten oder gar tausenden Servern schnell positiv auswirken. Natürlich sind die Anbieter bemüht ihre Hardware weitestgehend auszulasten und Server im Idle sind mehr oder weniger weggeworfenes Geld, aber vor allem die Optimierungen im Teillastbereich kommen in der Praxis aber sicherlich an der richtigen Stelle an.

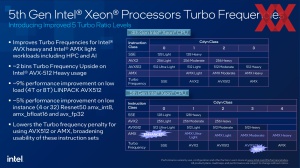

Für AVX512 und AMX gibt es neue Laststufen, in denen unterschiedliche Taktraten erreicht werden. Dies kann einerseits die Spitzenleistung verbessern, bietet auf der anderen Seite aber auch Potential für die Effizienz.

Intels eigene Leistungsdaten sind beeindruckend

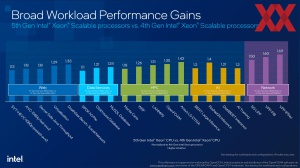

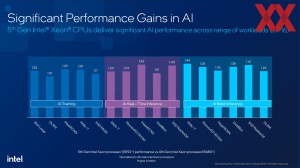

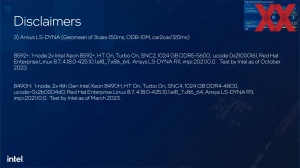

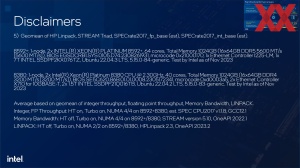

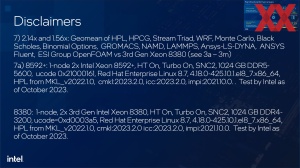

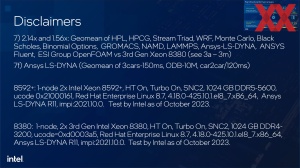

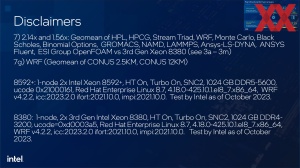

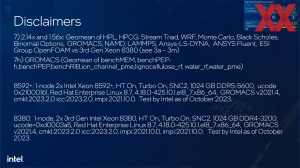

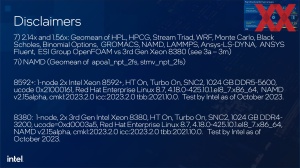

Natürlich hat Intel auch gleich einige Benchmarks zur Hand. Diese vergleichen die 5. Xeon-Generation sowohl gegen den direkten Vorgänger als auch die 3. Generation, was den wahrscheinlichsten Upgrade-Pfad beschreibt. Intel vergleicht dabei häufig die 56 Kerne von Sapphire Rapids gegen nun 64 Kerne von Emerald Rapids sowie gegen die maximal 40 Kerne der 3. Xeon-Generation (Ice Lake).

Entsprechend unterschiedlich hoch ist das Leistungsplus. Einerseits wird dieses durch die Erhöhung der Kernanzahl mit gleichzeitigem Wechsel der Architektur deutlich, auf der anderen Seite setzt Intel ab der 4. Generation auf AMX für KI-Anwendungen sowie die integrierten Beschleuniger.

Gegenüber Sapphire Rapids sieht Intel die Emerald-Rapids-Prozessoren in General-Purpose-Anwendungen um 21 % im Vorteil. Durch den größeren Cache profitieren HPC- und KI-Anwendungen um etwa 40 %. Geht man auf die 3. Xeon-Generation zurück liegt das Leistungsplus gleich bei 80 % oder gar mehreren Faktoren. Der Einsatz von AMX macht sich natürlich vor allem beim Inferencing und damit den KI-Anwendungen bemerkbar.

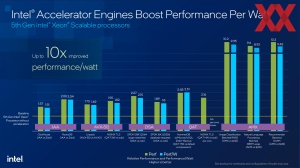

Singulär auf die Beschleuniger bezogen, kann für bestimmte Anwendungen von einer Verdopplung der Leistung im Vergleich zur Anwendung ohne diese ausgegangen werden. Inzwischen hat Intel damit wohl auch einen Status erreicht, in dem Software, die davon Gebrauch machen kann, auch großflächiger zum Einsatz kommt. Für Granite Rapids wird davon ausgegangen, dass Intel die Beschleuniger und deren Anzahl noch einmal deutlich verbessert.

CXL 1.1 soll endlich Fuss fassen

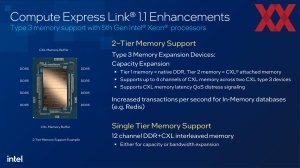

Compute Express Link oder kurz CXL scheint so langsam Fahrt aufzunehmen. Sowohl AMD wie auch Intel unterstützen CXL 1.1, aber nicht den vollen Funktionsumfang. Die physikalische Basis für CXL bildet PCI-Express 5.0.

Emerald Rapids unterstützt CXL 1.1 im ähnlichen Umfang wie auch schon Sapphire Rapids. Allerdings hat sich die CXL-Hardware weiterentwickelt und ebenso ist dies für die Prozessoren der Fall. Per CXL möglich ist die Speichererweiterung via CXL.mem. Bis zu vier Geräte werden unterstützt, wenngleich Intel hier in der Folie von zwei Geräten über vier Kanäle spricht. Theoretisch ließe sich je Kanal ein Gerät anbinden, allerdings wird aus Gründen der höheren Bandbreite meist auf zwei Kanäle je Gerät gesetzt.

Per CXL ist es einerseits möglich den Speicher deutlich zu erweitern, wenngleich die Anbindung nicht so schnell wie der DDR5-Speicher ist. 320 MB an LLC plus 4 TB an Arbeitsspeicher und nun eben noch eine Speichererweiterung via CXL. Samsung hat mit dem CXL 2.0 DRAM bereits die entsprechende Hardware mit 128 GB vorgestellt, die 35 GB/s erreichen können soll.

Produktfamilie wird entschlackt

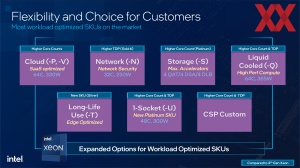

Werfen wir nun einen Blick auf das Angebot der Xeon-Prozessoren der fünften Generation alias Emerald Rapids. Wie bisher auch bietet Intel innerhalb dieser Serien auf bestimmte Anwendungen optimierte Modelle bzw. komplette Serien:

- Cloud: P- und V-Serie

- Netzwerk: N-Serie

- Storage: S-Serie

- 1-Socket: U-Serie

- Long-Life Use: T-Serie

- Wassergekühlt: Q-Serie

Was allerdings auch direkt auffällt: Von der 5. Generation der Xeon-Prozessoren gibt es keine Varianten für 4S- und 8S-Systeme. Diese Kundengruppe wird also weiterhin über die 4. Generation bedient.

Innerhalb der Produktgruppen weiterhin auffällig ist, dass DDR5-5600 bei den General-Purpose-Prozessoren nur in der Platinum-Serie unterstützt wird. Für Gold und Bronze wird meist nur DDR5-5200 bis herunter auf DDR5-4400 geboten. Dies war auch schon bei der 4. Xeon-Generation der y, allerdings nicht in diesem Umfang. Von der höheren Speicherbandbreite profitiert man also nur, wenn man auch das entsprechende Modell wählt.

Preislich orientieren sich die Emerald-Rapids-Prozessoren leicht, aber nicht übermäßig nach oben. Das Spitzenmodell mit 64 Kernen kostet 11.600 US-Dollar. Das kleinste Modell mit acht Kernen ist bereits ab 415 US-Dollar zu bekommen.

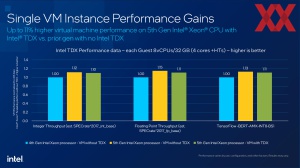

Darüber hinaus sei noch erwähnt, dass nun alle Modelle TDX (Trust Domain Extensions) unterstützen und damit einzelne VMs isoliert werden können. In der 4. Xeon-Generation war dies nicht für alle Modelle der Fall. Die Anzahl der Beschleuniger ist abhängig vom jeweiligen Modell. Das Hinzubuchen über den On-Demand-Dienst wird weiterhin über die OEMs oder SIs angeboten. Intel stellt nur die Schnittstelle bereit. Verkauft der Anbieter seinem Kunden einen Server mit einem Prozessor-Modell, welches keine oder zu wenige Beschleuniger anzubieten hat, können dieser per On-Demand nachgebucht werden. An diesem Modell ändert sich also nichts.

Die Prozessoren der 5. Xeon-Generation sind ab sofort erhältlich. Bei den großen OEMs und SIs werden die entsprechenden Server angeboten. Die großen Hyperscaler haben bereits damit begonnen, die entsprechenden Prozessoren zu verwenden. Der Übergang zwischen den Xeon-Generationen ist bei den großen Cloud-Anbietern fließend – alte Server fallen nach einer gewissen Zeit aus dem Angebot, die neuen werden dann entsprechend mit Emerald Rapids bestückt.