Werbung

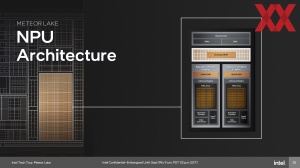

Bereits vor mehr als einem Jahr, auf der CES 2023 sprach AMD davon, dass zukünftige Prozessoren ohne eine AI-Beschleunigung nicht mehr denkbar sind. Entsprechend boten und bieten die Ryzen-Mobile-7000-Serie sowie die neuen Ryzen-8000(G) für Notebooks und den AM5 bereits mit Ryzen AI entsprechende Hardwareeinheiten. Bei Intel sind es die aktuellen Meteor-Lake-Modelle, die auf eine NPU im SoC-Tile setzen.

Doch abgesehen von den Windows Studio-Effekten ist der Nutzer noch weit entfernt davon die Beschleunigung per NPU auch wirklich zu nutzen. Häufig greifen Anwendungen, die theoretisch von den deutlich effizienteren NPUs Gebrauch machen könnten, noch auf die CPU- oder GPU-Kerne zurück, um die KI-Beschleunigung im Code der Programme zu nutzen.

Wir sehen hier also wieder das typische Henne-Ei-Problem, bei dem die Software zunächst auf die Hardware warten muss, um neue Funktionen auch wirklich nutzen zu können und solange die Software nicht in einem größeren Umfang davon Gebrauch macht, sieht der potentielle Käufer wenig Anreize sich nach einer neuen Hardware umzuschauen.

Um Entwicklern den Zugang zu erleichtern, hat Intel sich dazu entschieden die NPU Acceleration Library auf GitHub als Open-Source zu veröffentlichen.

Tony Mongkolsmai, Software-Architekt bei Intel, zeigt auch gleich, was mit der NPU Acceleration Library so alles möglich ist als Entwickler. So können kleine LLMs wie Gemma-2b oder TinyLlama mit wenigen Milliarden Parametern auf der NPU ausgeführt werden. Damit lassen sich kleine KI-Anwendungen lokal ausführen und setzen als Entwickler nicht voraus, dass man eine besonders starke Hardware im System dazu verbaut hat oder gar auf externe Rechenleistung in der Cloud zurückgreifen muss.

Bisher ist der Funktionsumfang der NPU Acceleration Library noch recht eingeschränkt. Die Funktions-Roadmap verzeichnet noch einige Lücken. Vor allem die Unterstützung von BFloat16, Mixed-Precision-Inference und die Möglichkeit die Anwendung heterogen auf NPU und GPU zugleich ausführen zu können, fehlen aktuell noch.

Auch AMD ist derzeit bestrebt, zunächst einmal die Entwickler zu motivieren, mehr und mehr Software so anzupassen, dass diese von den NPUs auch Gebrauch machen können. Auch hier ist abseits von einigen Demos noch wenig konkrete Anwendungssoftware zu finden, die auch wirklich die NPU nutzt und nicht einfach nur auf der CPU-Kernen oder der GPU läuft. Auf GitHub is auch hier eine entsprechende Ryzen-AI-Bibliothek zu finden.