che new

Enthusiast

Thread Starter

- Mitglied seit

- 31.07.2006

- Beiträge

- 6.540

Im Netz finden sich mittlerweile einige Stromverbrauchsmessungen zu Desktop Llano-APUs, auch das Thema Leistungsaufnahme bei Undervolting hat in Artikeln zwar schon etwas Beachtung gefunden, jedoch oft nicht allzu umfangreich oder tiefgründig. Leider hat dabei bisher das Undervolting von Northbridge & GPU keine Rolle gespielt, obwohl sie auch wichtiger Teil der APU sind. Das war für mich Grund genug diesen Bereich ebenfalls Aufmerksamkeit zu schenken. Was ich während dessen Interessantes festgestellt habe, könnt ihr hier lesen.

Testsystem

APU#1: AMD A6-3670 BE (100W TDP), 4x 2,7GHz, VID 1,4125V

APU#2: AMD A4-3400 (65W TDP), 2x 2,7GHz, VID 1,4125V

APU#3: AMD A8-3820 (65W TDP), 4x 2,5GHz (Turbo 2,8GHz), VID 1,3250V (Turbo VID 1,3875V)

Mainboard: Gigabyte GA-A75N-USB3 (Bios F3c)

RAM: 2 x 4GB Samsung DDR3L-1600 (MV-3V4G3D)

SSD: Corsair P64 64GB

NT: Antec EarthWatts EA-380D Green (80+ Bronze)

Kühler: Noctua NH-L12 (nur 120mm Lüfter)

Tastatur: Cherry Cymotion Pro, Kabel (USB)

Maus: Logitech OEM RX 250, Kabel (USB)

Messgerät: No-Energy NZR (SEM 16)

Betriebssystem: Windows 7 Professional 64bit (Service Pack 1)

Treiber:

Software:

Einstellungen:

1) Auswirkung von Undervolting an CPU-Kernen und CPU-NB/GPU (A6-3670 BE)

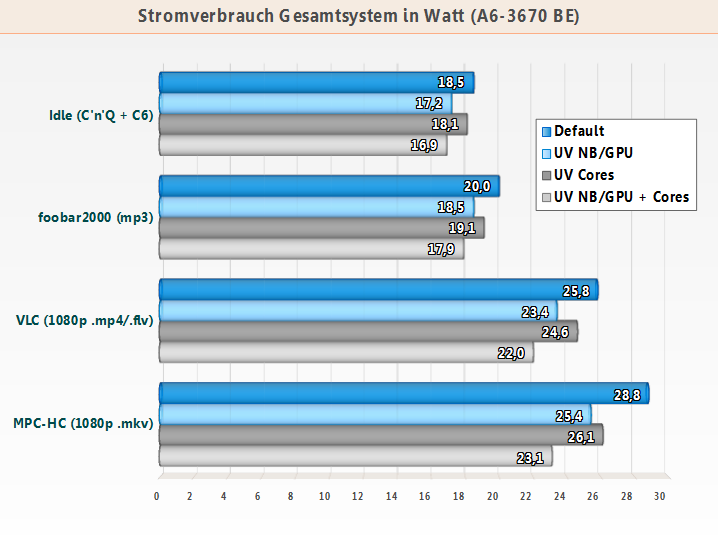

Als erstes habe ich relativ umfangreiche Messungen an einem System mit A6-3670 BE durchgeführt und die Entwicklung der Leistungsaufnahme bei Default-Betrieb, bei Undervolting des NB/GPU-Teils, bei Undervolting der CPU-Kerne und zu guter Letzt bei gleichzeitigem Undervolten von NB/GPU und CPU-Kerne dokumentiert. Der Grund warum ich NB und GPU immer in einem Atemzug nenne, ist ein ganz einfacher. Beides wird über die selbe Phase mit Spannung versorgt, undervoltet man die CPU-NorthBridge wird automatisch auch die GPU-Spannung gesenkt.

mit Spannung versorgt, undervoltet man die CPU-NorthBridge wird automatisch auch die GPU-Spannung gesenkt.

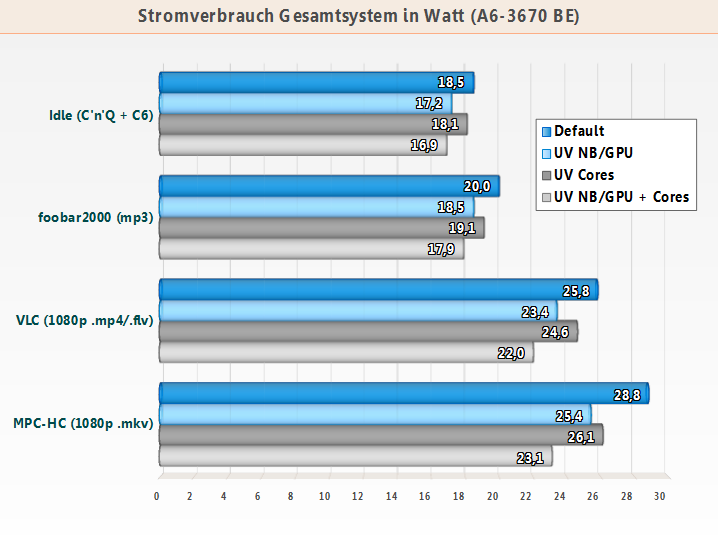

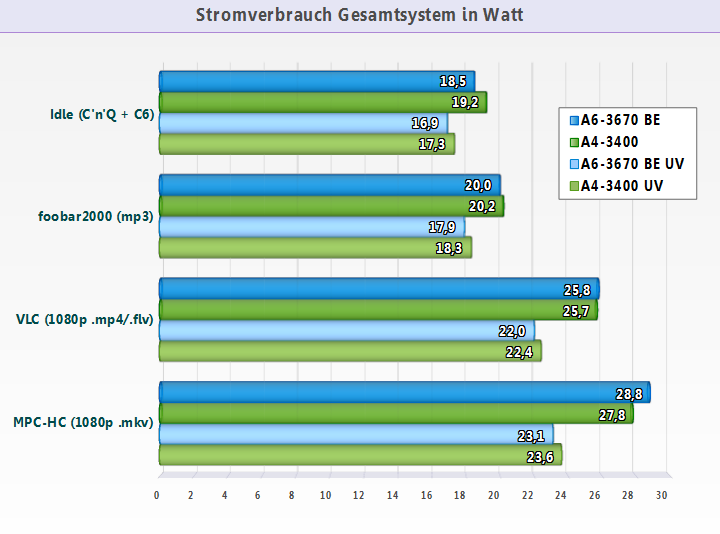

Gut zu sehen ist, dass im Leerlauf und bei geringen Lasten das Undervolten der NB/GPU deutlich mehr bringt als das Undervolten der CPU-Kerne. Aufgrund von Stromspartechniken wie Cool and Quiet/Clockgating und Powergating (C6 State) ist bei den Kernen im Idle praktisch nichts mehr zu holen. Laut AMDs Folien kann auch der GPU-Part „power gegatet“ werden, das bedeutet die sichtbare Ersparnis im Idle kommt vermutlich hauptsächlich von der Northbridge bzw. dem IMC (= Integrierten Memory-Controller). Unter Teillasten wie Videowiedergabe arbeitet hauptsächlich die GPU (die CPU-Kerne befinden sich dabei immer im höchsten P-State, was beim Llano 800MHz Taktrate bedeutet), dadurch wird der Nutzen von NB/GPU-Undervolting nochmals etwas verstärkt.

Vorwort zu den Lastmessungen:

Vielleicht wird sich der eine oder andere fragen, warum der MSI „Kombustor“ und kein „Furmark“ als GPU-Last Tool zum Einsatz kommt. Ich habe mich für den Kombustor entschieden, weil er einige Vorteile aufgrund seiner Möglichkeiten hat und dadurch aussagekräftiger als anderen GPU-Tools ist.

Furmark z.B. beschränkt sich auf nur eine API (OpenGL), die zudem im kommerziellen Spielmarkt kaum Verwendung findet, im Gegensatz zur weit verbreiteten Direct3D aka DirectX API. Das macht dieses Tool noch weniger repräsentativ als es ohnehin schon ist. Weiterhin belastet Furmark beim GPU Burn-in nicht nur den GPU-Teil sondern lastet einen von mehreren CPU-Kernen vollständig aus, bei einem Quad-Core ergeben sich dadurch ~25% CPU-Last, bei einem Dual-Core bereits ca. 50%.

Der Kombustor hingegen stellt alle aktuellen APIs zur Verfügung, d.h. man hat die Wahl zwischen DX 9 bis DX 11 und OpenGL 2 + 3. Des weiteren werden beim Burn-in mit DirectX die CPU-Kerne nicht belastet, die CPU-Auslastung liegt daher nur bei ca. 2-4% und somit verweilt der CPU-Teil im Idle-State (allerdings dürfte der C6 Schlafzustand der CPU-Kerne hier nicht mehr greifen). Somit wird hier wirklich fast nur die GPU belastet, NB(IMC) und RAM-Module natürlich zwangsläufig mit eingeschlossen.

Um die Unterschiede zwischen DirectX Burn-in und OpenGL Burn-in aufzuzeigen, habe ich beide APIs mit dem Kombustor vermessen und ins Diagramm aufgenommen.„Kombustor (OpenGL)“ entspricht dabei exakt Furmark, ein CPU-Kern wird also zusätzlich ausgelastet und der Verbrauch ist bis auf minimale Nuancen (+- 0,5W) mit den Furmark-Werten identisch, welche für mache ein Anhaltspunkt sein dürfte.

Ein weiterer Grund die wenig praxisrelevante OpenGL API als alleinigen Indikator für die Bewertung der GPU-Leistungsaufnahme zu berücksichtigen, ist das merkwürdige Verhalten einiger Grafikchips. Sandy Bridge iGPUs z.B. werden unter OpenGL (egal ob mit Furmark oder Kombustor) scheinbar daran gehindert, die Turbo-Taktraten (richtig) auszufahren bzw. die iGPU kann nicht voll ausgelastet werden. Erst unter der Direct3D API zeigt die Intel HD-GPU was sie wirklich aufnehmen kann, wie ich anhand dieser Werte feststellen konnte:

Die Differenzen zwischen DirectX und OpenGL sind hier nicht zu übersehen, ironischerweise ist es bei den AMD Prozessoren genau umgekehrt. Dort ist DirectX (deutlich) sparsamer, was jedoch damit zusammenhängt, dass kein CPU-Kern ausgelastet wird. Das ist dann zumindest noch nachvollziehbar. Aufgrund dieser unterschiedlichen Reaktionen (je nach GPU), war für mich die Berücksichtigung beider APIs im Burn-In-Test die logische Konsequenz. Auch im Hinblick auf Vergleiche mit anderen Architekturen wie z.B. Trinity.

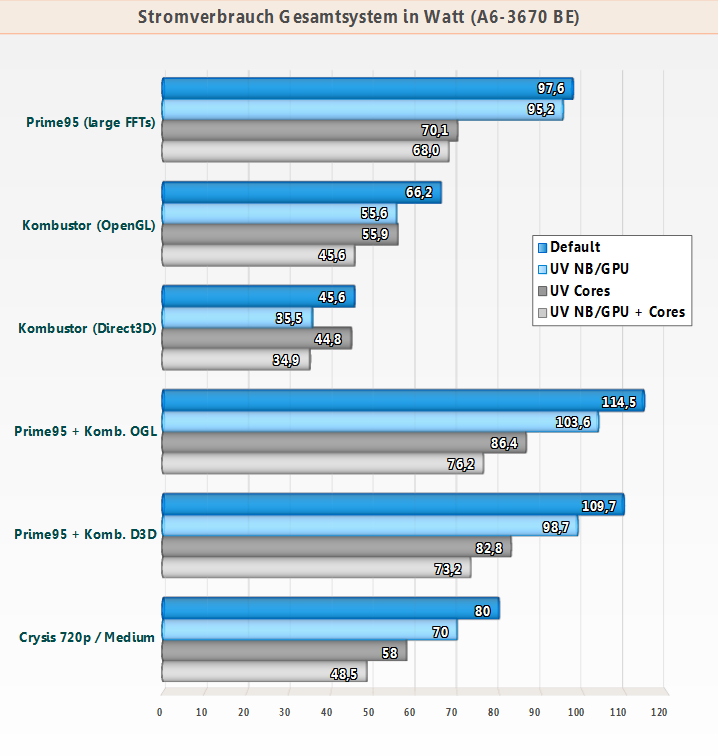

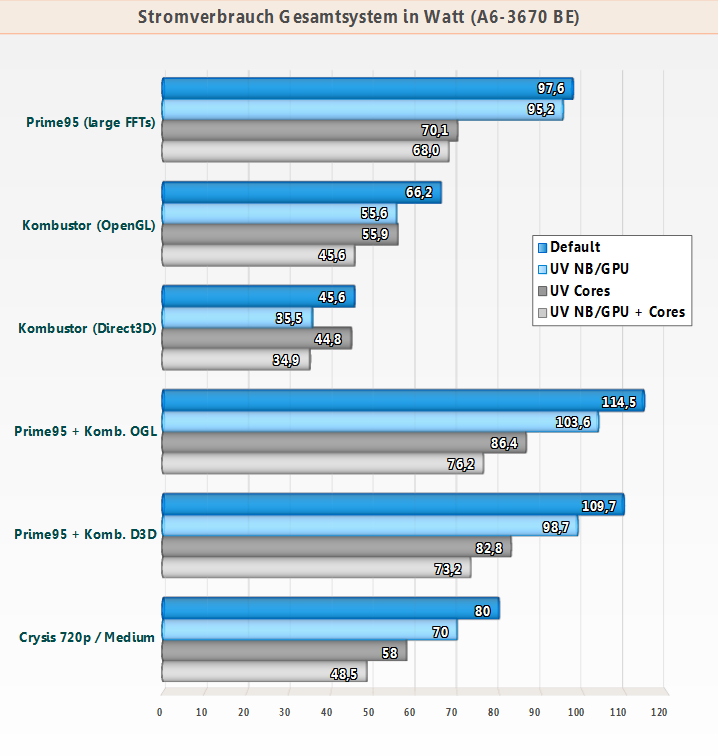

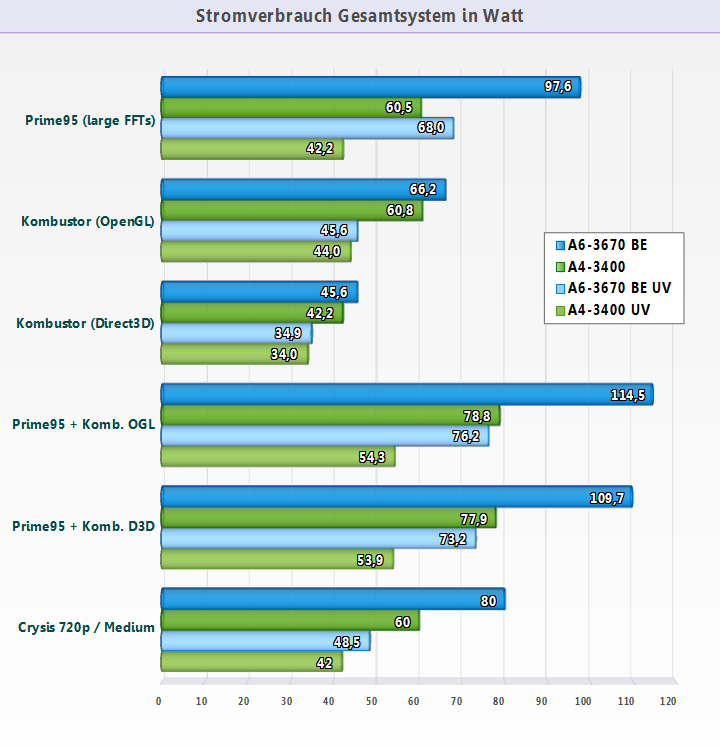

Wie nicht anders zu erwarten, bringt das Undervolting der CPU-Kerne unter Prime95 eine erhebliche Verbrauchsersparnis. Dass sie hier mit 27,5W dennoch relativ moderat ausfällt, liegt zum einen daran, dass die später erschienenen Black Edition-Modelle und 65W TDP-Modelle mit der Endung Ax-3x20 (also z.B. A8-3820, A6-3620) ein Stück weit effizienter gegenüber den ersten Modellen wie z.B. A6-3650, A8-3850 usw. geworden sind, wie hier gut zu sehen ist (selbst im Leerlauf gut erkennbar): Stromverbrauch von Llano-Motherboards - Silenthardware & Dirkvader Forum

Zum anderen liegt es aber auch an den sehr guten Spannungswandlern (insbesondere den DriverMosfets) meiner FM1-Platine. Die Größe und Ausstattung des Boards spielt übrigens nur eine untergeordnete Rolle, dieses Modell steht µATX-Boards sowieso kaum in etwas nach. Es gibt auch genug Beispiele, in denen spärliche ITX-Platinen (deutlich) stromhungriger sind als ausgewachsene, phasenreiche ATX-Boards mit identischen Chipsätzen.

Das NB/GPU-Undervolting macht sich hingegen nur leicht bemerkbar wenn alle CPU-Kerne ausgelastet werden. Deutlich anders sieht es aus wenn der GPU-Part stark ausgelastet wird, wie z.B. durch den Kombustor. Hier zeigt sich eine überraschend hohe Ersparnis, die den Verbrauch der GPU scheinbar mehr als halbiert, wenn man die Differenzen zwischen Prime95 und Prime95 + Kombustor beachtet.

Zuletzt habe ich noch die Praxis aufs Exempel gemacht und ein Spiel mit in die Messungen einbezogen. Obwohl das nach GPU-Leistung gierende Crysis (1280x720 / Medium Details) in der Regel nur zwei Kerne auslastet, ist die Ersparnis durch Undervolting in jedem Fall sehr deutlich. Wenn man bedenkt, dass durch Undervolting im gestellten Idealfall (Prime95 + Kombustor D3D) 36,5W Ersparnis herausspringen, so ist die Verbrauchsreduzierung von rund 31,5W im Praxisfall Crysis ziemlich beeindruckend.

Es gibt dabei auch keine Leistungseinbußen, denn dieses Llano-Modell verzichte komplett auf einen manchmal doch unberechenbaren Turbo. Das Spiel ist übrigens gut mit der HD 6530D spielbar. Eine Erhöhung des RAM-Taktes auf 1866MHz bringt nochmals eine kleine Erhöhung der Frame-Raten, der Verbrauch nimmt dabei mit modernen Riegel (30nm Chips) kaum erwähnenswert zu, egal ob es sich dabei um Riegel mit neuen Samsung-, Hynix- oder Micron-Chips handelt (die ich alle bereits da hatte).

2) Vergleich zwischen A4-3400 und A6-3670 BE bei Default und max. Undervolting

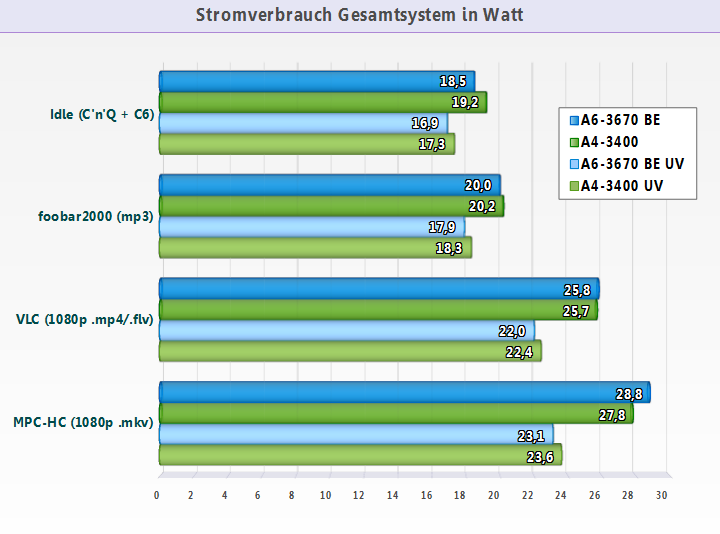

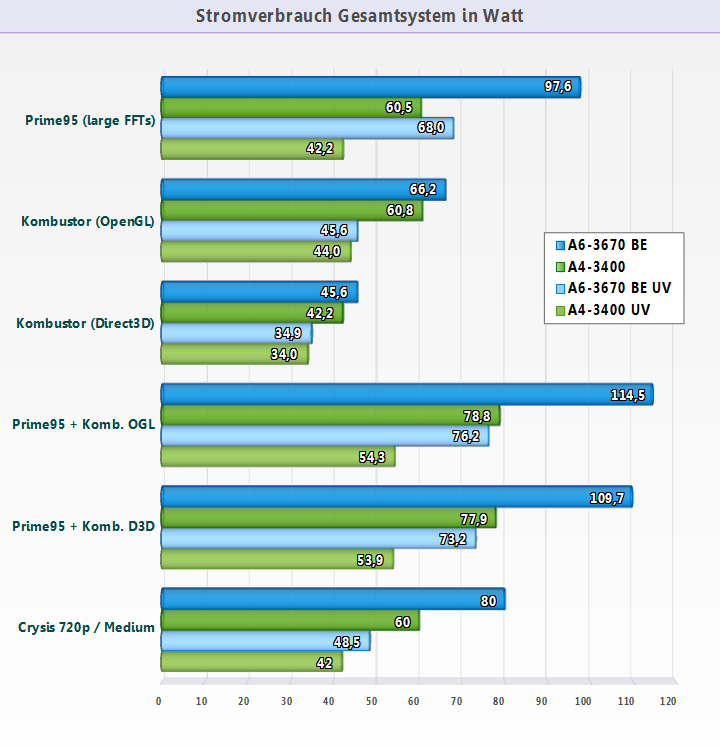

Als nächstes habe ich das gleiche Grundsystem mit einem A4-3400 Dual-Core vermessen und dem Ganzen die A6-3670 BE Werte gegenübergestellt. Damit das Diagramm nicht zu überladen wird, habe ich mich auf Messung bei Default und bei Undervolting von NB/GPU + CPU-Kerne gleichzeitig beschränkt, das sind mMn ohnehin die interessantesten Ergebnisse.

Überraschen mag auf dem ersten Blick, dass der Quad-Core Llano im Idle einen Tick sparsamer ist und selbst bei der Videowiedergabe trotz deutlich größerem GPU-Part nahezu gleich viel verbraucht wie ein Dual-Core Llano. An dieser Stelle möchte ich nochmal an den Effizienzunterschied zwischen älteren Release-Modellen und jüngeren Nachfolge-Modellen erinnern. Ein älterer A6-3650 z.B. hätte lediglich undervoltet mit einem A4-3400 mithalten können, bei Default-Betrieb wäre definitiv ein Vorsprung des Dual-Cores erkennbar gewesen, auch wenn sich dieser in Grenzen gehalten hätte.

Bei der Videowiedergabe lies sich bereits erahnen, dass die HD 6410D des A4-3400 trotz deutlich weniger Shadereinheiten (160 an der Zahl) nicht unbedingt sparsamer arbeitet als die HD 6530D des A6-3670 BE mit 320 Shadereinheiten. Das liegt vermutlich zum Teil an der Güte der Chips, denn man muss davon ausgehen, dass die Dual-Core Llanos nur teil-deaktivierte Quad-Core Llanos sind. Größtenteils wird es aber auch daran liegt, dass der GPU-Part von letzterer APU nur mit niedrigen 444MHz statt 600MHz taktet. Die interne GPU-Spannung des A6-3670 BE kann somit niedriger angesetzt werden und der geringe Takt der Shader tut sein Übriges dazu, so dass unterm Strich die HD 6530D eine deutlich bessere Effizienz besitzt.

CPU-Kern seitig gibt es eigentlich keine Auffälligkeiten, Undervolting-Potential und Verlustleistung bewegen sich im zu erwartenden Rahmen. Nachvollziehbar ist z.B., dass eine CPU mit doppelt so vielen Kernen ein sichtlich höheres Einspar-Potential durch Undervolten bietet als eine CPU mit halber Kernanzahl, insbesondere wenn Standard-Takt und -Spannung identisch sind. Natürlich liegt der deutlich schwächere Dual-Core in den CPU-Last-Szenarien trotzdem komfortabel in Führung. Ein bisschen enttäuschend wirkt der A4-3400 dann aber im Praxistest in Form von Crysis, er liefert deutlich weniger Frames als der A6-3670 BE und ist im Spiel, zumindest undervoltet, nur noch unwesentliche sparsamer (durchschnittlich ca. 6W).

Schlussbemerkungen:

Mir ist bewusst, dass der Llano schon bald am Ende seines Lebenszyklus angekommen ist und dieser Test daher etwas spät zu kommen scheint. Meine Überlegung war jedoch, dass das Interesse an den Sockel FM1 APUs immer relativ klein im Forum war. Den Hauptnutzen dieser doch etwas aufwendigen Messungen sehe ich vor allem darin, eine Vorlage zu haben mit der man den kommenden Trinity (2te Bulldozer Generation) bezüglich Effizienz und Undervolting-Potential vergleichen kann. Sicher wurde der Llano hier unter sehr guten Bedingungen vermessen, in erster Linie aufgrund der Wahl des Mainboards und dessen verbauten Spannungsversorgung. Aber ich will es dem Trinity auch nicht einfach machen, wenn er sich gegenüber dem Vorgänger beweisen soll. Die Hoffnung, dass es auch für Sockel FM2 einige Platinen mit guter Spannungsversorgung und Tweak-Möglichkeiten geben wird, besteht zumindest schon mal.

PS: Es sind auch noch zwei A8-3820 (65W TDP) CPUs vorhanden, die ich ebenfalls gründlich vermessen möchte. Allerdings wird das alles noch einige Zeit brauchen, aber ich kann schon kleine Details verraten. Das eine Exemplar hat eine VID von 1,3875V, das andere eine VID von 1,3250V, unter Prime95 liegen die CPUs grob 5W auseinander. Man kann übrigens den Turbo-Takt über den Multi festsetzen (entweder per BIOS oder per K10Stats), so dass alle vier CPU-Kerne bei Volllast mit 2,8GHz statt den üblichen 2,5GHz laufen.

Update Update Update Update Update Update Update Update Update Update Update Update Update Update Update Update

3) Auswirkung von Undervolting an CPU-Kernen und CPU-NB/GPU (A8-3820)

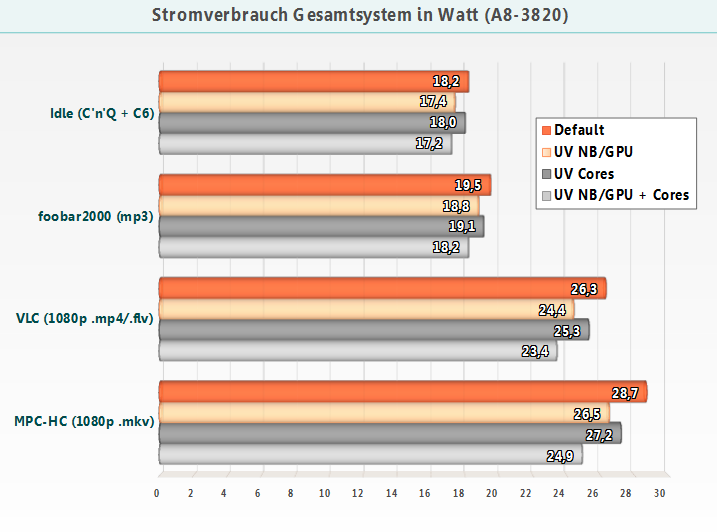

Wie vor langer Zeit angekündigt habe ich auch das Top-Modell unter den 65W TDP Llanos, den A8-3820 mit relativ flotter HD 6530D IGP, im selben System vermessen. Es handelt sich um das Exemplar mit der 1,3250V VID (1,3875V Turbo-VID), es benötigt unter Prime 95 einige Watt weniger als das zweite A8-3820 Exemplar mit 1,3875V VID (1,4125V Turbo-VID). Beide APUs zu vermessen war mir etwas zu zeitintensiv/aufwändig, die Unterschiede sind ohnehin nicht sehr groß und mit der Wahl des sparsameren der beiden A8-3820 ist auch die Herausforderung für das Piledriver-Pendant knackiger.

Immerhin habe ich die APU im gleichen Umfang wie den A6-3670 BE „untersucht“, so dass man auch hier in verschiedenen Lagen erkennen kann, was NB/GPU-Undervolting und/oder CPU-Kern-Undervolting effektiv bringt.

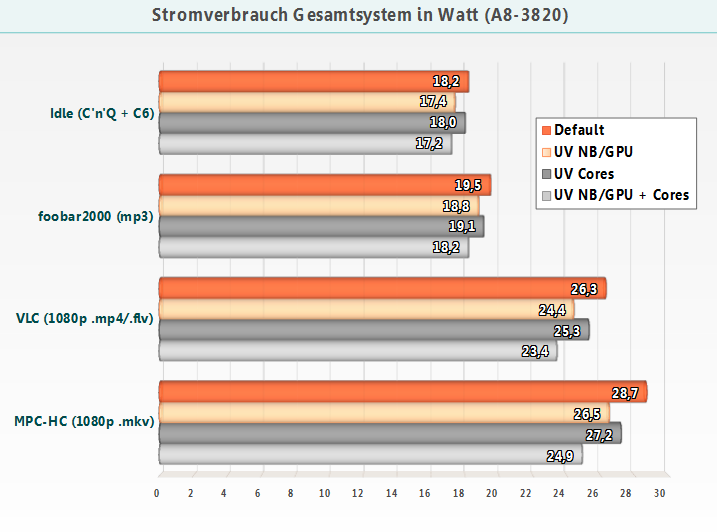

Wie schon bei den anderen beiden Llano-Modellen fällt auch hier die Ersparnis im Idle und bei Medienwiedergabe durch NB/GPU-Undervolting größer aus als durch CPU-Kern-Undervolting. Im Default-Betrieb ohne bzw. mit nur geringer Belastung liegen A8-3820 und A6-3670 BE praktisch auf einem Niveau, beim Undervolting zeigt sich allerdings eine kleine Differenz von rund 1-2 Watt zwischen den beiden Modellen. Das liegt in erster Linie daran, dass man den A8-3820 weniger stark (im Leerlauf) undervolten kann, vor allem was den NB/GPU-Part (-0,150V vs. -0,250V) betrifft, was jedoch nicht überrascht, da die GPU des 65W TDP Modells mit 600 MHz deutlich höher taktet als die GPU des Black Edition Modells (444 MHz).

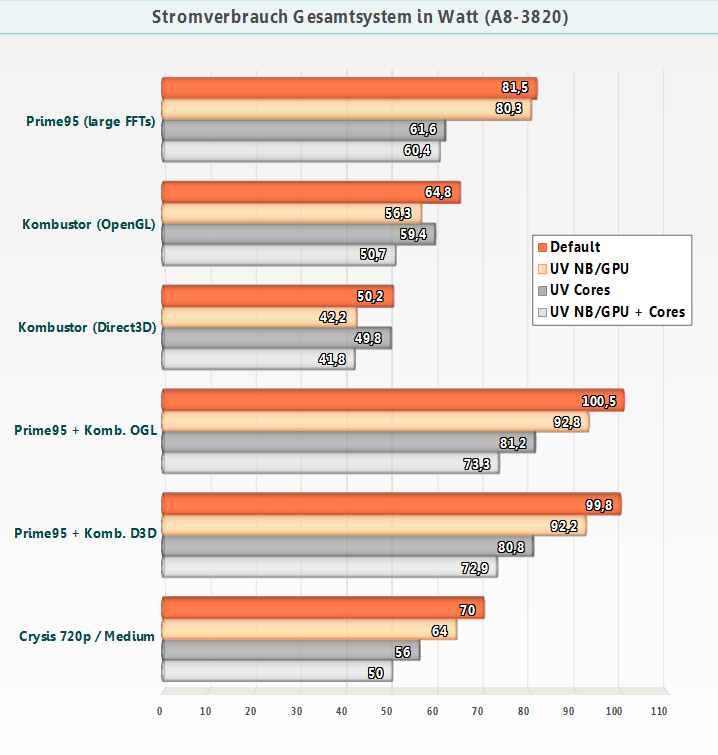

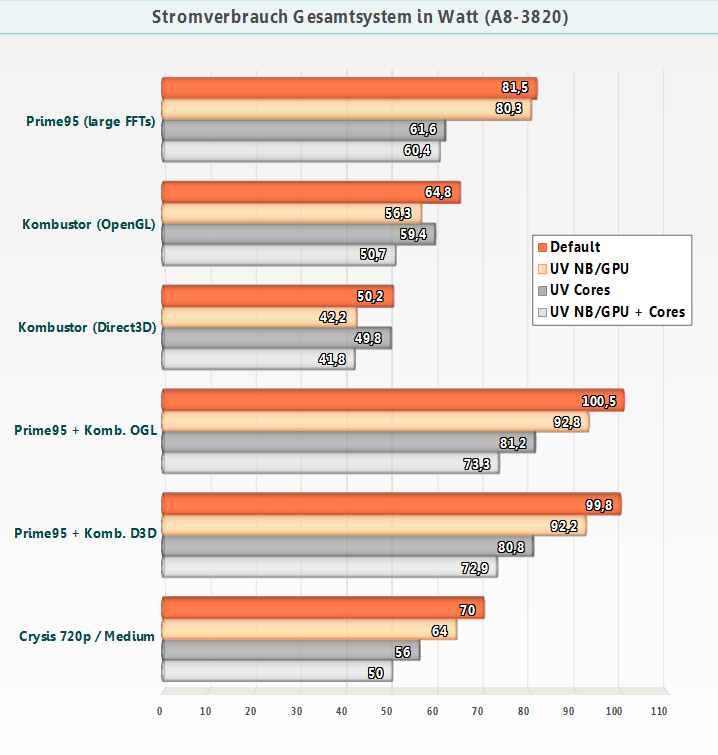

Bei den Lastmessungen gibt es ebenfalls keine großen Überraschungen, man sieht hier allerdings das AMD auch den 65W TDP Quad-Core Llanos eine sehr „großzügige“ VID spendiert. Das führt dazu, dass selbst beim A8-3820 per CPU-Kern-Undervolting noch ganze 20W Ersparnis unter starker CPU-Last herauszukitzeln sind. Was aber angesichts der möglichen Vcore-Absenkung von bis zu 0,200V nicht verwundert.

Interessant ist vielleicht noch die Feststellung, dass der Verbrauch unter Prime95 + Kombustor OpenGL (was Furmark entspricht) beinahe identisch zum Verbrauch unter Prime95 + Kombustor Direct3D ist. Das sah beim A6-3670 BE noch etwas anders aus, dort verursachte ersteres Lastszenario bis zu 5W Mehrverbrauch.

Zur Erinnerung nochmal: Die große Differenz zwischen der Kombustor OpenGL- und Kombustor Direct3D-Messung ergibt sich dadurch, das bei ersterem Belastungstest genau wie bei Furmark ein CPU-Kern voll ausgelastet wird. Im Direct3D-Szenario wird hingegen nur die GPU belastet, wie man es bei einem GPU-Test richtigerweise erwarten würde.

Vor allem unter Spielelast hinterlässt der A8-3820 einen positiven Eindruck. Er bietet die höchsten Frameraten unter den vermessenen APUs, schlägt verbrauchstechnisch aber dennoch fast immer den undervolteten A6-3670 BE in Crysis. Einzig beim Ausschöpfen des vollen Undervoltingpotentials, liegt Letzterer mit durchschnittlich 1,5W Abstand leicht vorne beim Verbrauch. Diesen Vorsprung „erkauft“ sich der undervoltete A6-3670 BE allerdings mit merklich weniger Spieleleistung, was ihn nicht unbedingt als Gewinner aus dem Vergleich gehen lässt.

Damit sind meine Verbrauchsmessungen zum Thema „Llano-Leistungsaufnahme bei Undervolting“ vorerst abgeschlossen. Als nächstes werde ich mich auf Piledriver (FM2) konzentrieren um zumindest ein Modell dieser Generation den Llano-APUs gegenüberzustellen. Ob ich mir hierfür einen Trinity (A8-5600K bzw. A10-5700) oder doch erst Richland (A8-6600K bzw. A10-6700) anschaffe, hängt davon ab ob noch (rechtzeitig) attraktive ITX-Platinen in Bezug auf Bios/UEFI-Tweakfunktionen & Bauteile erscheinen und wie es mit der preislichen Attraktivität der betreffenden APUs in den nächsten Wochen aussieht. Möglicherweise lasse ich mich durch die Spielbeilage und dem kommenden Preisnachlass noch zum Kauf eines A8-5600K oder ähnlichem verleiten.

Testsystem

APU#1: AMD A6-3670 BE (100W TDP), 4x 2,7GHz, VID 1,4125V

APU#2: AMD A4-3400 (65W TDP), 2x 2,7GHz, VID 1,4125V

APU#3: AMD A8-3820 (65W TDP), 4x 2,5GHz (Turbo 2,8GHz), VID 1,3250V (Turbo VID 1,3875V)

Mainboard: Gigabyte GA-A75N-USB3 (Bios F3c)

RAM: 2 x 4GB Samsung DDR3L-1600 (MV-3V4G3D)

SSD: Corsair P64 64GB

NT: Antec EarthWatts EA-380D Green (80+ Bronze)

Kühler: Noctua NH-L12 (nur 120mm Lüfter)

Tastatur: Cherry Cymotion Pro, Kabel (USB)

Maus: Logitech OEM RX 250, Kabel (USB)

Messgerät: No-Energy NZR (SEM 16)

Betriebssystem: Windows 7 Professional 64bit (Service Pack 1)

Treiber:

- AMD Catalyst Grafiktreiber 12.3

- AMD Chipsatztreiber (inkl. AHCI-Treiber) 12.3

Software:

- foobar2000 v1.1.5: MP3-Datei -> Audio-Datei mit 320 kBit/s

- VLC media player 2.0.1: MP4-Datei -> Big Buck Bunny (1080p)

- Media Player Classic - Home Cinema 1.6.1.4235 + Haali Media Splitter/Renderer 1.11.96.14 + LAV-Filters 0.50.2: MKV-Datei -> Killa-Sampla x264 (1080p)

- Prime95 v25.11 build 2

- MSI Kombustor 2.3.0 (GPU Burn-ins mit OpenGL 2 und Direct3D 10)

- Crysis DX10 (Feb 27 2008) inkl. Patch 1.2

Einstellungen:

- Default = C6 State + Virtualisierung aktiviert, AHCI aktiviert, EuP/ErP aktiviert

- A6-3670 Undervolting NorthBridge/GPU = CPU-NB Voltage -0,250V

- A6-3670 Undervolting Cores = CPU-Vcore Idle -0,250V / Load -0,200V

- A4-3400 Undervolting NorthBridge/GPU = CPU-NB Voltage -0,200V

- A4-3400 Undervolting Cores = CPU-Vcore Idle -0,200V / Load -0,275V

- A8-3820 Undervolting NorthBridge/GPU = CPU-NB Voltage -0,150V

- A6-3820 Undervolting Cores = CPU-Vcore Idle -0,1875V / Load -0,200V

- Zugewiesener RAM für die GPU: 512MB (AUTO-Einstellung)

- Wichtig: NorthBridge/GPU-Undervolting ist beim Llano nur mit Boards möglich, die diese Option im BIOS/UEFI bieten! Tools wie FusionTweaker sind bei diesem Teilbereich wirkungslos, auch wenn die P-States der CPU-NB augenscheinlich veränderbar sind, die Spannungen bleiben dennoch gleich.

1) Auswirkung von Undervolting an CPU-Kernen und CPU-NB/GPU (A6-3670 BE)

Als erstes habe ich relativ umfangreiche Messungen an einem System mit A6-3670 BE durchgeführt und die Entwicklung der Leistungsaufnahme bei Default-Betrieb, bei Undervolting des NB/GPU-Teils, bei Undervolting der CPU-Kerne und zu guter Letzt bei gleichzeitigem Undervolten von NB/GPU und CPU-Kerne dokumentiert. Der Grund warum ich NB und GPU immer in einem Atemzug nenne, ist ein ganz einfacher. Beides wird über die selbe Phase

Gut zu sehen ist, dass im Leerlauf und bei geringen Lasten das Undervolten der NB/GPU deutlich mehr bringt als das Undervolten der CPU-Kerne. Aufgrund von Stromspartechniken wie Cool and Quiet/Clockgating und Powergating (C6 State) ist bei den Kernen im Idle praktisch nichts mehr zu holen. Laut AMDs Folien kann auch der GPU-Part „power gegatet“ werden, das bedeutet die sichtbare Ersparnis im Idle kommt vermutlich hauptsächlich von der Northbridge bzw. dem IMC (= Integrierten Memory-Controller). Unter Teillasten wie Videowiedergabe arbeitet hauptsächlich die GPU (die CPU-Kerne befinden sich dabei immer im höchsten P-State, was beim Llano 800MHz Taktrate bedeutet), dadurch wird der Nutzen von NB/GPU-Undervolting nochmals etwas verstärkt.

Vorwort zu den Lastmessungen:

Vielleicht wird sich der eine oder andere fragen, warum der MSI „Kombustor“ und kein „Furmark“ als GPU-Last Tool zum Einsatz kommt. Ich habe mich für den Kombustor entschieden, weil er einige Vorteile aufgrund seiner Möglichkeiten hat und dadurch aussagekräftiger als anderen GPU-Tools ist.

Furmark z.B. beschränkt sich auf nur eine API (OpenGL), die zudem im kommerziellen Spielmarkt kaum Verwendung findet, im Gegensatz zur weit verbreiteten Direct3D aka DirectX API. Das macht dieses Tool noch weniger repräsentativ als es ohnehin schon ist. Weiterhin belastet Furmark beim GPU Burn-in nicht nur den GPU-Teil sondern lastet einen von mehreren CPU-Kernen vollständig aus, bei einem Quad-Core ergeben sich dadurch ~25% CPU-Last, bei einem Dual-Core bereits ca. 50%.

Der Kombustor hingegen stellt alle aktuellen APIs zur Verfügung, d.h. man hat die Wahl zwischen DX 9 bis DX 11 und OpenGL 2 + 3. Des weiteren werden beim Burn-in mit DirectX die CPU-Kerne nicht belastet, die CPU-Auslastung liegt daher nur bei ca. 2-4% und somit verweilt der CPU-Teil im Idle-State (allerdings dürfte der C6 Schlafzustand der CPU-Kerne hier nicht mehr greifen). Somit wird hier wirklich fast nur die GPU belastet, NB(IMC) und RAM-Module natürlich zwangsläufig mit eingeschlossen.

Um die Unterschiede zwischen DirectX Burn-in und OpenGL Burn-in aufzuzeigen, habe ich beide APIs mit dem Kombustor vermessen und ins Diagramm aufgenommen.„Kombustor (OpenGL)“ entspricht dabei exakt Furmark, ein CPU-Kern wird also zusätzlich ausgelastet und der Verbrauch ist bis auf minimale Nuancen (+- 0,5W) mit den Furmark-Werten identisch, welche für mache ein Anhaltspunkt sein dürfte.

Ein weiterer Grund die wenig praxisrelevante OpenGL API als alleinigen Indikator für die Bewertung der GPU-Leistungsaufnahme zu berücksichtigen, ist das merkwürdige Verhalten einiger Grafikchips. Sandy Bridge iGPUs z.B. werden unter OpenGL (egal ob mit Furmark oder Kombustor) scheinbar daran gehindert, die Turbo-Taktraten (richtig) auszufahren bzw. die iGPU kann nicht voll ausgelastet werden. Erst unter der Direct3D API zeigt die Intel HD-GPU was sie wirklich aufnehmen kann, wie ich anhand dieser Werte feststellen konnte:

Last-Werte des Pentium G840 sahen unter Win 7 in etwa so aus (nur auf die Schnelle gemessen):

Idle ~24,5/25,5W

CPU-Load (Prime95) ~ 55W

1. GPU-Load (Furmark) ~ 38-39W

2. GPU-Load (*MSI Kombustor DX9/DX10) ~ 45-46W

1. Full Load (Prime95 + Furmark) ~67-68W

2. Full Load (Prime95 + *MSI Kombustor DX9/DX10) ~72-73W

Die Differenzen zwischen DirectX und OpenGL sind hier nicht zu übersehen, ironischerweise ist es bei den AMD Prozessoren genau umgekehrt. Dort ist DirectX (deutlich) sparsamer, was jedoch damit zusammenhängt, dass kein CPU-Kern ausgelastet wird. Das ist dann zumindest noch nachvollziehbar. Aufgrund dieser unterschiedlichen Reaktionen (je nach GPU), war für mich die Berücksichtigung beider APIs im Burn-In-Test die logische Konsequenz. Auch im Hinblick auf Vergleiche mit anderen Architekturen wie z.B. Trinity.

Wie nicht anders zu erwarten, bringt das Undervolting der CPU-Kerne unter Prime95 eine erhebliche Verbrauchsersparnis. Dass sie hier mit 27,5W dennoch relativ moderat ausfällt, liegt zum einen daran, dass die später erschienenen Black Edition-Modelle und 65W TDP-Modelle mit der Endung Ax-3x20 (also z.B. A8-3820, A6-3620) ein Stück weit effizienter gegenüber den ersten Modellen wie z.B. A6-3650, A8-3850 usw. geworden sind, wie hier gut zu sehen ist (selbst im Leerlauf gut erkennbar): Stromverbrauch von Llano-Motherboards - Silenthardware & Dirkvader Forum

Zum anderen liegt es aber auch an den sehr guten Spannungswandlern (insbesondere den DriverMosfets) meiner FM1-Platine. Die Größe und Ausstattung des Boards spielt übrigens nur eine untergeordnete Rolle, dieses Modell steht µATX-Boards sowieso kaum in etwas nach. Es gibt auch genug Beispiele, in denen spärliche ITX-Platinen (deutlich) stromhungriger sind als ausgewachsene, phasenreiche ATX-Boards mit identischen Chipsätzen.

Das NB/GPU-Undervolting macht sich hingegen nur leicht bemerkbar wenn alle CPU-Kerne ausgelastet werden. Deutlich anders sieht es aus wenn der GPU-Part stark ausgelastet wird, wie z.B. durch den Kombustor. Hier zeigt sich eine überraschend hohe Ersparnis, die den Verbrauch der GPU scheinbar mehr als halbiert, wenn man die Differenzen zwischen Prime95 und Prime95 + Kombustor beachtet.

Zuletzt habe ich noch die Praxis aufs Exempel gemacht und ein Spiel mit in die Messungen einbezogen. Obwohl das nach GPU-Leistung gierende Crysis (1280x720 / Medium Details) in der Regel nur zwei Kerne auslastet, ist die Ersparnis durch Undervolting in jedem Fall sehr deutlich. Wenn man bedenkt, dass durch Undervolting im gestellten Idealfall (Prime95 + Kombustor D3D) 36,5W Ersparnis herausspringen, so ist die Verbrauchsreduzierung von rund 31,5W im Praxisfall Crysis ziemlich beeindruckend.

Es gibt dabei auch keine Leistungseinbußen, denn dieses Llano-Modell verzichte komplett auf einen manchmal doch unberechenbaren Turbo. Das Spiel ist übrigens gut mit der HD 6530D spielbar. Eine Erhöhung des RAM-Taktes auf 1866MHz bringt nochmals eine kleine Erhöhung der Frame-Raten, der Verbrauch nimmt dabei mit modernen Riegel (30nm Chips) kaum erwähnenswert zu, egal ob es sich dabei um Riegel mit neuen Samsung-, Hynix- oder Micron-Chips handelt (die ich alle bereits da hatte).

2) Vergleich zwischen A4-3400 und A6-3670 BE bei Default und max. Undervolting

Als nächstes habe ich das gleiche Grundsystem mit einem A4-3400 Dual-Core vermessen und dem Ganzen die A6-3670 BE Werte gegenübergestellt. Damit das Diagramm nicht zu überladen wird, habe ich mich auf Messung bei Default und bei Undervolting von NB/GPU + CPU-Kerne gleichzeitig beschränkt, das sind mMn ohnehin die interessantesten Ergebnisse.

Überraschen mag auf dem ersten Blick, dass der Quad-Core Llano im Idle einen Tick sparsamer ist und selbst bei der Videowiedergabe trotz deutlich größerem GPU-Part nahezu gleich viel verbraucht wie ein Dual-Core Llano. An dieser Stelle möchte ich nochmal an den Effizienzunterschied zwischen älteren Release-Modellen und jüngeren Nachfolge-Modellen erinnern. Ein älterer A6-3650 z.B. hätte lediglich undervoltet mit einem A4-3400 mithalten können, bei Default-Betrieb wäre definitiv ein Vorsprung des Dual-Cores erkennbar gewesen, auch wenn sich dieser in Grenzen gehalten hätte.

Bei der Videowiedergabe lies sich bereits erahnen, dass die HD 6410D des A4-3400 trotz deutlich weniger Shadereinheiten (160 an der Zahl) nicht unbedingt sparsamer arbeitet als die HD 6530D des A6-3670 BE mit 320 Shadereinheiten. Das liegt vermutlich zum Teil an der Güte der Chips, denn man muss davon ausgehen, dass die Dual-Core Llanos nur teil-deaktivierte Quad-Core Llanos sind. Größtenteils wird es aber auch daran liegt, dass der GPU-Part von letzterer APU nur mit niedrigen 444MHz statt 600MHz taktet. Die interne GPU-Spannung des A6-3670 BE kann somit niedriger angesetzt werden und der geringe Takt der Shader tut sein Übriges dazu, so dass unterm Strich die HD 6530D eine deutlich bessere Effizienz besitzt.

CPU-Kern seitig gibt es eigentlich keine Auffälligkeiten, Undervolting-Potential und Verlustleistung bewegen sich im zu erwartenden Rahmen. Nachvollziehbar ist z.B., dass eine CPU mit doppelt so vielen Kernen ein sichtlich höheres Einspar-Potential durch Undervolten bietet als eine CPU mit halber Kernanzahl, insbesondere wenn Standard-Takt und -Spannung identisch sind. Natürlich liegt der deutlich schwächere Dual-Core in den CPU-Last-Szenarien trotzdem komfortabel in Führung. Ein bisschen enttäuschend wirkt der A4-3400 dann aber im Praxistest in Form von Crysis, er liefert deutlich weniger Frames als der A6-3670 BE und ist im Spiel, zumindest undervoltet, nur noch unwesentliche sparsamer (durchschnittlich ca. 6W).

Schlussbemerkungen:

Mir ist bewusst, dass der Llano schon bald am Ende seines Lebenszyklus angekommen ist und dieser Test daher etwas spät zu kommen scheint. Meine Überlegung war jedoch, dass das Interesse an den Sockel FM1 APUs immer relativ klein im Forum war. Den Hauptnutzen dieser doch etwas aufwendigen Messungen sehe ich vor allem darin, eine Vorlage zu haben mit der man den kommenden Trinity (2te Bulldozer Generation) bezüglich Effizienz und Undervolting-Potential vergleichen kann. Sicher wurde der Llano hier unter sehr guten Bedingungen vermessen, in erster Linie aufgrund der Wahl des Mainboards und dessen verbauten Spannungsversorgung. Aber ich will es dem Trinity auch nicht einfach machen, wenn er sich gegenüber dem Vorgänger beweisen soll. Die Hoffnung, dass es auch für Sockel FM2 einige Platinen mit guter Spannungsversorgung und Tweak-Möglichkeiten geben wird, besteht zumindest schon mal.

PS: Es sind auch noch zwei A8-3820 (65W TDP) CPUs vorhanden, die ich ebenfalls gründlich vermessen möchte. Allerdings wird das alles noch einige Zeit brauchen, aber ich kann schon kleine Details verraten. Das eine Exemplar hat eine VID von 1,3875V, das andere eine VID von 1,3250V, unter Prime95 liegen die CPUs grob 5W auseinander. Man kann übrigens den Turbo-Takt über den Multi festsetzen (entweder per BIOS oder per K10Stats), so dass alle vier CPU-Kerne bei Volllast mit 2,8GHz statt den üblichen 2,5GHz laufen.

Update Update Update Update Update Update Update Update Update Update Update Update Update Update Update Update

3) Auswirkung von Undervolting an CPU-Kernen und CPU-NB/GPU (A8-3820)

Wie vor langer Zeit angekündigt habe ich auch das Top-Modell unter den 65W TDP Llanos, den A8-3820 mit relativ flotter HD 6530D IGP, im selben System vermessen. Es handelt sich um das Exemplar mit der 1,3250V VID (1,3875V Turbo-VID), es benötigt unter Prime 95 einige Watt weniger als das zweite A8-3820 Exemplar mit 1,3875V VID (1,4125V Turbo-VID). Beide APUs zu vermessen war mir etwas zu zeitintensiv/aufwändig, die Unterschiede sind ohnehin nicht sehr groß und mit der Wahl des sparsameren der beiden A8-3820 ist auch die Herausforderung für das Piledriver-Pendant knackiger.

Immerhin habe ich die APU im gleichen Umfang wie den A6-3670 BE „untersucht“, so dass man auch hier in verschiedenen Lagen erkennen kann, was NB/GPU-Undervolting und/oder CPU-Kern-Undervolting effektiv bringt.

Wie schon bei den anderen beiden Llano-Modellen fällt auch hier die Ersparnis im Idle und bei Medienwiedergabe durch NB/GPU-Undervolting größer aus als durch CPU-Kern-Undervolting. Im Default-Betrieb ohne bzw. mit nur geringer Belastung liegen A8-3820 und A6-3670 BE praktisch auf einem Niveau, beim Undervolting zeigt sich allerdings eine kleine Differenz von rund 1-2 Watt zwischen den beiden Modellen. Das liegt in erster Linie daran, dass man den A8-3820 weniger stark (im Leerlauf) undervolten kann, vor allem was den NB/GPU-Part (-0,150V vs. -0,250V) betrifft, was jedoch nicht überrascht, da die GPU des 65W TDP Modells mit 600 MHz deutlich höher taktet als die GPU des Black Edition Modells (444 MHz).

Bei den Lastmessungen gibt es ebenfalls keine großen Überraschungen, man sieht hier allerdings das AMD auch den 65W TDP Quad-Core Llanos eine sehr „großzügige“ VID spendiert. Das führt dazu, dass selbst beim A8-3820 per CPU-Kern-Undervolting noch ganze 20W Ersparnis unter starker CPU-Last herauszukitzeln sind. Was aber angesichts der möglichen Vcore-Absenkung von bis zu 0,200V nicht verwundert.

Interessant ist vielleicht noch die Feststellung, dass der Verbrauch unter Prime95 + Kombustor OpenGL (was Furmark entspricht) beinahe identisch zum Verbrauch unter Prime95 + Kombustor Direct3D ist. Das sah beim A6-3670 BE noch etwas anders aus, dort verursachte ersteres Lastszenario bis zu 5W Mehrverbrauch.

Zur Erinnerung nochmal: Die große Differenz zwischen der Kombustor OpenGL- und Kombustor Direct3D-Messung ergibt sich dadurch, das bei ersterem Belastungstest genau wie bei Furmark ein CPU-Kern voll ausgelastet wird. Im Direct3D-Szenario wird hingegen nur die GPU belastet, wie man es bei einem GPU-Test richtigerweise erwarten würde.

Vor allem unter Spielelast hinterlässt der A8-3820 einen positiven Eindruck. Er bietet die höchsten Frameraten unter den vermessenen APUs, schlägt verbrauchstechnisch aber dennoch fast immer den undervolteten A6-3670 BE in Crysis. Einzig beim Ausschöpfen des vollen Undervoltingpotentials, liegt Letzterer mit durchschnittlich 1,5W Abstand leicht vorne beim Verbrauch. Diesen Vorsprung „erkauft“ sich der undervoltete A6-3670 BE allerdings mit merklich weniger Spieleleistung, was ihn nicht unbedingt als Gewinner aus dem Vergleich gehen lässt.

Damit sind meine Verbrauchsmessungen zum Thema „Llano-Leistungsaufnahme bei Undervolting“ vorerst abgeschlossen. Als nächstes werde ich mich auf Piledriver (FM2) konzentrieren um zumindest ein Modell dieser Generation den Llano-APUs gegenüberzustellen. Ob ich mir hierfür einen Trinity (A8-5600K bzw. A10-5700) oder doch erst Richland (A8-6600K bzw. A10-6700) anschaffe, hängt davon ab ob noch (rechtzeitig) attraktive ITX-Platinen in Bezug auf Bios/UEFI-Tweakfunktionen & Bauteile erscheinen und wie es mit der preislichen Attraktivität der betreffenden APUs in den nächsten Wochen aussieht. Möglicherweise lasse ich mich durch die Spielbeilage und dem kommenden Preisnachlass noch zum Kauf eines A8-5600K oder ähnlichem verleiten.

Zuletzt bearbeitet:

fehlt nur noch der vergleich zu Trinity...wenn er dann da ist.

fehlt nur noch der vergleich zu Trinity...wenn er dann da ist.