Neurosphere

Enthusiast

Thread Starter

- Mitglied seit

- 06.11.2008

- Beiträge

- 4.324

nVidia GF10x/Geforce 4xx [Speku-, News- & Diskussionsthread] Part 4 (1. Seite lesen!)

Dies ist der Neustart des nVidia GT300 (40nm) DirectX 11 [Speku-, News- & Diskussionsthread] Part 4

480 GTX/470 GTX/465 GTX/460 GTX

Die drei Karten wurden offiziel Vorgestellt! Diskussionen über die Produkte bitte hier weiterführen:

Geforce 480 GTX Sammelthread (by PCZeus), 470 GTX Sammelthread (by Edgecrusher86) & 460 GTX Sammelthread (by Edgecrusher86),

Posts in diesem Thread die sich auf diese beiden Karten beziehen gelten als OT und werde konsequent gelöscht.

Newssammlung zur 460 by Endgecrusher86, vielen dank dafür:

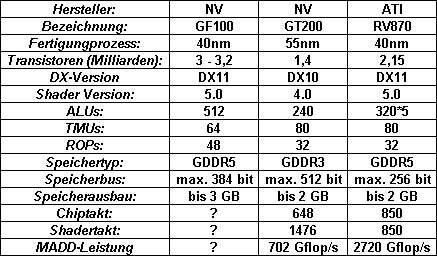

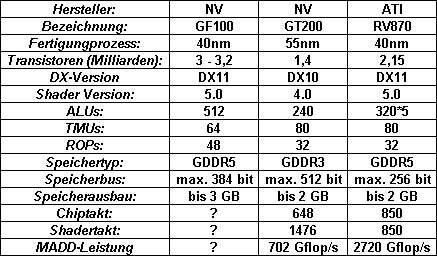

Die GPCs:

Der GF100 besteht aus Graphics Processing Clusters (kurz GPCs). Jeder GPC besteht aus 4 Streaming-Multiprocessors (SM),

in denen jeweils 4 Texture Mapping Units (TMUs) und 32 Arithmetic Logic Units (ALUs) untergebracht sind.

Nach derzeitigen Informationen kann der GF100 maximal 4 GPCs verwalten, womit er auf die besagten 512 "Cuda-Cores" (ALUs) und 64 TMUs kommt.

Besonders beim GF100 ist, das jeder GPC auf eine eigene Raster-Engine zurückgreifen kann. Alle bisherigen Designs und Architekturen hatten nur eine Raster-Engine die vor den Shaderclustern lag. Dadurch erhöht sich die Pixelleistung auf 32 Pixel pro Takt (4 GPCs x 8 Pixel) wodurch ein Flaschenhals aller bisherigen Architekturen beseitigt wurde und die Geometrieleistung überdurchschnittlich steigt. Deutlich zu sehen bekommt man dies an der Tesselationsleistung des GF100, nach NV-eigenen Folien ist diese zwischen 2 bis mehr als 6 mal so hoch wie die der 5870 von ATI.

Nun weiter zu den SM:

Zu jeder ALU gesellt sich eine Floating Point Unit (FPU). Der GF100 ist IEEE 754-2008-Standard kompatibel was ihn für GPGPU Aufgaben interessant macht.

Anders als der GT200 führt der GF100 pro Takt keine MADD+MUL Berechnung mehr aus sondern eine FMA. Das schmälert zwar auf den ersten Blick etwas die Rechenleistung pro ALU, allerdings erreicht FMA eine höhere Genauigkeit bei den Nachkommastellen, was ebenfalls wieder wichtig für GPGPU ist.

Die TMUs:

Auf den ersten Blick hat NV hier weniger verbaut als beim GT200. Allerdings soll die Taktrate nicht über den Chiptakt laufen sondern evtl in Richtung des Shadertaktes gehen, des weiteren soll die Effizienz aufgrund des größeren L1 (12 Kb Texture Cache + 64 Kb L1/Shared-Cache) und L2 Caches (768 Kb) weiter gesteigert worden sein. NV gibt für die TMUs bis zu 1,6 mal soviel Leistung wie beim GT200 an.

Die ROPs:

Die Raster Operation Processors (ROPs) wurden beim GF100 dahingehend überarbeitet, das es nun sechs ROP-Partitions gibt in denen jeweils 8 ROPs enthalten sind. Eine ROP kann nach einem Takt ein 32-Bit-Integer-Pixel, ein 16-Bit-Floating-Point-Pixel nach zwei Takten oder ein 32-Bit-FP-Pixel nach vier Takten ausgeben.

An Jeder ROP-Partition ist ein 64 Bit Speicherinterface angeschlossen womit der GF100 auf ein insgesammt 384bit breites Interface kommt.

Speicher und Interface:

NV gönnt dem GF100 ein 384 bit breites Speicherinterface (siehe oben) mit dem er maximal 6 GB Videospeicher ansprechen könnte. Die Speicherbandbreite wird dadurch gewährleistet das schneller GDDR5 verwendung findet. Die Taktrate des Speichers ist noch nicht bekannt, allerdings dürfte die Bandbreite bei über 200 GB/s liegen.

3D Vision Surround:

Der GF100 wird NVs neusten streich, 3D Vision Surround unterstützen. Damit ermöglicht der GF100 Stereoscopic 3D auf bis zu 3 Monitoren, allerdings nur wenn man zwei Karten sein eigen nennen kann.

32x CSAA:

Fermi bietet mit 32x CSAA einen neuen Antialiasing-Modus der auf 8x MSAA beruht. Jener soll laut NV eine bessere Bildqualität bieten als bisherige Modi. Ob NV in Zukunft SSAA anbieten wird ist unbekannt.

Blu-ray 3D:

Laut NV wird der GF100 die Dekodierung eines Blu-ray-3D-Films zu 100% übernehmen können.

Optimus:

Optimus ist der Nachfolger von Hybrid-Power und wird mit allen Intel Notebook-Chipsätzen lauffähig sein. Dadurch ist es möglich die dedizierte Grafikkarte abzuschalten sobald diese nicht gebraucht wird und auf die Chipsatzgrafik zurückzugreifen. Dadurch erreicht man einen geringeren Stromverbrauch und längere Akkulaufzeiten.

Nochmal Hinweise zu den Regeln gerade in diesem Thread:

Da es hier immer wieder zu Entgleisungen in jeder nur denkbaren Form gekommen ist, werden ab sofort die Regeln für diesen Thread verschärft. Jeder User ist natürlich in diesem Thread willkommen, wenn er aber an den Diskussionen teilnehmen möchte ist eine gewisse Netiquette Pflicht! Es geht hier nicht um die Produkte von ATI oder von NV aus vergangenen Zeiten. Natürlich können sie gerne herangezogen werden für Vergleiche, fehlt aber der Kontext zum eigentlichen Thema, werden die Posts gelöscht! Jeder hat selbst zu entscheiden ob ein Produkt empfehlenswert ist oder nicht, Kaufberatungen gehören also ebenfalls nicht in diesen Thread. Überlegt ob ihr jeden Post kommentieren müsst und steht darüber wenn ihr euch über Aussagen zu eurer Lieblingsmarke provoziert fühlt. Bleibt Sachlich, OT lesen ist für viele die sich für das Thema interessieren oft nicht so Lustig wie der Schreiberling es fand.

Weiterhin ist eure Mithilfe, diesen Thread "sauber" und informativ zu halten ausdrücklich erwünscht!

Wenn ihr auf Postings stoßt die absolut OT sind, provozieren oder was auch immer, geht bitte nicht darauf ein, sondern benutzt den "Beitrag melden-Button" (

) und überlasst alles weitere der Moderation.

) und überlasst alles weitere der Moderation.

Auch das sorgt dafür, hier eine für Jedermann angenehme Diskussion vorzufinden.

Sollte es zu mehrmaligem Verstoß gegen die Regeln kommen erhalten auffällige User eine Auszeit von diesem Thread.

nVidia GF10x/Geforce 4xx [Speku-, News- & Diskussionsthread]

Dies ist der Neustart des nVidia GT300 (40nm) DirectX 11 [Speku-, News- & Diskussionsthread] Part 4

Erhältliche Karten

480 GTX/470 GTX/465 GTX/460 GTX

Die drei Karten wurden offiziel Vorgestellt! Diskussionen über die Produkte bitte hier weiterführen:

Geforce 480 GTX Sammelthread (by PCZeus), 470 GTX Sammelthread (by Edgecrusher86) & 460 GTX Sammelthread (by Edgecrusher86),

Posts in diesem Thread die sich auf diese beiden Karten beziehen gelten als OT und werde konsequent gelöscht.

Die kleineren Ableger des GF100

Alle Angaben unter vorbehalt, Erscheinungstermine noch nicht bekannt.

Alle Angaben unter vorbehalt, Erscheinungstermine noch nicht bekannt.

Newssammlung zur 460 by Endgecrusher86, vielen dank dafür:

Ich fasse mal kurz die neusten News um die GTX 460 zusammen:

Bilder:

Technische Daten - GeForce GTX 460:

Coreclock: 675 MHz ( GTX 465 -> 607 MHz ! )

Shaderclock: 1350 MHz ( GTX 465 -> 1215 MHz ! )

GDDR5-Clock: 1800 MHz ( GTX 465 -> 1607 MHz ! )

CUDA Cores: 336 ( GTX 465 -> 352 )

TMUs: 56 ( GTX 465 -> 44 ! )

ROPs: 32 (1GB Variante) bzw. 24 (768 MB Variante) ( GTX 465 -> 32)

GTexel/s: 37.8 ( GTX 465 -> 26.7 ! )

Speicherbandbreite -> 256 Bit SI + 1GB GDDR5 (UVP -> 250$): 115.2 GB/s ( GTX 465 -> 102.848 GB/s ! )

Speicherbandbreite -> 192 Bit SI + 768MB GDDR5 (UVP -> 230$): 86.4 GB/s

Stromversorgung: 2 x 6 Pin PCI-E Konnektoren (längs)

PCB Länge: (von mir) geschätzte 21cm (Sollte wohl zwischen 8" (20.32 cm), 8.5" (21.59 cm) und 9" (22.86 cm) liegen)

SLI Konnektoren: 1

Anschlüsse: 2 x DVI, 1 x miniHDMI

Lüfter: 1 x 80mm (geschätzt), axial

Launch der beiden Karten -> Mitte Juli

Noch etwas zur Performance:

Zitat von Heise online:

Sowohl auf der GeForce GTX 460 mit 1 GByte als auch auf der Variante mit 768 MByte laufen die 56 Textureinheiten sowie die Rasterendstufen mit 675 MHz und die Shader-Rechenkerne mit 1350 MHz. Der Speicher arbeitet mit 1800 MHz Taktfrequenz (Read/Write-Clock). Der GF104-Chip beim 1-GByte-Modell kommuniziert über 256 Datenleitungen mit dem Speicher und erreicht so eine theoretische Datentransferrate von 115,2 GByte/s.

Bei der 768-MByte-Variante sind es durch das 192-Bit-Speicherinterface maximal 86,4 GByte/s. Ihre 3D-Leistung soll in etwa auf dem Niveau einer GeForce GTX 465 liegen, im 3D Mark Vantage sind in der Extreme-Voreinstellung ungefähr 6000 Punkte drin. Wie Übertaktungsexperimente in Ostasien bereits zeigten, lief der Grafikchip einer GTX-460-Testkarte (768 MByte, 192 Bit) ohne Erhöhung der Kernspannung mit 830 MHz noch stabil, bei einer leichten Spannungsanhebung waren sogar 900 MHz möglich. Damit erreichte die Karte rund 8000 Punkte (3DMark Vantage Extreme) und überflügelte sogar eine über 300 Euro teure GeForce GTX 470. Letztere schafft rund 7650 Punkte.

Bei purzelnden Preisen sicher eine verdammt interessante Karte -> die GTX 465 verliert damit ihre Daseinsberechtigung, zumindest wenn sich die Karte nicht freischalten lassen sollte

(also auf 448 SPs und 1GB oder im Optimalfall wie bei PoV als komplette 470er (ich hab am Montag zugegriffen)).

mfg

Edge

Allgemeines zum Chip: Der GF100 (aka Fermi)

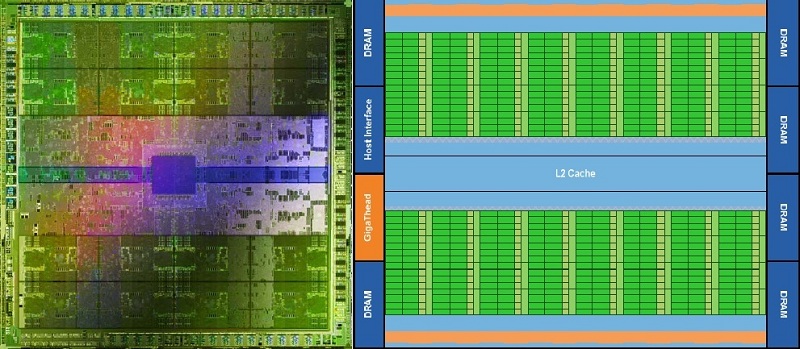

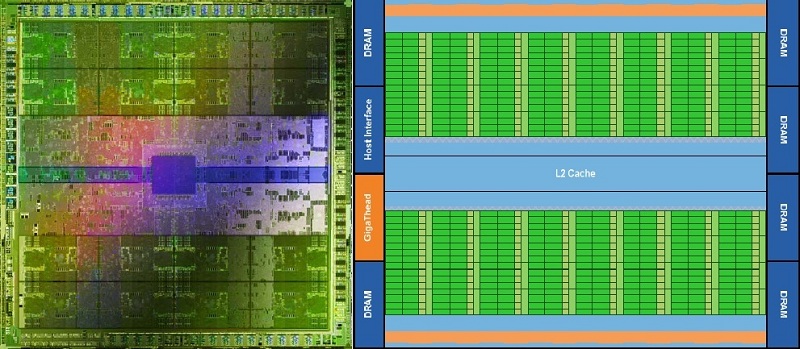

Innerer Aufbau:

Die GPCs:

Der GF100 besteht aus Graphics Processing Clusters (kurz GPCs). Jeder GPC besteht aus 4 Streaming-Multiprocessors (SM),

in denen jeweils 4 Texture Mapping Units (TMUs) und 32 Arithmetic Logic Units (ALUs) untergebracht sind.

Nach derzeitigen Informationen kann der GF100 maximal 4 GPCs verwalten, womit er auf die besagten 512 "Cuda-Cores" (ALUs) und 64 TMUs kommt.

Besonders beim GF100 ist, das jeder GPC auf eine eigene Raster-Engine zurückgreifen kann. Alle bisherigen Designs und Architekturen hatten nur eine Raster-Engine die vor den Shaderclustern lag. Dadurch erhöht sich die Pixelleistung auf 32 Pixel pro Takt (4 GPCs x 8 Pixel) wodurch ein Flaschenhals aller bisherigen Architekturen beseitigt wurde und die Geometrieleistung überdurchschnittlich steigt. Deutlich zu sehen bekommt man dies an der Tesselationsleistung des GF100, nach NV-eigenen Folien ist diese zwischen 2 bis mehr als 6 mal so hoch wie die der 5870 von ATI.

Nun weiter zu den SM:

Zu jeder ALU gesellt sich eine Floating Point Unit (FPU). Der GF100 ist IEEE 754-2008-Standard kompatibel was ihn für GPGPU Aufgaben interessant macht.

Anders als der GT200 führt der GF100 pro Takt keine MADD+MUL Berechnung mehr aus sondern eine FMA. Das schmälert zwar auf den ersten Blick etwas die Rechenleistung pro ALU, allerdings erreicht FMA eine höhere Genauigkeit bei den Nachkommastellen, was ebenfalls wieder wichtig für GPGPU ist.

Die TMUs:

Auf den ersten Blick hat NV hier weniger verbaut als beim GT200. Allerdings soll die Taktrate nicht über den Chiptakt laufen sondern evtl in Richtung des Shadertaktes gehen, des weiteren soll die Effizienz aufgrund des größeren L1 (12 Kb Texture Cache + 64 Kb L1/Shared-Cache) und L2 Caches (768 Kb) weiter gesteigert worden sein. NV gibt für die TMUs bis zu 1,6 mal soviel Leistung wie beim GT200 an.

Die ROPs:

Die Raster Operation Processors (ROPs) wurden beim GF100 dahingehend überarbeitet, das es nun sechs ROP-Partitions gibt in denen jeweils 8 ROPs enthalten sind. Eine ROP kann nach einem Takt ein 32-Bit-Integer-Pixel, ein 16-Bit-Floating-Point-Pixel nach zwei Takten oder ein 32-Bit-FP-Pixel nach vier Takten ausgeben.

An Jeder ROP-Partition ist ein 64 Bit Speicherinterface angeschlossen womit der GF100 auf ein insgesammt 384bit breites Interface kommt.

Speicher und Interface:

NV gönnt dem GF100 ein 384 bit breites Speicherinterface (siehe oben) mit dem er maximal 6 GB Videospeicher ansprechen könnte. Die Speicherbandbreite wird dadurch gewährleistet das schneller GDDR5 verwendung findet. Die Taktrate des Speichers ist noch nicht bekannt, allerdings dürfte die Bandbreite bei über 200 GB/s liegen.

Features:

3D Vision Surround:

Der GF100 wird NVs neusten streich, 3D Vision Surround unterstützen. Damit ermöglicht der GF100 Stereoscopic 3D auf bis zu 3 Monitoren, allerdings nur wenn man zwei Karten sein eigen nennen kann.

32x CSAA:

Fermi bietet mit 32x CSAA einen neuen Antialiasing-Modus der auf 8x MSAA beruht. Jener soll laut NV eine bessere Bildqualität bieten als bisherige Modi. Ob NV in Zukunft SSAA anbieten wird ist unbekannt.

Blu-ray 3D:

Laut NV wird der GF100 die Dekodierung eines Blu-ray-3D-Films zu 100% übernehmen können.

Optimus:

Optimus ist der Nachfolger von Hybrid-Power und wird mit allen Intel Notebook-Chipsätzen lauffähig sein. Dadurch ist es möglich die dedizierte Grafikkarte abzuschalten sobald diese nicht gebraucht wird und auf die Chipsatzgrafik zurückzugreifen. Dadurch erreicht man einen geringeren Stromverbrauch und längere Akkulaufzeiten.

Linkliste:

Neu:

Artikel:

Artikel auf CB zum GF100

Artikel auf PCGH

Techreport über den GF100 (englisch)

News:

TSMC hat Fertigungsprobleme behoben

Lauffähiges Fermisystem gesichtet

Sammelnews auf PCGH

Fermi debüt auf der Cebit

Die meisten Fermi-Karten im Q2 2010

News zu NVs kleineren ablegern auf 3DCenter (ursprung xbit Labs)

Geklaute 480er von Heise (Cebit)

Supermicro "Supercomputer" mit 4x Fermi (Cebit)

CB zum Fermi (Cebit)

Benchmarks der 470 auf der Cebit von Heise(Cebit)

HT4U über die GF100 auf der Cebit (Cebit)

Benchmarksammlung (Achtung, Fakealarm)

NVIDIA GeForce GTX 480 Final Specs & Pricing Revealed

Zu den kleinen Ablegern:

PCGH-Sammelnews, GF104 Tapeout erfolgt?

Offizielles:

Deutsche Infoseite von NV zum GF100

NVs Facebook Seite

Zum Optimus Feature

Alte Links aus dem nVidia GT300 (40nm) DirectX 11 [Speku-, News- & Diskussionsthread]:

Artikel:

Artikel auf CB zum GF100

Artikel auf PCGH

Techreport über den GF100 (englisch)

News:

TSMC hat Fertigungsprobleme behoben

Lauffähiges Fermisystem gesichtet

Sammelnews auf PCGH

Fermi debüt auf der Cebit

Die meisten Fermi-Karten im Q2 2010

News zu NVs kleineren ablegern auf 3DCenter (ursprung xbit Labs)

Geklaute 480er von Heise (Cebit)

Supermicro "Supercomputer" mit 4x Fermi (Cebit)

CB zum Fermi (Cebit)

Benchmarks der 470 auf der Cebit von Heise(Cebit)

HT4U über die GF100 auf der Cebit (Cebit)

Benchmarksammlung (Achtung, Fakealarm)

NVIDIA GeForce GTX 480 Final Specs & Pricing Revealed

Zu den kleinen Ablegern:

PCGH-Sammelnews, GF104 Tapeout erfolgt?

Offizielles:

Deutsche Infoseite von NV zum GF100

NVs Facebook Seite

Zum Optimus Feature

Alte Links aus dem nVidia GT300 (40nm) DirectX 11 [Speku-, News- & Diskussionsthread]:

Nvidia GT300 mit DirectX 11 ab Q4/2009 - News - Hardware-Infos

Fudzilla - GT300 is Nvidia's DirectX 11 emid=65

TSMCs 40nm-GP: RV870 und GT300 fast viermal so schnell wie heute? - TSMC, 40nm, 40G, Performance, GPU, 32nm, RV870, GT300

Infos zur DX11-Karte von Nvidia - News Hartware.net

Erste Direct3D-11-Karte von Nvidia in Q4/09? - 06.04.2009 - ComputerBase

Fudzilla - Nvidia´s DirectX 11 to come in Q4 emid=65

Nvidia GT300-Tape-Out im Juni? - News - Hardware-Infos

Kommen RV870 und GT300 früher als gedacht? - News - Hardware-Infos

Nvidia: GT300 im Oktober? - News Hartware.net

nVidia's GT300 specifications revealed - it's a cGPU! - Bright Side Of News*

GT300 wirft 512 Shadereinheiten in die Waagschale - Forum de Luxx

GT300 kommt mit 512 SPs noch dieses Jahr - News - Hardware-Infos

Kommt Nvidias GT300 mit 512 Shadereinheiten? - 23.04.2009 - ComputerBase

GT300 setzt auf 512 Bit-GDDR5-Interface - News - Hardware-Infos

Nvidia GT300 mit 512 Bit und GDDR5? - 07.05.2009 - ComputerBase

GT300 mit rund 2,4 Millarden Transistoren - News - Hardware-Infos

Nvidia G300 hat Tape-Out gemeistert - News - Hardware-Infos

Nvidia G300-Samples mit 700/1600/1100 MHz - News - Hardware-Infos

Nvidia G300 mit unter 225 Watt TDP - News - Hardware-Infos

Nvidia: GT300 erscheint 2009 - News Hartware.net

GT300 und RV870: Wann kommen die Chips? - 25.06.2009 - ComputerBase

Nvidia G300 mit finalem Tape-Out - News - Hardware-Infos

Nvidia plant Karte mit zwei GT300 - News Hartware.net

Nvidia GF100: 512 SPs, aber nur 384 Bit - News - Hardware-Infos

Nvidia kündigt GF100 (Fermi) an - News - Hardware-Infos

Nvidia und der Griff nach den Sternen - News - Hardware-Infos

Nvidia GF100: 128 TMUs und 48 ROPs - News - Hardware-Infos

Neuigkeiten zu GT300 / Fermi? - News Hartware.net

Offiziell:

Fudzilla - GT300 is Nvidia's DirectX 11 emid=65

TSMCs 40nm-GP: RV870 und GT300 fast viermal so schnell wie heute? - TSMC, 40nm, 40G, Performance, GPU, 32nm, RV870, GT300

Infos zur DX11-Karte von Nvidia - News Hartware.net

Erste Direct3D-11-Karte von Nvidia in Q4/09? - 06.04.2009 - ComputerBase

Fudzilla - Nvidia´s DirectX 11 to come in Q4 emid=65

Nvidia GT300-Tape-Out im Juni? - News - Hardware-Infos

Kommen RV870 und GT300 früher als gedacht? - News - Hardware-Infos

Nvidia: GT300 im Oktober? - News Hartware.net

nVidia's GT300 specifications revealed - it's a cGPU! - Bright Side Of News*

GT300 wirft 512 Shadereinheiten in die Waagschale - Forum de Luxx

GT300 kommt mit 512 SPs noch dieses Jahr - News - Hardware-Infos

Kommt Nvidias GT300 mit 512 Shadereinheiten? - 23.04.2009 - ComputerBase

GT300 setzt auf 512 Bit-GDDR5-Interface - News - Hardware-Infos

Nvidia GT300 mit 512 Bit und GDDR5? - 07.05.2009 - ComputerBase

GT300 mit rund 2,4 Millarden Transistoren - News - Hardware-Infos

Nvidia G300 hat Tape-Out gemeistert - News - Hardware-Infos

Nvidia G300-Samples mit 700/1600/1100 MHz - News - Hardware-Infos

Nvidia G300 mit unter 225 Watt TDP - News - Hardware-Infos

Nvidia: GT300 erscheint 2009 - News Hartware.net

GT300 und RV870: Wann kommen die Chips? - 25.06.2009 - ComputerBase

Nvidia G300 mit finalem Tape-Out - News - Hardware-Infos

Nvidia plant Karte mit zwei GT300 - News Hartware.net

Nvidia GF100: 512 SPs, aber nur 384 Bit - News - Hardware-Infos

Nvidia kündigt GF100 (Fermi) an - News - Hardware-Infos

Nvidia und der Griff nach den Sternen - News - Hardware-Infos

Nvidia GF100: 128 TMUs und 48 ROPs - News - Hardware-Infos

Neuigkeiten zu GT300 / Fermi? - News Hartware.net

Offiziell:

Demovideos:

Nochmal Hinweise zu den Regeln gerade in diesem Thread:

Da es hier immer wieder zu Entgleisungen in jeder nur denkbaren Form gekommen ist, werden ab sofort die Regeln für diesen Thread verschärft. Jeder User ist natürlich in diesem Thread willkommen, wenn er aber an den Diskussionen teilnehmen möchte ist eine gewisse Netiquette Pflicht! Es geht hier nicht um die Produkte von ATI oder von NV aus vergangenen Zeiten. Natürlich können sie gerne herangezogen werden für Vergleiche, fehlt aber der Kontext zum eigentlichen Thema, werden die Posts gelöscht! Jeder hat selbst zu entscheiden ob ein Produkt empfehlenswert ist oder nicht, Kaufberatungen gehören also ebenfalls nicht in diesen Thread. Überlegt ob ihr jeden Post kommentieren müsst und steht darüber wenn ihr euch über Aussagen zu eurer Lieblingsmarke provoziert fühlt. Bleibt Sachlich, OT lesen ist für viele die sich für das Thema interessieren oft nicht so Lustig wie der Schreiberling es fand.

Weiterhin ist eure Mithilfe, diesen Thread "sauber" und informativ zu halten ausdrücklich erwünscht!

Wenn ihr auf Postings stoßt die absolut OT sind, provozieren oder was auch immer, geht bitte nicht darauf ein, sondern benutzt den "Beitrag melden-Button" (

Auch das sorgt dafür, hier eine für Jedermann angenehme Diskussion vorzufinden.

Sollte es zu mehrmaligem Verstoß gegen die Regeln kommen erhalten auffällige User eine Auszeit von diesem Thread.

Zuletzt bearbeitet:

freu mich jetzt schon drauf was da so geht.

freu mich jetzt schon drauf was da so geht.