Liesel Weppen, es geht im die Optane DIMM Riegel die wie DDR4 DRAM Riegel in die RAM Slots kommen und auch so wie RAM angesprochen. Die haben mit den bisherigen Optane SSDs auch nichts zu tun, bisher gibt es ja als Optane nur NVMe SSDs, von den kleinen Memory mit 16GB über die 905P mit bis zu 1,5TB bis zur DC P4800X. Dort setzten sie SSDs mit NAND Cache und wie gut sie da in bestimten Disziplinen sind, zeigt z.B. der

Review der Samsung 983 ZET (Z-NAND) SSD, auch wenn die meisten Vorteile der großen Optane SSDs eben für den Heimanwender nicht so relevant sind, dass er den hohen Preis rechtfertigen würde.

Die

Optane DC Persistent Memory DIMM (Apache Pass) gibt es noch nicht zu kaufen, nur die großen Partner haben sie schon von Intel bekommen und daher wäre ich bei den Preisen auch noch sehr vorsichtig, ebenso bzgl. der Frage ob diese schon bei der nächsten Consumerplattform unterstützt werden. Außerdem wird man abwarten müssen

wie die Leistungsaufnahme sein wird.

Amigac64, in welcher Hinsicht ist "Die Verbindung von Peripherie zur CPU mit den M-2 ssds überfordert"? Erstens ist M.2 nur ein Formfaktor für SSDs mit SATA oder PCIe Anbindung und zweitens sind die schnellsten M.2 PCIe SSDs auch noch nicht wirklich durch ihre PCIe 3.0 x4 Anbindung eingeschränkt. Denn die 3,5GB/s die damit netto möglich sind, erreichen sie auch erst seit recht kurzer Zeit. Du scheinst mir aber irgendwie ein Anhänger der Idee zu sein wie sie

HPE mit The Machine formuliert hat.

Der Gedanke RAM und Massenspeicher zu vereinen ist sicher verlockend, aber man sollte auch nicht vergessen warum dies getrennt ist, denn dies hat ja einen sehr guten Grund. RAM ist teuer, vor allem DRAM und selbst wenn es die Optane DIMM dann wirklich mit 512GB für 600€ geben wird (ich denke aber der wird teurer sein) auch das 3D XPoint. Daher kann man rein von der Wirtschaftlichkeit her gar nicht alle Daten im RAM oder Optane DIMM ablegen, sondern braucht einfach einen Massenspeicher der günstiger ist. Die Geschichte hat nur leider immer wieder gezeigt, dass die billigeren Speicher auch langsamer sind, sowohl was die seq. Transferraten aber vor allem auch was die Latenzen betrifft und daher gibt es eben die Speicherpyramide bei der heutzutage unten die HDDs und ganz oben der L1 Cahce der CPU stehen.

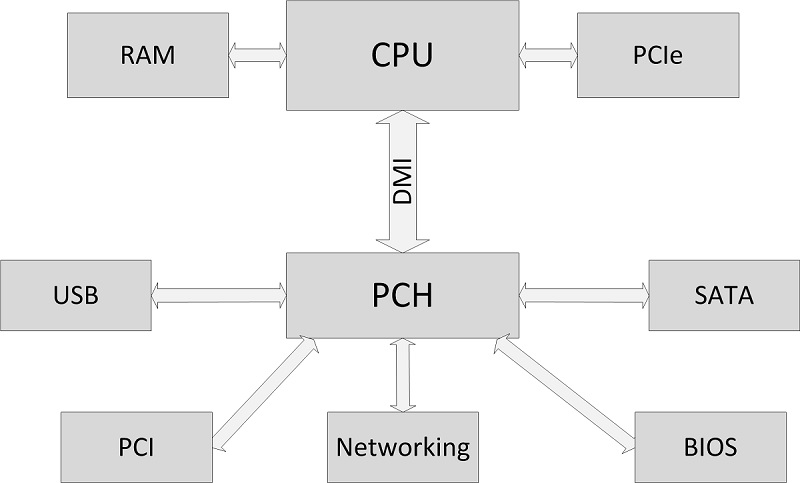

Selbst wenn Ice Lake Optane DIMM unterstützen wird, so wird sich an den Schnittstellen im Prinzip nichts ändern. Die PCIe Lanes dürften dann PCIe 4.0 sein, es wird aber weiterhin PCIe Lanes für M.2 Slots und vielleicht U.2 Ports geben, je nach Vorstellung des Mainboardherstellers und einen Chipsatz mit USB und SATA Host Ports und der wird dann wieder über DMI, hoffentlich dann DMI4, an die CPU angebunden sein.