danielmayer

Enthusiast

- Mitglied seit

- 30.03.2005

- Beiträge

- 1.010

So, ich habe Lust auf ein kleines Update.

Seit drei Jahren im Haus mit vollständiger Verkabelung (Cat7 + MM + SM), allerdings mit hektischem Einzug und zeitgleich neuem Job. So allmählich fasse ich mal die ein oder andere Sache an, "fertig" zu machen.

Alleine den Kabelsalat im HAR zu beheben hat mehrere Tage gekostet. Das ergänze ich gleich im 800G-Haus-Thread .

Der AIO-Server ist mittlerweile umgezogen in die Garage:

Oberhalb die Unterverteilung der Garage, in der auch 2xduplex MM, 2x duplex SM und 2xCAT7 zum HAR aufgelegt sind; außerdem 2xSM und 1xSM(SC, für SAT-1310 fiber) zur Gartenhütte.

Links neben dem Verteiler ist ein 8x optischer Verteiler für das SAT-Signal, mittlerweile "umgedreht", so dass IN und die beiden OUT unten angeschlossen sind. Darunter ein Invacom GTU Quatro als SAT-Endgerät zurück auf HH/HL/VH/VL. Die vier Kabel gehen dann in die Digital Devices Max S8 und über TVheadend ins LAN.

Der Schrank ist per 10G-Multimode an den HAR angeschlossen und per 10G-Singlemode an die Gartenhütte.

Hier werkeln jetzt von oben:

No-name-case mit Supermicro A2SDi-H-TF (Atom C3758), 64GB RAM, NVME-SSD für PFsense

Chenbro 21706, Asrockrack Epyc3101 ITX, 16GB RAM, 6x8TB WD Red an LSI 12G-SAS (Fujitsu branded)

Chenbro 21706, Gigabyte MC12-LE0 mit AMD 5650G Pro, 32GB ECC RAM - Testfarm und Backup2 mit 2x14TB WD Red (offline hot-swap).

XCase 3HE, s.u.

Ubiquiti Edge Switch 16 XG

HP 1800-24 1G uralt

Die zwei weißen Cat-Kabel nach links weg gehen zur Sungrow-PV-Station für Modbus und Ethernet. Die drei Glasfaser nach links gehen zum HAR/10G (blau), HAR/Glasfaserhausanschluss (weiß) und zur Gartenhütte/10G (gelb). Kabeltechnisch noch nicht schick, mir fehlen jetzt noch die richtigen Längen der Kabel.

Im Ubiquiti ist ein SFP-GPON-Modul von Zyxel, das von der Telekom offiziell vertrieben wird. Wird anstandslos erkannt, Port auf VLAN7 und WAN-Port vom Atom auf VLAN7. Also Hausanschluss durchgepatched in die Garage läuft problemlos.

Das TV-Zeugs sollte im dicken Server mit laufen (vierter Slot), die Karte macht aber seit Umbau I2C-errors und verliert damit den Sender nach wenigen Minuten endgültig (Neustart nötig). Derzeit in einem externen Gehäuse mit Celeron j4125, in dem sie drei Jahre problemlos lief - nun auch mit Fehlern... kümmere ich mich im Herbst drum...

Der 3HE-Server: Asrockrack ROMED6U-2L2T mit Epyc7302, 2x64GB RAM, 5x1TB SN570, 2x2TB SN770, 6x14 TB WD Red, Mellanox CX456-ECAT dual 100G. Leider sind zwei weitere 64GB-LRDIMM nicht nutzbar, da eins defekt.

Die 100G sind per simplex-Singlemode über den HAR direkt (ohne Switch) an meinen PC im Obergeschoss durchgepatched.

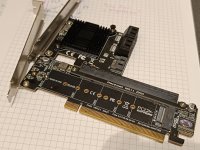

Alle nvme-SSDs sind auf zwei x16->x4x4x4x4-nvme Bifurcation-Karten eingesetzt. Der Onboard-NMVE-Slot ist daher frei und im Bild mit einem NVMe-x4->PCIe-Adapter verbunden.

Die TV-Karte lief aber weder im originären noch im improvisierten Slot fehlerfrei, im Übrigen aber auch identisch "schlecht" - der Adapter funktioniert ganz gut.

Ein 2HE-Seasonic-Netzteil von ebay, ein 2- oder 3-HE-Kühler von Supermicro. Die original-Gehäuselüfter sind furchtbare Turbinen. Das wirklich billig gefertigte Gehäuse hat neben den drei Lüftern nicht genug Platz für die ganzen Kabel, daher musste ein Lüfterslot frei werden und zwei normale wegen der Lautstärke eingesetzt werden. Man hatte den Server durch die geschlossene rückwärtige Tür gehört...

Wenn der dicke Server, der Atom/Firewall, alle vier IPMI und die beiden Switche laufen: 220 Watt etwa...

Vom TV abgesehen ist das technisch für die nächsten Jahre der Endzustand. Hoffentlich.

Software:

- Atom C3758: pfsense bare metal

- Epyc3101: Ubuntu Server

- Testfarm: Was halt so gerade ausprobiert werden muss

- Server: Ubuntu Server, freetz, VMs für Nextcloud, iobroker, Kubuntu Desktop, Win10; eine VM für "internal services" für Unifi-Controller, TVH (soll-zustand leider), Emby (readonly auf SMB); eine VM für Homeassistant; eine VM für gaming-server (to be done, u.a. Minecraft, NWN1 und NWN2); es gibt eine Business-VM und eine für den künftigen Rasperrymatic-Dienst.

So. Soll wohl reichen. Schönen Abend!

Seit drei Jahren im Haus mit vollständiger Verkabelung (Cat7 + MM + SM), allerdings mit hektischem Einzug und zeitgleich neuem Job. So allmählich fasse ich mal die ein oder andere Sache an, "fertig" zu machen.

Alleine den Kabelsalat im HAR zu beheben hat mehrere Tage gekostet. Das ergänze ich gleich im 800G-Haus-Thread .

Der AIO-Server ist mittlerweile umgezogen in die Garage:

Oberhalb die Unterverteilung der Garage, in der auch 2xduplex MM, 2x duplex SM und 2xCAT7 zum HAR aufgelegt sind; außerdem 2xSM und 1xSM(SC, für SAT-1310 fiber) zur Gartenhütte.

Links neben dem Verteiler ist ein 8x optischer Verteiler für das SAT-Signal, mittlerweile "umgedreht", so dass IN und die beiden OUT unten angeschlossen sind. Darunter ein Invacom GTU Quatro als SAT-Endgerät zurück auf HH/HL/VH/VL. Die vier Kabel gehen dann in die Digital Devices Max S8 und über TVheadend ins LAN.

Der Schrank ist per 10G-Multimode an den HAR angeschlossen und per 10G-Singlemode an die Gartenhütte.

Hier werkeln jetzt von oben:

No-name-case mit Supermicro A2SDi-H-TF (Atom C3758), 64GB RAM, NVME-SSD für PFsense

Chenbro 21706, Asrockrack Epyc3101 ITX, 16GB RAM, 6x8TB WD Red an LSI 12G-SAS (Fujitsu branded)

Chenbro 21706, Gigabyte MC12-LE0 mit AMD 5650G Pro, 32GB ECC RAM - Testfarm und Backup2 mit 2x14TB WD Red (offline hot-swap).

XCase 3HE, s.u.

Ubiquiti Edge Switch 16 XG

HP 1800-24 1G uralt

Die zwei weißen Cat-Kabel nach links weg gehen zur Sungrow-PV-Station für Modbus und Ethernet. Die drei Glasfaser nach links gehen zum HAR/10G (blau), HAR/Glasfaserhausanschluss (weiß) und zur Gartenhütte/10G (gelb). Kabeltechnisch noch nicht schick, mir fehlen jetzt noch die richtigen Längen der Kabel.

Im Ubiquiti ist ein SFP-GPON-Modul von Zyxel, das von der Telekom offiziell vertrieben wird. Wird anstandslos erkannt, Port auf VLAN7 und WAN-Port vom Atom auf VLAN7. Also Hausanschluss durchgepatched in die Garage läuft problemlos.

Das TV-Zeugs sollte im dicken Server mit laufen (vierter Slot), die Karte macht aber seit Umbau I2C-errors und verliert damit den Sender nach wenigen Minuten endgültig (Neustart nötig). Derzeit in einem externen Gehäuse mit Celeron j4125, in dem sie drei Jahre problemlos lief - nun auch mit Fehlern... kümmere ich mich im Herbst drum...

Der 3HE-Server: Asrockrack ROMED6U-2L2T mit Epyc7302, 2x64GB RAM, 5x1TB SN570, 2x2TB SN770, 6x14 TB WD Red, Mellanox CX456-ECAT dual 100G. Leider sind zwei weitere 64GB-LRDIMM nicht nutzbar, da eins defekt.

Die 100G sind per simplex-Singlemode über den HAR direkt (ohne Switch) an meinen PC im Obergeschoss durchgepatched.

Alle nvme-SSDs sind auf zwei x16->x4x4x4x4-nvme Bifurcation-Karten eingesetzt. Der Onboard-NMVE-Slot ist daher frei und im Bild mit einem NVMe-x4->PCIe-Adapter verbunden.

Die TV-Karte lief aber weder im originären noch im improvisierten Slot fehlerfrei, im Übrigen aber auch identisch "schlecht" - der Adapter funktioniert ganz gut.

Ein 2HE-Seasonic-Netzteil von ebay, ein 2- oder 3-HE-Kühler von Supermicro. Die original-Gehäuselüfter sind furchtbare Turbinen. Das wirklich billig gefertigte Gehäuse hat neben den drei Lüftern nicht genug Platz für die ganzen Kabel, daher musste ein Lüfterslot frei werden und zwei normale wegen der Lautstärke eingesetzt werden. Man hatte den Server durch die geschlossene rückwärtige Tür gehört...

Wenn der dicke Server, der Atom/Firewall, alle vier IPMI und die beiden Switche laufen: 220 Watt etwa...

Vom TV abgesehen ist das technisch für die nächsten Jahre der Endzustand. Hoffentlich.

Software:

- Atom C3758: pfsense bare metal

- Epyc3101: Ubuntu Server

- Testfarm: Was halt so gerade ausprobiert werden muss

- Server: Ubuntu Server, freetz, VMs für Nextcloud, iobroker, Kubuntu Desktop, Win10; eine VM für "internal services" für Unifi-Controller, TVH (soll-zustand leider), Emby (readonly auf SMB); eine VM für Homeassistant; eine VM für gaming-server (to be done, u.a. Minecraft, NWN1 und NWN2); es gibt eine Business-VM und eine für den künftigen Rasperrymatic-Dienst.

So. Soll wohl reichen. Schönen Abend!