Install the app

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: this_feature_currently_requires_accessing_site_using_safari

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

[Sammelthread] Proxmox Stammtisch

- Ersteller GrafikTreiber

- Erstellt am

BobbyD

Experte

- Mitglied seit

- 31.07.2022

- Beiträge

- 1.085

- Laptop

- https://psref.lenovo.com/Detail/Legion/Legion_5_17ACH6H?M=82JY005RGE

Proxmox hat ja durchaus Optionen diesbezüglich für VMs. Diese sind OOTB aber nicht aktiviert. Daher meine Frage, wenn ich diese nun aktiviere, ändert das überhaupt etwas oder muss ich dazu auch noch in den "Gästen" (Debian) etwas umstellen für funktionierendes TRIM.

Passthrough nutze ich nicht. Ich könnte mir vorstellen, dass für funktionierendes TRIM tatsächlich immer die ganze Kette funktionieren muss, also sowohl im Guest (VM) als auch auf dem Host, wenn kein Passthrough genutzt wird. Aber benutzt Debian OOTB überhaupt TRIM?

Man wird halt nirgends an die Hand genommen. 😉

Passthrough nutze ich nicht. Ich könnte mir vorstellen, dass für funktionierendes TRIM tatsächlich immer die ganze Kette funktionieren muss, also sowohl im Guest (VM) als auch auf dem Host, wenn kein Passthrough genutzt wird. Aber benutzt Debian OOTB überhaupt TRIM?

Man wird halt nirgends an die Hand genommen. 😉

Zuletzt bearbeitet:

Trim bei Einzelplatten wird sehr oft und seit langem in praktisch allen Systemen unterstützt

Trim im Raid ist eine Besonderheit, nur wenige können das so wie ZFS. Aber auch da nicht immer. Mit manchen Desktop SSDs gabs schon Datenverlust mit aktiviertem Trim.

Trim erfordert physischen Zugriff auf die Platte, geht in VMs also nur mit Hardware Passthrough.

Eine VM muss nicht wissen, wenn die darunterliegenden SSD ein Trim machen.

Trim im Raid ist eine Besonderheit, nur wenige können das so wie ZFS. Aber auch da nicht immer. Mit manchen Desktop SSDs gabs schon Datenverlust mit aktiviertem Trim.

Trim erfordert physischen Zugriff auf die Platte, geht in VMs also nur mit Hardware Passthrough.

Eine VM muss nicht wissen, wenn die darunterliegenden SSD ein Trim machen.

Zuletzt bearbeitet:

BobbyD

Experte

- Mitglied seit

- 31.07.2022

- Beiträge

- 1.085

- Laptop

- https://psref.lenovo.com/Detail/Legion/Legion_5_17ACH6H?M=82JY005RGE

@gea Aktuell gehe ich davon aus, dass TRIM bei mir nicht läuft, da die von mir nachträglich hinzugefügte, mit ZFS formatierte SSD auf dem Host nicht in der fstab Datei auftaucht (soweit ich das sagen kann als Linux-Noob).

Also der typische Linux Quark. 🤪

Gut, dass TRIM eh nur optional ist, denn ich kriege es hier wohl nicht zum Laufen für meine nachträglich zu Proxmox hinzugefügte SSD.

Beitrag automatisch zusammengeführt:

Dagegen spricht, dass man das bei den HDD-Images in Proxmox ja explizit konfigurieren kann, ergo kann TRIM "durchgereicht" werden.geht in VMs also nur mit Hardware Passthrough.

Beitrag automatisch zusammengeführt:

Also der typische Linux Quark. 🤪

Gut, dass TRIM eh nur optional ist, denn ich kriege es hier wohl nicht zum Laufen für meine nachträglich zu Proxmox hinzugefügte SSD.

Zuletzt bearbeitet:

Trim teilt der SSD mit welche Datenblöcke nicht in Verwendung sind um freie Bereiche zu löschen damit beim Schreiben seltener read block+erase block+write updated block Situationen auftreten die massiv Performance kosten. Sowas geht nur auf dem Level der die SSD physisch verwaltet. Bei einer VM mit einer virtual disk macht das keinen Sinn.

ZFS kann trim jederzeit auf einem Pool aus ssd ausführen oder man kann autotrim aktivieren

openzfs.github.io

openzfs.github.io

ZFS kann trim jederzeit auf einem Pool aus ssd ausführen oder man kann autotrim aktivieren

zpool-trim.8 — OpenZFS documentation

BobbyD

Experte

- Mitglied seit

- 31.07.2022

- Beiträge

- 1.085

- Laptop

- https://psref.lenovo.com/Detail/Legion/Legion_5_17ACH6H?M=82JY005RGE

Bzw. ich installiere mir napp-it auf den Proxmox Host und habe alles wesentliche zu ZFS in der Web-UI? Muss ich mir überlegen. Diese Modularität hätte was. Danke.ZFS kann trim jederzeit auf einem Pool aus ssd ausführen oder man kann autotrim aktivieren

Der neuste release candidate läuft jetzt direkt auf Proxmox. Windows wird nicht mehr benötigt, einfach herunterladen und starten, keine Installation. Deinstallation=Ordner löschen. Lediglich für die Verwaltung von Servergruppen oder Keyverwaltung wird ein extra Webserver wie Apache oder lighttpd oder ein Windows benötigt.

spacemonQuee

Experte

- Mitglied seit

- 08.12.2015

- Beiträge

- 150

- Details zu meinem Desktop

- Prozessor

- Ryzen R9 5900x

- Mainboard

- Asus X570 Creator Wifi

- Kühler

- HEATKILLER IV PRO HWLUXX Edition

- Speicher

- 4 x 32GB T-Force XTreem DDR4 3600

- Grafikprozessor

- 2 x Geforce RTX 3090FE

- Display

- HP X27q

- SSD

- 2 x Samsung SSD980Pro 2TB, Samsung 870EVO 2TB, Samsung 850Pro 500GB, Samsung 860EVO 500GB

- Gehäuse

- Phanteks Enthoo 719

- Netzteil

- Corsair HX1200 1200W

- Keyboard

- Ducky One 2 TKL

- Mouse

- Endgame Gear XM1

- Betriebssystem

- Windows 10 Pro

Habe glaub ich was dummes gemacht, kennt sich jemand mit LSI HBAs unter Proxmox aus? Meiner wird nicht mehr erkannt und auch mit lspci nicht aufgelistet.

spacemonQuee

Experte

- Mitglied seit

- 08.12.2015

- Beiträge

- 150

- Details zu meinem Desktop

- Prozessor

- Ryzen R9 5900x

- Mainboard

- Asus X570 Creator Wifi

- Kühler

- HEATKILLER IV PRO HWLUXX Edition

- Speicher

- 4 x 32GB T-Force XTreem DDR4 3600

- Grafikprozessor

- 2 x Geforce RTX 3090FE

- Display

- HP X27q

- SSD

- 2 x Samsung SSD980Pro 2TB, Samsung 870EVO 2TB, Samsung 850Pro 500GB, Samsung 860EVO 500GB

- Gehäuse

- Phanteks Enthoo 719

- Netzteil

- Corsair HX1200 1200W

- Keyboard

- Ducky One 2 TKL

- Mouse

- Endgame Gear XM1

- Betriebssystem

- Windows 10 Pro

ich habe (bzw. hatte) einen PVE 7.3-3 am laufen, darauf zwei LXC containter und eine VM auf welcher TrueNAS lief. TrueNAS hatte mit Hilfe eines LSI 9210-8i vier HDDs im pool.Schreib doch mal etwas mehr darüber, was Du nun gemacht hast was zu dem aktuellen Zustand geführt hat.

Ich wollte auf neue Hardware umziehen, habe backups auf eine externe SSD von den containern und der VM gemacht, habe die System-SSD, den HBA und eine Mellanox Karte auf der neuen Hardware installiert (Mainboard Gigabyte MC12-LE0, CPU AMD 5900X und 2x32GB ECC RAM). Das hat nicht funktioniert, kam nicht über POST hinaus und jedes mal wenn ich ins BIOS wollte oder mit F10 die bootoptionen auswählen wollte hat sich das system neu gestartet.

Habe die Hardware also wieder zurückgebaut, den alten Server gestartet, und seitdem startet die TrueNAS VM nicht mehr mit dem error " TASK ERROR: no PCI device found for '0000:09:00.0' "

unter lspci wird der LSI 9210-8i auch nicht mehr aufgelistet.

Jetzt frage ich mich, habe ich dem HBA beim umbau einen Hardwaredefekt verursacht,

Edit Nachtrag: habe inzwischen versucht eine neue Firmware auf den HBA zu flashen mit dieser anleitung. Auch hier findet er die LSI Karte nicht mehr, ich vermute daher inzwischen einen Hardware defekt

Ich habe nach dem missglückten Umzug noch PVE 8.3 auf eine andere SSD neu installiert, mit eingestecktem HBA während der installation, vielleicht wurde hier etwas überschrieben? Aber auch hier hat das neue System die karte nicht aufgelistet mit lspci.

Habe keinen zweiten HBA, wenn ich jedoch einen besorge könnte ich die VM und viel wichtiger den zfs-pool wieder zum laufen bekommen?

Die Frage wäre, wie der LSI eingebunden war: auf dem Proxmox Host, oder hast Du per Paththrough an die VM durch gereicht? Ob und wie ein System mit eingestecktem (bootfähigem) RaidControlelr bootet, hängt auch von der Mainboard Bios config ab, sprich die Bootreihenfolge muss dort stimmen.

Den Controller unter UEFI flashen <kann> eine echte herausforderung sein, d.h. bloss weis das jetzt auf die schnelle nicht geklappt hat, muss die Karte nicht zwingend defekt sein.

Ich würde erstmal schauen, ob der Controller im Bios irgendwie erkannt wird (= als Boot Device angeboten wird), und ob der z.B. so Meldungen ausgibt wie "Press CTRL+H" für Controller Bios oder so ähnlich. Und mal mit Bios Einstellungen herumspielen, was die Boot Reihenfolge angeht. Erst wenn das geschafft ist, würde ich im OS weiter machen.

Was Deinen ZFS Pool angeht, ist die Frage wieder angelegt wurde: als RAID über den Controller, oder über einzelne Platten über den Controller.

Den Controller unter UEFI flashen <kann> eine echte herausforderung sein, d.h. bloss weis das jetzt auf die schnelle nicht geklappt hat, muss die Karte nicht zwingend defekt sein.

Ich würde erstmal schauen, ob der Controller im Bios irgendwie erkannt wird (= als Boot Device angeboten wird), und ob der z.B. so Meldungen ausgibt wie "Press CTRL+H" für Controller Bios oder so ähnlich. Und mal mit Bios Einstellungen herumspielen, was die Boot Reihenfolge angeht. Erst wenn das geschafft ist, würde ich im OS weiter machen.

Was Deinen ZFS Pool angeht, ist die Frage wieder angelegt wurde: als RAID über den Controller, oder über einzelne Platten über den Controller.

pwnbert

Legende

- Mitglied seit

- 30.10.2014

- Beiträge

- 5.346

Hilft dir das weiter?

Passthrough eines alten LSI war bissl tricky am MC12 mit Proxmox, siehe Rombar und Bootoptionen:

www.hardwareluxx.de

Ausm BIOS war ich nie direkt drin glaub ich, müsstest mal unter den PCIe Settings schauen, was es da in der Hinsicht gibt. MC12 ist so ne Sache.

www.hardwareluxx.de

Ausm BIOS war ich nie direkt drin glaub ich, müsstest mal unter den PCIe Settings schauen, was es da in der Hinsicht gibt. MC12 ist so ne Sache.

Steckt der HBA vllt einfach schlecht im Slot?

Passthrough eines alten LSI war bissl tricky am MC12 mit Proxmox, siehe Rombar und Bootoptionen:

[Sammelthread] - Proxmox Stammtisch

Macht das wer? Nein. Sorry, ist einfach keine Hilfe. Falls tatsächlich wer den Filer auf dem durchgereichten HBA betreibt, bitte Hände hoch. Diejenigen die den Filer dagegen virtuell laufen lassen auch Hände hoch.

Steckt der HBA vllt einfach schlecht im Slot?

PCI Passthrough - Proxmox VE

Für PT muss man ggf. auch noch paar Parameter von Hand setzen. Ich <meine> das wäre früher anders gewesen - daher kann es sein, das Du mit der neusten PVE Version nicht das gleiche Setup fahren kannst, ohne manuelle Änderungen an div. konfigs. Aber dazu muss der Controller erstmal *irgendwo* sichtbar werden, danach kann man schauen ob und wie man den einbindet.

spacemonQuee

Experte

- Mitglied seit

- 08.12.2015

- Beiträge

- 150

- Details zu meinem Desktop

- Prozessor

- Ryzen R9 5900x

- Mainboard

- Asus X570 Creator Wifi

- Kühler

- HEATKILLER IV PRO HWLUXX Edition

- Speicher

- 4 x 32GB T-Force XTreem DDR4 3600

- Grafikprozessor

- 2 x Geforce RTX 3090FE

- Display

- HP X27q

- SSD

- 2 x Samsung SSD980Pro 2TB, Samsung 870EVO 2TB, Samsung 850Pro 500GB, Samsung 860EVO 500GB

- Gehäuse

- Phanteks Enthoo 719

- Netzteil

- Corsair HX1200 1200W

- Keyboard

- Ducky One 2 TKL

- Mouse

- Endgame Gear XM1

- Betriebssystem

- Windows 10 Pro

Die Frage wäre, wie der LSI eingebunden war: auf dem Proxmox Host, oder hast Du per Paththrough an die VM durch gereicht? Ob und wie ein System mit eingestecktem (bootfähigem) RaidControlelr bootet, hängt auch von der Mainboard Bios config ab, sprich die Bootreihenfolge muss dort stimmen.

Das weiß ich leider nicht mehr aber bin fast sicher dass sie durchgereicht war in die VM damit TrueNAS sie nutzen kann. Erinnere mich noch dass ich ein paar iommu settings einstellen musste.

Ich würde erstmal schauen, ob der Controller im Bios irgendwie erkannt wird (= als Boot Device angeboten wird), und ob der z.B. so Meldungen ausgibt wie "Press CTRL+H" für Controller Bios oder so ähnlich. Und mal mit Bios Einstellungen herumspielen, was die Boot Reihenfolge angeht. Erst wenn das geschafft ist, würde ich im OS weiter machen.

Wird er leider nicht. In keinem der beiden BIOS, weder vom alten board (Asus X99-E WS), noch vom neuen Gigabyte.

Was Deinen ZFS Pool angeht, ist die Frage wieder angelegt wurde: als RAID über den Controller, oder über einzelne Platten über den Controller.

Raid mit zwei vdevs

Hilft dir das weiter?

Passthrough eines alten LSI war bissl tricky am MC12 mit Proxmox, siehe Rombar und Bootoptionen:

Ausm BIOS war ich nie direkt drin glaub ich, müsstest mal unter den PCIe Settings schauen, was es da in der Hinsicht gibt. MC12 ist so ne Sache.

[Sammelthread] - Proxmox Stammtisch

Macht das wer? Nein. Sorry, ist einfach keine Hilfe. Falls tatsächlich wer den Filer auf dem durchgereichten HBA betreibt, bitte Hände hoch. Diejenigen die den Filer dagegen virtuell laufen lassen auch Hände hoch.www.hardwareluxx.de

Danke schaue ich mir an und gebe Rückmeldung.

Steckt der HBA vllt einfach schlecht im Slot?

Nein ausgeschlossen

Zuletzt bearbeitet:

pwnbert

Legende

- Mitglied seit

- 30.10.2014

- Beiträge

- 5.346

Die Antwort ist für mich unklar.Raid mit zwei vdevs

Ich meine, er möchte wissen, obs Hardware-Raid war (also TrueNAS nur 1 Drive sieht), oder obs Software-Raid (Z1/Z2/whatever) war, und TrueNAS alle Drives "sieht".

Im zweiten Fall ist alles recht easy und du kannst sonst irgend nen HBA/ASM1166 etc. nehmen, im ersten Fall kenn ich mich nicht aus (HW-Raid).

LSI 9210-8i gibts um 20€ ohne Kabel und um 30€ mit Kabel auf ebay-de aus China, wird aber brauchen, bis die da sind.

spacemonQuee

Experte

- Mitglied seit

- 08.12.2015

- Beiträge

- 150

- Details zu meinem Desktop

- Prozessor

- Ryzen R9 5900x

- Mainboard

- Asus X570 Creator Wifi

- Kühler

- HEATKILLER IV PRO HWLUXX Edition

- Speicher

- 4 x 32GB T-Force XTreem DDR4 3600

- Grafikprozessor

- 2 x Geforce RTX 3090FE

- Display

- HP X27q

- SSD

- 2 x Samsung SSD980Pro 2TB, Samsung 870EVO 2TB, Samsung 850Pro 500GB, Samsung 860EVO 500GB

- Gehäuse

- Phanteks Enthoo 719

- Netzteil

- Corsair HX1200 1200W

- Keyboard

- Ducky One 2 TKL

- Mouse

- Endgame Gear XM1

- Betriebssystem

- Windows 10 Pro

Sorry. Software RAID. ein 9211 sollte dann auch gehn vermute ich, vielleicht sogar 93xx. Muss noch die Unterschiede herausfinden abgesehen von PCI 2 vs 3.Die Antwort ist für mich unklar.

Ich meine, er möchte wissen, obs Hardware-Raid war (also TrueNAS nur 1 Drive sieht), oder obs Software-Raid (Z1/Z2/whatever) war, und TrueNAS alle Drives "sieht".

Im zweiten Fall ist alles recht easy und du kannst sonst irgend nen HBA/ASM1166 etc. nehmen, im ersten Fall kenn ich mich nicht aus (HW-Raid).

LSI 9210-8i gibts um 20€ ohne Kabel und um 30€ mit Kabel auf ebay-de aus China, wird aber brauchen, bis die da sind.

pwnbert

Legende

- Mitglied seit

- 30.10.2014

- Beiträge

- 5.346

Naja, irgendwann ist das "Bios" anders, wird dann ins UEFI integriert.

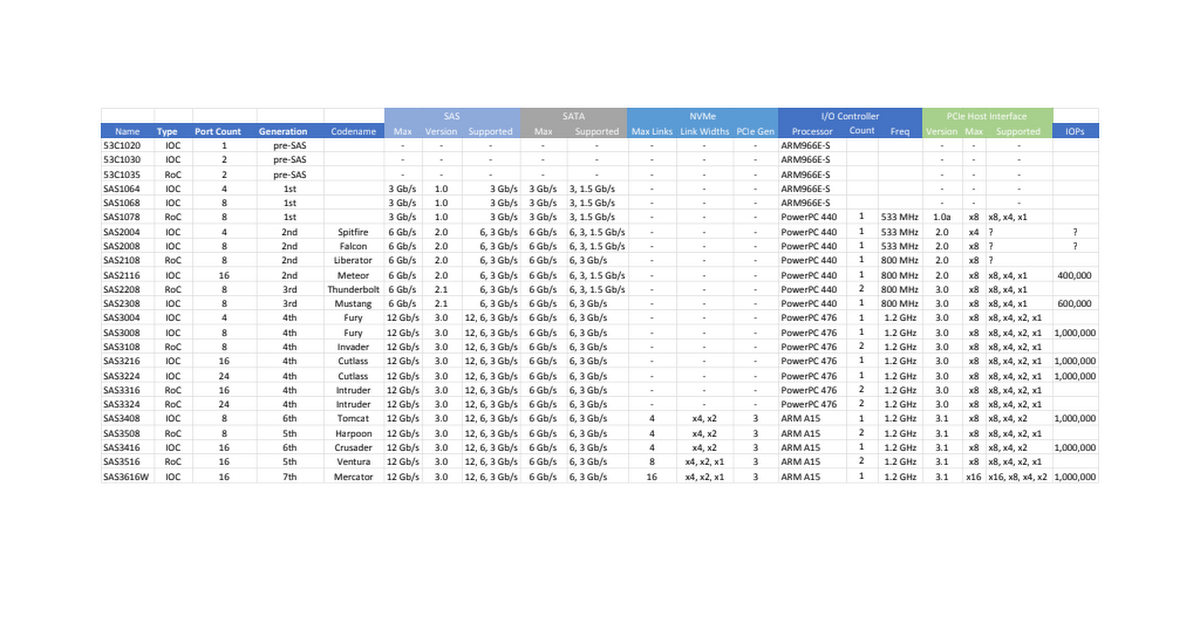

Irgendwo gibts ein Spreadsheet wo die drin stehen, auch im Forum hier verlinkt, müsste man nur finden (siehe Ende vom Post).

Ab irgendwann können sie auch Tri-Mode, also nvme, wobei ich damit an nem 9400-16i herumfrickel seit ner Zeit, geht nicht so ohne weiteres. Möglicherweise braucht man dafür "spezielle "Kabel (welche man so billig nicht kommt). Bin da noch nicht ganz durch. Wobei die nvme Performance eh eher meh sein soll.

Das mit PCIe und SAS Version wird vmtl. recht egal sein, je nach Größe des Raids natürlich. Wenn du aber so das druchschnittliche Home-User Raid mit 4-8 HDDs hast, werdens realistsich PCIE 2.0x4 als Anbindung auch tun.

Hab nen billigen LSI 9207-8i liegen, mit kabeln unter 30€, isn Inspur, sieht neu aus (ob ers wohl war?). Kühlkörper sehr klein und sehr warm, aber darf wohl auch so warm werden. Hat noch das "alte" Bios. Stromverbrauch okay. Die Namen sind lustig, der 9207-8i ist mit dem 2308er Chip neuer als der 9210-8i mit dem 2008er Chip.

Einen Lenovo 9400-16i (sas3416) hab ich auch noch hier, mit dem muss ich mich noch näher beschäftigen. Einfach so als HBA funktioniert er schon, die TriMode Sache hab ich aber noch nicht hinbekommen (und ob ich das je werde).

Theoretisch kann der 4x nvme, lt. Tabelle link width x2/x4, was mich natürlich total neugierig machen würde, ob man da mit 8 "Kanälen" dann tatsächlich 4 nvme mit je PCIe 3.0x2 betreiben kann, was eine relativ geile Option wäre fürn Hybrid-Pool imho. Geht aber so wsl nur mit speziellem Kabelwerk, wenn überhaupt.

Der 9400-16i ist kühler und sparsamer als der 9207-8i, was schon ziemlich nice ist. Kostet halt selbst als günstiges Angebot doch seine 100€ und verwendet andere Kabel.

9300 soll meiner recherche nach bissl wärmer werden als 9207, drum hab ich mich für den nicht weiter interessiert. Ist aber auch moderner... vllt. treibermäßig irgendwie interessant.

Der 9207 / sas2308 hat noch den SFF-8087 Stecker.

Ab dem 9300er ist es dann der SFF-8643 Stecker.

Je nach dem, wie du verkabelt hast, ist es vllt. interessant beim alten Stecker zu bleiben (wobei es auf ebay aus China viele günstige Sets mit SATA Kabeln gibt, welche imho sehr gut sind, aber wenn du irgend eine SFF Hotswap Backplane hast, hilft dir das vllt. nicht).

Der sas2008 ist halt wirklich alt (aus 2008).

forum.proxmox.com

Offenbar bist du nicht allein, aber ich kann dir nicht wirklich weiterhelfen.

forum.proxmox.com

Offenbar bist du nicht allein, aber ich kann dir nicht wirklich weiterhelfen.

Wobei, brauchst du den HBA überhaupt? Hat das MC12 zu wenige Ports? Oder reichst du den ganzen Controller per PCIe durch?

Du könntest den HBA auch durch eine ASM1166 Karte (6x Sata, PCIe 3.0x2) ersetzen (bekommst zumindest bei amzn Prime um +/-30€), ist sparsamer, sollte ASPM soweit können und nicht zuu schlecht sein. Das JMB Äquivalent mit 5 Ports würde ich nicht in betracht ziehen, der hat so ne Art Reset Bug beim Passthrough unter Proxmox.

tl,dr:

Ich würde versuchen das Problem mit "neuer" Hardware zu umschiffen (28€ fürn 9207-8i mitsamt Kabelsatz ist ja nix, nur die Lieferzeit ist bissl blöd) - oder den HBA ganz weg lassen, wenn das eine Option ist.

PS:

Gefunden!

docs.google.com

docs.google.com

Irgendwo gibts ein Spreadsheet wo die drin stehen, auch im Forum hier verlinkt, müsste man nur finden (siehe Ende vom Post).

Ab irgendwann können sie auch Tri-Mode, also nvme, wobei ich damit an nem 9400-16i herumfrickel seit ner Zeit, geht nicht so ohne weiteres. Möglicherweise braucht man dafür "spezielle "Kabel (welche man so billig nicht kommt). Bin da noch nicht ganz durch. Wobei die nvme Performance eh eher meh sein soll.

Das mit PCIe und SAS Version wird vmtl. recht egal sein, je nach Größe des Raids natürlich. Wenn du aber so das druchschnittliche Home-User Raid mit 4-8 HDDs hast, werdens realistsich PCIE 2.0x4 als Anbindung auch tun.

Hab nen billigen LSI 9207-8i liegen, mit kabeln unter 30€, isn Inspur, sieht neu aus (ob ers wohl war?). Kühlkörper sehr klein und sehr warm, aber darf wohl auch so warm werden. Hat noch das "alte" Bios. Stromverbrauch okay. Die Namen sind lustig, der 9207-8i ist mit dem 2308er Chip neuer als der 9210-8i mit dem 2008er Chip.

Einen Lenovo 9400-16i (sas3416) hab ich auch noch hier, mit dem muss ich mich noch näher beschäftigen. Einfach so als HBA funktioniert er schon, die TriMode Sache hab ich aber noch nicht hinbekommen (und ob ich das je werde).

Theoretisch kann der 4x nvme, lt. Tabelle link width x2/x4, was mich natürlich total neugierig machen würde, ob man da mit 8 "Kanälen" dann tatsächlich 4 nvme mit je PCIe 3.0x2 betreiben kann, was eine relativ geile Option wäre fürn Hybrid-Pool imho. Geht aber so wsl nur mit speziellem Kabelwerk, wenn überhaupt.

Der 9400-16i ist kühler und sparsamer als der 9207-8i, was schon ziemlich nice ist. Kostet halt selbst als günstiges Angebot doch seine 100€ und verwendet andere Kabel.

9300 soll meiner recherche nach bissl wärmer werden als 9207, drum hab ich mich für den nicht weiter interessiert. Ist aber auch moderner... vllt. treibermäßig irgendwie interessant.

Der 9207 / sas2308 hat noch den SFF-8087 Stecker.

Ab dem 9300er ist es dann der SFF-8643 Stecker.

Je nach dem, wie du verkabelt hast, ist es vllt. interessant beim alten Stecker zu bleiben (wobei es auf ebay aus China viele günstige Sets mit SATA Kabeln gibt, welche imho sehr gut sind, aber wenn du irgend eine SFF Hotswap Backplane hast, hilft dir das vllt. nicht).

Der sas2008 ist halt wirklich alt (aus 2008).

No SAS2008 after upgrade

Hello All. I've upgraded from 7 to 8 successfully except one problem. If i use kernel 6.2.16-3-pve it will not detect my SAS2008 hba cards, using 5.15.108-1 is fine. Can anyone can tell why is that and if there is any way to add drivers to this cards and use newest kernel?

Wobei, brauchst du den HBA überhaupt? Hat das MC12 zu wenige Ports? Oder reichst du den ganzen Controller per PCIe durch?

Du könntest den HBA auch durch eine ASM1166 Karte (6x Sata, PCIe 3.0x2) ersetzen (bekommst zumindest bei amzn Prime um +/-30€), ist sparsamer, sollte ASPM soweit können und nicht zuu schlecht sein. Das JMB Äquivalent mit 5 Ports würde ich nicht in betracht ziehen, der hat so ne Art Reset Bug beim Passthrough unter Proxmox.

tl,dr:

Ich würde versuchen das Problem mit "neuer" Hardware zu umschiffen (28€ fürn 9207-8i mitsamt Kabelsatz ist ja nix, nur die Lieferzeit ist bissl blöd) - oder den HBA ganz weg lassen, wenn das eine Option ist.

PS:

Gefunden!

avago_info_v1.1

Wenn man konfigurierte Platten von einem alten LSI Controller an einen neuen Controller steckt, kriegt man eine Meldung: "found foreign configuration, import?" -> wenn man dann YES sagt, wird das Drive Setup importiert.

/edit

Man kann den Import auch über das Controller Bios anstossen, wenn man die Meldung beim booten verpasst hat.

Und die Reihenfolge der Platten ist dem Controller auch egal, d.h. es ist (zumindest meiner Erfahrung nach) egal, ob die Platte von #1 an #6 angeschlossen wird. Sofern der PC ausgeschaltet ist, kann man die Platten in der Backplane auch "umsortrieren", z.b. um zwischen den Platten freie Slots zu haben für bessere Kühlung.

/edit

Man kann den Import auch über das Controller Bios anstossen, wenn man die Meldung beim booten verpasst hat.

Und die Reihenfolge der Platten ist dem Controller auch egal, d.h. es ist (zumindest meiner Erfahrung nach) egal, ob die Platte von #1 an #6 angeschlossen wird. Sofern der PC ausgeschaltet ist, kann man die Platten in der Backplane auch "umsortrieren", z.b. um zwischen den Platten freie Slots zu haben für bessere Kühlung.

Zuletzt bearbeitet:

Moin,

kurze Frage an die Experten:

Ich werde meinen Proxmox Server umbauen. In Zukunft werde ich eine VM haben die als NAS fungiert - an diese VM möchte ich den SATA Controller vom Mainboard (AMD B450 Chipsatz) weiterreichen, da ich die HDDs, die am SATA Controller hängen, nur in der NAS VM brauche.

Das NAS brauche ich aber nur sporadisch. Ich möchte, dass wenn die VM aus ist, auch die HDDs aus sind, um Strom zu sparen und die HDDs zu schonen (auch wenn mir bewusst ist, dass das hochfahren der HDDs auch (sehr) auf die Lebensdauer geht).

Wie realisiere ich das am besten? Reicht es, wenn ich die VM herunterfahre? Hat jemand von euch das Szenario vielleicht umgesetzt?

Danke euch.

kurze Frage an die Experten:

Ich werde meinen Proxmox Server umbauen. In Zukunft werde ich eine VM haben die als NAS fungiert - an diese VM möchte ich den SATA Controller vom Mainboard (AMD B450 Chipsatz) weiterreichen, da ich die HDDs, die am SATA Controller hängen, nur in der NAS VM brauche.

Das NAS brauche ich aber nur sporadisch. Ich möchte, dass wenn die VM aus ist, auch die HDDs aus sind, um Strom zu sparen und die HDDs zu schonen (auch wenn mir bewusst ist, dass das hochfahren der HDDs auch (sehr) auf die Lebensdauer geht).

Wie realisiere ich das am besten? Reicht es, wenn ich die VM herunterfahre? Hat jemand von euch das Szenario vielleicht umgesetzt?

Danke euch.

xST4R

Enthusiast

- Mitglied seit

- 22.10.2017

- Beiträge

- 3.744

hey proxmox experten,

ich habe keinerlei / wenig erfahrung mit proxmox und möchte mir ein neues homelab aufbauen.

der server steht soweit nun frag ich mich wie ich das mit den platten mache , sollte ich proxmox auf einzelne platten legen und die vm's aus getrennt ?

bisher habe ich es so geplant :

2x 250gb SSD - Proxmox > im raid1 > zfs

2x 1tb SSD - Proxmox VMs > im raid1 > zfs

2x 1tb SSD - Docker / Cache für TrueNAS > im raid1 > zfs

1x 2tb SSD > ISO Dateien (iventoy) > zfs

2x 8tb HDD > NAS > im raid1 > zfs

habt ihr verbesserungsvorschläge ?

legende :

sata m2hdd

was hab ich geplant :

- einige docker container

- 2-3 vm

- plex / Jellyfin

- truenas

- iventoy (pc über netzwerk installieren)

eine weitere frage wär was ich an ddr5 ecc ram haben sollte bei der aktuellen maximalen datenmenge ?

ich habe keinerlei / wenig erfahrung mit proxmox und möchte mir ein neues homelab aufbauen.

der server steht soweit nun frag ich mich wie ich das mit den platten mache , sollte ich proxmox auf einzelne platten legen und die vm's aus getrennt ?

bisher habe ich es so geplant :

2x 250gb SSD - Proxmox > im raid1 > zfs

2x 1tb SSD - Proxmox VMs > im raid1 > zfs

2x 1tb SSD - Docker / Cache für TrueNAS > im raid1 > zfs

1x 2tb SSD > ISO Dateien (iventoy) > zfs

2x 8tb HDD > NAS > im raid1 > zfs

habt ihr verbesserungsvorschläge ?

legende :

sata m2hdd

was hab ich geplant :

- einige docker container

- 2-3 vm

- plex / Jellyfin

- truenas

- iventoy (pc über netzwerk installieren)

eine weitere frage wär was ich an ddr5 ecc ram haben sollte bei der aktuellen maximalen datenmenge ?

Zuletzt bearbeitet:

Weltherrscher

Experte

- Mitglied seit

- 28.04.2008

- Beiträge

- 915

Wie hast du dir das mit dem Docker/Cache vorgestellt?

Im Proxmox mit ZFS formatieren und wie in TrueNAS weiter reichen?

Als eine Disk?

Weiß nicht, wie das mit ZFS auf ZFS ist, könnte jedoch schreibintensiv sein, je nachdem, ob dus als ARC oder ZLOG nutzen willst.

ZLOGs brauchen eher super Schreibraten pro Tag, eher wenigewr Geschwindigkeit.

Von den Dingern wird seltenst gelesen.

DDR5 ECC?

In welchen Rechner?

Im Proxmox mit ZFS formatieren und wie in TrueNAS weiter reichen?

Als eine Disk?

Weiß nicht, wie das mit ZFS auf ZFS ist, könnte jedoch schreibintensiv sein, je nachdem, ob dus als ARC oder ZLOG nutzen willst.

ZLOGs brauchen eher super Schreibraten pro Tag, eher wenigewr Geschwindigkeit.

Von den Dingern wird seltenst gelesen.

DDR5 ECC?

In welchen Rechner?

xST4R

Enthusiast

- Mitglied seit

- 22.10.2017

- Beiträge

- 3.744

ich weis noch garnicht wie, es wird warscheinlich ein linux in einer vm und dort dann docker installiert (hab mich da noch nicht informiert wie es laufen soll)

und nein ich will das alles trennen. (zur not muss ich noch hdd/ssd nachkaufen)

setup ist :

am5

3x m2 (onboard)

4x sata (mit wifi to sata 6x)

ddr5 (bis 128gb)

ecc

bifurcation (die karte für 4x m² hab ich auch schon hier)

1x 2.5gbit

und thunderbolt

+ nanoKVM

aktuell bin ich noch in der "ich weis noch nicht wie phase"

und nein ich will das alles trennen. (zur not muss ich noch hdd/ssd nachkaufen)

setup ist :

am5

3x m2 (onboard)

4x sata (mit wifi to sata 6x)

ddr5 (bis 128gb)

ecc

bifurcation (die karte für 4x m² hab ich auch schon hier)

1x 2.5gbit

und thunderbolt

+ nanoKVM

aktuell bin ich noch in der "ich weis noch nicht wie phase"

Zuletzt bearbeitet:

Man sollte Storage so einfach wie möglich konzipierenhey proxmox experten,

ich habe keinerlei / wenig erfahrung mit proxmox und möchte mir ein neues homelab aufbauen.

der server steht soweit nun frag ich mich wie ich das mit den platten mache , sollte ich proxmox auf einzelne platten legen und die vm's aus getrennt ?

bisher habe ich es so geplant :

2x 250gb SSD - Proxmox > im raid1 > zfs

2x 1tb SSD - Proxmox VMs > im raid1 > zfs

2x 1tb SSD - Docker / Cache für TrueNAS > im raid1 > zfs

1x 2tb SSD > ISO Dateien (iventoy) > zfs

2x 8tb HDD > NAS > im raid1 > zfs

- 250 GB Proxmox Bootmirror (nur Proxmox, keine VMs): ok

- 8 GB Datenmirror: ok

Cache: Schreibcache in ZFS ist RAM, Lesecache primär RAM, kann man als SSD erweitern,

bringt aber mit ausreichend RAM nichts. Besser sind Hybrid Pools mit Special Vdevs für kleine Dateien, Metadaten oder komplette ZFS Dateisysteme.

Ich würde mir noch eine 2TB M2 kaufen um 2 x 2 special vdev mirrors zu haben (3TB nutzbar)

dann noch eine 8 TB Platte als externes Backup (USB)

Der Pool hätte dann 11 TB (8+3) die man flexibel nutzen kann

Bleibt das sync write Problem mit VMs

Da man mit VMs sync aktivieren sollte, geht die Performance mit Plattenpools in den Keller wenn man kein Slog (ab 10GB) hat. Man könnte jetzt eine der M.2 partitionieren. Ohne Slog Mirror sollte die M.2 PLP haben.

eine weitere frage wär was ich an ddr5 ecc ram haben sollte bei der aktuellen maximalen datenmenge ?

Es gibt keine feste Relation RAM->Poolgröße.

Was man sagen kann ist dass Proxmox 2-4GB braucht, dazu den RAM den die VMs brauchen (auch min 2-4 GB für ein 64bit OS) dazu den RAM den man Proxmox gönnen möchte um ZFS schneller zu machen (Schreib-Lesecache) auch so ab 4 GB.

Wird der ZFS Hauptspeicher nicht von Proxmox verwaltet sondern einer Storage VM mit Passthrough so kommt deren Bedarf dazu, sind bei einer Illumos Storage VM 2-4 GB, bei Linux 4-8 GB.

Proxmox als Homeserver das auch NAS direkt macht geht damit ab ca 16GB, mit einer Storage VM eher 24-32 GB dazu der Bedarf der VMs, gerne mehr damit das System nicht gleich auf Platte swappen muss..

xST4R

Enthusiast

- Mitglied seit

- 22.10.2017

- Beiträge

- 3.744

danke dir für die antwort.

mein plan war das halt so zu gestallten das die hdd's permanent im standby sind und nur aktiv werden wenn daten geschrieben oder kopiert oder gelöscht werden. auserdem wollte ich mal schauen ob es bei truenas eine art folder-cache gibt so das die platten beim reinen "durchsuchen" nicht direkt geweckt werden (unraid bietet zb so eine funktion)

daher wollte ich das "nas" quasi komplett vom eigentlich proxmox und den anderen vm's trennen.

ein externes backup habe ich auch geplant (usb platten besitze ich bereits , auserdem habe ich einen root server und google drive mit 2tb)

vielleicht ist auch proxmox garnicht das richtige für mich ? (um das rauszufinden bin ich hier)

mein plan war das halt so zu gestallten das die hdd's permanent im standby sind und nur aktiv werden wenn daten geschrieben oder kopiert oder gelöscht werden. auserdem wollte ich mal schauen ob es bei truenas eine art folder-cache gibt so das die platten beim reinen "durchsuchen" nicht direkt geweckt werden (unraid bietet zb so eine funktion)

daher wollte ich das "nas" quasi komplett vom eigentlich proxmox und den anderen vm's trennen.

ein externes backup habe ich auch geplant (usb platten besitze ich bereits , auserdem habe ich einen root server und google drive mit 2tb)

vielleicht ist auch proxmox garnicht das richtige für mich ? (um das rauszufinden bin ich hier)

Zuletzt bearbeitet:

pwnbert

Legende

- Mitglied seit

- 30.10.2014

- Beiträge

- 5.346

Vielleicht ist Unraid was für dich.

Welche Hardware hast bereits?

Steck einfach irgendwas zusammen und installier mal, dann siehst eh, wo das hinführt.

Ob du jetzt ne alte 2.5" Laptop 250gb HDD ansteckst oder ne 22tb Heliumplatte ist egal. TrueNAS bootet sogar von so ner genannten Platte recht flott, kann man alles so zusammenfrickeln fürn Testaufbau, solangs kein IDE ist...

Nachtrag:

Weisst du, im Nachbarthread redest du noch so groß. Es hat schon nen Grund, warum son einfach Syno/QNAP als benutzerfreundlich gilt.

Ich mag dich hier auch ned blöd anmachen, dir nur erklären, dass es nen Grund hat, warum es so Produkte gibt.

Du wirst schon noch merken, dass es mit einer finalen Inbetriebnahme im Jahr 2025 eng werden könnte bei deinem MJ11 Projekt.

ZFS hat auch keinen "Cache" und SLOG(ZIL) und L2arc solltest du ganz schnell vergessen (ich war schon an diesem Ort, kann man hier nachlesen), svdev... naja... fürn Anfang eher nicht.

Welche Hardware hast bereits?

Steck einfach irgendwas zusammen und installier mal, dann siehst eh, wo das hinführt.

Ob du jetzt ne alte 2.5" Laptop 250gb HDD ansteckst oder ne 22tb Heliumplatte ist egal. TrueNAS bootet sogar von so ner genannten Platte recht flott, kann man alles so zusammenfrickeln fürn Testaufbau, solangs kein IDE ist...

Nachtrag:

Weisst du, im Nachbarthread redest du noch so groß. Es hat schon nen Grund, warum son einfach Syno/QNAP als benutzerfreundlich gilt.

Ich mag dich hier auch ned blöd anmachen, dir nur erklären, dass es nen Grund hat, warum es so Produkte gibt.

Du wirst schon noch merken, dass es mit einer finalen Inbetriebnahme im Jahr 2025 eng werden könnte bei deinem MJ11 Projekt.

ZFS hat auch keinen "Cache" und SLOG(ZIL) und L2arc solltest du ganz schnell vergessen (ich war schon an diesem Ort, kann man hier nachlesen), svdev... naja... fürn Anfang eher nicht.

Mit VMs gibts kein Standby und Cache bei ZFS ist ausschließlich RAM. Der arbeitet nicht dateibasiert (wäre auch nicht sinnvoll) sondern speichert read last/read most Datenblöcke. Was man machen könnte wäre ein zweiter SSD pool. Bei den gesparten paar Watt bei 2 Platten ist das aber eher Verschwendung von Gehirnschmalz, keep it easy!mein plan war das halt so zu gestallten das die hdd's permanent im standby sind und nur aktiv werden wenn daten geschrieben oder kopiert oder gelöscht werden. auserdem wollte ich mal schauen ob es bei truenas eine art folder-cache gibt so das die platten beim reinen "durchsuchen" nicht direkt geweckt werden (unraid bietet zb so eine funktion)

daher wollte ich das "nas" quasi komplett vom eigentlich proxmox und den anderen vm's trennen.

ein externes backup habe ich auch geplant (usb platten besitze ich bereits , auserdem habe ich einen root server und google drive mit 2tb)

vielleicht ist auch proxmox garnicht das richtige für mich ? (um das rauszufinden bin ich hier)

Nachdem ESXi unbezahlbar geworden ist, ist Proxmox die ideale VM Plattform. Da neuestes ZFS fest dabei ist, auch ein ideales NAS und da es Debian ist, auch ein idealer Allround Server. Für mich ist Proxmox einfach das interessanteste Server-Linux derzeit.

Alternativen daher (mit ZFS):

OSX (mit genügend Kleingeld), etwas eingeschränkt in den Anwendungen.

Windows (wird für mich wieder zunehmen eine Top Lösung) mit Storage Spaces + ZFS (fast fertig), überragendem ACL Handling, Hyper-V mit virtual harddisk und SMB Direkt (Windows Server)

Qnap (Fertig NAS mit eigenem ZFS)

OmniOS (Solaris Fork, minimalistischer ZFS Server, glänzt mit geringstem Resourcenverbrauch und ZFS Stabilität)

Weltherrscher

Experte

- Mitglied seit

- 28.04.2008

- Beiträge

- 915

pwnbert

Legende

- Mitglied seit

- 30.10.2014

- Beiträge

- 5.346

Brauchst imho nicht, die iGPU der "normalen" CPUs tuts und die können ECC.Gibts für AM5 schon Ryzen Pros mit GPU (für ECC)?

Sollte z.B. mit dem Asrock B850 Livemixer gut gehen, habs aber nicht getestet.

xST4R

Enthusiast

- Mitglied seit

- 22.10.2017

- Beiträge

- 3.744

Welche Hardware hast bereits?

Was das fürn Brett?

Welche CPU?

Gibts für AM5 schon Ryzen Pros mit GPU (für ECC)?

Wo soll die Bifurcation-Karte rein?

Hast du ne extra Graka geplant?

ich habe eine alte unraid lizenz (muss also nicht monatlich zahlen) und habe vorher auch immer unraid genutzt. ein mate meinte aber das proxmox in allem für mich die bessere wahl ist ...

folgende hardware habe ich aktuell :

Ryzen 7 7700 (nicht die beste wahl aber kann ECC und war günstig und hat igpu)

ASROCK B650M PG Lightning

(*Please refer to Memory Support List for more information)

2x 8tb hdd (seagate ironwolf)

2x 1tb nvme (wd sn770)

1x 2tb nvme (wd sn850x)

morgen kommen :

2x 1tb sata ssd Crucial BX500

2x 240gb sata ssd Crucial BX500

eine extra gpu ist nicht geplant !

die bifurcation ist geplant für weitere nvme platten und schaut so aus :

die karte habe ich auch bereits hier

auserdem ist ein wifi to sata adapter aufm weg und sollte in den nächsten 7 tagen hier eintreffen

das sind so die sachen die ich bisher habe / geplant habe / auf dem weg sind .

Zuletzt bearbeitet:

Ähnliche Themen

- Antworten

- 21

- Aufrufe

- 1K

- Antworten

- 10

- Aufrufe

- 1K