Install the app

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: this_feature_currently_requires_accessing_site_using_safari

-

Hardwareluxx führt derzeit die Hardware-Umfrage 2025 (mit Gewinnspiel) durch und bittet um eure Stimme.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

56 P-Cores am Limit: Der Intel Xeon w9-3495X im Test

- Ersteller HWL News Bot

- Erstellt am

blazethelight

Enthusiast

Das ist erfreulich zu hören und zeigt für mich dann persönlich auch den ganz anderen Anspruch der Plattform und auch den Anwendungsbereich.

Alle die keine Server benötigen / Cluster benötigen können mit der Plattform sicherlich effektiv arbeiten.

Alles andere sollte hier doch relativ gesehenen gar nicht oder sehr wenig relevant sein.

Ich muss für Holt oft eine Lanze brechen, da er zwar manchmal etwas zu crass formuliert oder aus den Fundus passende und gezielte Beispiele heraus pickt, aber oft auch (über viele Plattformen) vor allem auch praktische Erfahrungen / Einblicke besitzt, die die meisten gar nicht besitzen können.

Selbst Enterprise Architekten (aus meiner persönlichen Erfahrung) besitzen meistens sehr wenig praktisches (vor allem aktuelles) Wissen und beziehen vieles nur aus der reinen Theorie.

Intel hat(tte) sich viele Jahre lang aus dem WS Segment zurück gezogen und hat viele Standards eingeführt und vor allem über viele vergangen Mainstream Plattformen den Mainboard Herstellern freie Hand gelassen, die BIOS Firmware anzupassen (was Default konfiguriert ist) und damit viele Standards in Bezug auf TPD, PLs etc. brechen lassen.

Je nach Serie und Hersteller kamen da ganz andere Leistungsaufnahmen und Ergebnisse heraus. Ich kann für mich nur sagen, dass auch ich da die Übersicht (jedes Jahr ein neuer Sockel mit eigenen Anpassungen und Eigenheiten) verloren habe.

Bei den OEMs, sieht das ganze in der Regel aber nicht so aus und sorgt dafür, dass die Spezifikationen entweder eingehalten werden, oder genau für das angedachte Einsatzgebiet modifiziert werden (SAP Systeme, DBs, Terminal Server oder halt Workstations für bestimmte Worklaods CAD, Simulationen etc).

Bei Server Cluster ist mittlerweile der HCI Ansatz fast Standard und alles andere wird da eher eine Nische bleiben.

De facto also für mich persönlich legitim, unsere Sicht nicht auf dem eigentlichen OEM Markt zu beziehen oder zu vergleichen.

Alleine die sehr knappe (bisherige) Board Auswahl für den Retail Markt sollte aufzeigen, dass wir diese Plattform nicht allzu häufig hier im Forum finden werden und vor allem die dazugehörigen Workloads.

Interesse hätte ich dazu natürlich, auch wenn ich persönlich die finanziellen Mittel nicht hätte, um damit kein Geld verdienen zu müssen.

Alle die keine Server benötigen / Cluster benötigen können mit der Plattform sicherlich effektiv arbeiten.

Alles andere sollte hier doch relativ gesehenen gar nicht oder sehr wenig relevant sein.

Ich muss für Holt oft eine Lanze brechen, da er zwar manchmal etwas zu crass formuliert oder aus den Fundus passende und gezielte Beispiele heraus pickt, aber oft auch (über viele Plattformen) vor allem auch praktische Erfahrungen / Einblicke besitzt, die die meisten gar nicht besitzen können.

Selbst Enterprise Architekten (aus meiner persönlichen Erfahrung) besitzen meistens sehr wenig praktisches (vor allem aktuelles) Wissen und beziehen vieles nur aus der reinen Theorie.

Intel hat(tte) sich viele Jahre lang aus dem WS Segment zurück gezogen und hat viele Standards eingeführt und vor allem über viele vergangen Mainstream Plattformen den Mainboard Herstellern freie Hand gelassen, die BIOS Firmware anzupassen (was Default konfiguriert ist) und damit viele Standards in Bezug auf TPD, PLs etc. brechen lassen.

Je nach Serie und Hersteller kamen da ganz andere Leistungsaufnahmen und Ergebnisse heraus. Ich kann für mich nur sagen, dass auch ich da die Übersicht (jedes Jahr ein neuer Sockel mit eigenen Anpassungen und Eigenheiten) verloren habe.

Bei den OEMs, sieht das ganze in der Regel aber nicht so aus und sorgt dafür, dass die Spezifikationen entweder eingehalten werden, oder genau für das angedachte Einsatzgebiet modifiziert werden (SAP Systeme, DBs, Terminal Server oder halt Workstations für bestimmte Worklaods CAD, Simulationen etc).

Bei Server Cluster ist mittlerweile der HCI Ansatz fast Standard und alles andere wird da eher eine Nische bleiben.

De facto also für mich persönlich legitim, unsere Sicht nicht auf dem eigentlichen OEM Markt zu beziehen oder zu vergleichen.

Alleine die sehr knappe (bisherige) Board Auswahl für den Retail Markt sollte aufzeigen, dass wir diese Plattform nicht allzu häufig hier im Forum finden werden und vor allem die dazugehörigen Workloads.

Interesse hätte ich dazu natürlich, auch wenn ich persönlich die finanziellen Mittel nicht hätte, um damit kein Geld verdienen zu müssen.

Zuletzt bearbeitet:

blazethelight

Enthusiast

Bin schon ein wenig angefixt von dem Sockel / der Plattform.

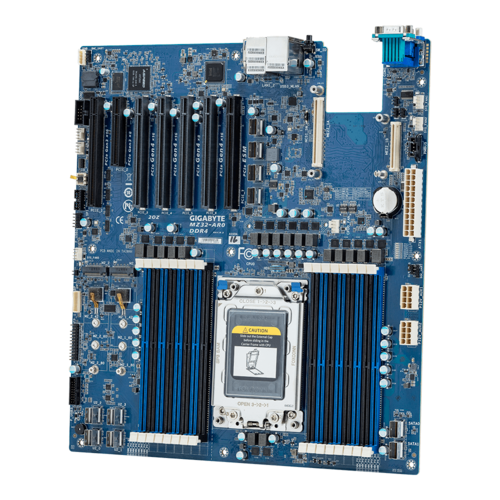

Keine shared / deaktivierte Schnittstellen / WS und bis zu 56 Cores (werden ja auch später wieder günstiger).

Mal schauen wo die Preise in einem oder zwei Jahren liegen...

Aktuell käme man nur für Board (8 Channel) 256 GB RDIMM RAM und 16 Cores bei ca. 5000 € raus.

Natürlich alles noch teuer am Anfang.

Aber wer weiß, vielleicht in einiger Zeit etwas günstiger zu erhalten.

Beispiel:

geizhals.eu

geizhals.eu

geizhals.eu

geizhals.eu

geizhals.eu

geizhals.eu

Weiter so AMD, dann wird Intel gezwungen, die WS sparte weiter auszubauen / günstiger anzubieten. 😉

Keine shared / deaktivierte Schnittstellen / WS und bis zu 56 Cores (werden ja auch später wieder günstiger).

Mal schauen wo die Preise in einem oder zwei Jahren liegen...

Aktuell käme man nur für Board (8 Channel) 256 GB RDIMM RAM und 16 Cores bei ca. 5000 € raus.

Natürlich alles noch teuer am Anfang.

Aber wer weiß, vielleicht in einiger Zeit etwas günstiger zu erhalten.

Beispiel:

ASUS Pro WS W790E-Sage SE ab € 1089,00 (2025) | Preisvergleich Geizhals EU

✔ Preisvergleich für ASUS Pro WS W790E-Sage SE ✔ Produktinfo ⇒ Formfaktor: E-ATX (SSI EEB) • Sockel: Intel 4677 (LGA4677) • Chipsatz: Intel W790 • CPU-Kompatibilität: C… ✔ Intel Xeon ✔ Testberichte ✔ Günstig kaufen

Intel Xeon w5-3435X, 16C/32T, 3.10-4.70GHz, boxed ohne Kühler ab € 1830,00 (2025) | Preisvergleich Geizhals EU

✔ Preisvergleich für Intel Xeon w5-3435X, 16C/32T, 3.10-4.70GHz, boxed ohne Kühler ✔ Produktinfo ⇒ Kerne: 16 (16C) • Threads: 32 • Turbotakt: 4.70GHz (Turbo Boost Max 3.0), 4.50GHz (Turbo Boost 2.0) • Bas… ✔ Intel ✔ Testberichte ✔ Günstig kaufen

Kingston FURY Renegade Pro RDIMM Kit 256GB, DDR5-5600, CL36-38-38 ab € 1129,00 (2025) | Preisvergleich Geizhals EU

✔ Preisvergleich für Kingston FURY Renegade Pro RDIMM Kit 256GB, DDR5-5600, CL36-38-38 ✔ Produktinfo ⇒ Typ: DDR5 RDIMM 288-Pin, reg ECC, on-die ECC • Übertragung: 5600MT/s (5600MHz effektiv - abgeleitet von 2… ✔ Speicher ✔ Testberichte ✔ Günstig kaufen

Weiter so AMD, dann wird Intel gezwungen, die WS sparte weiter auszubauen / günstiger anzubieten. 😉

Holt

Legende

- Mitglied seit

- 05.07.2010

- Beiträge

- 30.398

Ja, der war im Grunde als erster Xeon Workstation Prozessor mit offenem Multi und damit auch für Enthusiasten der Vorgänger dieser ganze X CPUs, zumindest wenn es um den Einsatz bei Enthusiasten geht. Die Verbreitung unter diese Zielgruppe dürfte wohl auch diesmal ähnlich bescheiden bleiben, denn im Grund bieten die Mainstream Plattformen inzwischen genug und da SLI tot ist, werden mehrere Grakas in einem Rechner eigentlich nur noch bei GPU Computing verwendet. Anspruchsvolle Gamer die sich früher die HEDT Plattform geholt haben um da beiden Grakas in ihrem SLI Verband voll anbinden zu können, werden hier kaum zugreifen, spätestens nachdem sie die Ergebnisse der Spieletest in diesem Review gelesen haben.Ich finde es schade, das kein Xeon W-3175x mit im Vergleich ist

Was meinst Du konkret? Es werden doch sogar unterschiedliche RAM Geschwindigkeiten gebencht.Was mich irritiert, ist die nicht im Artikel erwähnte reg. ECC RDIMMs Möglichkeit?

Das ist das eigentliche Problem für so ein System, denn wie viele Leute würden sich sowas kaufen und wie viele, gerade in den Firmen, werden sowieso Server haben, ggf. in Form gemieteter Cloudserver und die rechenintensiven Aufgabe dann dorthin auslagern? Wie viele Anwendungen gibt es noch für Workstations mit sehr hohen Multithreadperformance?Alle die keine Server benötigen / Cluster benötigen

blazethelight

Enthusiast

@Holt:

Jau hatte mich da schwer vertan beim Lesen des Artikels.

Sind alles RDIMMs (auch laut Homepage der Mobos).

Ich selbst habe bis auf VMs keine (produktive) Anwendung, welche bei mir die 36 Cores / 72 Threads wirklich auslasten kann.

Jedoch bin auch froh darüber, sonst könnte ich das System auch währenddessen für nichts anderes mehr nutzen (zocken etc.). 😉

Ist es hier auch der Fall, dass die Frequenz ab einer bestimmten Menge an RDIMMs Bestückung verringert wird (Speichercontroller Limitierung) und die Latenzen erhöht werden müssen ?

Wie sieht das bei WRx80 dazu aus?

Weiß das jemand?

Bezüglich das die Desktop Plattformen genug bieten, kann man so sehen.

Aber auch nur in Bezug auf die CPU Core Anzahl.

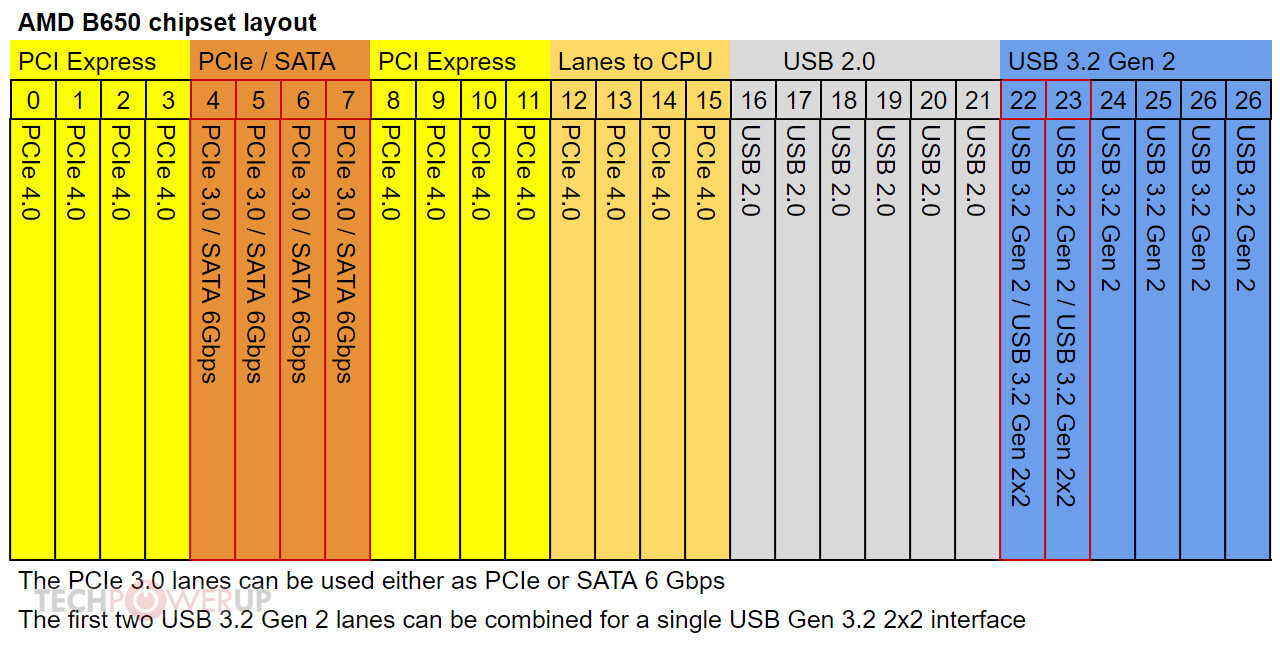

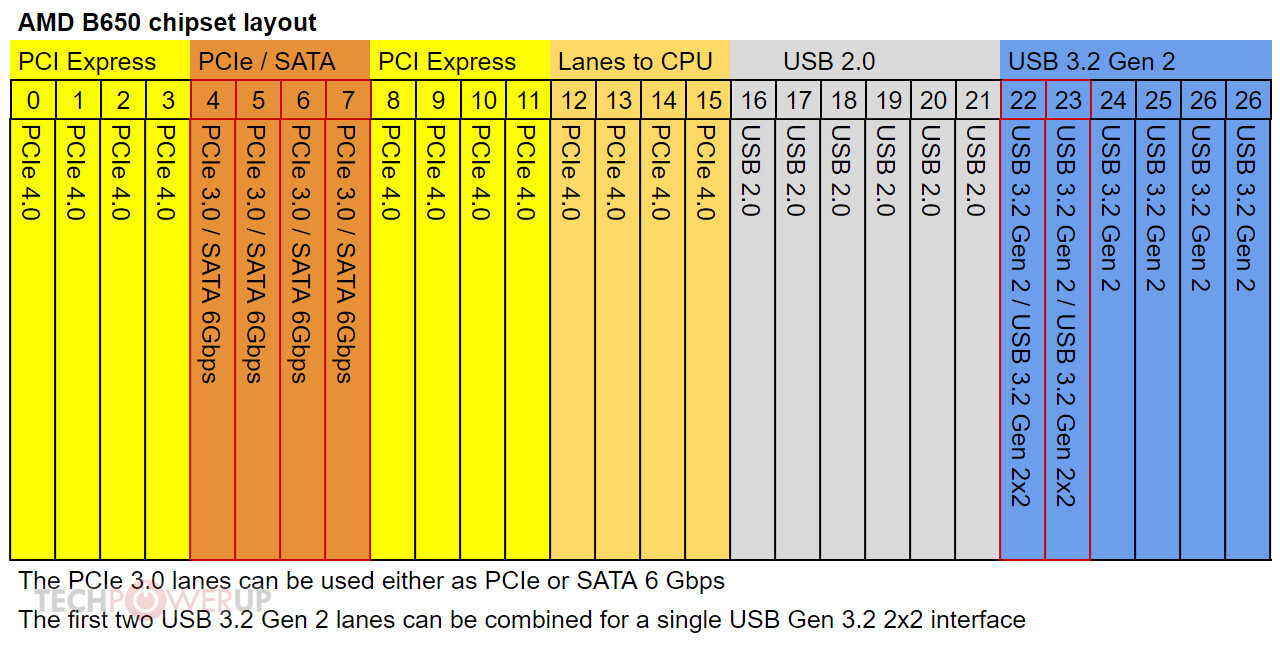

Mehr aber auch nicht (selbst wenn die Lanes Dank AMD Push erhöht worden sind - wurde bei Intel oft nur der DMI aufgebohrt im Desktop Segment)!

Für mich bleibt der GAP der Plattformen ein Problem / hindert mich persönlich zu einer Neuanschaffung / Wechsel von 10 Jahren alter Hardware zu einer neuen soliden Plattform, welche gut reifen darf...

Ich ärgere mich nur sehr oft darüber, dass die Anbindung der Lanes bei der Vollbestücking nicht mehr transparent angegeben wird (M.2s, PCIe Beschleunigerkarten, 10 GBit Netzwerkkarten und vor allem M.2. Erweiterungskarten).

Da rufen Hersteller über 1000 € für ein MSI AM5 Godlike auf, und dann werden Schnittstellen nach und nach geteilt und deaktiviert, wenn diese mit voller Bandbreite bestückt werden würden (Hauptsache 4 M.2.s und Erweiterungskarte sind vorhanden, dass die Lanes des Chipsatzes & der CPU dann schon aufgebraucht sind, soll da nicht ins Gewicht fallen?).

Selbst SATA 6 GB Schnittstellen werden dann teilweise deaktiviert dafür.

Ganz tolle Idee bei nem System, was als Beispiel Hypervisor spielen / könnte / dürfte im Homelab mit ZFS / Cache und man trotzdem mal ne Runde daddeln / Content Creation / Simulationen ausführen möchte.

Früher stand das bei Geizhals.eu dabei.

Mittlerweile nur noch im Handbuch.

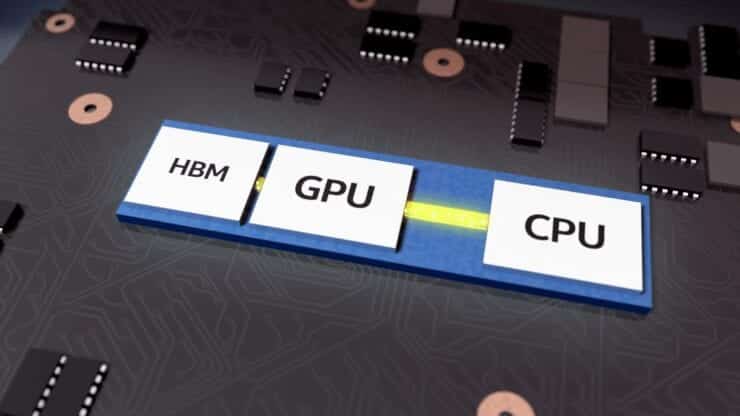

Weiß jemand, ob wir auch die CPUs mit HBM2(e) zu Gesicht bekommen werden oder sind die nur für dem OEM Markt bestimmt?

@dbode:

Ansonsten hätte ich auch gerne die CPUs mit weniger Kernen (16) im "Spieletest" gesehen, denke die schneiden da wegen dem weitaus höheren Basis Takt (3.0 GHz) ein wenig besser ab.

Dabei könntest du (falls der die 56 Core CPU wirklich HBM2e on die hätte) dazu einen Vergleich ziehen können je nach Workload (Core Anzahl auf 16 per BIOS beschränken und je nach Lust und Laune auch den Takt normalisieren).

Auch aktuelle SPEC Benches wäre bei der Plattform schon ganz schön gewesen: https://www.spec.org/benchmarks.html

Aber toll, dass du den Speichertest dabei hattest! 👍

Auch toll, das du das Thema Abwärme, Leistungsaufnahme (auch idle) und OC beleuchtet hast. Top!

Trotzdem hätte ich gerne mal die Themen Vollbestückung des RAMs (was passiert dann laut z.B. AIDA RAM Benches ), CPU Latenzen (sind doch auch Chiplets oder?), Vollbestückung der PCIe Lanes (wie ist dann was noch wie noch angebunden inkl. Auswirkung, wenn man klotzt via M.2 Erweiterungskarte mit 4 - 6 Stück M2280er voll angebunden via PCIe 5.0 x4 inkl. Augenmerk auf das Lane Splitting und vor allem was passiert dann mit den internen 2 M.2 Schnittstellen, welche direkt an der CPU angebunden sind!), PCIe 4.0 x4 10 GBit 4 Port Intel Network Controller, ein paar PCIe 4.0 x 16 Nvidia HPC GPUs zur eigentlichen High End GPU etc.).

Auch der BMC / IPMI wird oft nicht geprüft. Schade.

Dafür sollte so eine Plattform doch auch sein?!

Bei Pudget Systems haben die bis auf den 16 Kerner mit Pre Release Saphire Rapids WS CPUs ein paar "Content Creations" Benches hinterlegt.

www.pugetsystems.com

www.pugetsystems.com

(Aber da fehlen natürlich diverse Speicherintensive Worklaods).

30 % schneller ist gar nicht schlecht (im Gegensatz zum Vorgänger).

Dafür, daß Intel so große Probleme besaß mit der Serie... 😉

Natürlich gräbt Intel den weitaus älteren AMD Zen 3 (Threadstripper 5000 Pro) TRs noch immer noch nicht die Kunden weg (höchstens im Schnittstellenbereich / Speicherintensiven Workloads / alle welche RDIMMs bevorzugen).

Die neuen TRs könnten ja auch noch als Antwort folgen...

Dort sollte AMD wirklich mal langsam (m.E.) RDIMMs nicht nur erlauben / unterstützen, sondern auch validieren!

Sonst geht das blinde Kuh Spiel da auch so weiter.

Jeder der behauptet, dass On Die ECC bei dem DDR5 Desktop Plattformen ausreichend würde, sollte sich dann vorab informieren und dann selbst entscheiden, ob er es bei DDR5 benötigt oder auch nicht:

An dieser Stelle möchten wir Ihnen ein Youtube-Video zeigen. Ihre Daten zu schützen, liegt uns aber am Herzen: Youtube setzt durch das Einbinden und Abspielen Cookies auf ihrem Rechner, mit welchen sie eventuell getracked werden können. Wenn Sie dies zulassen möchten, klicken Sie einfach auf den Play-Button. Das Video wird anschließend geladen und danach abgespielt.

Youtube Videos ab jetzt direkt anzeigen

Ich selbst habe seit reg. ECC RDIMMs (DDR4) so gut wie keine WHEAs oder Datenverlust / Datenkorruptionen mehr (Media Archive).

Das "First World Problem" / Dilemma habe ich einfach bei den TR Plattformen...

Mal soll je nach Board Hersteller OC und RDIMMs funktionieren, mal nicht.

Auch das die geringeren Core Counts nur für OEMs verkauft worden sind, ist einfach dumm, wenn man als Kunde mit der WRx40 oder WRx80 liebäugelt aber halt keine 24 Cores (oder mehr) benötigt oder vorerst nicht (be-) zahlen möchte.

Dann halt nicht AMD!

Läuft das bei den TR Plattformen auch so, dass die AGESA Updates ziemlich viel (sehe in Foren viele dann das OC danach erneuern^^) verbessern / verändern / reifen lassen analog zum Desktop (AM4, AM5)?

Wer keine High Count Workloads besitzt, hat höchstens Spaß an der eigentlichen Plattform (wie persönlich ich selbst hätte, so oft konvertierte ich auch keine 4K HDR Videos, aber wenn, dann gerne per Software ~ via CPUs und freue mich darüber, währenddessen noch daddeln zu können. Auch die Zuverlässigkeit und längerer Support, RDIMMs etc. werden mich nicht mehr zu einem Desktop Sockel verführen können... ).

Diese Zusammenfassung erklärt es (das Plattform Dilemma) m.E. ganz gut: https://biz.crast.net/amd-threadripper-pro-5995wx-and-5975wx-review-sheer-threaded-dominance/

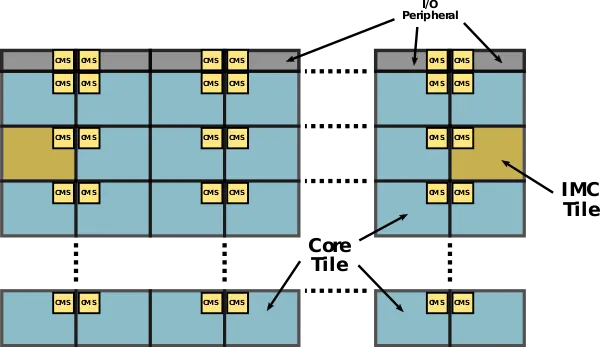

PS. Laut dem älteren HWLuxx Artikel zu der Vorstellung zu Saphire Rapids hätte im WS Segment nur die 56 Core CPU HBM2e dabei (on die?) oder ist damit nur der Server / HPC Bereich gemeint, da dort der HBM2e den eigentlichen RAM ersetzen kann (wahrscheinlich sowohl als auch oder?) ?

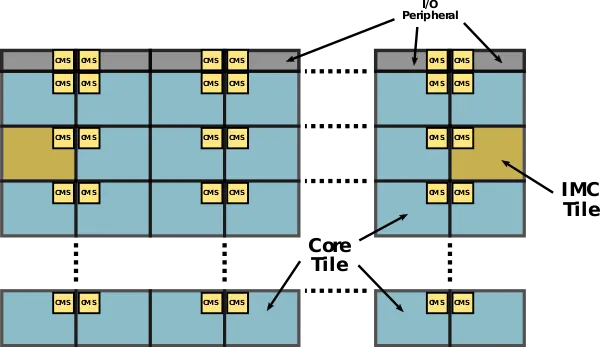

Auszug:

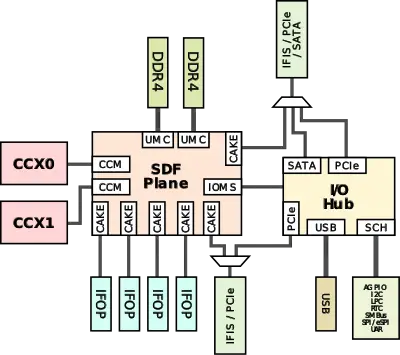

Vergleich der Packages für Sapphire Rapids

Quelle:

www.hardwareluxx.de

www.hardwareluxx.de

Jau hatte mich da schwer vertan beim Lesen des Artikels.

Sind alles RDIMMs (auch laut Homepage der Mobos).

Ich selbst habe bis auf VMs keine (produktive) Anwendung, welche bei mir die 36 Cores / 72 Threads wirklich auslasten kann.

Jedoch bin auch froh darüber, sonst könnte ich das System auch währenddessen für nichts anderes mehr nutzen (zocken etc.). 😉

Ist es hier auch der Fall, dass die Frequenz ab einer bestimmten Menge an RDIMMs Bestückung verringert wird (Speichercontroller Limitierung) und die Latenzen erhöht werden müssen ?

Wie sieht das bei WRx80 dazu aus?

Weiß das jemand?

Bezüglich das die Desktop Plattformen genug bieten, kann man so sehen.

Aber auch nur in Bezug auf die CPU Core Anzahl.

Mehr aber auch nicht (selbst wenn die Lanes Dank AMD Push erhöht worden sind - wurde bei Intel oft nur der DMI aufgebohrt im Desktop Segment)!

Für mich bleibt der GAP der Plattformen ein Problem / hindert mich persönlich zu einer Neuanschaffung / Wechsel von 10 Jahren alter Hardware zu einer neuen soliden Plattform, welche gut reifen darf...

Ich ärgere mich nur sehr oft darüber, dass die Anbindung der Lanes bei der Vollbestücking nicht mehr transparent angegeben wird (M.2s, PCIe Beschleunigerkarten, 10 GBit Netzwerkkarten und vor allem M.2. Erweiterungskarten).

Da rufen Hersteller über 1000 € für ein MSI AM5 Godlike auf, und dann werden Schnittstellen nach und nach geteilt und deaktiviert, wenn diese mit voller Bandbreite bestückt werden würden (Hauptsache 4 M.2.s und Erweiterungskarte sind vorhanden, dass die Lanes des Chipsatzes & der CPU dann schon aufgebraucht sind, soll da nicht ins Gewicht fallen?).

Selbst SATA 6 GB Schnittstellen werden dann teilweise deaktiviert dafür.

Ganz tolle Idee bei nem System, was als Beispiel Hypervisor spielen / könnte / dürfte im Homelab mit ZFS / Cache und man trotzdem mal ne Runde daddeln / Content Creation / Simulationen ausführen möchte.

Früher stand das bei Geizhals.eu dabei.

Mittlerweile nur noch im Handbuch.

Weiß jemand, ob wir auch die CPUs mit HBM2(e) zu Gesicht bekommen werden oder sind die nur für dem OEM Markt bestimmt?

@dbode:

Ansonsten hätte ich auch gerne die CPUs mit weniger Kernen (16) im "Spieletest" gesehen, denke die schneiden da wegen dem weitaus höheren Basis Takt (3.0 GHz) ein wenig besser ab.

Dabei könntest du (falls der die 56 Core CPU wirklich HBM2e on die hätte) dazu einen Vergleich ziehen können je nach Workload (Core Anzahl auf 16 per BIOS beschränken und je nach Lust und Laune auch den Takt normalisieren).

Auch aktuelle SPEC Benches wäre bei der Plattform schon ganz schön gewesen: https://www.spec.org/benchmarks.html

Aber toll, dass du den Speichertest dabei hattest! 👍

Auch toll, das du das Thema Abwärme, Leistungsaufnahme (auch idle) und OC beleuchtet hast. Top!

Trotzdem hätte ich gerne mal die Themen Vollbestückung des RAMs (was passiert dann laut z.B. AIDA RAM Benches ), CPU Latenzen (sind doch auch Chiplets oder?), Vollbestückung der PCIe Lanes (wie ist dann was noch wie noch angebunden inkl. Auswirkung, wenn man klotzt via M.2 Erweiterungskarte mit 4 - 6 Stück M2280er voll angebunden via PCIe 5.0 x4 inkl. Augenmerk auf das Lane Splitting und vor allem was passiert dann mit den internen 2 M.2 Schnittstellen, welche direkt an der CPU angebunden sind!), PCIe 4.0 x4 10 GBit 4 Port Intel Network Controller, ein paar PCIe 4.0 x 16 Nvidia HPC GPUs zur eigentlichen High End GPU etc.).

Auch der BMC / IPMI wird oft nicht geprüft. Schade.

Dafür sollte so eine Plattform doch auch sein?!

Bei Pudget Systems haben die bis auf den 16 Kerner mit Pre Release Saphire Rapids WS CPUs ein paar "Content Creations" Benches hinterlegt.

Intel Xeon W-3400 Content Creation Preview

Intel has announced their latest Xeon processor families, including the W-2400 and W-3400 lines. While there is still several months to go before the sales embargo, we are able to give a preview of how these processors perform in various content creation applications.

www.pugetsystems.com

www.pugetsystems.com

(Aber da fehlen natürlich diverse Speicherintensive Worklaods).

30 % schneller ist gar nicht schlecht (im Gegensatz zum Vorgänger).

Dafür, daß Intel so große Probleme besaß mit der Serie... 😉

Natürlich gräbt Intel den weitaus älteren AMD Zen 3 (Threadstripper 5000 Pro) TRs noch immer noch nicht die Kunden weg (höchstens im Schnittstellenbereich / Speicherintensiven Workloads / alle welche RDIMMs bevorzugen).

Die neuen TRs könnten ja auch noch als Antwort folgen...

Dort sollte AMD wirklich mal langsam (m.E.) RDIMMs nicht nur erlauben / unterstützen, sondern auch validieren!

Sonst geht das blinde Kuh Spiel da auch so weiter.

Jeder der behauptet, dass On Die ECC bei dem DDR5 Desktop Plattformen ausreichend würde, sollte sich dann vorab informieren und dann selbst entscheiden, ob er es bei DDR5 benötigt oder auch nicht:

Datenschutzhinweis für Youtube

An dieser Stelle möchten wir Ihnen ein Youtube-Video zeigen. Ihre Daten zu schützen, liegt uns aber am Herzen: Youtube setzt durch das Einbinden und Abspielen Cookies auf ihrem Rechner, mit welchen sie eventuell getracked werden können. Wenn Sie dies zulassen möchten, klicken Sie einfach auf den Play-Button. Das Video wird anschließend geladen und danach abgespielt.

Youtube Videos ab jetzt direkt anzeigen

Ich selbst habe seit reg. ECC RDIMMs (DDR4) so gut wie keine WHEAs oder Datenverlust / Datenkorruptionen mehr (Media Archive).

Das "First World Problem" / Dilemma habe ich einfach bei den TR Plattformen...

Mal soll je nach Board Hersteller OC und RDIMMs funktionieren, mal nicht.

Auch das die geringeren Core Counts nur für OEMs verkauft worden sind, ist einfach dumm, wenn man als Kunde mit der WRx40 oder WRx80 liebäugelt aber halt keine 24 Cores (oder mehr) benötigt oder vorerst nicht (be-) zahlen möchte.

Dann halt nicht AMD!

Läuft das bei den TR Plattformen auch so, dass die AGESA Updates ziemlich viel (sehe in Foren viele dann das OC danach erneuern^^) verbessern / verändern / reifen lassen analog zum Desktop (AM4, AM5)?

Wer keine High Count Workloads besitzt, hat höchstens Spaß an der eigentlichen Plattform (wie persönlich ich selbst hätte, so oft konvertierte ich auch keine 4K HDR Videos, aber wenn, dann gerne per Software ~ via CPUs und freue mich darüber, währenddessen noch daddeln zu können. Auch die Zuverlässigkeit und längerer Support, RDIMMs etc. werden mich nicht mehr zu einem Desktop Sockel verführen können... ).

Diese Zusammenfassung erklärt es (das Plattform Dilemma) m.E. ganz gut: https://biz.crast.net/amd-threadripper-pro-5995wx-and-5975wx-review-sheer-threaded-dominance/

PS. Laut dem älteren HWLuxx Artikel zu der Vorstellung zu Saphire Rapids hätte im WS Segment nur die 56 Core CPU HBM2e dabei (on die?) oder ist damit nur der Server / HPC Bereich gemeint, da dort der HBM2e den eigentlichen RAM ersetzen kann (wahrscheinlich sowohl als auch oder?) ?

Auszug:

Vergleich der Packages für Sapphire Rapids

| Kerne | UPIs | PCIe | Speicherkanäle | Chipgröße | EMIB-Verbindungen | |

| XCC-Package | 60 | 4 | 5x 16 Lanes | 8x DDR5 | 4x 400 mm² | 10 |

| MCC-Package | 32 | 3 | 5x 16 Lanes | 8x DDR5 | ? | keine |

| XCC-HBM-Package | 56 | 4 | 5x 16 Lanes | 8x DDR5 + 4x HBM2e | 4x 400 mm² | 14 |

Quelle:

Nach vielen Verspätungen nun offiziell: Sapphire Rapids kommt mit vielen Beschleunigern - Hardwareluxx

Nach vielen Verspätungen nun offiziell: Sapphire Rapids kommt mit vielen Beschleunigern.

Zuletzt bearbeitet:

n3cron

Enthusiast

- Mitglied seit

- 13.05.2020

- Beiträge

- 6.520

- Ort

- DE - BY - MILF

- Details zu meinem Desktop

- Prozessor

- Intel Core i7 13700K 16 (8+8) 3.40GHz So.1700

- Mainboard

- MSI Tomahawk WIFI Intel Z790 So. 1700

- Kühler

- be quiet! Silent Loop 2 360mm All-in-One

- Speicher

- 64GB (2x 32GB) G.Skill Ripjaws S5 weiss DDR5-5600 DIMM CL28

- Grafikprozessor

- Gigabyte Nvidia RTX 3080 Gaming OC 10G

- Display

- Xiaomi Mi Curved Gaming Monitor 34" 144hz@ UWQHD 3440*1440

- SSD

- Samsung 990Pro 2 TB, Samsung 970 Evo Plus M.2 2280 PCIe 3.0 x4 3D-NAND TLC

- Opt. Laufwerk

- -

- Soundkarte

- -

- Gehäuse

- be quiet! Silent Base 802

- Netzteil

- 750 Watt be quiet! Dark Power 13 Modular 80+ Titanium

- Betriebssystem

- Windows 11 Pro

- Internet

- ▼950 Mbit ▲600 Mbit

@blazethelight

Bei AMD ist es eher abhängig vom Board. Alle CPUs ab "Zen3" unterstützen grundsätzlich ECC und sind ECC kompatibel. Aber unbuffert.

Ich hab mir in der Arbeit als Budget VM Host ein Asus Pro WS X570-ACE geschnappt und ein Ryzen Pro 5750G draufgepackt gepaart mit Kingston 3200er CL22 2x32 GB ECC RAM Sticks. (QVL von ASUS).

Mit Zen3 ist das recht flott und für die überwiegenden Szenarios sogar ausreichend um Dinge zu testen.

Bei AMD ist es eher abhängig vom Board. Alle CPUs ab "Zen3" unterstützen grundsätzlich ECC und sind ECC kompatibel. Aber unbuffert.

Ich hab mir in der Arbeit als Budget VM Host ein Asus Pro WS X570-ACE geschnappt und ein Ryzen Pro 5750G draufgepackt gepaart mit Kingston 3200er CL22 2x32 GB ECC RAM Sticks. (QVL von ASUS).

Mit Zen3 ist das recht flott und für die überwiegenden Szenarios sogar ausreichend um Dinge zu testen.

blazethelight

Enthusiast

@n3cron:

Danke dir.

Genau das meine ich aber auch damit.

Als die (ersten) TR Plattformen noch relativ neu waren, stand das sehr oft in Frage und war selbst bei dem Mainboard Herstellern nicht dokumentiert.

Erst nach und nach (bzw. ab der WRx40 oder WRx80 wurde das auch wirklich / spätestens dokumentiert) konnten nur praktische Erfahrungen das Thema genauer beleuchten / bestätigen.

Man kann natürlich auch sagen, dann musst du dir halt für viel Geld eine OEM Fertig Plattform erwerben, wer damit aber kein Geld verdient und den dazugehörigen Support nicht benötigt (und das vor allem steuerlich nicht absetzen kann!), ist letztendlich aufgeschmissen gewesen.

Deswegen freue ich mich, wenn Intel wieder ernsthafte Schritte unternimmt, im WS Segment (DIY) ein wenig mehr mit zu mischen und AMD nicht völlig davon laufen lässt (Konkurrenz tut uns allen immer gut). Vor allem, wenn es eine Plattform ist, welche dir in vielen Enterprise Standards Garantien geben kann.

Und machen wir uns auch nichts vor.

Jeder Hersteller, welcher aktuell (über die letzten Jahre) die Bereiche dominieren kann, gewinnt auch beim Windows OS in Bezug auf Optimierungen von Software Anpassungen (Patches / Optimierungen) bei den üblichen Workloads.

Der längste Balken, gewinnt bei mir meist nicht. Sondern die solide / zuverlässige Plattform und das Feature Set.

Danke dir.

Genau das meine ich aber auch damit.

Als die (ersten) TR Plattformen noch relativ neu waren, stand das sehr oft in Frage und war selbst bei dem Mainboard Herstellern nicht dokumentiert.

Erst nach und nach (bzw. ab der WRx40 oder WRx80 wurde das auch wirklich / spätestens dokumentiert) konnten nur praktische Erfahrungen das Thema genauer beleuchten / bestätigen.

Man kann natürlich auch sagen, dann musst du dir halt für viel Geld eine OEM Fertig Plattform erwerben, wer damit aber kein Geld verdient und den dazugehörigen Support nicht benötigt (und das vor allem steuerlich nicht absetzen kann!), ist letztendlich aufgeschmissen gewesen.

Deswegen freue ich mich, wenn Intel wieder ernsthafte Schritte unternimmt, im WS Segment (DIY) ein wenig mehr mit zu mischen und AMD nicht völlig davon laufen lässt (Konkurrenz tut uns allen immer gut). Vor allem, wenn es eine Plattform ist, welche dir in vielen Enterprise Standards Garantien geben kann.

Und machen wir uns auch nichts vor.

Jeder Hersteller, welcher aktuell (über die letzten Jahre) die Bereiche dominieren kann, gewinnt auch beim Windows OS in Bezug auf Optimierungen von Software Anpassungen (Patches / Optimierungen) bei den üblichen Workloads.

Der längste Balken, gewinnt bei mir meist nicht. Sondern die solide / zuverlässige Plattform und das Feature Set.

Zuletzt bearbeitet:

- Mitglied seit

- 18.02.2005

- Beiträge

- 5.952

Threadripper konnten immer ECC und AMD hat das so auch kommuniziert. Ich habe/hatte übrigens alle Generationen bis auf die aktuelle - die ist für mich wenig attraktiv - da hab ich EPYCs gekauft. Gen1 - 2 hatten immer UDIMMs. Bei Gen3 heben die ohne "Pro" UDIMMs und die mit "Pro" RDIMMs, ebenso können die aktuelle "Pro Threadripper nur RDIMMs.

blazethelight

Enthusiast

@Kullberg:

Wie sieht es da je nach Jahr / Zen / Epyc Variante die Vollbestückung des DRAMs aus bzw. über 8 DIMMs?

In Bezug, ob die Frequenzen verringert werden und die Timings nach oben korrigiert werden.

Gibt das dann der SOC vor oder wird das immer via JEDEC Spezifikation klassifiziert?

PS. AMD hatte das wirklich immer dokumentiert, aber die Mainboard Hersteller am Anfang oft nicht... So war das gemeint von mir.

Unbuffered DIMMs werden halt etwas langsamer sein als registered ECC.

Wieviel das dann wirklich ausmacht (je nach Variante) ist mir persönlich nicht bekannt.

Wie sieht es da je nach Jahr / Zen / Epyc Variante die Vollbestückung des DRAMs aus bzw. über 8 DIMMs?

In Bezug, ob die Frequenzen verringert werden und die Timings nach oben korrigiert werden.

Gibt das dann der SOC vor oder wird das immer via JEDEC Spezifikation klassifiziert?

PS. AMD hatte das wirklich immer dokumentiert, aber die Mainboard Hersteller am Anfang oft nicht... So war das gemeint von mir.

Unbuffered DIMMs werden halt etwas langsamer sein als registered ECC.

Wieviel das dann wirklich ausmacht (je nach Variante) ist mir persönlich nicht bekannt.

Zuletzt bearbeitet:

- Mitglied seit

- 18.02.2005

- Beiträge

- 5.952

Sowohl das hier im Test besprochene Mobo (das ACE) als auch alle meine EPYC Mobos und mein dual Xeon So. 4189 haben nur 1 DIMM per Speicherkanal. Von daher wird die Frequenz nicht irgendwie gesenkt. Meine Erfahrung sowohl mit EPYCs als auch So. 4189 Xeon ist, dass man alle (8 pro CPU) Speicherkanäle bestücken sollte für beste Performance. Bei E5 26**v4 Xeons war das noch nicht so. Zumindest bei meinen Anwendungen.

Unbuffered DIMMs sind eher schneller als RDIMMs - der Unterschied ist aber minimal. Bei RDIMMs können prinzipiell mehr DIMMs pro Speicherkanal genutzt werden, wenn aber nur 1 DIMM Sockel pro Kanal vorhanden ist, macht das nichts aus.

Unbuffered DIMMs sind eher schneller als RDIMMs - der Unterschied ist aber minimal. Bei RDIMMs können prinzipiell mehr DIMMs pro Speicherkanal genutzt werden, wenn aber nur 1 DIMM Sockel pro Kanal vorhanden ist, macht das nichts aus.

blazethelight

Enthusiast

@Kullberg:

Meine auch eigentlich, bei allgemeiner nahezu Vollbestückung des DRAMs auf AMD TRs und EPYC Plattformen (würde mal selbst vermuten, dass auf einen Epyc Server Sockel, sowas eher nicht mehr passieren würde).

Nicht ob man soweit passend auffüllen würde, um Quad oder Okta Channel überhaupt zu erhalten (das sollte klar sein).

Bei mir passiert das halt bei dem alten C612 Chipsatz / E-5 v3 und v4 CPU Serie.

Ob das vielleicht allgemein bei Multi-Socket Systemen eher ein Thema sein könnte, weiß ich aktuell auch nicht (Hast du einen Epyc System mit mehr als einen Socket im praktischen Einsatz?).

Daher meine Frage, ob es hier ganz allgemein eher der JEDEC Standard so vorsieht, oder in meinen praktischen / veralteten Beispiel Fall der Mainboard Hersteller (ASUS) hier einfach eingreift.

Im Fall von UDIMM ECC vs RDIMM ECC besteht in der grauen Theorie ja nur der Unterschied (vermutet nun von mir - das es nur im Falle einer nötigen Fehlerkorrektur passieren könnte) das ein zusätzlicher Chip mit allen anderen DRAM Chips kommuniziert, anstatt die CPU mit jeden Chip einzeln kommunizieren muss.

Daher sollte das schneller sein?!

Das UDIMM allgemein schneller arbeitet inkl. höher Frequenzen (je nach dem) und geringeren Latenzen im Gegensatz zu RDIMMs, stand gar nicht für mich in Frage, da die fehlende Fehler - Erkennung und Fehler - Korrektur natürlich länger dauert als gar keine oder bei DDR5 (Mainstream Sockel) "nur" On Die anstatt End To End .

Dazu kommt es ja noch, dass die genutzte Variante der Fehlerkorrekturen (8 Bit / 16 Bit / etc.) je nach Mainboard / DRAM und Hersteller eine ganz andere sein kann, welche überhaupt unterstützt wird (zumindesten weiß ich das bei DDR4 L/RDIMM)...

Bei allen Fragen und Themen, freue ich mich einfach auf den Austausch dazu und den dazugehörigen praktischen Erfahrungen von euch! 👍

Danke bisher schon an euch.

Hoffe das geht so weiter.

Meine auch eigentlich, bei allgemeiner nahezu Vollbestückung des DRAMs auf AMD TRs und EPYC Plattformen (würde mal selbst vermuten, dass auf einen Epyc Server Sockel, sowas eher nicht mehr passieren würde).

Nicht ob man soweit passend auffüllen würde, um Quad oder Okta Channel überhaupt zu erhalten (das sollte klar sein).

Bei mir passiert das halt bei dem alten C612 Chipsatz / E-5 v3 und v4 CPU Serie.

Ob das vielleicht allgemein bei Multi-Socket Systemen eher ein Thema sein könnte, weiß ich aktuell auch nicht (Hast du einen Epyc System mit mehr als einen Socket im praktischen Einsatz?).

Daher meine Frage, ob es hier ganz allgemein eher der JEDEC Standard so vorsieht, oder in meinen praktischen / veralteten Beispiel Fall der Mainboard Hersteller (ASUS) hier einfach eingreift.

Im Fall von UDIMM ECC vs RDIMM ECC besteht in der grauen Theorie ja nur der Unterschied (vermutet nun von mir - das es nur im Falle einer nötigen Fehlerkorrektur passieren könnte) das ein zusätzlicher Chip mit allen anderen DRAM Chips kommuniziert, anstatt die CPU mit jeden Chip einzeln kommunizieren muss.

Daher sollte das schneller sein?!

Das UDIMM allgemein schneller arbeitet inkl. höher Frequenzen (je nach dem) und geringeren Latenzen im Gegensatz zu RDIMMs, stand gar nicht für mich in Frage, da die fehlende Fehler - Erkennung und Fehler - Korrektur natürlich länger dauert als gar keine oder bei DDR5 (Mainstream Sockel) "nur" On Die anstatt End To End .

Dazu kommt es ja noch, dass die genutzte Variante der Fehlerkorrekturen (8 Bit / 16 Bit / etc.) je nach Mainboard / DRAM und Hersteller eine ganz andere sein kann, welche überhaupt unterstützt wird (zumindesten weiß ich das bei DDR4 L/RDIMM)...

Bei allen Fragen und Themen, freue ich mich einfach auf den Austausch dazu und den dazugehörigen praktischen Erfahrungen von euch! 👍

Danke bisher schon an euch.

Hoffe das geht so weiter.

Zuletzt bearbeitet:

- Mitglied seit

- 18.02.2005

- Beiträge

- 5.952

Deine Vorstellungen von RDIMMs stimmen nicht - eine Erklärung ist hier.

Ich hab im letzten Jahr 5 EPYC Systeme mit je 2 CPUs gebaut, 2 Rechner mit 7T83, 1 mit 7642, 1 mit 7H12 und 1 mit 7763. 3 davon sind produktiv im Einsatz, 2 sind z.Zt. ausgeschaltet. Bei allen sind alle Speicherkanäle (also je 16) bestückt.

Ich hab im letzten Jahr 5 EPYC Systeme mit je 2 CPUs gebaut, 2 Rechner mit 7T83, 1 mit 7642, 1 mit 7H12 und 1 mit 7763. 3 davon sind produktiv im Einsatz, 2 sind z.Zt. ausgeschaltet. Bei allen sind alle Speicherkanäle (also je 16) bestückt.

blazethelight

Enthusiast

Damit sollte es mir nun dank dir klar sein, dass es auf TR / Epyc Sockeln / der / den aktuellen Xeon Plattform/en nicht mehr passiert oder halt bei mir eine Eigenheit des Herstellers des Mainboards oder Chipsatzes - ggfls. des bei mir persönlich gemischten reg. DDR4 RDIMMs ist (2x unterschiedliche JEDEC Standards - auch wenn das bei mir auch bei identischen JEDECs auch aufgetaucht war / ist) .

Da genügt mir an sich natürlich schon. Vielen Dank für deine praktischen Erfahrungen dazu.

Vielleicht kleine Anmerkung.

Wikipedia ist eine feine Sache.

Aber in diesem Bezug ist nicht nur Wikipedia veraltet sondern selbst das Elektronik Kompendium (das ich persönlich für Grundlagen oft als gelungenen erachte.)

Bezüglich meiner Aussage, dass RDIMM ECC eigentlich schneller sein könnte oder sollte als UDIMM ECC, muss ich das nun auf "kommt drauf an" vermutlich korrigieren.

Mal wieder für wesentlich bessere Verständnisgrundlagen, bietet sich Serve the Home als Quelle an (selbst der Artikel ist alt - von Intel oder Kingston selbst gab es nur aktuelle Informationen von On die ECC vs RDIMM ECC in Bezug auf DDR5) :

www.servethehome.com

www.servethehome.com

Auch wenn vielleicht in der Virtualisierung nur wirklich relevant.

Und ja, ich lerne immer gerne dazu.

Auszüge:

Basics:

The basic difference is that memory commands in unbuffered memory configurations go directly from the controller to the memory module, while in registered memory configurations the commands are sent first to the memory banks’ registers prior to being sent to the modules. This concept may sound difficult, but here is the very simple/ conceptual view regarding what is going on.

UDIMM:

In the above example the memory controller accesses the memory banks directly. The above assumes that the memory controller resides within the CPU package as it does in modern CPU architectures. Looking at older systems, the memory controller resided within the CPU northbridge. Compare this to the registered memory example below.

RDIMM:

Here the CPU communicates with the registers for the banks of memory on each module. From there, these registers communicate with the DRAM. The implications of this are twofold. First, on a negative side, instructions take approximately one CPU cycle longer due to the intermediary of the bank register. On the positive side, this buffering reduces the strain on the CPU’s memory controller because it points to the dedicated intermediary register versus accessing the DRAM directly. It is easier on the memory controller to deal with a fewer number of targets.

Da genügt mir an sich natürlich schon. Vielen Dank für deine praktischen Erfahrungen dazu.

Vielleicht kleine Anmerkung.

Wikipedia ist eine feine Sache.

Aber in diesem Bezug ist nicht nur Wikipedia veraltet sondern selbst das Elektronik Kompendium (das ich persönlich für Grundlagen oft als gelungenen erachte.)

Bezüglich meiner Aussage, dass RDIMM ECC eigentlich schneller sein könnte oder sollte als UDIMM ECC, muss ich das nun auf "kommt drauf an" vermutlich korrigieren.

Mal wieder für wesentlich bessere Verständnisgrundlagen, bietet sich Serve the Home als Quelle an (selbst der Artikel ist alt - von Intel oder Kingston selbst gab es nur aktuelle Informationen von On die ECC vs RDIMM ECC in Bezug auf DDR5) :

Unbuffered versus Registered ECC Memory - Difference between ECC UDIMMs and RDIMMs

An article outlining the differences between unbuffered versus registered ECC memory and the concepts involved with ECC UDIMMs and RDIMMs

Auch wenn vielleicht in der Virtualisierung nur wirklich relevant.

Und ja, ich lerne immer gerne dazu.

Auszüge:

Basics:

The basic difference is that memory commands in unbuffered memory configurations go directly from the controller to the memory module, while in registered memory configurations the commands are sent first to the memory banks’ registers prior to being sent to the modules. This concept may sound difficult, but here is the very simple/ conceptual view regarding what is going on.

UDIMM:

In the above example the memory controller accesses the memory banks directly. The above assumes that the memory controller resides within the CPU package as it does in modern CPU architectures. Looking at older systems, the memory controller resided within the CPU northbridge. Compare this to the registered memory example below.

RDIMM:

Here the CPU communicates with the registers for the banks of memory on each module. From there, these registers communicate with the DRAM. The implications of this are twofold. First, on a negative side, instructions take approximately one CPU cycle longer due to the intermediary of the bank register. On the positive side, this buffering reduces the strain on the CPU’s memory controller because it points to the dedicated intermediary register versus accessing the DRAM directly. It is easier on the memory controller to deal with a fewer number of targets.

Zuletzt bearbeitet:

Holt

Legende

- Mitglied seit

- 05.07.2010

- Beiträge

- 30.398

Das steht doch der ersten Folien die Du selbst gepostet hat: DDR5@4800(1DPC),4400(2DPC), wobei DPC für DIMM per Channel steht. Der Test zeigt aber auch, dass ja mehr geht, so wurde ja auch mit 6400 gebencht, der RAM Controller kann also mehr als spezifiziert wurde.Ist es hier auch der Fall, dass die Frequenz ab einer bestimmten Menge an RDIMMs Bestückung verringert wird (Speichercontroller Limitierung) und die Latenzen erhöht werden müssen ?

Vollbestückung ist relativ was die DPC angeht und nur die sind relevant. Alle auf der 2. Seite des Reviews genannten Mainboards haben 8 RAM Slots, aber nur beim ASUS Pro-WS-W790E-SAGE-SE sind diese so angeschlossen, dass alle 8 Speicherkanäle belegt werden, mit 1DPC und bei den ASUS Pro-WS-W790-ACE sowie dem ASRock W790 WS sind es eben 2 DPC für 4 RAM Channels.Ich ärgere mich nur sehr oft darüber, dass die Anbindung der Lanes bei der Vollbestücking nicht mehr transparent angegeben wird

Man das Handbuch des Mainboards eben vor dem Kauf schon mal lesen, zumindest im Bezug auf solche Einschränkungen die einem ggf. wichtig sind, wie eben was sich gegenseitig ausschließt.Früher stand das bei Geizhals.eu dabei.

Mittlerweile nur noch im Handbuch.

Das gibt es ja bei den Server CPUs und ich denke eher nicht, dass es auch noch eine Workstation Version davon geben wird, außerdem scheint dies auch in Zukunft wohl wieder zu verschwinden. Aber es kommt immerhin MCR DIMM und dies wird die Bandbreite nochmal deutlich steigern:Weiß jemand, ob wir auch die CPUs mit HBM2(e) zu Gesicht bekommen werden oder sind die nur für dem OEM Markt bestimmt?

Wobei da vergessen wurde, dass schon mit DDR4 eine CRC bei der Übertragung eingeführt wurden und im Fall von Übertragungsfehlern wird die Übertragung dann wiederholt. Aber Sicherheit, auch die Sicherheit vor RAM Fehlern ist immer relativ, deswegen gibt es ja auch unterschiedliche Technologien bis hin zu Chipkill und Spiegelung der RAM Inhalte, was ausreichend ist, muss also jeder für sich entschieden, aber mit On-Die-ECC hat man einen gewissen Schutz vor gekippten Bits und man hat auch einen Schutz vor Übertragungsfehlern und steht damit auf der ersten Stufe der Sicherheitsleiter.Jeder der behauptet, dass On Die ECC bei dem DDR5 Desktop Plattformen ausreichend würde

Nein, nicht alle Zen3 CPUs unterstützen ECC, der 5500 ist z.B. eine Ausnahme:Alle CPUs ab "Zen3" unterstützen grundsätzlich ECC und sind ECC kompatibel. Aber unbuffert.

Mit UDIMM ECC Riegeln kompatible ist jedes System, auch wenn es kein ECC unterstützt, sofern die übrigens Spezifikationen passen, dann hängen die zusätzlichen Datenbits eben in der Luft und bleiben ungenutzt, aber es wird laufen. Das einzige was ECC technisch von solchen ohne ECC unterscheidet ist, dass sie eben mehr Datenbits (72 bzw. bei DDR5 80 statt 64) haben und der RAM Controller da seine Prüfsumme ablegen kann. Praktisch muss man dann noch beachten, dass es ECC RAM mit unterschiedlichen Technologien gibt, eben die RDIMM und LRDIMM (wobei es zumindest für RDIM wohl auch eine Spezifikation ohne ECC geben soll, aber wohl keine solche Riegel) und diese sind weder untereinander noch mit UDIMM kompatibel, was aber nichts damit zu tun hat, dass es ECC Riegel gibt, sondern das sie eben nicht unbuffered sind.

Das macht dann immer wieder mal Probleme wenn Leute dies nicht beachten und günstig in der Bucht gebrauchte Server RAMs kaufen, die dann aber fast immer eben RDIMM oder LRDIMM sind und diese in ihren Mainstream Plattform (also aktuell AM5 bzw. LGA1700 und deren Vorgänger) packen und die unterstützen eben nur unbuffered RAM, also UDIMM. In Zukunft kommt ja wohl noch Multiplexer Combined Ranks (MCR) DIMM dazu und wenn die dann mit 8800 bezeichnet werden, dann wird es einen Haufen Threads geben wo Leute sich diese wegen deren hohen Geschwindigkeit gekauft haben und dann fragen warum der Rechner damit nicht booten will.

Zuletzt bearbeitet:

blazethelight

Enthusiast

@Kullberg & @Holt:

Ich glaube wir haben aneinander vorbei geredet bzw. ich habe mich falsch ausgedrückt.

Nur zum Verständnis:

Bei meinen Board gibt es keine max. Ram Bestückung mit nur 4 oder nur 8 DIMMs - sondern 16 DIMMs.

---

Daher kam meine Frage / mein Interesse - zu praktischen Erfahrungen dazu.

Da dies hier in beiden Fällen des Intel WS Sockels 4677 erst gar nicht möglich ist, hat sich das Thema da eher schon erledigt gehabt - hätte aber ja trotzdem sein können, dass die Frequenzen / Timings sich bei der Vollbestückung verändert hätten - auch wenn eher unwahrscheinlich (entweder nur 4 DIMMs oder 8 DIMMs - war ja auch gar nicht auf diesem bezogen von mir).

Interessant wären dann die Größe von DIMMs, damit die max. 2TB erreicht werden würden...^^ Die gibt es eher nicht dazu zu kaufen (bei 8x32 GB / 256 GB ist da "real" aktuell Schluss). Aber das ist natürlich mehr als ausreichend für ein WS Board.

Meine Interesse galt dem AMD EPYC SP3 Sockel, da es dort halt auch möglich gewesen wäre / ist: https://geizhals.eu/?cat=mbsp3&xf=319_DDR4-3200~4400_E-ATX+(SSI+EEB)~493_16x+DDR4+DIMM~8540_2048

Daher galt dort mein Interesse zu praktischen Erfahrungen dazu (wo Kullberg mich ja schon aufgeklärt hatte, dass selbst als Beispiel bei 16 DIMMs bei ihm auf dem SP3 das Verhalten nicht vorhanden wäre / ist).

Auch auf den AMD TRs Sockeln (TRX40, WRX80 und X399) ist dies doch auch gar nicht möglich, da zu wenige DIMM Steckplätze vorhanden sind (auch nur maximal 8 möglich).

---

Danke Holt wegen dem Auszug aus Anandtech. Dann gibbet auf den Intel WS leider kein HBM2e (auch wen die 56 Core Anzahl zufällig gepasst hätte : 8x DDR5 + 4x HBM2e ~ bye, bye^^).

Natürlich lese ich mir die Mainboard Beschreibung vor einen möglichen Kauf 3 x durch... Ich mag keine bösen Überraschungen.

Ich glaube wir haben aneinander vorbei geredet bzw. ich habe mich falsch ausgedrückt.

Nur zum Verständnis:

Bei meinen Board gibt es keine max. Ram Bestückung mit nur 4 oder nur 8 DIMMs - sondern 16 DIMMs.

---

Daher kam meine Frage / mein Interesse - zu praktischen Erfahrungen dazu.

Da dies hier in beiden Fällen des Intel WS Sockels 4677 erst gar nicht möglich ist, hat sich das Thema da eher schon erledigt gehabt - hätte aber ja trotzdem sein können, dass die Frequenzen / Timings sich bei der Vollbestückung verändert hätten - auch wenn eher unwahrscheinlich (entweder nur 4 DIMMs oder 8 DIMMs - war ja auch gar nicht auf diesem bezogen von mir).

Interessant wären dann die Größe von DIMMs, damit die max. 2TB erreicht werden würden...^^ Die gibt es eher nicht dazu zu kaufen (bei 8x32 GB / 256 GB ist da "real" aktuell Schluss). Aber das ist natürlich mehr als ausreichend für ein WS Board.

Meine Interesse galt dem AMD EPYC SP3 Sockel, da es dort halt auch möglich gewesen wäre / ist: https://geizhals.eu/?cat=mbsp3&xf=319_DDR4-3200~4400_E-ATX+(SSI+EEB)~493_16x+DDR4+DIMM~8540_2048

Daher galt dort mein Interesse zu praktischen Erfahrungen dazu (wo Kullberg mich ja schon aufgeklärt hatte, dass selbst als Beispiel bei 16 DIMMs bei ihm auf dem SP3 das Verhalten nicht vorhanden wäre / ist).

Auch auf den AMD TRs Sockeln (TRX40, WRX80 und X399) ist dies doch auch gar nicht möglich, da zu wenige DIMM Steckplätze vorhanden sind (auch nur maximal 8 möglich).

---

Danke Holt wegen dem Auszug aus Anandtech. Dann gibbet auf den Intel WS leider kein HBM2e (auch wen die 56 Core Anzahl zufällig gepasst hätte : 8x DDR5 + 4x HBM2e ~ bye, bye^^).

Natürlich lese ich mir die Mainboard Beschreibung vor einen möglichen Kauf 3 x durch... Ich mag keine bösen Überraschungen.

Zuletzt bearbeitet:

Holt

Legende

- Mitglied seit

- 05.07.2010

- Beiträge

- 30.398

Was ist beim S. 4677 nicht möglich? 16DIMM? Natürlich uns es reicht sogar ein Sockel dafür, da die CPUs ja bis zu 16 RAM Kanäle haben und auch zwei DIMM pro Channel unterstützen. Ich kenne zwar kein Mainboard für die Workstation Versionen der Sapphire Rapids Xeons welches dies bietet, es sollte aber gehen, nur Multi-Socket ist normalerweise alleine den Server Varianten vorbehalten, wobei dies auch hier von der jeweiligen Version abhängt.Da dies hier in beiden Fällen des Intel WS Sockels 4677 erst gar nicht möglich ist

Nochmal: Dafür ist nur die Anzahl der DIMM per Channel relevant, wie viele der vorhandenen Channels genutzt werden, ist im Prinzip irrelevant! Praktisch ist es natürlich so, dass nie alle Riegel eines Kits gleich sind gut übertaktbar und wenn man eben das RAM auch übertakten kann und 8 Riegel hat, ist die Wahrscheinlichkeit das man mit dem Takt nicht so hoch kommt als wenn man nur den schnellsten der Riegel des Kits alleine einsetzt, natürlich gegeben.hätte aber ja trotzdem sein können, dass die Frequenzen / Timings sich bei der Vollbestückung verändert hätten

Nein, selbst GH listet auch schon 64GB DDR5 DRIMM Riegel mindestens zwei DPC sollten auch gehen (früher konnten Xeons teils sogar 3DPC), auch wenn es also derzeit keine Mainboards damit gibt, wären dies also 16+64GB=1TB RAM und Intel gibt "Max Memory Size (dependent on memory type) 4 TB" an. Aber schon bei DDR4 gibt es auch 128RG Riegel bei GH gelistet und mit DDR5 wird die Kapazität der größten Riegel noch steigen:damit die max. 2TB erreicht werden würden...^^ Die gibt es eher nicht dazu zu kaufen (bei 8x32 GB / 256 GB ist da "real" aktuell Schluss).

Samsung will 2022 noch DDR5-Module mit 512 GB liefern - 1 TB sind geplant - Hardwareluxx

Samsung will 2022 noch DDR5-Module mit 512 GB liefern - 1 TB sind geplant.

Mit solchen 512GB Riegel kann man dann auch mit den bestehenden Mainboard mit 8 DIMM die maximalen 4TB realisieren. DDR5 ist ja noch recht neu, gerade auch im Serverbereich und solche Serverhardware ist im normalen Handel oft erst viel später oder gar nicht zu bekommen, erscheint also auf Portalen wie GH oft erst spät oder gar nicht, auch wenn die großen OEMs dies schon lange anbieten.

Wie viel RAM brauchst Du den bzw. hättest Du den gerne?

n3cron

Enthusiast

- Mitglied seit

- 13.05.2020

- Beiträge

- 6.520

- Ort

- DE - BY - MILF

- Details zu meinem Desktop

- Prozessor

- Intel Core i7 13700K 16 (8+8) 3.40GHz So.1700

- Mainboard

- MSI Tomahawk WIFI Intel Z790 So. 1700

- Kühler

- be quiet! Silent Loop 2 360mm All-in-One

- Speicher

- 64GB (2x 32GB) G.Skill Ripjaws S5 weiss DDR5-5600 DIMM CL28

- Grafikprozessor

- Gigabyte Nvidia RTX 3080 Gaming OC 10G

- Display

- Xiaomi Mi Curved Gaming Monitor 34" 144hz@ UWQHD 3440*1440

- SSD

- Samsung 990Pro 2 TB, Samsung 970 Evo Plus M.2 2280 PCIe 3.0 x4 3D-NAND TLC

- Opt. Laufwerk

- -

- Soundkarte

- -

- Gehäuse

- be quiet! Silent Base 802

- Netzteil

- 750 Watt be quiet! Dark Power 13 Modular 80+ Titanium

- Betriebssystem

- Windows 11 Pro

- Internet

- ▼950 Mbit ▲600 Mbit

Also normalerweise kannst du nicht mit nur einer CPU voll bestücken, sondern die Slots müssten auch voll belegt sein.

blazethelight

Enthusiast

@n3cron:

Das ist natürlich klar bei Multi Sockel Boards. Für andere "Mitleser", welche in dem Bereich aber keine Erfahrung haben, finde ich deinen Hinweis / Beitrag aber sehr hilfreich.

@Holt:

Das stimmt auch soweit alles, was du schreibst.

Es geht / ging mir nie um "ich benötige 1, 2, oder 4 TB Ram."

Sondern dass es teilweise je nach Chipsatz einfach möglich ist und man teilweise (früher) relativ günstig bei Ebay und Co für ähnliches Geld (Vergleich der Kosten mit sehr schnellen UDIMM im Mainstream Bereich) einfach eine hohe Kapazität erhalten konnte inkl. Fehlerkorrektur.

Ich hatte mich bezüglich des realen (und aktuellen) Arbeitsspeicherausbau auf die QVL von der ASUS Homepage des ASUS Pro WS W790E-Sage SE selbst bezogen.

Das grundlegend viel mehr möglich ist / sein wird (da alle Komponenten aktuell noch sehr neu sind und teilweise gar nicht lieferbar sind ist doch auch klar.

Genauso das der eigentliche Intel 4677 Sockel (anderer Chipsatz / Server) weitaus mehr kann ist auch klar.

Ich habe mich aber auch hier auf den im Artikel gezeigten Intel W790 Chipsatz / das Board ASUS Pro WS W790E-Sage SE bezogen.

Aus eigener Erfahrung passen / funktionieren als Beispiel auf dem "alten" M-ITX ASRock X99E-ITX 2x 128 GB DDR4 RDIMMs (könnten auch LRDIMMs sein - müsste ich nochmal auslesen) - auch wenn das nie auf der ASRock Homepage / Ram QVL gelistet war.

Das ist dann einfach glücklich und muss man im Zweifel ausprobieren.

Ich halte mich dann einfach immer an den Datenblättern des RAMs (wenn verfügbar) und prüfe die JEDEC Daten (kann der Notfalls in den nächsten tieferen programmierten JEDEC wechseln).

Auch das wir Endkunden (ohne Eigengewerbe) ohne OEMs oder Ebay gar nicht mal so eben an manche (Server) Hardware rankommen können, ist natürlich auch korrekt / klar.

Die (seit / nach dem X99 Sockel / C600 er Chipsatz) bewussten Unterscheidungen der Hersteller zwischen Workstations und Servern empfinde ich persönlich als sehr schade.

Da war / ist man selbst sehr flexibel, was man verbauen möchte (variable Auswahl an UDIMM, reg. L/RDIMM, OC, Mainstream, WS oder Server CPUs, WS und Server Features, On-board Sound, etc..)

Obwohl ich schon anmerken muss, dass mir persönlich bei dem W790 Chipsatz nicht viel "fehlen" würde.

Außer das da halt keine Server CPUs (im späteren Verlauf) verbaut werden können, welche je nach dem einfach spannend gewesen wären (UML bezogen oder Features allgemein bezogen).

Kritisch sehe ich wieder Intel seine "Software / Firmware" Beschränkungen der CPU Features (das gab es schon einmal - weiß den Sockel aber gerade nicht).

Aber das führt Nvidia ebenso (schon lange) aus und lässt die Kasse klingeln.

Auch wenn ich den AMD SP3 nicht wirklich mit dem W790 vergleichen kann / sollte, wäre dann für mich persönlich der SP3 (oder in Zukunft der Nachfolger) im Zweifel die (immer noch) spannendere Wahl (auch wenn da kein PCIe 5.0 vorhanden ist und kein DDR5 etc.).

Auch wenn man da wieder den reinrassigen Server hätte (das

ASRock Rack ROME2D16-2T ist schon nett - oder als Alternative das Supermicro H12DSi-NT6) und eben keine WS (das I/O Shield spricht wieder klar gegen eine Nutzung als WS dagegen). Daher bin ich da persönlich immer wieder zwiegespalten. 🤣

Kurz gesagt:

Ich werde mich davon verabschieden können / müssen, dass es wieder einen Chipsatz geben wird, welcher einen die Freiheiten einräumt, aus beliebigen Bereichen (Mainstream, WS oder Server) Komponenten zu verbauen / zu "mixen".

Das hat(te) eigentlich vor allem Kostenvorteile und lässt für mich persönlich eine Plattform würdevoll altern (und habe halt alle Freiheiten / kann später immer wieder wechseln auf z.B. CPUs und Ram, welche 5 Jahre vorher für mich einfach nicht bezahlbar waren).

Das es aus Leistungssicht / IPC Sicht der CPUs (von dem Takt und Features wie als Beispiel AVX512 mal ganz abgesehen) und den modernen (schnelleren) Schnittstellen der Boards (mehr PCIe Lanes, aufgebohrter DMI bei Intel) / Ram Geschwindigkeiten für viele Personen keinen Sinn ergibt, ist / wäre eine völlig legitime Ansicht der Dinge (und würde den Tatsachen / Fakten entsprechen, welche man nicht abstreiten kann / sollte).

Was ich übrigens meinte bezüglich nicht mehr wirklich transparenten Angaben, zu der Anbindung von CPU / Chipsatz, PCIe und (teil-) deaktivieren Schnittstellen bei der Nutzung von vollen angebunden PCIe Geräten ist der Umstand, dass es früher dafür PLX Chips / Switches gab (selbst wenn das extra Strom gekostet hatte - konnte man ja deaktivieren wenn nicht benötigt / heute wären natürlich andere und schnellere Verbindungen nötig), um die Limitierungen des DMI / UMI zu umgehen.

Das würde ich persönlich bei den (abgehobenen) Mainboard Preisen eher wieder begrüßen als D-RGB (auf den Mainstream bezogen).

Hier ganz nett (und halbwegs aktuell) erklärt / aufgezeigt:

audiosciencereview.com

audiosciencereview.com

Wenn auch selbst "gestandene" Tech Seiten immer nur auf die Block Diagramme zeigen müssen und das ganze trotzdem nicht in der Realität einordnen können (praktisch - da die Mainboard Hersteller einfach nach belieben selbst entscheiden können - was manche auch ordentlich umsetzen / viele aber leider nicht direkt und offensichtlich erklären), halte ich vieles hier für reines Marketing / Theorien und ist für mich der Grund, warum ich den Mainstream Bereich (schon etwas länger) bewusst meiden möchte:

www.techpowerup.com

www.techpowerup.com

Natürlich, wird es selten vorkommen, dass jemand die gesamte Bandbreite gleichzeitig zwischen CPU & Chipsatz benötigt, aber falls doch, ist der DMI / UMI immer noch (bewusst im Mainstream) beschnitten.

Das wären für mich übrigens "Artikel" wert, als Tech Seite.

Die dazugehörige Bandbreitenubersicht in Jahren, zeigt es halt auch deutlich, dass sich da einiges getan hat und auch getan werden musste:

www.servethehome.com

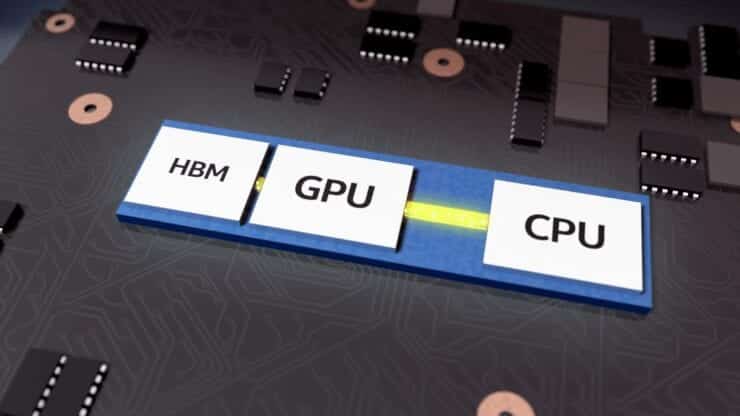

www.servethehome.com

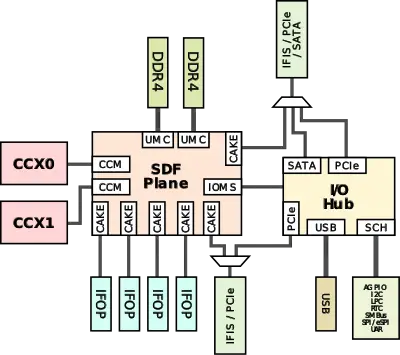

Die dazugehörigen Verbindungen (auch zwischen Cache und Cores / Core Chiplets untereinander auf den Chips / Packages selbst oder GPU zu GPU und CPU zu GPU / IO) hat man mal gehört, aber selten auf Tech Seiten genauer erläutert. Als Beispiel: Infinity Fabric oder ehemals Hyper Transport bei AMD: https://www.nas.nasa.gov/hecc/support/kb/amd-rome-processors_658.html

Bei Intel ehemals QPI oder heute Mesh (Ring Bus) oder im GPU Bereich EMIB und bzw. CXL in vielen Bereichen (die Informationen sind leider nicht alle vollständig je nach aktueller Architektur oder Sockel):

hardwaresfera.com

hardwaresfera.com

en.wikichip.org

en.wikichip.org

en.wikichip.org

en.wikichip.org

en.wikichip.org

en.wikichip.org

en.wikichip.org

en.wikichip.org

en.wikichip.org

en.wikichip.org

en.wikichip.org

en.wikichip.org

en.wikichip.org

en.wikichip.org

Das ist natürlich klar bei Multi Sockel Boards. Für andere "Mitleser", welche in dem Bereich aber keine Erfahrung haben, finde ich deinen Hinweis / Beitrag aber sehr hilfreich.

@Holt:

Das stimmt auch soweit alles, was du schreibst.

Es geht / ging mir nie um "ich benötige 1, 2, oder 4 TB Ram."

Sondern dass es teilweise je nach Chipsatz einfach möglich ist und man teilweise (früher) relativ günstig bei Ebay und Co für ähnliches Geld (Vergleich der Kosten mit sehr schnellen UDIMM im Mainstream Bereich) einfach eine hohe Kapazität erhalten konnte inkl. Fehlerkorrektur.

Ich hatte mich bezüglich des realen (und aktuellen) Arbeitsspeicherausbau auf die QVL von der ASUS Homepage des ASUS Pro WS W790E-Sage SE selbst bezogen.

Das grundlegend viel mehr möglich ist / sein wird (da alle Komponenten aktuell noch sehr neu sind und teilweise gar nicht lieferbar sind ist doch auch klar.

Genauso das der eigentliche Intel 4677 Sockel (anderer Chipsatz / Server) weitaus mehr kann ist auch klar.

Ich habe mich aber auch hier auf den im Artikel gezeigten Intel W790 Chipsatz / das Board ASUS Pro WS W790E-Sage SE bezogen.

Aus eigener Erfahrung passen / funktionieren als Beispiel auf dem "alten" M-ITX ASRock X99E-ITX 2x 128 GB DDR4 RDIMMs (könnten auch LRDIMMs sein - müsste ich nochmal auslesen) - auch wenn das nie auf der ASRock Homepage / Ram QVL gelistet war.

Das ist dann einfach glücklich und muss man im Zweifel ausprobieren.

Ich halte mich dann einfach immer an den Datenblättern des RAMs (wenn verfügbar) und prüfe die JEDEC Daten (kann der Notfalls in den nächsten tieferen programmierten JEDEC wechseln).

Auch das wir Endkunden (ohne Eigengewerbe) ohne OEMs oder Ebay gar nicht mal so eben an manche (Server) Hardware rankommen können, ist natürlich auch korrekt / klar.

Die (seit / nach dem X99 Sockel / C600 er Chipsatz) bewussten Unterscheidungen der Hersteller zwischen Workstations und Servern empfinde ich persönlich als sehr schade.

Da war / ist man selbst sehr flexibel, was man verbauen möchte (variable Auswahl an UDIMM, reg. L/RDIMM, OC, Mainstream, WS oder Server CPUs, WS und Server Features, On-board Sound, etc..)

Obwohl ich schon anmerken muss, dass mir persönlich bei dem W790 Chipsatz nicht viel "fehlen" würde.

Außer das da halt keine Server CPUs (im späteren Verlauf) verbaut werden können, welche je nach dem einfach spannend gewesen wären (UML bezogen oder Features allgemein bezogen).

Kritisch sehe ich wieder Intel seine "Software / Firmware" Beschränkungen der CPU Features (das gab es schon einmal - weiß den Sockel aber gerade nicht).

Aber das führt Nvidia ebenso (schon lange) aus und lässt die Kasse klingeln.

Auch wenn ich den AMD SP3 nicht wirklich mit dem W790 vergleichen kann / sollte, wäre dann für mich persönlich der SP3 (oder in Zukunft der Nachfolger) im Zweifel die (immer noch) spannendere Wahl (auch wenn da kein PCIe 5.0 vorhanden ist und kein DDR5 etc.).

Auch wenn man da wieder den reinrassigen Server hätte (das

ASRock Rack ROME2D16-2T ist schon nett - oder als Alternative das Supermicro H12DSi-NT6) und eben keine WS (das I/O Shield spricht wieder klar gegen eine Nutzung als WS dagegen). Daher bin ich da persönlich immer wieder zwiegespalten. 🤣

Kurz gesagt:

Ich werde mich davon verabschieden können / müssen, dass es wieder einen Chipsatz geben wird, welcher einen die Freiheiten einräumt, aus beliebigen Bereichen (Mainstream, WS oder Server) Komponenten zu verbauen / zu "mixen".

Das hat(te) eigentlich vor allem Kostenvorteile und lässt für mich persönlich eine Plattform würdevoll altern (und habe halt alle Freiheiten / kann später immer wieder wechseln auf z.B. CPUs und Ram, welche 5 Jahre vorher für mich einfach nicht bezahlbar waren).

Das es aus Leistungssicht / IPC Sicht der CPUs (von dem Takt und Features wie als Beispiel AVX512 mal ganz abgesehen) und den modernen (schnelleren) Schnittstellen der Boards (mehr PCIe Lanes, aufgebohrter DMI bei Intel) / Ram Geschwindigkeiten für viele Personen keinen Sinn ergibt, ist / wäre eine völlig legitime Ansicht der Dinge (und würde den Tatsachen / Fakten entsprechen, welche man nicht abstreiten kann / sollte).

Was ich übrigens meinte bezüglich nicht mehr wirklich transparenten Angaben, zu der Anbindung von CPU / Chipsatz, PCIe und (teil-) deaktivieren Schnittstellen bei der Nutzung von vollen angebunden PCIe Geräten ist der Umstand, dass es früher dafür PLX Chips / Switches gab (selbst wenn das extra Strom gekostet hatte - konnte man ja deaktivieren wenn nicht benötigt / heute wären natürlich andere und schnellere Verbindungen nötig), um die Limitierungen des DMI / UMI zu umgehen.

Das würde ich persönlich bei den (abgehobenen) Mainboard Preisen eher wieder begrüßen als D-RGB (auf den Mainstream bezogen).

Hier ganz nett (und halbwegs aktuell) erklärt / aufgezeigt:

DMI/UMI and you! A guide to your motherboard's chipset bandwidth.

So what is DMI and why is it important? DMI is the bandwidth tunnel between your Motherboard's Chipset's PCH/Southbridge and your CPU. DMI is important because the bandwidth is divided between your USB ports, Non-CPU linked PCIe slots, SATA ports and others. Knowing this information will help...

audiosciencereview.com

audiosciencereview.com

Wenn auch selbst "gestandene" Tech Seiten immer nur auf die Block Diagramme zeigen müssen und das ganze trotzdem nicht in der Realität einordnen können (praktisch - da die Mainboard Hersteller einfach nach belieben selbst entscheiden können - was manche auch ordentlich umsetzen / viele aber leider nicht direkt und offensichtlich erklären), halte ich vieles hier für reines Marketing / Theorien und ist für mich der Grund, warum ich den Mainstream Bereich (schon etwas länger) bewusst meiden möchte:

AMD Zen 4 & Socket AM5 Explained: PCIe Lanes, Chipsets, Connectivity

There has been a fair bit of confusion about AMD's upcoming AM5 platform when it comes to connectivity and we're going to break things down and explain what the difference is between the B650 and X670 boards. We're also going to cover the processor connectivity, since that's an integral part of...

Natürlich, wird es selten vorkommen, dass jemand die gesamte Bandbreite gleichzeitig zwischen CPU & Chipsatz benötigt, aber falls doch, ist der DMI / UMI immer noch (bewusst im Mainstream) beschnitten.

Das wären für mich übrigens "Artikel" wert, als Tech Seite.

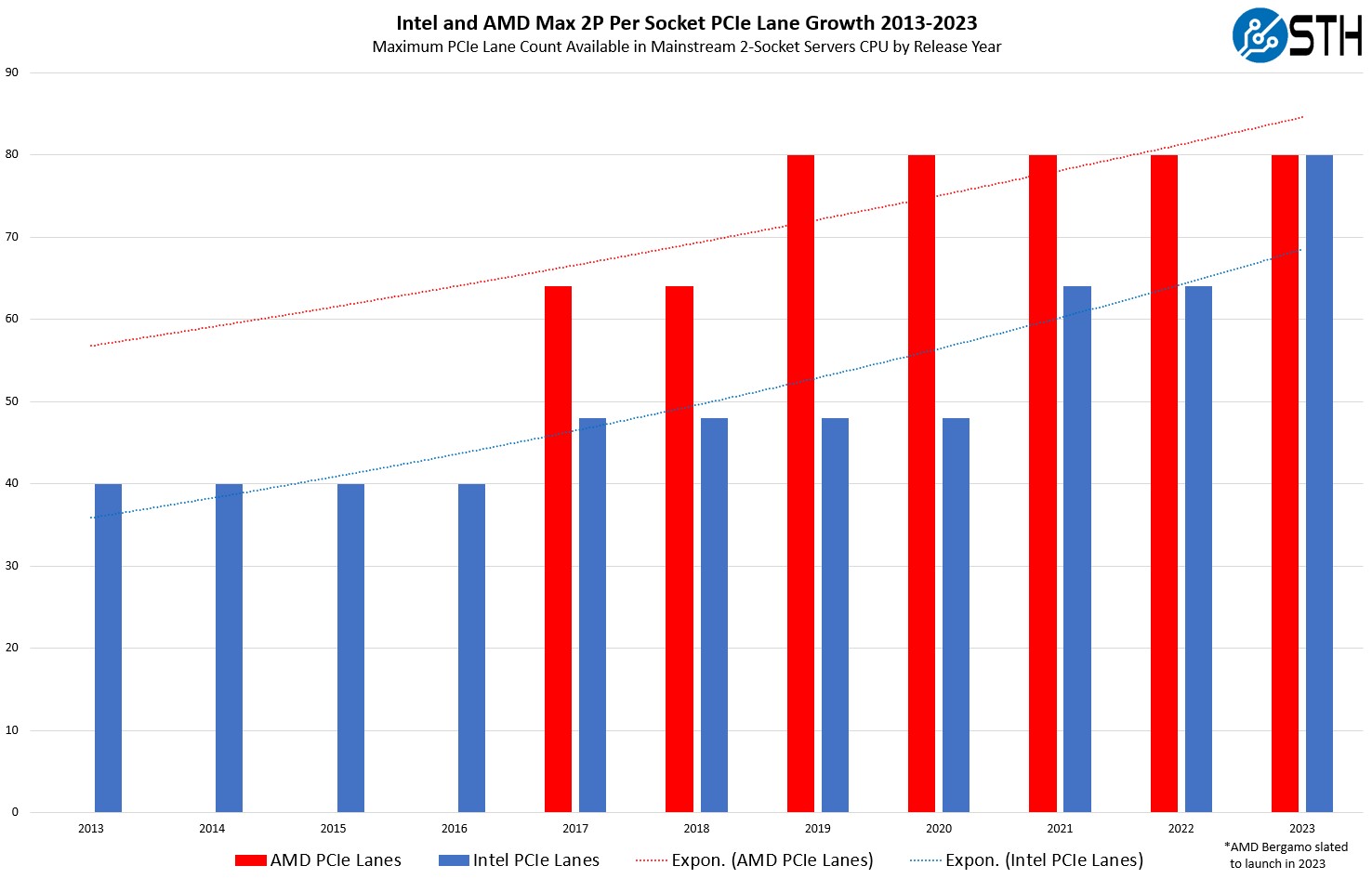

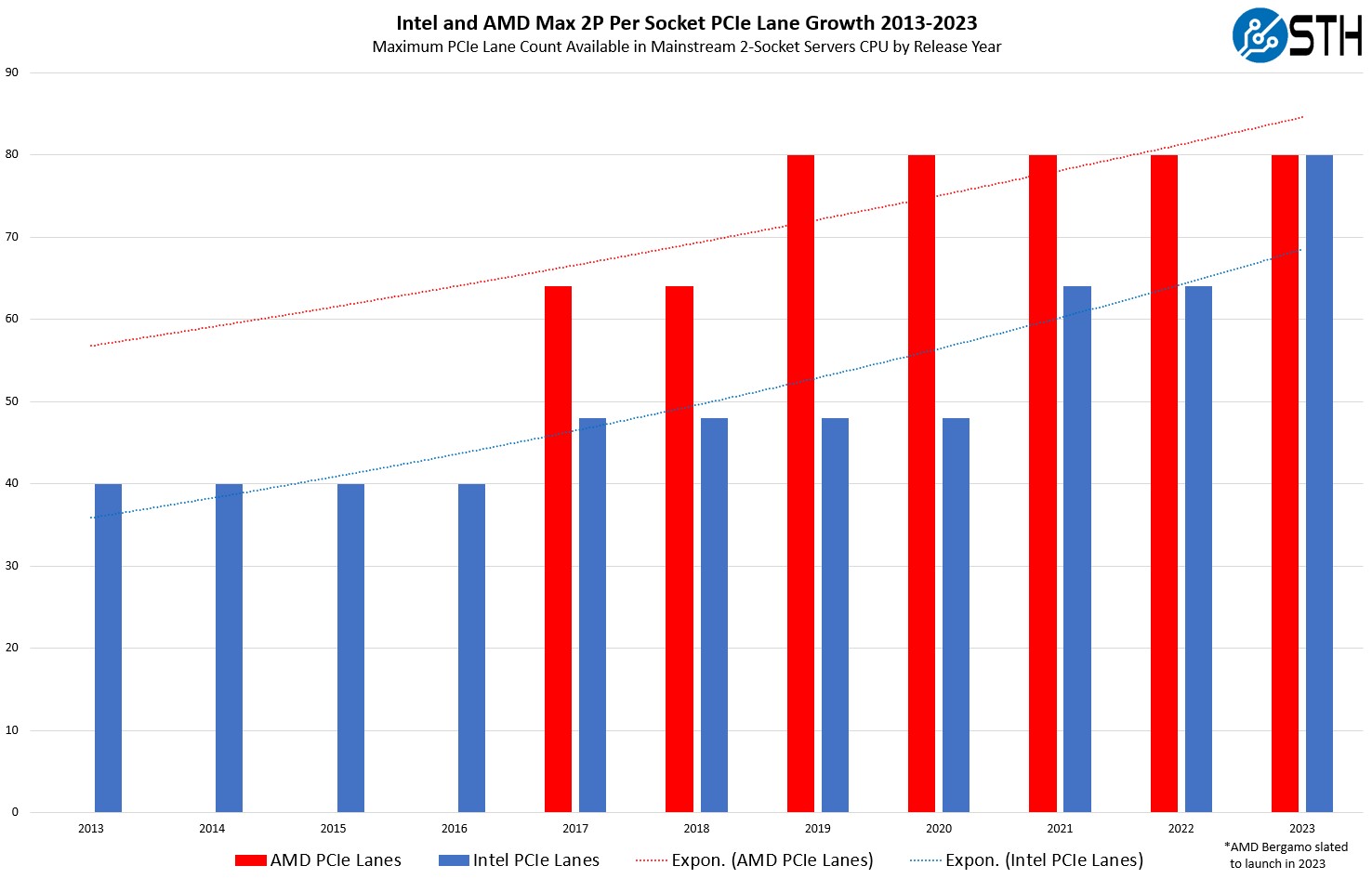

Die dazugehörige Bandbreitenubersicht in Jahren, zeigt es halt auch deutlich, dass sich da einiges getan hat und auch getan werden musste:

PCIe Lanes and Bandwidth Increase Over a Decade for Intel Xeon and AMD EPYC

We chart the PCIe lane counts (per socket) for mainstream dual socket servers between 2013 and 2023 to see the key industry trends

Die dazugehörigen Verbindungen (auch zwischen Cache und Cores / Core Chiplets untereinander auf den Chips / Packages selbst oder GPU zu GPU und CPU zu GPU / IO) hat man mal gehört, aber selten auf Tech Seiten genauer erläutert. Als Beispiel: Infinity Fabric oder ehemals Hyper Transport bei AMD: https://www.nas.nasa.gov/hecc/support/kb/amd-rome-processors_658.html

Bei Intel ehemals QPI oder heute Mesh (Ring Bus) oder im GPU Bereich EMIB und bzw. CXL in vielen Bereichen (die Informationen sind leider nicht alle vollständig je nach aktueller Architektur oder Sockel):

Intel does not give AMD access to EMIB technology

AMD is left wanting to get their hands on Intel's EMIB technology, which would solve many of the company's current problems.

Infinity Fabric (IF) - AMD - WikiChip

Infinity Fabric (IF) is a proprietary system interconnect architecture that facilitates data and control transmission across all linked components. This architecture is utilized by AMD's recent microarchitectures for both CPU (i.e., Zen) and graphics (e.g., Vega), and any other additional...

en.wikichip.org

en.wikichip.org

Heterogeneous Integration (HI) - WikiChip

Heterogeneous Integration (HI) refers to the assembly and packaging of multiple separately manufactured components onto a single chip in order to improve functionality and enhance operating characteristics. Heterogeneous integration allows for the packaging of components of different...

en.wikichip.org

en.wikichip.org

Mesh Interconnect Architecture - Intel - WikiChip

Intel's mesh interconnect architecture is a multi-core system interconnect architecture that implements a synchronous, high-bandwidth, and scalable 2-dimensional array of half rings. Their mesh architecture has replaced the ring interconnect architecture in the server and HPC markets.

en.wikichip.org

en.wikichip.org

Broadwell - Microarchitectures - Intel - WikiChip

Broadwell (BDW) is Intel's microarchitecture based on the 14 nm process for mobile, desktops, and servers. Introduced in early 2015, Broadwell is a process shrink of Haswell which introduced several enhancements. Broadwell is named after Broadwell, Illinois.

en.wikichip.org

en.wikichip.org

Socket SP3 - Packages - AMD - WikiChip

Socket SP3 is a microprocessor socket designed by AMD for the first three generations of their EPYC family of high performance server processors. It supports eight channels of DDR4 memory and eight 16-lane PCIe I/O links. Socket SP3 succeeded Socket G34 and was superseded by Socket SP5.

en.wikichip.org

en.wikichip.org

Socket SP5 - Packages - AMD - WikiChip

Socket SP5 is a microprocessor socket designed by AMD for the fourth generation of their EPYC family of high performance server processors, succeeding Socket SP3. Its counterpart for desktop processors is Socket AM5.

en.wikichip.org

en.wikichip.org

Ice Lake (server) - Microarchitectures - Intel - WikiChip

Ice Lake (ICL, ICX) Server Configuration is Intel's successor to Cascade Lake, a 10 nm microarchitecture for enthusiasts and servers.

en.wikichip.org

en.wikichip.org

Zuletzt bearbeitet:

Holt

Legende

- Mitglied seit

- 05.07.2010

- Beiträge

- 30.398

Das lag daran, dass der X99 Chipsatz eben noch eine reine HEDT Plattform war, die aber technisch natürlich auf den Xeons basierte und damals wollte Intel den HEDT Kunden eben UDIMM bieten, während für die C600er Chipsätze nur RDIMM/LRDIMM vorgesehen war. Da dies technisch alles die gleichen Chips waren, konnten die Mainboard Hersteller sich halt über Intels Vorgaben hinwegsetzen und auch RDIMM und LRDIMM in X99 Boards freigeben und zumindest in einigen von denen laufen auch Xeons und die haben dann auch die ECC RAM Unterstützung.Aus eigener Erfahrung passen / funktionieren als Beispiel auf dem "alten" M-ITX ASRock X99E-ITX 2x 128 GB DDR4 RDIMMs (könnten auch LRDIMMs sein - müsste ich nochmal auslesen) - auch wenn das nie auf der ASRock Homepage / Ram QVL gelistet war.

...

Da war / ist man selbst sehr flexibel, was man verbauen möchte (variable Auswahl an UDIMM, reg. L/RDIMM, OC, Mainstream, WS oder Server CPUs, WS und Server Features, On-board Sound, etc..)

Ja, denn HEDT ist tot, die Mainstream Plattformen bieten inzwischen so viel CPU Performance und PCIe Lanes, beim Z790 sind es auch 20 direkt von der CPU und bis zu 28 vom Chipsatz und damit so viele wie man auch maximal bei X99 hatte, nur waren da dann 40 von der CPU. Es gibt nun nur noch die Workstation Plattformen, AMD hat TR der HEDT war ja auch zugunsten der TR PRO (die sind Workstation) eingestellt und bei Intel übernehmen halt die X Versionen der hier getesteten Sapphire Rapids die HEDT Rolle mit und die unterstützen nun kein UDIMM mehr. Aber dafür gibt es nun OC RDIMM RAM Riegel, ich erinnere mich nicht sowas früher schon mal gesehen zu haben.Ich werde mich davon verabschieden können / müssen, dass es wieder einen Chipsatz geben wird, welcher einen die Freiheiten einräumt, aus beliebigen Bereichen (Mainstream, WS oder Server) Komponenten zu verbauen / zu "mixen".

Wenn man sich diese Plattform nicht neu kaufen will, weil man nicht so viel Geld ausgeben will oder kann, dann wird man noch so 3 bis 5 Jahre warten müssen, denn meisten behalten die Firmen ihre Rechner so lange und erst dann kommen die erste auf dem Gebrauchtmarkt an. Bis dahin hast Du ja noch genug Zeit zum Überlegen, auch ob es ein Server oder doch eine WS sein soll.kann später immer wieder wechseln auf z.B. CPUs und Ram, welche 5 Jahre vorher für mich einfach nicht bezahlbar waren

Seit Broadcom die Firma PLX übernommen hat, haben sie die Preise der Chips gewaltig erhöht und außerdem haben die Plattformen heute eigentlich selbst genug Lanes, zumal SLI tot ist und man zumindest in Consumerbereich die PCIe Lanes heute vor allem für die Anbindung von NVMe SSDs braucht. Da ist auch die DMI Anbindung kein echter Flaschenhals, denn außer wenn man ein RAID 0 aus mehreren schnellen NVMe SSDs am Chipsatz betreibt, werden kaum jemals wirklich so viele Daten auf einmal in die gleiche Richtung transportiert, dass DMI zum Flaschenhals werden und DMI ist ja technisch PCIe und damit vollduplex, es können also Daten gleichzeitig in beiden Richtungen übertragen werden.Was ich übrigens meinte bezüglich nicht mehr wirklich transparenten Angaben, zu der Anbindung von CPU / Chipsatz, PCIe und (teil-) deaktivieren Schnittstellen bei der Nutzung von vollen angebunden PCIe Geräten ist der Umstand, dass es früher dafür PLX Chips / Switches gab

Mein ASRoch Z790 Steel Legend hat z.B. eine PCIe 4.0 x8 Anbindung des Chipsatzes an dem 3 M.2 Slots mit je PCIe 4.0 x4 Anbindung, nur wenn ich alle 3 mit einer schnellen NVMe SSDs bestücke und die in ein RAID 0 packe, wäre DMI hier ein Flaschenhals, aber wozu außer zum Aufgeilen an längsten Benchmarkbalken sollte gut sein?

Übrigens hat mein Mainboard nur eine solcher Einschränkungen und die betrifft den M.2 Slot mit PCIe 5.0 Lanes, wenn der benutzt wird, kann man den M.2 Slot mit den 4 PCIe 4.0 Lanes aus der CPU nicht nutzen (wobei das ein reines Platzproblem ist, die Slots sind gegenüberliegend montiert und die SSDs belegen damit physikalisch den gleichen Platz) und der PCIe 5.0 Slot hat dann nur noch 8 Lanes.

Und das ist auch gut so, denn je mehr und schnellere Schnittstellen wie eben PCIe Lanes man hat, umso höher wir die Leistungsaufnahme und natürlich macht es die ganze Plattform auch teurer. Aber gerade die Mainstream Plattformen sind eben ein Kompromiss und daher eben nicht so teuer und stromhungrig wie eben die hier getestete WS Plattform, die auch Maximalansprüche bedienen soll. Nur kann oder will sich dann, wie Du ja selbst schreibst, längst nicht jeder diese zum Neupreis leisten und kauft sie dann in vielleicht 5 Jahren lieber gebraucht, wenn dann schon wieder neue Modelle auf dem Markt sind, die diese hier vermutlich wieder alt aussehen lassen.Natürlich, wird es selten vorkommen, dass jemand die gesamte Bandbreite gleichzeitig zwischen CPU & Chipsatz benötigt, aber falls doch, ist der DMI / UMI immer noch (bewusst im Mainstream) beschnitten.

Am Ende muss eben jeder selbst entscheiden was ihm wichtig ist. Wer nur wegen Haben Wollen kauft, für den ist die Entscheidung gefallen und die anderen sollten halt schauen welche Eigenschaften ihnen wichtiger sind und wo er Kompromisse eingehen will.

Jetzt wirst Du aber alles durcheinander, denn QuickPath Interconnect (QPI) ist eine Punkt-zu-Punkt-Verbindung für die Kommunikation zwischen Prozessoren untereinander und Mesh ist für die Kommunikation innerhalb der CPU und hat bei den CPUs für die großen Sockel den Ringbus abgelöst. EMIB ist eine Technologie zur Verbindung von Dies zu einem Chip und hat mit mit Mesh oder Ringbus nichts zu tun und mit QPI schon gar nicht, da QPI ja für die Kommunikation zwischen unterschiedlichen Prozessoren ist.Bei Intel ehemals QPI oder heute Mesh (Ring Bus) oder im GPU Bereich EMIB

tonythebuilder

Experte

- Mitglied seit

- 01.09.2017

- Beiträge

- 529

- Details zu meinem Desktop

- Prozessor

- Intel Xeon w5-2455X

- Mainboard

- ASUS Pro WS W790-Ace

- Kühler

- Noctua NH-U14S DX-4677

- Speicher

- 2x 64 GB DDR5-4800 RDIMM

- Grafikprozessor

- PowerColor 7900 XT (Ref.-Design), Sapphire RX570 ITX 4GB (HwPt)

- Display

- 2x 24" Eizo

- SSD

- T-Force Carder A440 Pro 2TB, Asus Hyper M.2 X16 Gen5: 2x Kingston KC3000 2TB, Corsair MP600 GS 0.5TB

- Soundkarte

- Steinberg UR22C

- Gehäuse

- Phanteks NV7

- Netzteil

- Corsair Professional HX1000i

- Keyboard

- Cherry KC 6000 Slim

- Mouse

- Logitech MX518

- Betriebssystem

- Linux Mint Edge

Supermicro X13SWA-TFWas ist beim S. 4677 nicht möglich? 16DIMM? Natürlich uns es reicht sogar ein Sockel dafür, da die CPUs ja bis zu 16 RAM Kanäle haben und auch zwei DIMM pro Channel unterstützen. Ich kenne zwar kein Mainboard für die Workstation Versionen der Sapphire Rapids Xeons welches dies bietet, es sollte aber gehen, nur Multi-Socket ist normalerweise alleine den Server Varianten vorbehalten, wobei dies auch hier von der jeweiligen Version abhängt.

Und bitte Vorsichtig sein, Saphire Rapids Server CPUs, nicht mit Saphire Rapids WS CPUs verwechseln oder vermischen. Die beiden brauchen unterschiedliche Chipsets C741 (Server) und W790 (WS).

Mainstream Plattformen sind gut, wenn man nur eine Grafikkarte und eventuell eine weitere Erweiterungskarte (10GBit-NIC etc.) einbauen möchtete. Möchte man mehr haben, sind oft nicht die richtigen Slots oder diese sind nicht voll elektrisch angebunden (16 Slot aber nur 8fach angebunden). Oder man nutzt einen M.2 Slot und man muss einen PCIe Slot aufgeben. Usw. usw.....

Holt

Legende

- Mitglied seit

- 05.07.2010

- Beiträge

- 30.398

Da ist ja schon eines mit 16 RAM Slots und damit fehlen dann nur noch 256GB DDR5 RDIMM Riegel für den maximalen Speicherausbau.Supermicro X13SWA-TF

Den meisten reicht dies aber, dafür ist es ja die Mainstream Plattform und für Enthusiasten gibt es eben nun mit den X Modellen der Sapphire Rapids Workstation CPUs gibt es eben nun auch von Intel wieder eine aktuelle Plattform mit reichlich schnellen PCIe Lanes. Wie schon geschrieben muss am Ende jeder für sich entscheiden was seinen Wünsche und Ansprüche am Besten erfüllt, aber man kann eben nicht alles auf einmal haben, diese Plattform ist wie der Review gezeigt hat, eben teuer und zieht schon im Idle reichlich Strom, kann aber bei Spielen trotzdem nicht mithalten. Die optimale Plattform bzw. eben das optimale System welches in jeder Hinsicht optimal ist, gibt es eben nicht und kann es nie geben, man muss immer irgendwo Kompromisse machen, wie eigentlich immer im Leben.Mainstream Plattformen sind gut, wenn man nur eine Grafikkarte und eventuell eine weitere Erweiterungskarte (10GBit-NIC etc.) einbauen möchtete. Möchte man mehr haben, sind oft nicht die richtigen Slots oder diese sind nicht voll elektrisch angebunden

Vista

Urgestein

- Mitglied seit

- 24.01.2006

- Beiträge

- 5.240

- Ort

- im PC

- Desktop System

- System Wahnwitz

- Laptop

- -

- Details zu meinem Desktop

- Prozessor

- Intel Xeon W-3175X, 28C/56T, 3.10-3.80GHz LGA3647

- Mainboard

- Asus ROG Dominus Extreme LGA3647

- Kühler

- Phanteks Glacier Dominus Extreme Kit CPU+VRMs

- Speicher

- Corsair Dominator RGB DDR4-4000 MHZ CL19 12 x 16 GB

- Grafikprozessor

- Asus ROG Matrix GeForce RTX 4090 Platinum 24GB GDDR6X

- Display

- Philips 43 Zoll 4K

- SSD

- Samsung 970 Evo Plus 2TB + 980 Pro 1TB + 990 Pro 4TB

- HDD

- 3x Toshiba MG09 18 TB

- Opt. Laufwerk

- ASUS Blu-Ray Laufwerk

- Soundkarte

- Creative AE-5 Plus + Lightning Kit

- Gehäuse

- Thermaltake W200 Core + 2x Thermaltake P200 Core

- Netzteil

- 2x Corsair AX1600i

- Keyboard

- Corair K100 Gold + Corsair Nexus

- Mouse

- Corsair + MM800 RGB Cloth

- Betriebssystem

- Windows 10 Pro for Workstation

- Webbrowser

- Firefox, Edge, Opera, Chrome

- Sonstiges

- Mo-Ra 420 Pro Steel Push/Pull Noctua a20 HP

- Internet