HWL News Bot

News

Thread Starter

- Mitglied seit

- 06.03.2017

- Beiträge

- 113.961

... weiterlesen

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: this_feature_currently_requires_accessing_site_using_safari

und immer ist Intel der Böse ^^ herrlichDer chip ist schon beeindruckend. Da zeigt sich was möglich ist und wie Intel über Jahre die Kundschaft verarscht hat.

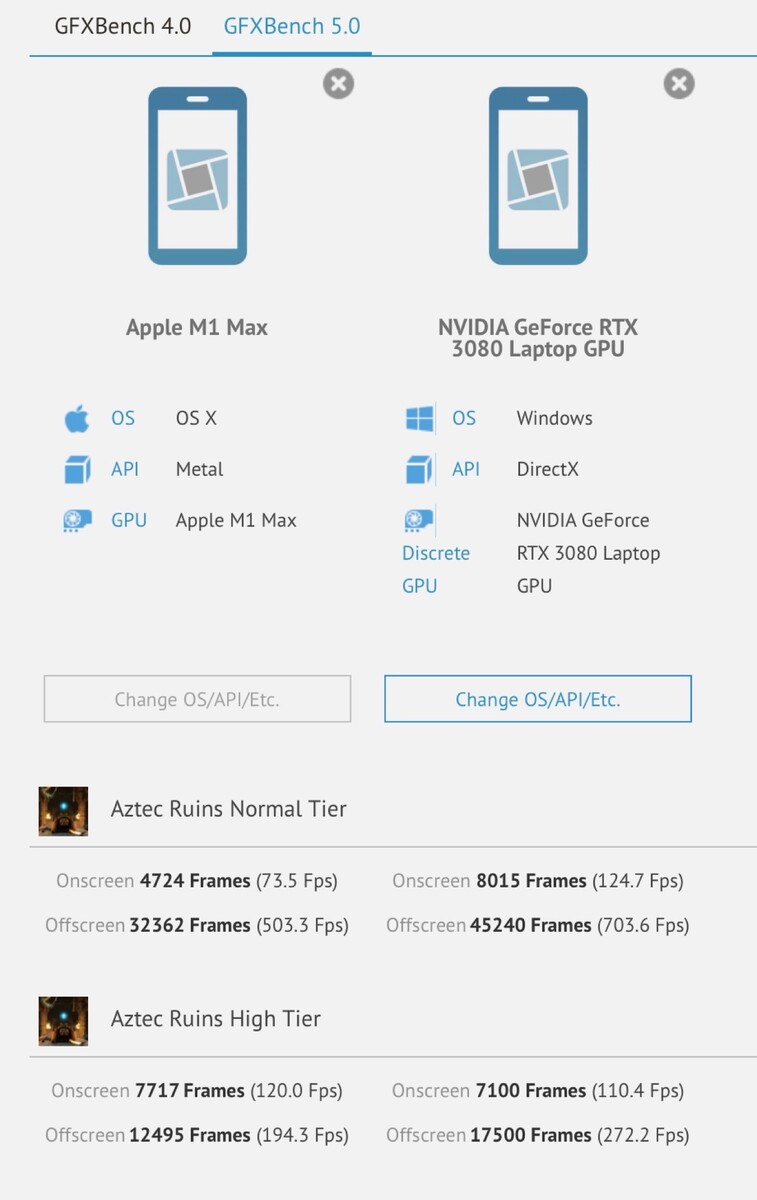

Nimmt man nur die TFLOPS als vergleich, sprechen wir für den M1 Max von einem Niveau welches mit einer GeForce RTX 3060 bzw. Radeon RX 6600 XT vergleichbar ist.Mich würde die Gaming Leistung interessieren, meine Frau spielt mit dem 8 Core Air M1 WoW Shadowlands in annehmbare Grafik. Classic kann man voll aufdrehen. ^^

Mal sehen was der 32 Core Chip da schafft.

Die beiden Modelle mit i5-8500B und i7-8700B (mit der unterirdischen UHD 630 GPU) wollen noch abgelöst werden.Die Minis gibts doch bereits mit M1.

Nicht eher mit einer GeForce RTX 3060 Mobile bzw. einer Radeon RX 6700M?Nimmt man nur die TFLOPS als vergleich, sprechen wir für den M1 Max von einem Niveau welches mit einer GeForce RTX 3060 bzw. Radeon RX 6600 XT vergleichbar ist.

Die beiden Modelle mit i5-8500B und i7-8700B (mit der unterirdischen UHD 630 GPU) wollen noch abgelöst werden.

Fragt sich nur, ob neben dem M1 Pro auch ein M1 Max angeboten werden wird.

Nicht eher mit einer GeForce RTX 3060 Mobile bzw. einer Radeon RX 6700M?

Intel hat ein Jahrzehnt gepennt und die Gewinnmargen poliert. Sonst wäre die Konkurrenz nicht überlegen. Apple hätte nie "mal eben" Hardware entwickelt und das Ökosystem auf einen anderen Befehlssatz portiert. Dahinter liegen massive technische Entscheidungen.und immer ist Intel der Böse ^^ herrlich

Intel hatte kein R&D?R&D bekommt also nix ab?

Den Vergleich habe ich nicht gezogen.Intel hatte kein R&D?

Hatte auch auf den MacMini gehofft. Es hieß ja immer, dass der mit dem neuen 14" und 16" MacBook rauskommen wird. Schade schade.Hoffentlich kommen die bald im Mac Mini... ein MacBook kann ich leider nicht gebrauchen im Moment 🦊

Hatte auch auf den MacMini gehofft. Es hieß ja immer, dass der mit dem neuen 14" und 16" MacBook rauskommen wird. Schade schade.

Wird ja vermutet, dass man den Mini vershcoben hat um eine schlechte Liefersituation zu umgehen, also die Nachfrage nach den Chips etwas runterzufahren. 3 neue Produkte könnten hier doch etwas kontraproduktiv sein.Hatte auch auf den MacMini gehofft. Es hieß ja immer, dass der mit dem neuen 14" und 16" MacBook rauskommen wird. Schade schade.

Der chip ist schon beeindruckend. Da zeigt sich was möglich ist und wie Intel über Jahre die Kundschaft verarscht hat.

Wenn ich da bis zu 10x so viel GPU Power zum gleichen Preis bekommen, dann kann ich gut damit leben, dass das Ding irgendwann nach der Garantie vielleicht mal etwas kaputt und dann kauft man halt etwas Neues, was wieder extrem viel besser ist.Inwiefern? Wüsste nicht, dass Intel je ein quasi Mainboard im Chip gebaut hat. Wenn die Bussysteme gekürzt werden war es auch damals schon so, dass die Performance quasi explodiert ist, da macht Apple nichts neues. Könnte man auch beim PC machen, aber dann wäre nichts mehr mit Aufrüsten im klassischen Sinn. Und wenn ein Defekt da wäre kann man ja auch das ganze Bauteil entsorgen, sprich den Rechner in die Tonne schmeißen.

Mal schauen, wenn Intel sich im GPU-Sektor aufgebaut hat wird da bestimmt auch etwas ähnliches im Notebookbereich kommen. Zumindest könnten Sie das dann auch machen. Im Desktopsegment sehe ich da nicht die klassische Zielgruppe von solchen Geräten.

Wenn ich da bis zu 10x so viel GPU Power zum gleichen Preis bekommen, dann kann ich gut damit leben, dass das Ding irgendwann nach der Garantie vielleicht mal etwas kaputt und dann kauft man halt etwas Neues, was wieder extrem viel besser ist.

Diese Leistungssprünge die Apple da abliefert sind einfach pervers.

Die Leistung bei geringem Verbrauch bekommst du aber nur WEIL man verlötet. Wo findest du aktuell steckbar LPDDR5 6400? Und überleg mal wieviele Module du für 512Bit Busbreite du benötigst. Genauso beim SOC, da könnte man auch argumentieren, dass man eine getrennte GPU steckbar machen könnte, wie das früher tw der Fall war. Nur dann ist halt nichts mit Unified Memory und schnellen internen Bussen die effizient funktionieren.10x mehr GPU-Leistung (in Bezug auf was?) im Best-Case. Ich würde mich da nicht blenden lassen. Ein Gerät für 3000+€ sollte locker 5-10 Jahre halten, im Optimalfall sogar länger, das kannst Du da aber vergessen( dank verbundenen Komponenten und verlöteter Hardware.

Klar ich kann immer damit argumentieren dies, das, irgendwas kommt in der Zukunft. Was wenn ich die Leistung am besten schon gestern brauche?Warten wir es ab, die erste Antwort von den anderen wird nicht lange auf sich warten lassen. Intel hat das Hinauszögern zuletzt beim Pentium 4 praktiziert und dann kam die Core-Architektur, die 15 Jahre Bestleistung geliefert hat. Die haben das sicher längst auf dem Schirm.