Moin,

ja wie der Name schon sagt, habe ich am zweiten M.2 Slot (der, der über den Chipsatz angesteuert wird) ne echt miese Performance.

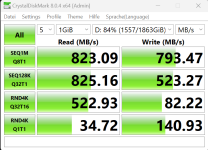

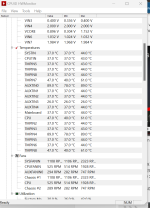

Ich rede hier von gerade mal 700MB/s was PCIe 3.0 x1 oder PCIe 1.0 x4 entsprechen würde. Meine NVMEs unterstützen aber beide PCIe 3.0 x4, dies wird auch so als aktuelle Verbindung in CrystalDiskInfo und Samsung Magican angezeigt.

Habe zwei NVMEs (Samsung und Kingston) und beide natürlich schon getauscht. Auf M.2_1 (der, der über die CPU angebunden ist) läuft alles fein -> ca. 3500 MB/s auf M.2_2 plötzlich nur noch 800 MB/s.

Ich habe keine SATA Platten angeschlossen und keine Zusatzkarten in den PCIe Slots.

Witzigerweise macht es Null unterschied welche PCIe GEN Version ich für den M.2_2 Slot im Bios einstelle (Auto, GEN1, GEN2, GEN3) es bleibt bei genau der gleichen Geschwindigkeit, weswegen ich davon ausgehe dass die NVMEs im M.2_2 Slot fälschlicherweise mit PCIe 1.0 x 4 oder aber mit PCIe 3.0 x1 angesprochen werden. Warum mir das aber so nicht in CrystalDiskInfo angezeigt wird ist natürlich auch komsich.

Auf dem M.2_1 läuft wie gesagt alles gut, wenn ich den Slot im Bios auf GEN1 runterstelle dann bekomme ich auch erwartungsgemäß eine niedrigere Datenrate, diese Bios Einstellung scheint also grundsätzlich zu funktionieren.

Unter Linux das selbe Phänomen weswegen ich Windows Treiber als Ursache eigentlich eher ausschließe.

Hatte jemand schon einmal so ein ähnliches Problem mit den B550 Boards?

Was ich schon probiert habe

- NVME Treiber Update bei der Samsung NVME

- AMD Chipsatz Update

- Bios Update

- clear CMOS

alles ohne Erfolg

Kann man irgendwie ein Bios downgrade forcen?

oha

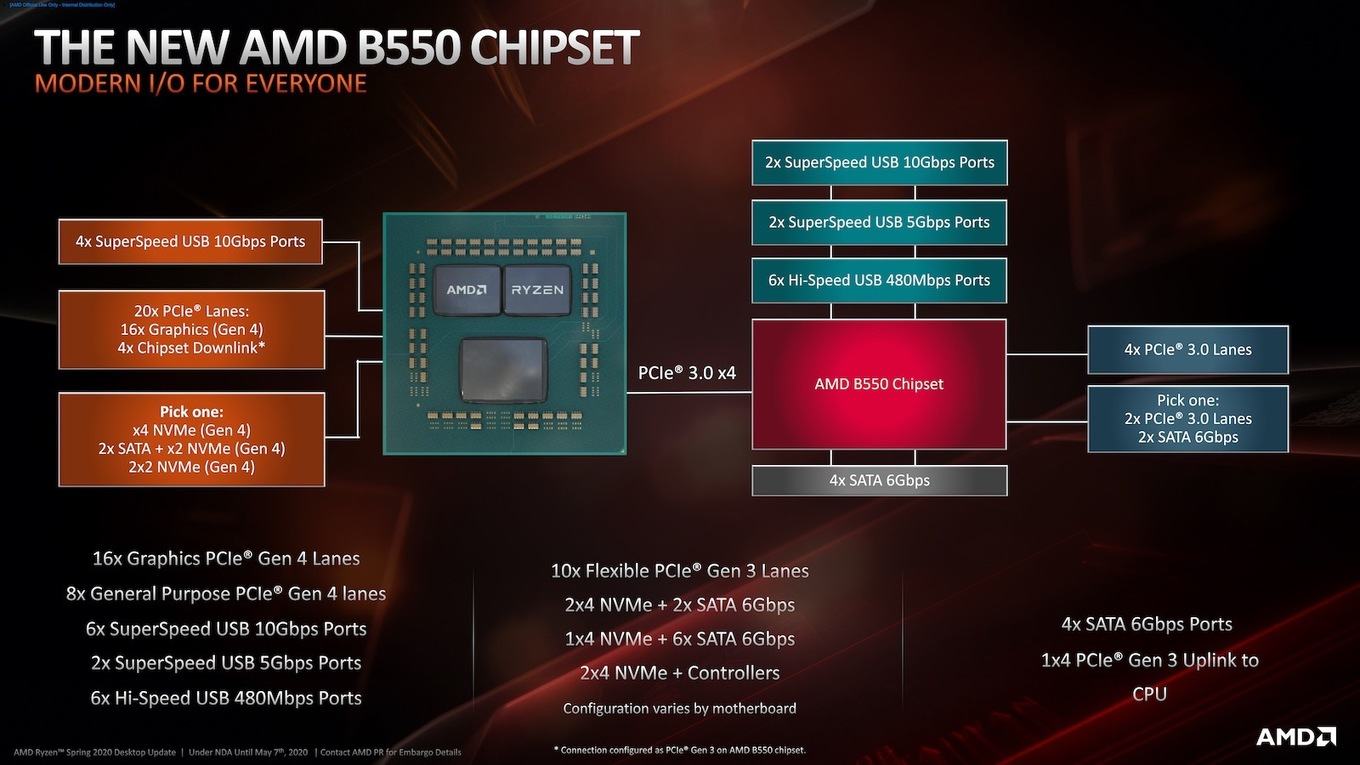

der Dude hat genau das selbe Problem wie ich, er hat sich sogar nen PCIe Slot Adapter für die NVME geholt, ohne Erfolg offenbar läuft der ganze Chipsatz PCI Bus nur mit 1.0 oder aber mit maximal mit PCIe 3.0 x1 😬.

forums.tomshardware.com

forums.tomshardware.com

ja wie der Name schon sagt, habe ich am zweiten M.2 Slot (der, der über den Chipsatz angesteuert wird) ne echt miese Performance.

Ich rede hier von gerade mal 700MB/s was PCIe 3.0 x1 oder PCIe 1.0 x4 entsprechen würde. Meine NVMEs unterstützen aber beide PCIe 3.0 x4, dies wird auch so als aktuelle Verbindung in CrystalDiskInfo und Samsung Magican angezeigt.

Habe zwei NVMEs (Samsung und Kingston) und beide natürlich schon getauscht. Auf M.2_1 (der, der über die CPU angebunden ist) läuft alles fein -> ca. 3500 MB/s auf M.2_2 plötzlich nur noch 800 MB/s.

Ich habe keine SATA Platten angeschlossen und keine Zusatzkarten in den PCIe Slots.

Witzigerweise macht es Null unterschied welche PCIe GEN Version ich für den M.2_2 Slot im Bios einstelle (Auto, GEN1, GEN2, GEN3) es bleibt bei genau der gleichen Geschwindigkeit, weswegen ich davon ausgehe dass die NVMEs im M.2_2 Slot fälschlicherweise mit PCIe 1.0 x 4 oder aber mit PCIe 3.0 x1 angesprochen werden. Warum mir das aber so nicht in CrystalDiskInfo angezeigt wird ist natürlich auch komsich.

Auf dem M.2_1 läuft wie gesagt alles gut, wenn ich den Slot im Bios auf GEN1 runterstelle dann bekomme ich auch erwartungsgemäß eine niedrigere Datenrate, diese Bios Einstellung scheint also grundsätzlich zu funktionieren.

Unter Linux das selbe Phänomen weswegen ich Windows Treiber als Ursache eigentlich eher ausschließe.

Hatte jemand schon einmal so ein ähnliches Problem mit den B550 Boards?

Was ich schon probiert habe

- NVME Treiber Update bei der Samsung NVME

- AMD Chipsatz Update

- Bios Update

- clear CMOS

alles ohne Erfolg

Kann man irgendwie ein Bios downgrade forcen?

Beitrag automatisch zusammengeführt:

oha

der Dude hat genau das selbe Problem wie ich, er hat sich sogar nen PCIe Slot Adapter für die NVME geholt, ohne Erfolg offenbar läuft der ganze Chipsatz PCI Bus nur mit 1.0 oder aber mit maximal mit PCIe 3.0 x1 😬.

Question - Asus Prime B550 Plus M.2_2 Port is slow

Hey, hoping to get some help here after 2 days of pulling my hair out trying to figure out a way to get anyway near the advertised speeds for the samsung 970 evo plus I purchased and installed into my system a couple days ago. My system is an Asus B550 Plus prime series mobo, AMD Ryzen 5 5600x...

Anhänge

Zuletzt bearbeitet: