Fortsetzung von diesem Thread

Radeon HD 5000er Serie

Codenamen: Evergreen (DX11 allg.), Cypress XT (5870), Cypress LE (5850), Juniper XT (5770), Juniper LE (5750)

Launch: 23. September Vorstellung (evtl. kleine Verfügbarkeit), 10. Oktober Verfügbarkeit beim Händler

Offizieller Preis in Frankreich is 239€ für die 5850/1GB und 349€ für 5870/GB (Link)

Bilder (Quelle: hardwareBG.com vom 14.9.09)

6x Displayport-Variante vonh Chiphell.com

Nacktfotos von vorne und hinten (Arabhardware.net)

(Arabhardware.net)

Mehr hochauflösende Fotos auf Overclock.net:

http://www.overclock.net/hardware-news/574905-arabhardware-hd-photos-5870-1gb-its.html

Offizielle Fotos der xfx-Verkaufsversion (xfx-Webseite)

Diagramm zum Aufbau des Chips

Chip-Silikon (pczilla.net)

5870: Benchmarks (Czechgamer.com / Chiphell.com)

Vergleich 5870 mit 4870

Vergleich AA-Effizienz

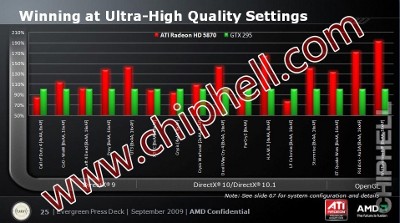

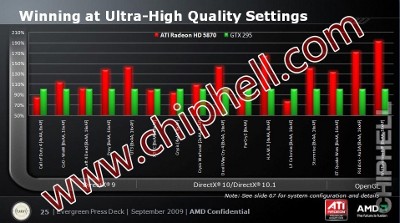

Vergleich-Benchmarks mit gtx200 Gesamtübersicht

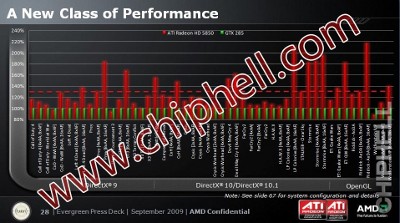

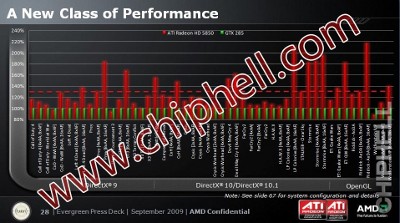

Vergleich 5870 mit gtx 285

Vergleich 5850 mit gtx 285

Vergleich 5870 Crossfire mit gtx 295 Sli

Offizielle Specs Radeon 5870 (von Ati-Forum.de)

Technische Spezifikationen für Cypress XT / 5870 (unter Vorbehalt)

Technische Spezifikationen für Cypress LE / 5850 (sofern verschieden von 5870 und falls bekannt)

Technische Spezifikationen für Juniper (5750/5770)

Modelle

Offizielle Seiten

Ati Eyefinity

Aktuelle Quellen

6.9.09 Radeon HD 5870 and its 1600 shaders (Nordichardware)

8.9.09 21k in 3D Mark Vantage (Beyond3D)

10.9.09 First Exclusive Details and Images of the unreleased HD 5870 (Alienbabeltech)

10.9.09 Ati Radeon HD 5870: Alle Details (Hardware-Infos)

10.9.09 Eyefinity-Infos (.mht hier)

10.9.09 Hawx Sechs-Bildschirm-Demo

10.9.09 Crysis Warhead in 5.670 x 2.160 Pixeln @ 60fps (Golem.de)

10.9.09 Amd Eyefinity 24 Display Tech Demo On Linux (Phoronix)

11.9.09 Radeon 5870 nackt (Czechgamer)

(Czechgamer)

11.9.09 HD58XX - Endgültige Spezifikationen (Ati-Forum.de)

11.9.09 Eyefinity+5870-Fotos (Widescreen-Gaming)

12.9.09 nVidia macht sich in die Hose "President and Ceo of nVidia Corp. (NiViDA) Jen Hsun Huang sells 260,475 shares of NiViDA on 09/11/2009 at an average price of $16.07 a share."

"President and Ceo of nVidia Corp. (NiViDA) Jen Hsun Huang sells 260,475 shares of NiViDA on 09/11/2009 at an average price of $16.07 a share."

11.9.09 Eyefinity mit Crysis 3

16.9.09 Temperatur und Taktraten im Idle (Xtremesystems.org)

21.9.09 Offizieller Preis in Frankreich (Caseandcooling.fr)

Jegliche Änderungen, Verbesserungen und zusätzliche Infos bitte hier posten, ich trag sie dann hier ein.

Radeon HD 5000er Serie

Codenamen: Evergreen (DX11 allg.), Cypress XT (5870), Cypress LE (5850), Juniper XT (5770), Juniper LE (5750)

Launch: 23. September Vorstellung (evtl. kleine Verfügbarkeit), 10. Oktober Verfügbarkeit beim Händler

Offizieller Preis in Frankreich is 239€ für die 5850/1GB und 349€ für 5870/GB (Link)

Bilder (Quelle: hardwareBG.com vom 14.9.09)

6x Displayport-Variante vonh Chiphell.com

Nacktfotos von vorne und hinten

(Arabhardware.net)

(Arabhardware.net)

Mehr hochauflösende Fotos auf Overclock.net:

http://www.overclock.net/hardware-news/574905-arabhardware-hd-photos-5870-1gb-its.html

Offizielle Fotos der xfx-Verkaufsversion (xfx-Webseite)

Diagramm zum Aufbau des Chips

Chip-Silikon (pczilla.net)

5870: Benchmarks (Czechgamer.com / Chiphell.com)

Vergleich 5870 mit 4870

Vergleich AA-Effizienz

Vergleich-Benchmarks mit gtx200 Gesamtübersicht

Vergleich 5870 mit gtx 285

Vergleich 5850 mit gtx 285

Vergleich 5870 Crossfire mit gtx 295 Sli

Offizielle Specs Radeon 5870 (von Ati-Forum.de)

Technische Spezifikationen für Cypress XT / 5870 (unter Vorbehalt)

- Chip: RV870

- Strukturgröße: 40nm

- Chipgröße: 338mm²

- Transistoren: 2,1 Milliarden

- Chiptakt: 850MHz

- Shadertakt: 850MHz

- Shader-Einheiten (Madd): 320

- Shadercluster (pro Cluster 16 x 5D Shaderunits): 20 x 16 (x 5D)

- Stream-Prozessoren: 1600

- Flops (Madd/Add): 2720GigaFlops

- Rops: 32

- Pixelfüllrate: 27.200MegaPixel/s

- Tmus: 80

- Taus: unbekannt

- Texelfüllrate: 66.000MegaTexel/s

- Unified Shader: ja

- Speichermenge: 1GB / 2GB Gddr5

- Speichertakt: 1200MHz

- Speicherinterface: 256 Bit

- Speicherbandbreite: 153,6GB/s

- Verbrauch Idle: 27 Watt (157MHz Kern / 300MHz Speicher: 40°C @ 20% Lüfter)

- Verbrauch Last: 188 Watt

- DirectX-Version: 11

- Anschließbare Monitore: 3 Stück bis 2560x1600

- Preis: 1GB 399 US$ / 2GB 449 US$

- Länge: 28cm (voraussichtlich)

Technische Spezifikationen für Cypress LE / 5850 (sofern verschieden von 5870 und falls bekannt)

- Coretakt: 725 MHz

- Flops (Madd/Add): 2090GigaFlops

- Texelrate: 52,2 GTex/s

- Pixelfüllrate: 23,2 PTex/s

- Speichertakt: 1000 MHz Gddr5

- Speicherbandbreite: 128,0 GB/s

- Speicherbandbreite (256 Bit SI): 128 GB/s

- Stream-Prozessoren: 1440

- Shader: 288 (5D)

- Shadercluster (pro Cluster 16 x 5D Shaderunits): 18 x 16 (x 5D)

- Verbrauch Last: 170 Watt

- Preis: 299 US$

Technische Spezifikationen für Juniper (5750/5770)

- Chipgröße: 181mm²

Modelle

- HD 5850 (Cypress LE)

- HD 5870 (Cypress XT)

- HD 5870 X2 (2x Cypress XT)

- HD 5750 (Juniper LE)

- HD 5770 (Juniper XT)

Offizielle Seiten

Ati Eyefinity

Aktuelle Quellen

6.9.09 Radeon HD 5870 and its 1600 shaders (Nordichardware)

8.9.09 21k in 3D Mark Vantage (Beyond3D)

10.9.09 First Exclusive Details and Images of the unreleased HD 5870 (Alienbabeltech)

10.9.09 Ati Radeon HD 5870: Alle Details (Hardware-Infos)

10.9.09 Eyefinity-Infos (.mht hier)

10.9.09 Hawx Sechs-Bildschirm-Demo

10.9.09 Crysis Warhead in 5.670 x 2.160 Pixeln @ 60fps (Golem.de)

10.9.09 Amd Eyefinity 24 Display Tech Demo On Linux (Phoronix)

11.9.09 Radeon 5870 nackt

(Czechgamer)

(Czechgamer)11.9.09 HD58XX - Endgültige Spezifikationen (Ati-Forum.de)

11.9.09 Eyefinity+5870-Fotos (Widescreen-Gaming)

12.9.09 nVidia macht sich in die Hose

"President and Ceo of nVidia Corp. (NiViDA) Jen Hsun Huang sells 260,475 shares of NiViDA on 09/11/2009 at an average price of $16.07 a share."

"President and Ceo of nVidia Corp. (NiViDA) Jen Hsun Huang sells 260,475 shares of NiViDA on 09/11/2009 at an average price of $16.07 a share."11.9.09 Eyefinity mit Crysis 3

16.9.09 Temperatur und Taktraten im Idle (Xtremesystems.org)

21.9.09 Offizieller Preis in Frankreich (Caseandcooling.fr)

Jegliche Änderungen, Verbesserungen und zusätzliche Infos bitte hier posten, ich trag sie dann hier ein.

Zuletzt bearbeitet:

(Offizielles AMD PR)

(Offizielles AMD PR)

die Diskusion hat zwar weitläufig was mit dem Thema zu tun, aber eben interessiert das quasi niemanden

die Diskusion hat zwar weitläufig was mit dem Thema zu tun, aber eben interessiert das quasi niemanden