- wie lange idle't ein Rechner wenn man den betreibt

Bei mir ca. 12-14 Stunden pro Tag.

- wieviel Zeit verbringt man durchschnittlich mit daddeln

Ich ca. 2-4h/Tag. Im Schnitt eher weniger, da es auch Tage gibt wo ich schlicht und einfach mal überhaupt nix zocke.

Ergo: Der Rechner läuft 14-16h/Tag (aktuell mit Homeoffice sowieso) aber ich spiele nur 2-4h täglich. Und vom Rest idlet der Rechner zu 90%.

- wird ingame überhaupt seitens der CPU Maximalauslastung der CPU über alle Kerne generiert

Nein.

- nimmt nicht, gerade wenn man über FHD daddelt, die Pixelschleuder einen höheren stellenwert ein als die CPU

Nein, die CPU-Requirements sind weitgehend unabhängig von der Auflösung.

Ist egal ob du in 720p oder 8K spielst, die CPU hat die (annähernd) gleiche Last.

Umgekehrt, je höher die Auflösung wird, desto wichtiger wird die GPU.

Gerade bei FHD, ist die CPU "egal", ausser man will 240, 300fps in FHD, und genau dann wird die CPU wieder extrem wichtig.

Soweit mir das bekannt ist bekommt man eine CPU nur in diversen Benchmarks an ihre Grenzen wo auch Maximallast generiert wird, nicht aber ingame. Korrigiert mich wenn ich da falsch liege.

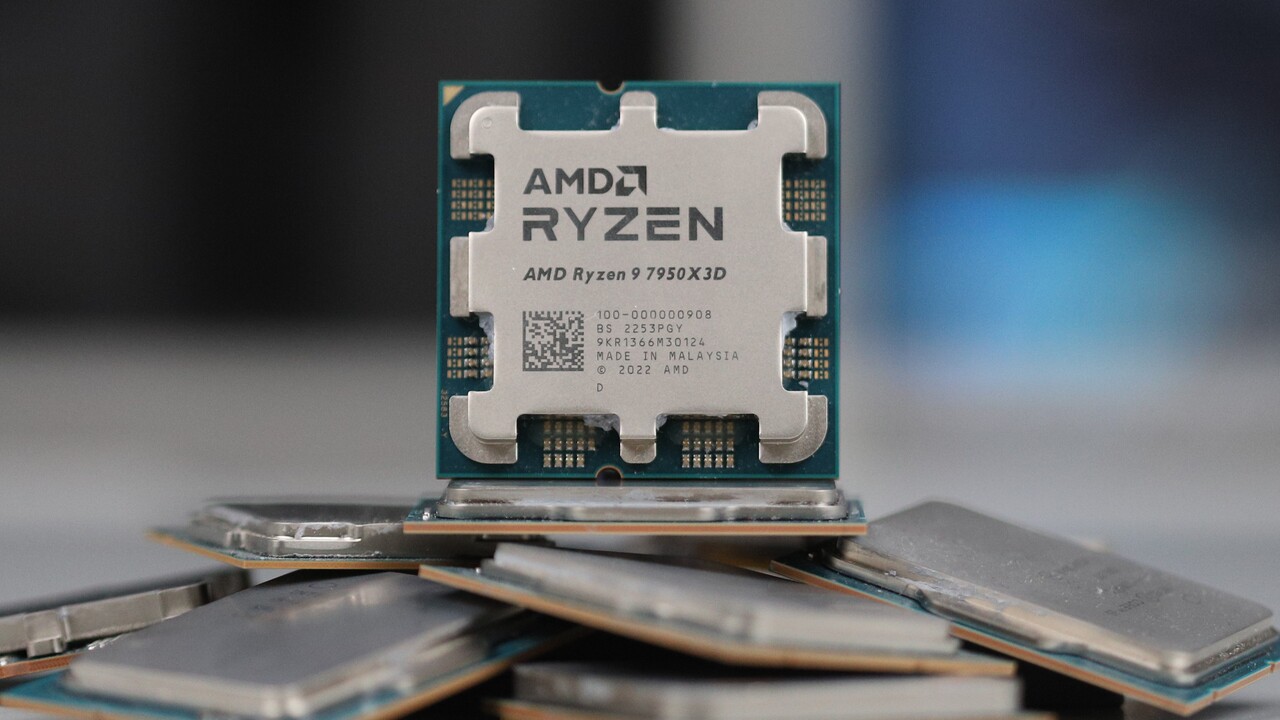

Die ganze CPU bekommt man ingame kaum auf Maximallast, seit 6/8/10/12-Kerner üblich sind, weil die meisten Spiele kaum mehr als 6 Kerne effizient nutzen können. Und selbst die 6 Kerne die genutzt werden laufen nicht jeder auf 100%.

Man kommt aber sehr wohl SEHR EINFACH mit praktisch jeder verfügbaren CPU ins Single-Core-Leistungslimit und das hat eben nichts mit der Auflösung zu tun. Es hat nur damit zu tun, das die GPU bei hoher Auflösung oder eben eine schwache GPU bremst.

Deswegen oben auch meine Anmerkung, das ich lieber nen 6-Kerner mit 10% höherer Singlecore-Leistung nehmen würde, also einen 8 Kerner, der zwar insgesamt 5% mehr (theoretische) Performance liefern kann, aber eben 10% weniger Singlecore hat.

Das Intel-Systeme 70% weniger brauchen, wage ich zu bezweifeln. So pauschal schon gleich dreimal.

Es stimmt meiner Erfahrung nach das

Desktop-Systeme auf Intelbasis etwas weniger Idle-Stromverbrauch haben.

Was beim Idleverbrauch reinhaut sind die Grafikkarten. Da ist AMD im Idle DEUTLICH schlechter als NVidia. Im Desktop.

)

)