Nun, die Welt ist in der Hinsicht etwas komplexer. Die Zeit von 1000SX ist schon lange vorbei.

Für QSFP-DD als auch OSFP sind folgende Stecker vorgesehen:

MPO-12 (8/12)

MPO-16 (16/16)

MPO-24 (16/24)

CS

LC-D

SN

MDC

Und dann noch BiDi für

MPO-12 (8/12)

SN

MDC

Das ist das, was die Normenlage bezüglich Stecker/Transceiver vorgibt. Daran orientieren sich 400G und sicherlich auch 800G.

Dem gegenüber steht die IEEE, die das dann in Bezug auf Ethernet (denn die sind nur eine der Anwender von Stecker/Transceiver) anpasst. Für 400G hat die IEEE folgende Lösungen erdacht:

400GBASE-SR16 (MM)

400GBASE-SR8 (MM)

400GBASE-SR4.2 (MM)

400GBASE-DR4 (SM)

400GBASE-FR8 (SM)

400GBASE-LR8 (SM)

400GBASE-ER8 (SM)

zusätzlich arbeitet man an

400GBASE-ZR (SM)

400GBASE-FR4 (SM)

400GBASE-LR4-6 (SM)

Die Singlemode Sache lasse ich jetzt mal weg. Läuft am Ende immer auf einen Zweifaser-Link mit 4-8 Wellenlängen hinaus. (ausgenommen DR4, die haben MPO-12 (8/12))

400GBASE-SR8

Benutzt 8 Fasern hin und 8 Fasern zurück.

Es gibt laut 802.3 zwei Optionen das zu lösen:

B: MPO-24 (16/24) oder auch MPO-12 two row genannt

A: MPO-16 (16/16)

400GBASE-SR16

Benutzt 16 Fasern und 16 Fasern zurück.

Das führt zum MPO-32 (32/32). Jetzt fragt man sich, wo kommt dieser her, denn weder QSFP-DD noch OSFP sehen den vor.

Der kommt aus der CFP, konkret aus dem CFP8, Spezifikation. Das ist die einzige Bauform, die 2x 16 Datalanes unterstützt.

Das war auch die erste Lösung für 400G, da man so eine relativ geringe Symbolrate per Lane hat, was die DSP entlastet.

400GBASE-SR4.2

Benutzt 8 Fasern hin und 8 Fasern zurück, das ganze in BiDi.

Als Stecker kommt ein MPO-12 (8/12) zum Einsatz.

Des Weiteren ist festgelegt, dass der MPO-24 für breakout Applikationen gedacht ist und nicht für strukturierte Verkabelung.

Jetzt ist die Frage, was macht man....

-SR16 ist wohl raus

Also entweder wird es ein 800GBASE-SR8 mit verdoppelter Symbolrate @ MPO-16 (16/16) und/oder MPO-24( (16/24) geben, oder 800GBASE-SR4.4 mit 4 Lanes pro verwendeter Faser, dafür mit gleichbleibender Symbolrate @ MPO-12 (8/12) BiDi oder aber 800GBASE-SR4.2 mit doppelter Symbolrate auf einem MPO-12 (8/12) BiDi.

Sprich also MPO-16 oder MPO-12 ist hier sicherlich die Wahl. Jetzt ist die Frage, was die IEEE working group sich da noch ausdenkt. 800G ist leider noch eine Weile weg, so dass da noch alles passieren kann.

So, jetzt kommt aber die Frage der Transition:

MPO-16 sieht man erst ab 200G. Bis dahin ist es entweder MPO-12 oder MPO-24.

Sprich also der Weg könnte ab 10G so aussehen.

40G-SR4 mit MPO-12

100G-SR4 mit MPO-12

200G-SR4 mit MPO-12

400G-SR4.2 mit MPO-12

das ist das, was man heute schon sagen kann.

400G-SR8 mit MPO-16

800G-SR8 mit MPO-16?

Alternativ sind noch folgende Zwischensteps machbar:

40G-SR2-BiDi mit LC MM

100G-SR2-BiDi mit LC MM

Diese Transceiver sind im Verhältnis der SR4 schon sehr viel teurer.

So, und was machen wir jetzt?

MPO-12 geht sicher bis 400G, 800G evtl.

MPO-16 geht erst ab 400G

LC geht nur bis 100G

Im worst case legt man eben alle 3 Leitungen rein. (alternativ nen breakout auf LC, wobei so nen LC-Kabel halt auch nichts kostet)

Je nach Situation ist dann also die eine Leitung ggf. ab 800G über, oder die andere kann erst ab 800G genutzt werden.

Man legt dann also ggf. einen mittleren 3-stelligen Betrag rein, der dann irgendwann stirbt. Dafür muss man ggf. die Wände nicht mehr aufmachen, kommt also auf die Situation an.

Ist natürlich auch ne Frage in welchem Umfeld man sich bewegt, @home oder @Firma und da sind dann Investitionsschutz und totes Kapital Themen die beachten werden müssen.

EDIT: Breakoutapplikationen oder passive TAPs sind Themen die dann noch oben drauf kommen und das Thema weiter verkomplizieren.

2ndEDIT: 25G/50G habe ich bei der Transition wegelassen, um es nicht noch mehr aufzublasen. Läuft aber auch auf ne LC-D MM hinaus.

PS: Was ich nicht versuchen würde, 100x LC-D reinzulegen und dann irgendwas hinzuzaubern. Das Thema MPO-LC ist nochmal eine ganz andere Baustelle.

3rdEDIT:

Wem das zu wenig Fasern sind, es gibt noch sowas:

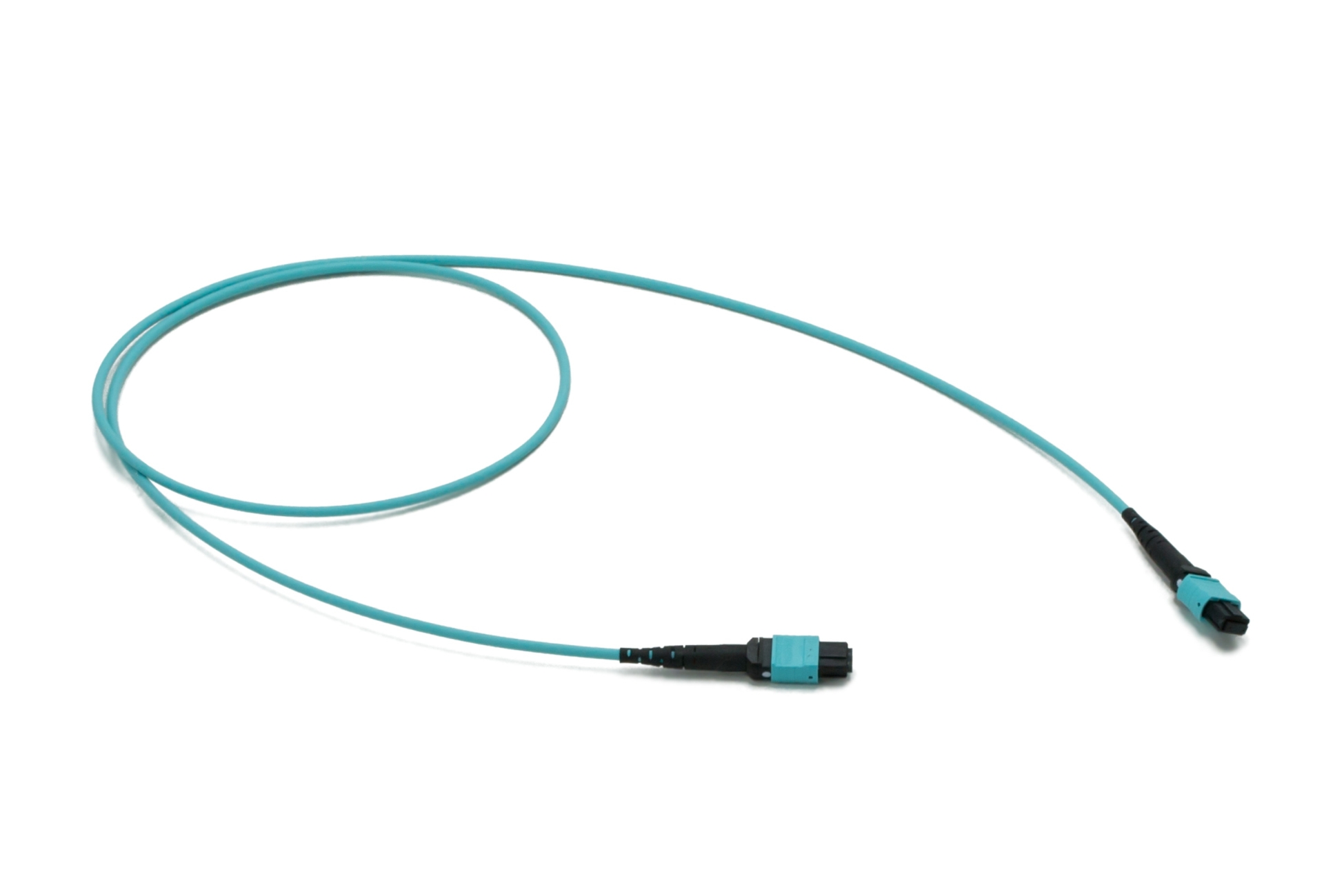

Patch cables with High fibre count MTP® connectivity with the benefit of a small footprint and easy handling. Utilising all the benefits of the 12/24 design.

www.sylex.sk