loopy83

Moderator, HWLUXX OC-Team, TeamMUTTI

Hallo zusammen,

Ich besitze eine Domain und den dazugehörigen Webspace, der bei all-inclusive-webspace gehostet wird.

Dort liegen überwiegend alte Fotoalben (html Seiten), die ich dem Freundeskreis zur Verfügung stelle.

Üblicherweise gehe ich so vor:

- ich lade ein Video oder eine Bildersammlung auf den Webspace (.zip Archive), um sie den beteiligten Freunden zur Verfügung zu stellen

- die Archive sind 700MB - 1GB groß

- innerhalb von ein paar Tagen laden sich meine Freunde (5-10 Leute) die Datei runter

- danach lösche ich die Datei wieder

Jetzt hatte ich schon zwei Mal folgendes Problem:

- Im September habe ich ein 1GB großes Hochzeitsvideo hochgeladen, um es den Hochzeitsgästen zur Verfügung zu stellen

- innerhalb von 3 Tagen war meine Domain gesperrt, weil 12TB (!) Traffic verursacht wurden

- vergangenen Sonntag habe ich eine 700MB große .zip Datei hochgeladen, die Bilder vom Wochenende enthalten hat

- gestern wurde meine Domain wieder gesperrt, weil 300GB (!) Traffic verursacht wurden

Im ersten Fall bestand der Nutzerkreis vielleicht aus 15 Personen.

Im zweiten Fall waren es 3-4 Personen, die es laden sollten.

In jedem Fall nicht genug, um 12TB (!) Daten zu erreichen!

Nach dem zweiten Fall droht mir der Hoster nun mit der Kündigung, die ich noch abwenden konnte.

Aber beim nächsten Mal ist es dann soweit...

Ich habe den Link zu den Archiven immer direkt im Format http://domain.de/ordner/datei.zip per Whatsapp verschickt.

Ich habe es also in keinem öffentlichen Forum oder sonst wo gepostet!

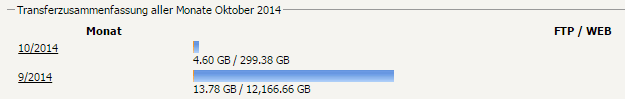

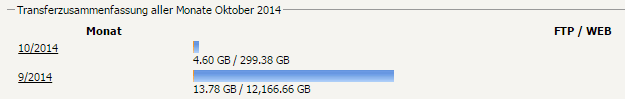

Das ganze sieht dann so aus:

Auffallend ist auch, dass ich immer so ein Grundrauschen von 100-1000MB habe. Dabei liegen auf dem Server und der Website vielleicht 1000-2000 stark komprimierte Bilder in einem html-Fotoalbum, die keinen interessieren dürften und mein Freundeskreis vielleicht 1-2 mal im Jahr in alten Erinnerungen schwelgen will

Wird das Grundrauschen durch irgendwelche Scan-Bots verursacht?

Auch auffallend ist, dass der extrem hohe Traffic vom Web aus verursacht wurde. Direkten Zugang zum FTP scheint also keiner zu haben, um diesen zu mißbrauchen.

Das Passwort habe ich natürlich jedes Mal sofort geändert!

Wer hat eine Vermutung, woher der extreme Traffic kommen kann, kurz nachdem ich größere Dateien hochgeladen habe?

Scannen da 1000 Firmen 24/7 das komplette Netz und laden alles 1000fach runter, was man findet?

Wer macht da ein Backup vom Internet?

all-inclusive-webspace meinte übrigens, dass es meine Schuld ist, wenn ich einen Link irgendwo poste und der dann immer wieder und wieder gepostet wird.

Wahrscheinlich gehen sie davon aus, dass ich irgendwelche Filme zum Download anbiete und es dann in irgendwelchen einschlägigen Foren poste... was ja auch nachvollziehbar ist, aber nun mal nicht zutrifft. Mehr konnten sie mir nicht sagen oder helfen, außer die Kündigung noch einmal auszusetzen.

Hat wer eine Idee?

Wie kann ich mich dagegen schützen, ohne auf Dropbox etc. auszuweichen?

Vielen Dank!

Andi

Ich besitze eine Domain und den dazugehörigen Webspace, der bei all-inclusive-webspace gehostet wird.

Dort liegen überwiegend alte Fotoalben (html Seiten), die ich dem Freundeskreis zur Verfügung stelle.

Üblicherweise gehe ich so vor:

- ich lade ein Video oder eine Bildersammlung auf den Webspace (.zip Archive), um sie den beteiligten Freunden zur Verfügung zu stellen

- die Archive sind 700MB - 1GB groß

- innerhalb von ein paar Tagen laden sich meine Freunde (5-10 Leute) die Datei runter

- danach lösche ich die Datei wieder

Jetzt hatte ich schon zwei Mal folgendes Problem:

- Im September habe ich ein 1GB großes Hochzeitsvideo hochgeladen, um es den Hochzeitsgästen zur Verfügung zu stellen

- innerhalb von 3 Tagen war meine Domain gesperrt, weil 12TB (!) Traffic verursacht wurden

- vergangenen Sonntag habe ich eine 700MB große .zip Datei hochgeladen, die Bilder vom Wochenende enthalten hat

- gestern wurde meine Domain wieder gesperrt, weil 300GB (!) Traffic verursacht wurden

Im ersten Fall bestand der Nutzerkreis vielleicht aus 15 Personen.

Im zweiten Fall waren es 3-4 Personen, die es laden sollten.

In jedem Fall nicht genug, um 12TB (!) Daten zu erreichen!

Nach dem zweiten Fall droht mir der Hoster nun mit der Kündigung, die ich noch abwenden konnte.

Aber beim nächsten Mal ist es dann soweit...

Ich habe den Link zu den Archiven immer direkt im Format http://domain.de/ordner/datei.zip per Whatsapp verschickt.

Ich habe es also in keinem öffentlichen Forum oder sonst wo gepostet!

Das ganze sieht dann so aus:

Auffallend ist auch, dass ich immer so ein Grundrauschen von 100-1000MB habe. Dabei liegen auf dem Server und der Website vielleicht 1000-2000 stark komprimierte Bilder in einem html-Fotoalbum, die keinen interessieren dürften und mein Freundeskreis vielleicht 1-2 mal im Jahr in alten Erinnerungen schwelgen will

Wird das Grundrauschen durch irgendwelche Scan-Bots verursacht?

Auch auffallend ist, dass der extrem hohe Traffic vom Web aus verursacht wurde. Direkten Zugang zum FTP scheint also keiner zu haben, um diesen zu mißbrauchen.

Das Passwort habe ich natürlich jedes Mal sofort geändert!

Wer hat eine Vermutung, woher der extreme Traffic kommen kann, kurz nachdem ich größere Dateien hochgeladen habe?

Scannen da 1000 Firmen 24/7 das komplette Netz und laden alles 1000fach runter, was man findet?

Wer macht da ein Backup vom Internet?

all-inclusive-webspace meinte übrigens, dass es meine Schuld ist, wenn ich einen Link irgendwo poste und der dann immer wieder und wieder gepostet wird.

Wahrscheinlich gehen sie davon aus, dass ich irgendwelche Filme zum Download anbiete und es dann in irgendwelchen einschlägigen Foren poste... was ja auch nachvollziehbar ist, aber nun mal nicht zutrifft. Mehr konnten sie mir nicht sagen oder helfen, außer die Kündigung noch einmal auszusetzen.

Hat wer eine Idee?

Wie kann ich mich dagegen schützen, ohne auf Dropbox etc. auszuweichen?

Vielen Dank!

Andi

Zuletzt bearbeitet: