HWL News Bot

News

Thread Starter

- Mitglied seit

- 06.03.2017

- Beiträge

- 114.393

... weiterlesen

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: this_feature_currently_requires_accessing_site_using_safari

Naja, deine Werte werden doch kaum mit Standardeinstellungen sein. Bei Tests die man Online findet liegen die Werte sehr deutlich unter deinen. Z.B. https://www.ultrabookreview.com/24809-acer-triton-500-review/Na ja - finde die Leistung überhaupt nicht zufriedenstellend.

Das sind Werte von einem 2019er ACER Triton 500 ( ebenfalls "thin & light") mit i7-8750H und 2080 MaxQ (80W)

3DMark 13 – Fire Strike: 16103 (Graphics – 19554, Physics – 13979);

3DMark 13 – Time Spy: 7064 (Graphics – 7421, CPU – 5551);

Das habe ich auch nicht behauptet... ;-)Naja, deine Werte werden doch kaum mit Standardeinstellungen sein. Bei Tests die man Online findet liegen die Werte sehr deutlich unter deinen. Z.B. https://www.ultrabookreview.com/24809-acer-triton-500-review/

Die Taktraten entsprechen der 80W Variante. Ich nehme mal an, 95W ergeben sich aus +15W Dynamic Boost.Unser Testmuster macht sich mit einem Grund- und Boost-Takt von 780, bzw. mindestens 1.245 MHz ans Werk. Damit schaffen es MSI und NVIDIA, die TGP im Notebook auf 95 W zu drücken. Technisch spezifiziert NVIDIA sein mobiles Spitzenmodell im Bereich von 80 bis 130 W.

www.notebookcheck.com

www.notebookcheck.com

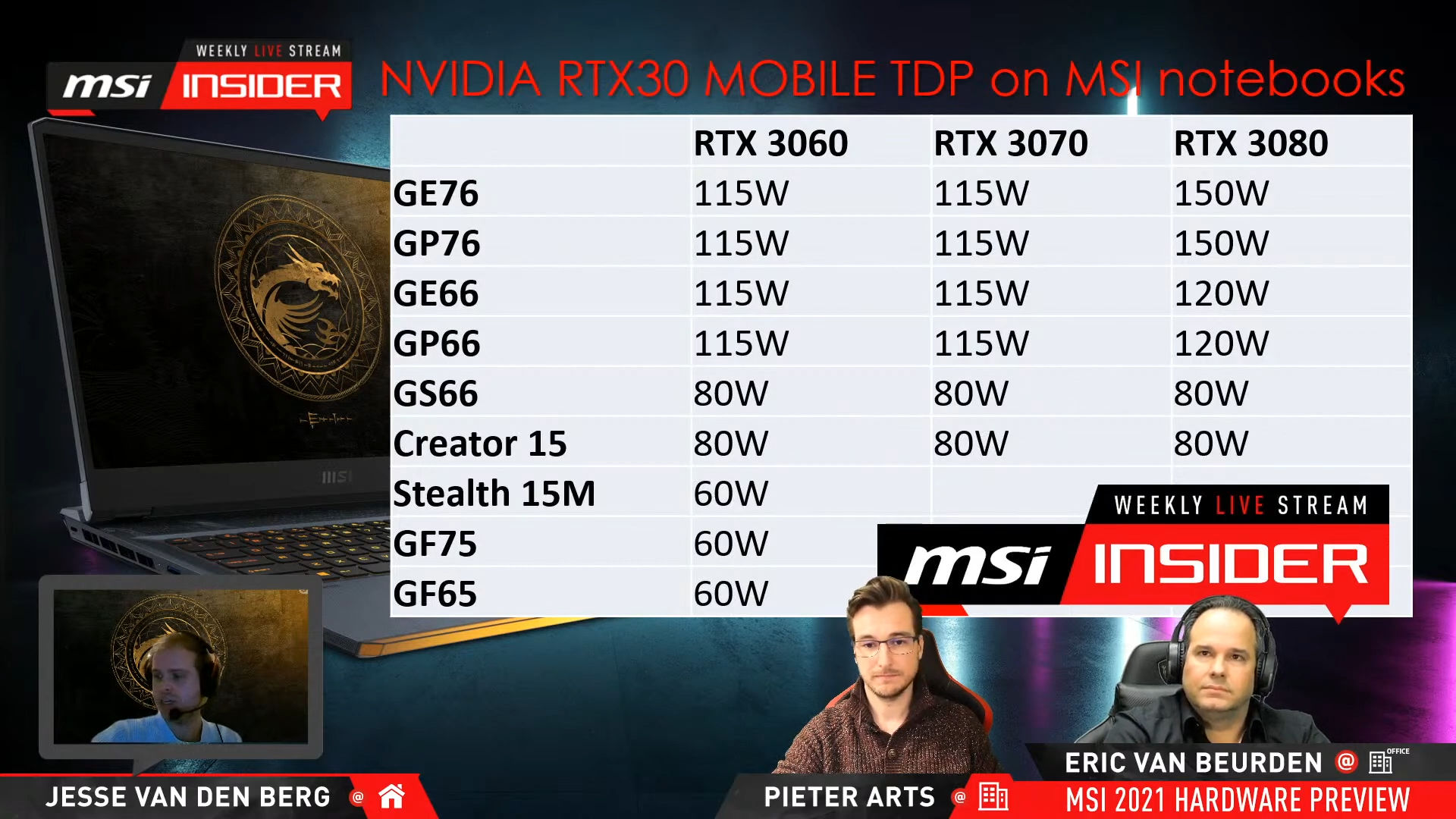

Hier kommt wohl der Widerspruch zu Tage, bei dem ein Tester auf das Wohlgefallen des Unternehmens angewiesen ist und sich hüten muss ein negatives Feedback zu äußern, gleichzeitig aber von einem professionellem Tester wie Ihnen, die Leserschaft Neutralität erwartet.Eine GeForce RTX 3070 mit einer spezifizieren TGP von 125 W kann schneller als eine vermeintlich höherwertigere GeForce RTX 3080 mit nur 95 W sein. Eine eindringlichere Recherche im Datenblatt wird beim Laptop-Kauf somit endgültig zur Pflicht.

Alle bisherigen Benchmark-Ergebnisse einer Reihe finden sich jeweils im letzten Artikel. Der MSI-Artikel wurde vorher erstellt, der Gigabyte ist der aktuellste – ein Quervergleich ist für die nächste, längst fällige Parcours-Umstellung geplant.@Stegan

Warum entfernen Sie die Ergebnisse des Gigabyte AORUS 15P XC aus Ihren eigenen Benchmarks?

Es bietet die gleiche Leistung (was wohl für viele der Käufer dieser Preisklasse das ausschlaggebende Argument sein sollte) und kostet weniger als die Hälfte.

Ganz einfach: Es sind Geräte mit unterschiedlicher Zielgruppe. Von einem dünnen, portablen Gerät, wie es das MSI-Modell ist, kann man keine Höchstleistung erwarten, schließlich stößt man Blick auf Kühlung und Stromversorgung auf gewissen Grenzen – die 150 W der von Dir gewünschten GPU müssen erst einmal abgeführt werden. Da tut sich das AORUS-Gerät nunmal leicht als das MSI-Modell. Die Barebones entscheiden letztendlich, welche TGPs eingesetzt werden (können).Warum wird nicht deutlich, ein negativer Punkt im Fazit gezogen, dass der Käufer hier beinahe 4000 € bezahlt, aber dafür solch niedrige Leistung erhält, vor allem Prozessor- und Spieleleistung, im Vergleich zu anderen Geräten?

Die Stromaufnahme der Grafikkarte wurde um fast 88 % reduziert. Der Kunde soll aber dazu verleitet werden fast 4000 € zu bezahlen.

Wann erhält der Käufer die hier verbaute Grafikkarte in der 150 W-Ausführung? Erst im 6000 € Notebook?

Wer kauft sich ein solches Gerät für 4000 €, blos damit es in den Abmessungen 2,5 cm hoch ist und schick aussieht? Es ist doch ein Spielenotebook; man möchte Leistung!

Die hier zitierte Kritik geht gegen NVIDIA, die letztendlich die Hardware liefern. MSI und Gigabyte basteln quasi das Produkt drumherum. Letzteres wurde getestet.Das ist Ihr negatives Fazit - in beschwichtigende Worte gehüllt; sacht formuliert.

Hier kommt wohl der Widerspruch zu Tage, bei dem ein Tester auf das Wohlgefallen des Unternehmens angewiesen ist und sich hüten muss ein negatives Feedback zu äußern, gleichzeitig aber von einem professionellem Tester wie Ihnen, die Leserschaft Neutralität erwartet.

Man sollte schon Äpfel mit Äpfeln vergleichen: Vorher war es eine RTX 2080 Max-Q, heute ist es einfach eine RTX 3080 ohne Namenszusatz, aber ebenfalls reduzierter TGP. Dass das für den Käufer nicht die beste Option ist, steht im Artikel. Der Schuldige ist aber NVIDIA, nicht MSI.

Den Preis machen am Ende nicht die reinen Hardware-Komponenten aus. Das MSI-Gerät bietet viele Vorzüge, die das Gigabyte-Modell nicht, das fängt schon alleine am Display mit der höheren Auflösung an und ich bin mir sicher, dass NVIDIA für die – nennen wir sie einfach Max-Q-Version – der Grafikkarte einen stattlichen Aufpreis zur RTX 3070 aufruft.

Die hier zitierte Kritik geht gegen NVIDIA, die letztendlich die Hardware liefern. MSI und Gigabyte basteln quasi das Produkt drumherum. Letzteres wurde getestet.

Das ist mir bewusst, wenn du mal hochscrollst. Trotzdem handelt es sich eben dabei um die 80W, nicht 95W Variante.15 W sind dem Dynamic Boost geschuldet

Der größte Beschiss ist aber noch Nvidia's Dynamic Boost. Dieser poliert oftmals nur Benchmark Ergebnisse auf und hat nichts mit Realword-Gaming zu tun, weil CPU und GPU in den bekannten 3D-Mark Benchmarks für sich alleine getestet werden und der Combined Test nur lächerliche 20 Sekunden geht (Firestrike). Was für'n glücklicher Zufall, dass Intels PL2 (TAU) oftmals aber min. 30 Sekunden anhält.Das ist vorsätzliche Täuschung und Be t r u g.

Das ist noch gar nichts... Die 3D-Mark Datenbank ist schon teilweise zugemüllt und Videocardz hat mittlerweile eine Auflistung von über 28 Notebooks GPU veröffentlicht und das ist noch längst nicht alles. Die Hersteller können auch noch nachträglich via BIOS Update das PL der GPU anpassen (falls sich zu viele User über hohe Temps beschwerenÄhm... diese angebliche Transparenz von Nvidia hat dazu geführt, dass ihr die 80W GPU als 95W im Artikel bezeichnet.

).

).Die Leistung entspricht weder einer 2080s von einem Lappy, noch von einem Desktop-PC. 3D-Mark Links/ Bilder habe ich alle da, falls gewünscht. Hier mal die Daten zum Vergleich:Die Leistung entspricht auf den Punkt einer 2080S.

3080 ist immer noch 50% schneller!

Turing Chips von den Desktop Karten waren äquivalent zu den Notebook Karten. Das hat sich mit Ampere aber deutlich geändert.Ne 3070 Desktop ist ja so gesehen das, was früher eine 80 Serie war ?