Simsi1986

Enthusiast

Thread Starter

- Mitglied seit

- 02.02.2003

- Beiträge

- 1.256

- Ort

- Aschaffenburg

- Desktop System

- Desktop PC

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 7950X

- Mainboard

- ASUS ROG Strix X670E-E Gaming WIFI

- Kühler

- Noctua NH-D15 chromax.black & 7x be quiet! Silent Wings 3 PWM High-Speed

- Speicher

- G.Skill Flare X5 32GB (2x16GB) DDR5-6000 CL32-38-38-96

- Grafikprozessor

- PowerColor Radeon RX 6900 XT (Referenz-Modell)

- Display

- 2x Dell G3223Q 32" UHD

- SSD

- Seagate FireCuda 530 NVMe 1TB & 4TB

- Soundkarte

- Onboard

- Gehäuse

- be quiet! Dark Base 700

- Netzteil

- be quiet! Dark Power 12 1000W

- Keyboard

- Logitech G815

- Mouse

- Logitech Pro X

- Betriebssystem

- Windows 11 22H2

- Webbrowser

- Microsoft Edge Chromium

- Sonstiges

- Logitech Pro X Wireless

- Internet

- ▼1 Gbit ▲50 Mbit

Servus,

nachdem mein Microserver N54L auf Basis von Windows Server 2019 bzw. die darauf betriebene VM mittlerweile aus dem letzten Loch pfeift und der Speicherplatz auch so langsam knapp wird, schaue ich hin und wieder nach Möglichkeiten für einen potentiellen Nachfolger. Nachdem weder HPE noch Dell kein Interesse haben, ein vergleichbares Konzept anzubieten bleibt mir am Ende nur der Eigenbau.

Der Nostalgie halber eine Übersicht der aktuellen Konfiguration:

geizhals.de

Onboard LAN ist deaktiviert, dafür ist auf der Dual-GBit Netzwerkkarte Switch Embedded Teaming aktiviert.

geizhals.de

Onboard LAN ist deaktiviert, dafür ist auf der Dual-GBit Netzwerkkarte Switch Embedded Teaming aktiviert.

Die SSD beheimatet das OS für Hyper-V und auf den beiden Raid1 Volumes liegt jeweils eine große VHDX bzw. auf einer auch die System-Platte der VM mit Server 2019 inkl. aktivierter Essentials Rolle.

Das 3rd Party Netzteil stammt noch aus einer Zeit als der Server auf dem Schreibtisch stand um die Lautstärke halbwegs erträglich zu gestalten - spielt für den neuen Server keine Rolle, da im Keller untergebracht.

Ursprünglich hatte ich die Idee, mir ein (bzw. das einzige verfügbare) X399 Mainboard von Asrock Rack zu holen und sowohl RAM als auch Threadripper CPU aus dem aktuellen Heimrechner zu recyclen. Da ich aber aber aus Kostengründen nicht gleichzeitig Heimserver und Heimrechner austauschen möchte konzentriere ich mich erstmal nur auf den Heimserver.

Grundsätzlich soll der neue Server auf Windows Server 2022 basieren und eine VM mit diesem Betriebssystem hosten. Dabei möchte ich Storage Spaces mit NVMEs als Cache nutzen und früher oder später auch die LAN-Anbindung auf 10 Gbit/s erweitern. Habe noch eine Radeon VII übrig, die ich für was auch immer mit verbauen möchte. Genauso wie Storage Spaces Direct eher zum Zweck des Heimlabors um mit den neuen Technologien von Microsoft "zu spielen" und Erfahrung für die Arbeit zu sammeln. Daher auch der massive Sprung in Bezug auf Speicherkapazität und Rechenleistung. Idealerweise baue ich das System und denke über Aufrüstung/Erneuerung nach wenn es nicht mehr anders geht

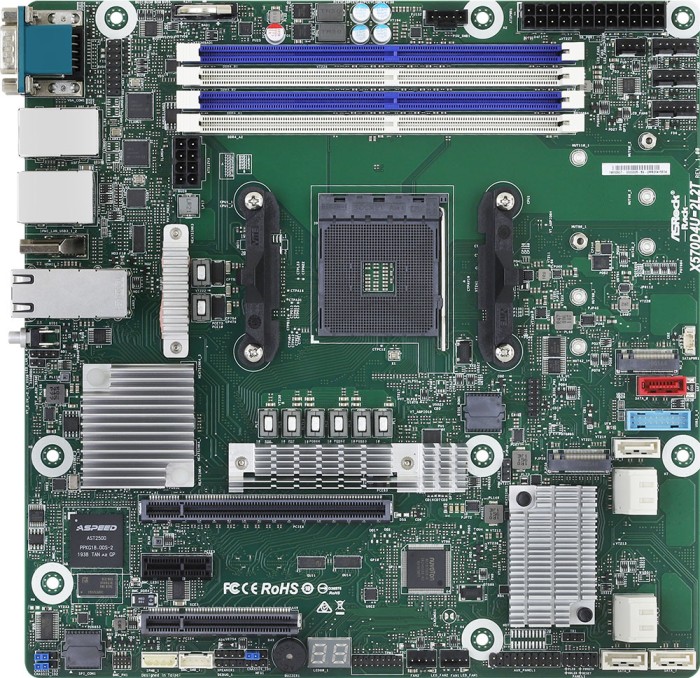

Vermutlich reicht auch ein Acht-Kern Epyc mehr als aus - die Anforderung von mindestens 16-Kernen basiert mehr auf psychologischen Gründen, dass der Heimserver nicht weniger Kerne haben darf als der Heimrechner

Nachfolgend die aktuelle Aufstellung mit der Bitte um Anregungen und Anpassungsvorschlägen - die NVMEs sind quasi vorhanden und sollen bloß weiterverwendet werden, daher auch keine PCIE 4.0 wobei dies für den Cache auch kaum ins Gewicht fallen sollte. Das µATX Board ist dem Gehäuse geschuldet - das größere ATX Modell von Silverstone hat weniger Platz für GPU und CPU-Kühler. Bei letzterem bin ich nicht sicher, ob der größere NH-U14S passt, sonst würde dieser in der Auflistung auftauchen. Beim Mainboard liegt das Augenmerk auch auf 2x 10 Gbit/s Onboard LAN und bin äußerst unsicher bzgl. des Prozessors bzw. dessen Kompatibilität. In den Ankündigungen steht noch etwas von Naples-Unterstützung, in den Datenblättern jedoch nur noch Rome und Milan. Ryzen wäre praktisch auch denkbar, preislich sehe ich dabei aber kein Ersparnis, sollte es bei 16 Kernen bleiben.

geizhals.de

1x ASRock Hyper Quad M.2 Card (90-MCA0G0-00UANZ)

geizhals.de

1x ASRock Hyper Quad M.2 Card (90-MCA0G0-00UANZ)

2x Seagate Exos X - X18 16TB, 512e/4Kn, SAS 12Gb/s (ST16000NM004J)

1x Crucial P5 SSD 1TB, M.2 (CT1000P5SSD8)

4x Crucial P5 SSD 2TB, M.2 (CT2000P5SSD8)

1x AMD Epyc 7351P, 16C/32T, 2.40-2.90GHz, tray (PS735PBEVGPAF)

4x Samsung RDIMM 32GB, DDR4-3200, CL22-22-22, reg ECC (M393A4G43AB3-CWE)

1x Broadcom SAS 9300-8i Kit, PCIe 3.0 x8 (LSI00345)

1x XFX Radeon VII, 16GB HBM2, HDMI, 3x DP (RX-VEGMA3FD6)

1x ASRock Rack ROMED6U-2L2T

1x SilverStone Air Penetrator 120i PRO, 120mm (SST-AP120i-PRO)

1x Noctua NH-U12S TR4-SP3

1x SilverStone Case Storage CS330 schwarz (SST-CS330B)

1x Corsair HX Series HX1000 80 PLUS Platinum 1000W ATX 2.4 (CP-9020139)

Vorab vielen Dank für konstruktive Beiträge.

nachdem mein Microserver N54L auf Basis von Windows Server 2019 bzw. die darauf betriebene VM mittlerweile aus dem letzten Loch pfeift und der Speicherplatz auch so langsam knapp wird, schaue ich hin und wieder nach Möglichkeiten für einen potentiellen Nachfolger. Nachdem weder HPE noch Dell kein Interesse haben, ein vergleichbares Konzept anzubieten bleibt mir am Ende nur der Eigenbau.

Der Nostalgie halber eine Übersicht der aktuellen Konfiguration:

MicroServer N54L Stand 2021 | Wunschlisten Geizhals Deutschland

MicroServer N54L Stand 2021 | Wunschlisten

Die SSD beheimatet das OS für Hyper-V und auf den beiden Raid1 Volumes liegt jeweils eine große VHDX bzw. auf einer auch die System-Platte der VM mit Server 2019 inkl. aktivierter Essentials Rolle.

Das 3rd Party Netzteil stammt noch aus einer Zeit als der Server auf dem Schreibtisch stand um die Lautstärke halbwegs erträglich zu gestalten - spielt für den neuen Server keine Rolle, da im Keller untergebracht.

Ursprünglich hatte ich die Idee, mir ein (bzw. das einzige verfügbare) X399 Mainboard von Asrock Rack zu holen und sowohl RAM als auch Threadripper CPU aus dem aktuellen Heimrechner zu recyclen. Da ich aber aber aus Kostengründen nicht gleichzeitig Heimserver und Heimrechner austauschen möchte konzentriere ich mich erstmal nur auf den Heimserver.

Grundsätzlich soll der neue Server auf Windows Server 2022 basieren und eine VM mit diesem Betriebssystem hosten. Dabei möchte ich Storage Spaces mit NVMEs als Cache nutzen und früher oder später auch die LAN-Anbindung auf 10 Gbit/s erweitern. Habe noch eine Radeon VII übrig, die ich für was auch immer mit verbauen möchte. Genauso wie Storage Spaces Direct eher zum Zweck des Heimlabors um mit den neuen Technologien von Microsoft "zu spielen" und Erfahrung für die Arbeit zu sammeln. Daher auch der massive Sprung in Bezug auf Speicherkapazität und Rechenleistung. Idealerweise baue ich das System und denke über Aufrüstung/Erneuerung nach wenn es nicht mehr anders geht

Vermutlich reicht auch ein Acht-Kern Epyc mehr als aus - die Anforderung von mindestens 16-Kernen basiert mehr auf psychologischen Gründen, dass der Heimserver nicht weniger Kerne haben darf als der Heimrechner

Nachfolgend die aktuelle Aufstellung mit der Bitte um Anregungen und Anpassungsvorschlägen - die NVMEs sind quasi vorhanden und sollen bloß weiterverwendet werden, daher auch keine PCIE 4.0 wobei dies für den Cache auch kaum ins Gewicht fallen sollte. Das µATX Board ist dem Gehäuse geschuldet - das größere ATX Modell von Silverstone hat weniger Platz für GPU und CPU-Kühler. Bei letzterem bin ich nicht sicher, ob der größere NH-U14S passt, sonst würde dieser in der Auflistung auftauchen. Beim Mainboard liegt das Augenmerk auch auf 2x 10 Gbit/s Onboard LAN und bin äußerst unsicher bzgl. des Prozessors bzw. dessen Kompatibilität. In den Ankündigungen steht noch etwas von Naples-Unterstützung, in den Datenblättern jedoch nur noch Rome und Milan. Ryzen wäre praktisch auch denkbar, preislich sehe ich dabei aber kein Ersparnis, sollte es bei 16 Kernen bleiben.

Heimserver Selfmade Epyc | Wunschlisten Geizhals Deutschland

Heimserver Selfmade Epyc | Wunschlisten

2x Seagate Exos X - X18 16TB, 512e/4Kn, SAS 12Gb/s (ST16000NM004J)

1x Crucial P5 SSD 1TB, M.2 (CT1000P5SSD8)

4x Crucial P5 SSD 2TB, M.2 (CT2000P5SSD8)

1x AMD Epyc 7351P, 16C/32T, 2.40-2.90GHz, tray (PS735PBEVGPAF)

4x Samsung RDIMM 32GB, DDR4-3200, CL22-22-22, reg ECC (M393A4G43AB3-CWE)

1x Broadcom SAS 9300-8i Kit, PCIe 3.0 x8 (LSI00345)

1x XFX Radeon VII, 16GB HBM2, HDMI, 3x DP (RX-VEGMA3FD6)

1x ASRock Rack ROMED6U-2L2T

1x SilverStone Air Penetrator 120i PRO, 120mm (SST-AP120i-PRO)

1x Noctua NH-U12S TR4-SP3

1x SilverStone Case Storage CS330 schwarz (SST-CS330B)

1x Corsair HX Series HX1000 80 PLUS Platinum 1000W ATX 2.4 (CP-9020139)

Vorab vielen Dank für konstruktive Beiträge.

Zuletzt bearbeitet: