Dann wärs das Beste den PC ganz aus zulassen -> spart noch mehr Strom

Wer wirklich 2h im Schnitt jeden Tag 365 Tage im Jahr zockt- gibt eh schon mindestens 90€ im Jahr für den Strom seines PCs aus...

ob das jetzt 81€ oder 99€ sind sollte für jemanden der 300€ in ne GPU versenkt nicht DER entscheidende Punkt sein.

Wenn ich das Produkt dafür 6 Monate länger nutzen kann hat man den Unterschied eh schon wieder rausgeholt.

Als ich 2012 eine 7970 gekauft hatte, war der Stromverbrauch auch das Argument für die GTX680 -> rückblickend glaub ich nicht, dass es eine falsche Entscheidung war

-> heißt nicht dass 970vs390 dasselbe passiert.

Diverse Tests "messen" gerne mit so putzigen Mess-Zwischenstecker -> empfehle da wirklich mal die THG Artikel

Gerade seit Maxwell ist das ganze ja nicht mehr so einfach.

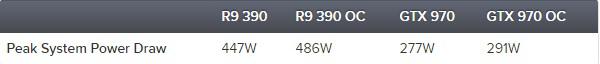

Sinds "nur" mehr 75W wären wir bei 13,5€ im Jahr oder 1,13€ im Monat... ich glaub kann man auch zu ner AMD greifen wenn Mami und Papi einem nicht die Stromrechnung bezahlen

Und das wohlgemerkt immer noch bei 730h -> wer seine Rechnungen selber zahlt wird eher nicht in diesen Bereichen landen...

Effizienz ist eine schöne Sache, wird aber gerne überbewertet.

Besser 10min der Zockzeit an die frische Luft gehen

.

.