Nvidia GeForce 280 GTX "Sammel-Thread + FAQ" Bitte bei Fragen die erste Seite lesen 5

Nvidia GeForce 280 GTX Sammelthread

Technische Daten der 280 GTX - G200

Erste Tests der Karte

Geizhals Links (zu erwartende Preise zwischen 450€-600€)

Taktraten der vorübertakteten Modelle (Reihenfolge GPU/ Shader/ VRAM):

Treiber

Tools

Wie laut ist die Karte?

Wie hoch ist der Stromverbrauch?

Wie heiss darf meine Karte werden?

Passt die Karte in mein Gehäuse?

Wie gut läßt sich die Karte übertakten?

Videobeschleunigung

Performance

PhysX by NVIDIA - GeForce PhysX

Andere Kühllösungen

Danke Snoopy

Allgemeine Hinweise

Um das Geflame, Gespame oder sonstige Unannehmlichkeiten zu minimieren wird gebeten im Falle eines Versoßes den „Beitrag-melden“ - Button (

) zu benutzen! Natürlich auch im Falle eines Verstoßes der Forenregeln!

) zu benutzen! Natürlich auch im Falle eines Verstoßes der Forenregeln!

Solche Beiträge oder nicht Themenbezogene Beiträge werden dann entfernt.

Der erste Post sollte immer aktuell gehalten werden. Sollte er einmal nicht aktualisiert worden sein, dann meldet euch per PN bei mir oder bei den anderen zuständigen Moderatoren!

Grüße der Froggi

Nvidia GeForce 280 GTX Sammelthread

Technische Daten der 280 GTX - G200

- Chip = G200

- Fertigung = 65 nm

- Chip Größe = 576 mm²

- Transistoren = ca. 1.400 Mio.

- Chiptakt = 602 MHz

- Shadertakt = 1.296 MHz

- Pixel-Pipelines = keine

- Shader-Einheiten (MADD) = 240 (1D)

- FLOPs (MADD/ADD) = 933 GFLOPs

- ROPs = 32

- Pixelfüllrate = 19.264 MPix/s

- TMUs = 80

- TAUs = 80

- Texelfüllrate = 48.160 MTex/s

- Vertex-Shader = kein

- Unified-Shaderin Hardware = √

- Pixelshader = SM 4

- Vertexshader = SM 4

- Geometryshader = √

- Memory

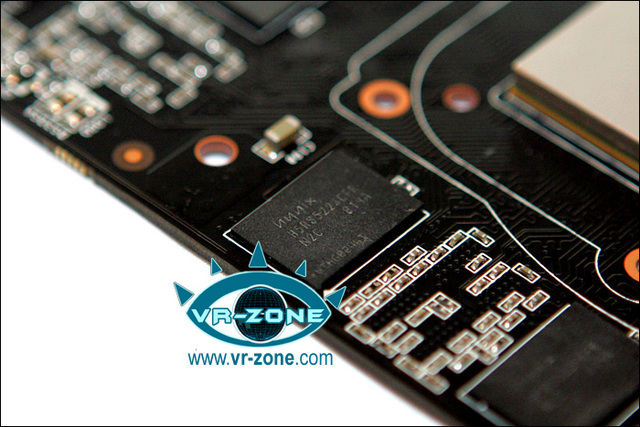

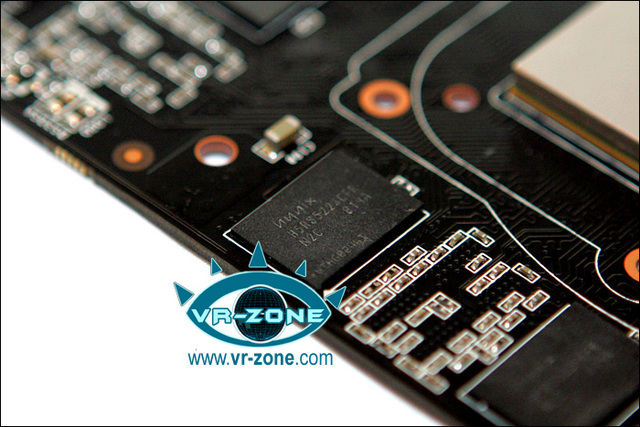

- Art = Hynix

- Speichermenge = 1.024 MB GDDR3

- Speichertakt = 1.107 MHz

- Speicherinterface = 512 Bit

- Speicherbandbreite = 141.696 MB/s

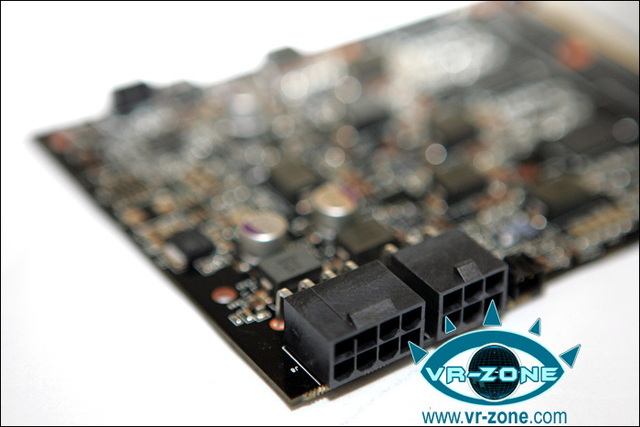

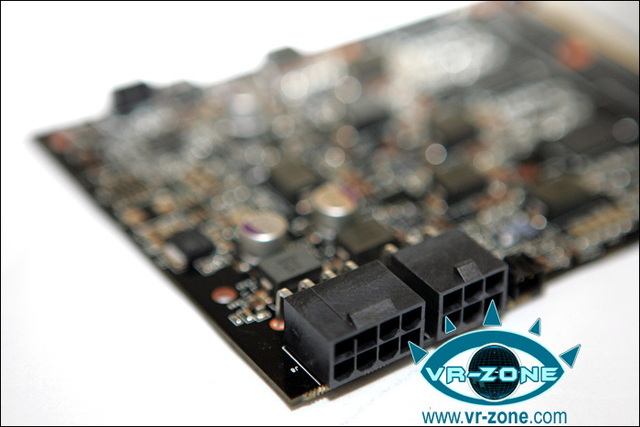

- Stromaufnahme >>> 236 Watt TDP (über einen 6xpin und 8xpin Anschluß)

- Die Karte besitzt nur Shader 4.0, dass heißt keine DX10.1 unterstützung!

- Die Karte nutzt PCIe 2.0, ist aber völlig abwärtskompatibel.

Erste Tests der Karte

Code:

[URL="http://www.pcgameshardware.de/aid,647678/News/Nvidia_Geforce_GTX_280_Alle_PCGH-Tests_im_Ueberblick/"]PCGamesHardware (deutsch)[/URL]

[URL="http://www.computerbase.de/artikel/hardware/grafikkarten/2008/test_nvidia_geforce_gtx_280_sli/#abschnitt_einleitung"]Computerbase (deutsch)[/URL]

[URL="http://www.guru3d.com/article/geforce-gtx-280-review-test/"]Guru 3d (englisch)[/URL]

[URL="http://www.extremetech.com/article2/...2320089,00.asp"]Extremtech (englisch)[/URL]

[URL="http://www.pcper.com/article.php?aid=577"]PC Perpective (englisch)[/URL]

[URL="http://techreport.com/articles.x/14934"]Techreport (englisch)[/URL]

[URL="http://anandtech.com/video/showdoc.aspx?i=3334"]Andtech (englisch)[/URL]

[URL="http://www.hexus.net/content/item.php?item=13736"]Hexus (englisch)[/URL]

[URL="http://www.neoseeker.com/Articles/Hardware/Reviews/gtx280/"]Neoseeker (englisch)[/URL]

[URL="http://www.overclock3d.net/reviews.p..._msi_n280gtx/1"]Overclocker3d net (englisch)[/URL]

[URL="http://enthusiast.hardocp.com/article.html?art=MTUxOCwxLCxoZW50aHVzaWFzdA=="]Enthusiast (englisch)[/URL]

[URL="http://www.hothardware.com/Articles/NVIDIA_GeForce_GTX_280_and_GTX_260_Unleashed/"]HotHardware (englisch)[/URL]

[URL="http://www.tomshardware.com/reviews/...-280,1953.html"]TomsHardware (englisch)[/URL]

[URL="http://www.hardwarecanucks.com/forum/hardware-canucks-reviews/7972-evga-geforce-gtx-280-1gb-superclocked-review.html"]Hardware Canucks (englisch)[/URL]

[URL="http://www.hardwarezone.com/articles...?cid=3&id=2593"]Hardwarezone (englisch)[/URL]

[URL="http://benchmarkreviews.com/index.php?option=com_content&task=view&id=179&Itemid=1"]Benchmarkreviews (englisch)[/URL]

[URL="http://www.firingsquad.com/hardware/nvidia_geforce_gtx_280_260_performance/"]Firingsquad (englisch)[/URL]

[URL="http://www.techpowerup.com/reviews/Zotac/GeForce_GTX_280_Amp_Edition/"]TechPowerUp (englisch)[/URL]

[URL="http://www.legitreviews.com/article/726/1/"]Legitreviews (englisch)[/URL]

[URL="http://www.nvnews.net/reviews/geforce_gtx_280/index.shtml"]NVnews (englisch)[/URL]

[URL="http://www.bjorn3d.com/read.php?cID=1293"]Bjorn3D (englisch)[/URL]

[URL="http://www.driverheaven.net/reviews.php?reviewid=579"]Driverhaven (englisch)[/URL]

[URL="http://www.hardwaresecrets.com/article/570"]HardwareSecrets (englisch)[/URL]

[URL="http://www.elitebastards.com/cms/index.php?option=com_content&task=view&id=577&Itemid=31"]EliteBastards (englisch)[/URL]

[URL="http://www.tweaktown.com/reviews/1464/zotac_geforce_gtx_280_amp_edition/index.html"]TweakTown (englisch)[/URL]Geizhals Links (zu erwartende Preise zwischen 450€-600€)

Code:

[URL="http://preisvergleich.hardwareluxx.de/?fs=280+gtx"]Hwluxx Geizhals Link[/URL]Taktraten der vorübertakteten Modelle (Reihenfolge GPU/ Shader/ VRAM):

Code:

[LIST]

[*]-

[*]-

[*]-

[*]-

[*]-

[*]-

[*]-

[*]-

[*]-

[*]-

[*]-

[/LIST]Treiber

Code:

Alle Infos und neuste Treiber findet ihr in diesem Thread [URL="http://www.forumdeluxx.de/forum/showthread.php?t=346738"]hier[/URL]Tools

Code:

[URL="ftp://download.nvidia.com/downloads/...MedusaInst.exe"]Nvidia Tech Demo Medusa[/URL]

[COLOR="Red"][B]Grafikkarten Analyse Tool Gpu-Z[/B][/COLOR] [URL="http://www.techpowerup.com/downloads/811/TechPowerUp_GPU-Z_v0.0.9.html"]hier[/URL]

[B][COLOR="Red"]

RivaTuner zum OC der Graka[/COLOR][/B] [url=http://downloads.guru3d.com/downloadget.php?id=163&file=5&evp=2d213e528fb556c354432a3976bff55a]hier[/url]

[B][COLOR="Red"]AtiTool zum OC der Graka[/COLOR][/B] [url=http://www.computerbase.de/downloads/software/systemprogramme/grafikkarten/atitool/]hier[/url]FAQ

Wie laut ist die Karte?

- Zum Thema Lüfter konnte Nvidia in der Vergangenheit immer gut Punkten, leider ist ihnen das bei diesem Transistormonster dieses mal nicht so gut geglückt. Aufgrund der ernomen größe der GPU und der starken wärme Abgabe muß der Kühler dieses mal einiges mehr Leisten, was ihn in der Lautstärke Rangliste diesmal leider keine so guten Punkte einbringt wie gewohnt. Selbst im Idle muß die Karte diesmal einen Platz hinter dem 2GPU Konkurrenten der ATI 3870X2 einnehmen. Unter Last zeichnet sich das gleiche Bild ab, dass ganze war aber eigentlich ab zu sehen. Irgendwie muß die hohe Abwärme ja raus geblasen werden. Für Silent Freaks ist die Karte wohl so diesmal nicht zu empfehlen.

Anleitung zur Lüftersteuerung über RivaTuner

- Da vieler User grade an der Lüftersteuerung vom RivaTuner basteln um der Karte etwas das schwitzen auszutreiben findet ihr im 3DForum dazu eine Hilfestellung. Zu finden Hier

- Ansonsten findet ihr im Sammelfred zum RivaTuner hier alle wichtigen Infos. Danke Ralf_1

Wie hoch ist der Stromverbrauch?

- Lange war bei Nvidia der fehlende 2D Modus ein Kritikpunkt der G80 Reihe und der G92 Nachfolger. Die Karten verschwendeten leider immer Energie, was angesicht der aktuellen Strompreise wirklich Anlass zu Kritik bot. Nun hat es Nvidia mit der neuen Generation der 260 - 280 GTX geschafft hierbei nach zu bessern. So ist der Idle Stromverbrauch auf ein für dieses Monster akzeptables Niveau gesunken. Leider konnte NVidia dies im Last Modus nicht bewerkstelligen und so stellt die neue Grafikkarte gleichzeitig auch einen neuen Negativrekord auf. Noch nie zuvor hat eine Single GPU Grafikkarte unter Last soviel Strom konsumiert. Sie liegt damit dicht an ihren Dual GPU Pendanten.

Wie heiss darf meine Karte werden?

- Wie uns die Lautstärke der Lüfters erahnen lässt ist die Karte im IDLE Modus relativ kühl, dass ganze haben wir wohl auch dem endlich von NVidia intigriertem Stromsparmodus zu verdanken. Selbst unter Last ist die Karte mit 80° Grad für so eine GPU noch relativ kühl. Das lässt eventuell spielraum den Lüfter noch etwas zu drosseln um die Lautstärke zu senken.

Passt die Karte in mein Gehäuse?

- Wie bereits bekannt, entspricht die Karte mit ihren Abmaßen in etwa denen der alten G80-GTX oder der GX2. Wer die 28cm der bisherigen Karten aufnehmen konnte, wird auch bei diesem Stück keine Probleme haben.

Wie gut läßt sich die Karte übertakten?

- coming soon....

Übertaktbarkeit:

coming soon....

Videobeschleunigung

- coming soon....

Performance

PhysX by NVIDIA - GeForce PhysX

- Mit der aktuelle GForce Generation bringt führt Nvidia nun auch das von ihnen aufgekaufte PhysX ein, nun aber können Nutzer einer GeForce-8- und -9-Grafikkarte von den Erweiterungen durch PhysX profitieren. Für Unreal Tournament (extra Mod mit extra PhysX Karten) und 3DMark Vantange besteht zur aktuellen Zeitpunkt eine unterstützung. Unser Hardwareluxx Redakteur *Andreas Schilling* hat für euch ein paar Benchmarks erstellt.Den ganzen Artikel findet ihr unter diesem Link -> http://www.hardwareluxx.de/cms/artikel.php?action=show&id=621&seite=1

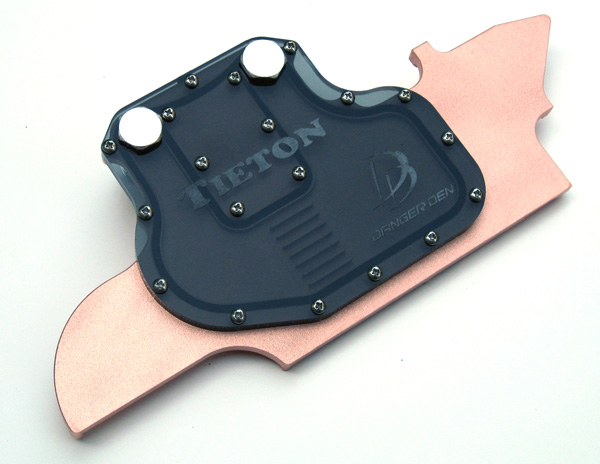

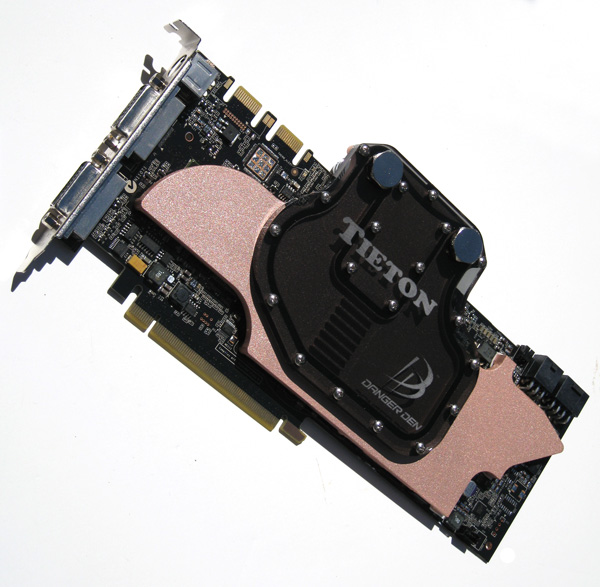

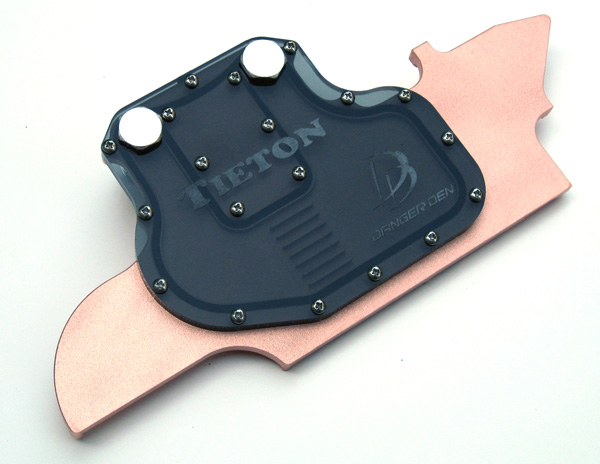

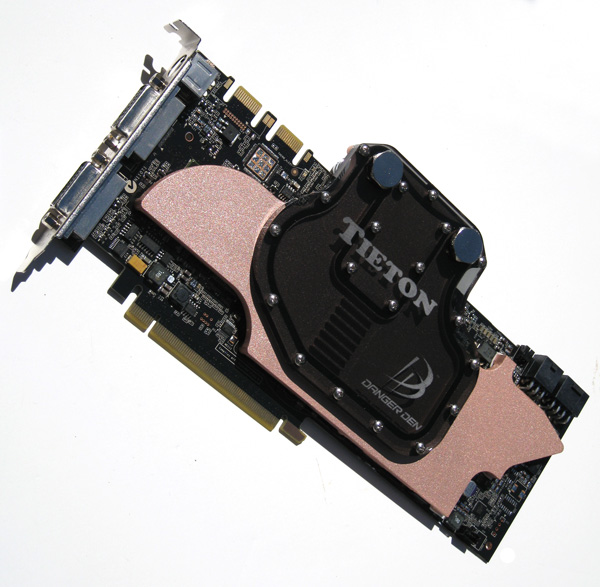

Andere Kühllösungen

- In diesem Thread -> hier, findet ihr die ersten Wasserkühler zu der neuen 280er GTX.

Danke an den User Shoggy für diese Infos.

Und hier der Rest des GPU-X² R670. Der Hauptblock ist für den G200 gleich http://www.pcmasters.de/hardware/review/watercoll-heatkiller-gpu-x2-r670.html

http://www.watercool.de/cms/forumpics/gpu_x2_g200_1.jpg

http://www.watercool.de/cms/forumpics/gpu_x2_g200_2.jpg

http://www.watercool.de/cms/forumpics/gpu_x2_g200_3.jpg

http://www.watercool.de/cms/forumpics/gpu_x2_g200_4.jpg

EK-FC280 GTX SLI

http://ekwaterblocks.com/shop/produ...d=279&osCsid=34d33c974a90de5797597830f31369a8

EK-FC280 GTX SLI - Acetal

http://ekwaterblocks.com/shop/product_info.php?cPath=21_31_42&products_id=280

EK-FC280 GTX SLI - Nickel plated

http://ekwaterblocks.com/shop/product_info.php?cPath=21_31_42&products_id=281

EVGA GTX280-HC

http://www.xtremesystems.org/forums/showpost.php?p=3070050&postcount=1

Danke Snoopy

Allgemeine Hinweise

Um das Geflame, Gespame oder sonstige Unannehmlichkeiten zu minimieren wird gebeten im Falle eines Versoßes den „Beitrag-melden“ - Button (

Solche Beiträge oder nicht Themenbezogene Beiträge werden dann entfernt.

Der erste Post sollte immer aktuell gehalten werden. Sollte er einmal nicht aktualisiert worden sein, dann meldet euch per PN bei mir oder bei den anderen zuständigen Moderatoren!

Grüße der Froggi