y33H@

Enthusiast

Thread Starter

- Mitglied seit

- 14.05.2007

- Beiträge

- 2.704

Inhalt

1) Einleitung

Aktuell bietet der Markt bis 150€ eine Menge an verfügbaren Karten, welche um die Gunst des Käufers buhlen. Doch wo bekommt man die meisten Leistung, und das auch noch möglichst günstig? "Kauf dir eine X1950Pro, die gibts mit Versand als leise Version (zB die Powercolor) ab 120€" lautet meistens die Antwort. Doch in den letzten Wochen ist eine der schon gerne als veraltet und langsam verschrieenen Geforce 7900GS Karten ins Licht der Zocker gerückt, die (recht laute) XFX 7900GS 600M, erhältlich für 105€. Ob sie der X1950Pro Paroli bieten kann und wie sie sich gegen allerhand andere GPUs schlägt, zeigt das folgende RoundUp.

2) Technische Details

Die X19x0 GPUs kommen mit gewaltiger Shaderpower und hohem Stromverbrauch daher, liegen aber in Sachen GTex/s und Bandbreite teils deutlich hinter der Konkurrenz. Die 7900GS und 7900GT differenzieren sich nur in der Anzahl der Pixel Pipelines und den Vertex Einheiten, hier ist ein Vergleich besonders interessant. XFX poliert mit dem auf satte 600MHz erhöhten Chiptakt das Manko der 7900GS - die vergleichsweise niedrigen GFLOP/s - aus und bietet zudem die größte Speicherbandbreite.

3) Testsystem

4) Benchmarks und Performancerating

FEAR

Half Life² - Lost Coast

Hier werden nun sämtliche Ergebnisse gemittelt und man kann das durchschnittliche Potenzial der jeweiligen GPU ablesen - der 3D Mark und Crysis bleiben außen vor.

Das Resultat ist eindeutig, die XFX ist einer 7950GT absolut ebenbürtig, beide müssen sich aber um bis zu 12% der X1950Pro geschlagen geben, zur X1900XT fehlen 39%. Letztere kann sich um maximal 24% vom kleinen Bruder X1950Pro lösen, die langsamste X19x0, die GT, ordnet sich maximal 11% hinter der Pro-Version ein. Die normale 7900GS unterliegt aufgrund der fehlenden Funktionseinheiten der 7900GT um rund 9%, die von XFX aufgedonnerte Version schnellt mit 20% weit davon. Auch die 512Mb der 7950GT machen sich dezent bemerkbar, die minimum fps sind mit fordernden Settings etwas höher. Das die Unterschiede nicht deutlicher ausfallen, liegt vor allem an den beiden Spielen UT3 und WiC, hier bremst der verwendete Prozessor alle Karten aus und limitiert die Benchmarks.

5) Schlusswort

XFX hat eine interessante Karte in petto, die Radeon X1950Pro ist rund 15€ teurer, jeodch 12% schneller. Die leicht schlechtere Bildqualität der Geforce verblasst nahezu, denn für anisotrope Filterung und Kantenglättung fehlt ohnehin oft genug die Power, gerade bei aktuellen Titeln. Als Manko bleibt eindeutig der laute Lüfter, ein Zalman VF-700Cu sorgt hier für Ruhe, aber auch einen 15€ höheren Preis - hierfür bekommt man schon eine leise Palöit X1950GT/512. Wer ein klein wenig sparen möchte, ein schwaches Netzteil und schlechte Ohren hat und ohnehin nur in 1024*768 spielt, kann zur XFX greifen, der Rest hält sich an die übliche Antwort: "Kauf dir eine X1950Pro (oder X1950GT^^)".

cYa

Kritik und Feedback wie immer erwünscht!

An dieser Stelle geht noch ein Dankeschön an Felix "BurnoutHerbert" E., John V. und Tom W. für die Bereitstellung ihrer Grafikkarten!

1) Einleitung

2) Technische Details

3) Testsystem

4) Benchmarks und Performancerating

5) Schlusswort

2) Technische Details

3) Testsystem

4) Benchmarks und Performancerating

5) Schlusswort

1) Einleitung

Aktuell bietet der Markt bis 150€ eine Menge an verfügbaren Karten, welche um die Gunst des Käufers buhlen. Doch wo bekommt man die meisten Leistung, und das auch noch möglichst günstig? "Kauf dir eine X1950Pro, die gibts mit Versand als leise Version (zB die Powercolor) ab 120€" lautet meistens die Antwort. Doch in den letzten Wochen ist eine der schon gerne als veraltet und langsam verschrieenen Geforce 7900GS Karten ins Licht der Zocker gerückt, die (recht laute) XFX 7900GS 600M, erhältlich für 105€. Ob sie der X1950Pro Paroli bieten kann und wie sie sich gegen allerhand andere GPUs schlägt, zeigt das folgende RoundUp.

2) Technische Details

Die X19x0 GPUs kommen mit gewaltiger Shaderpower und hohem Stromverbrauch daher, liegen aber in Sachen GTex/s und Bandbreite teils deutlich hinter der Konkurrenz. Die 7900GS und 7900GT differenzieren sich nur in der Anzahl der Pixel Pipelines und den Vertex Einheiten, hier ist ein Vergleich besonders interessant. XFX poliert mit dem auf satte 600MHz erhöhten Chiptakt das Manko der 7900GS - die vergleichsweise niedrigen GFLOP/s - aus und bietet zudem die größte Speicherbandbreite.

3) Testsystem

- 7900GS/256 (450/660)

- 7900GT/256 (450/660)

- XFX 7900GS 600M/256 (600/800)

- 7950GT/512 (550/700)

- X1950GT/256 (500/600)

- X1950Pro/256 (575/690)

- X1900XT/512 (621/720)

- Intel Core2Duo E6300 @ 2.4GHz

- 2 x 1024Mb DDR2-667 CL5

- Intel 965P Chipsatz

- Windows XP Professional SP2 32Bit

- Forceware 162.18 (Hohe Qualität, Optimierungen aus)

- Catalyst 7.10 (A.I. Standard, Optimierungen aus)

4) Benchmarks und Performancerating

Verwendete Benchmarks:

Verwendete Settings (alle bei maximalen Details):

- 3D Mark 06 v1.0.2 free

- Call of Duty 2 v1.3 (Echtzeit-Demo)

- Crysis SP Demo (integrierter GPU-Benchmark)

- FEAR v1.07 (integrierter Benchmark)

- Half Life² - Lost Coast (Echtzeit-Demo)

- Prey v1.1 (Timedemo)

- Unreal Tournament 3 Demo Beta (Deathmatch mit 5 Bots)

- World in Conflict Demo (integrierter Benchmark)

Verwendete Settings (alle bei maximalen Details):

- 1024*768

- 1280*1024

- 1280*1024 mit AA/AF (UT3 mangels AA mit 16:1 AF; Crysis ohne AA/AF, da sonst unspielbar)

3D Mark 06

Futuremarks synthetischer Klassiker darf natürlich nicht fehlen. Zwar verfügt er über keine reelle Spieleengine, so dass die Ergebnisse teils mit Vorsicht zu genießen sind, bildet aber einen guten Maßstab um schnell und einfach eine Leistungsprognose abgeben zu können. Die CPU erreicht hierbei einen Score von 2066 Punkten.

Die 7900GS, 7900GT und X1950GT sind abgeschlagen, die X1950Pro kratzt an der 5000 Punkte Marke und verfehlt somit knapp das Treppchen. Die 7950GT kann sich gerade einmal 2% von der XFX absetzen, die X1900XT ist der klare Sieger.

Die 7900GS, 7900GT und X1950GT sind abgeschlagen, die X1950Pro kratzt an der 5000 Punkte Marke und verfehlt somit knapp das Treppchen. Die 7950GT kann sich gerade einmal 2% von der XFX absetzen, die X1900XT ist der klare Sieger.

Call of Duty 2

Das Release von Infinity Wards zweitem Streich ist zwar nicht ganz so lange her wie der zweite Weltkrieg, der Shooter bietet aber noch immer eine detaillierte Optik und fordert insbesondere die Grafikkarte. Die Timedemo zeigt den Angriff der Briten auf das kleine Küstenstädtchen Al Daba und zehrt mit der Darstellung von volumetrischem Rauch, heftigen Explosionen und massivem Sperrfeuer sehr an den Ressourcen der GPUs.

Ohne AA/AF setzen sich die Radeons an die Spitze, gefolgt von der 7950GT und der kaum langsameren XFX. Zieht die grafische Qualität an, rücken aber alle Karten näher zusammen, praktisch ist 1280*1024 mit 4xAA und 8:1AF aber nur auf der X1900XT halbwegs flüssig spielbar, unter 45fps sind einfach zu wenig für diesen flotten Shooter. Nur dank den 512Mb lässt die 7950GT die XFX knapp hinter sich, kein Wunder, die Timedemo schluckt 290Mb VRAM.

Ohne AA/AF setzen sich die Radeons an die Spitze, gefolgt von der 7950GT und der kaum langsameren XFX. Zieht die grafische Qualität an, rücken aber alle Karten näher zusammen, praktisch ist 1280*1024 mit 4xAA und 8:1AF aber nur auf der X1900XT halbwegs flüssig spielbar, unter 45fps sind einfach zu wenig für diesen flotten Shooter. Nur dank den 512Mb lässt die 7950GT die XFX knapp hinter sich, kein Wunder, die Timedemo schluckt 290Mb VRAM.

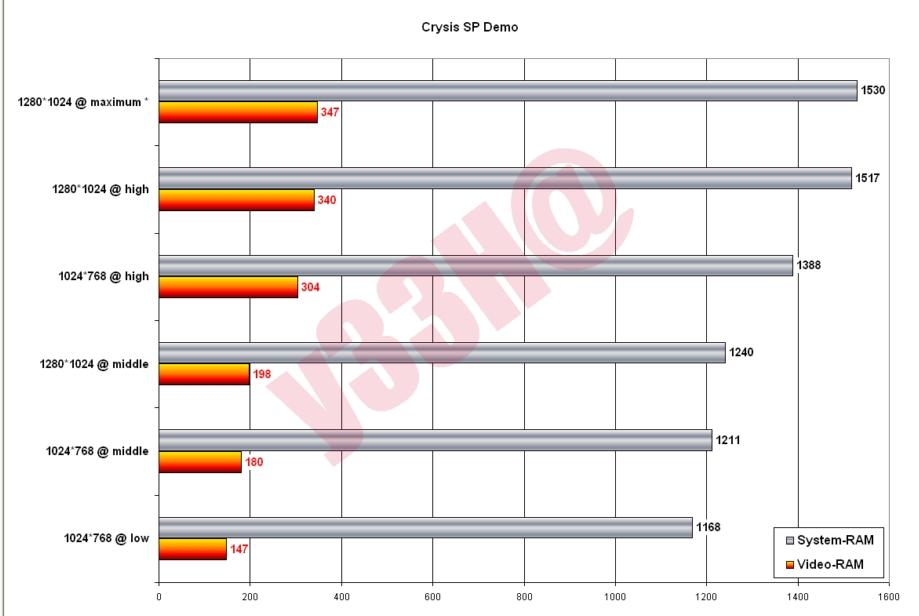

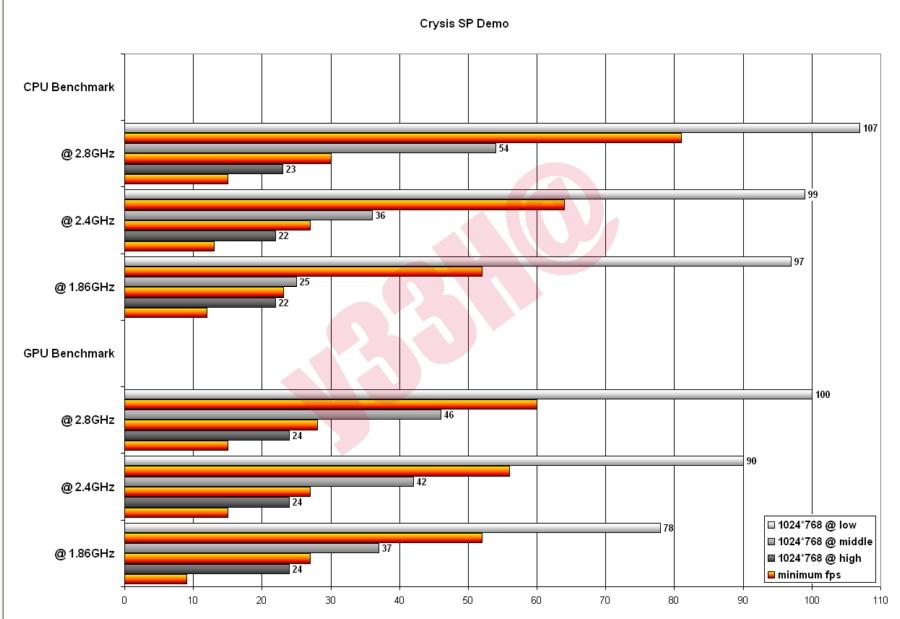

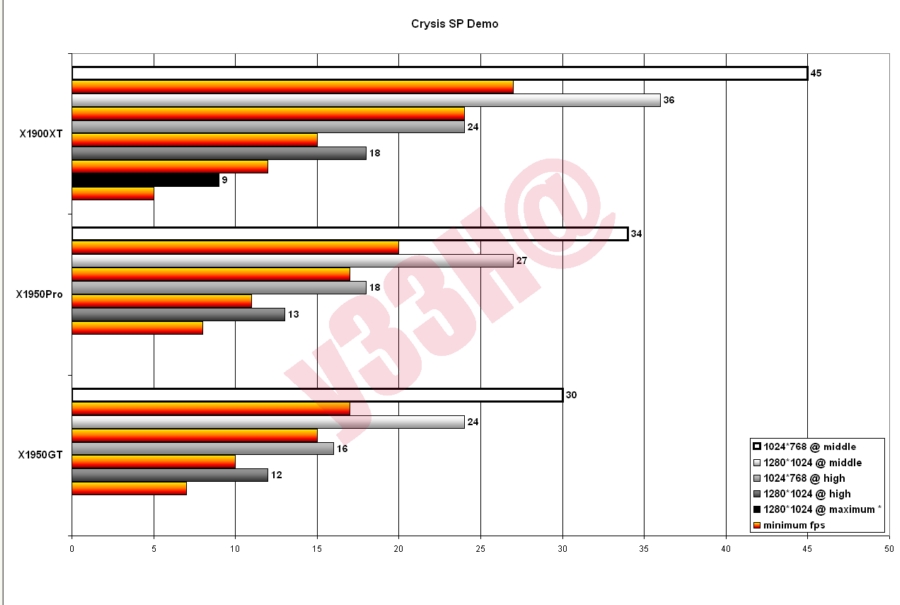

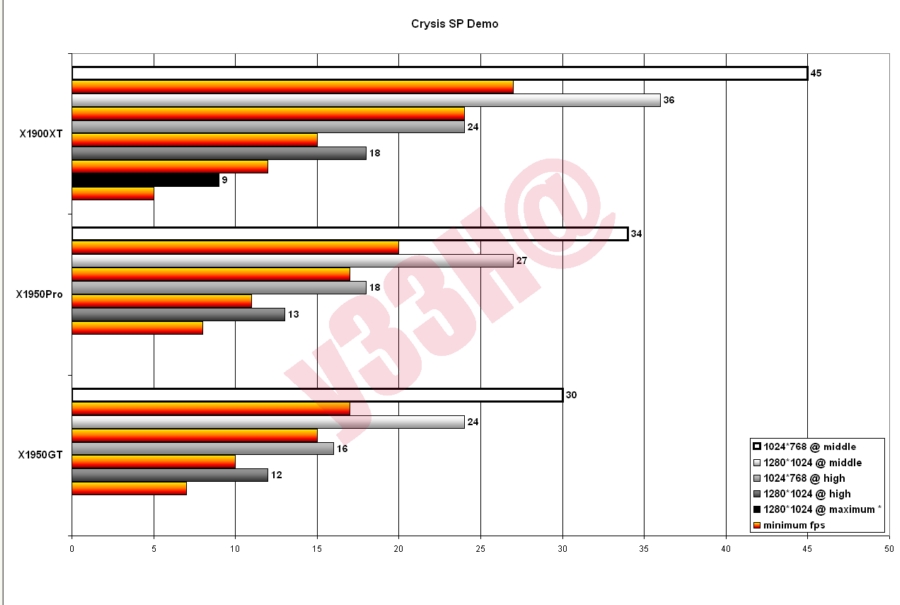

Crysis

Warum stirbt man in Crysis trotz Nano Suit schneller als man Maximum Armor sagen kann? Weil die grafische Qualität derartig grandios und brillant ist, dass man die Gegner vor lauter Staunen schlicht vergisst. Denn die Macher von Far Cry ziehen in Crysis alle Register, die in Sachen bombastischer und phänomenaler Inszenierung nur denkbar sind. Von HDR Rendering, Depth of Field, Motion Blur und Parallax-Occlusion-Mapping über ein unglaublich realistisches Pixelnass und eine lebensechte Vegetation samt Soft Shadows bis hin zu einer Physik, die es erlaubt, nahezu alles in seine Einzelteile zu zerlegen, bietet der wohl am meisten erwartete Shooter aller Zeiten jede erdenkliche technische Facette, die ein Spiel aktuell überhaupt bieten kann. Dröhnende Explosionen mit Hitzeflimmern sowie volumetrischem Rauch und hämmernde Schüsse aus den AK-47 der gerissenen KI-Recken perfektionieren das auch spielerisch umwerfende Produkt aus Deutschland. Doch Crysis lässt nicht nur die Sehnerven kapitulieren, sondern bringt problemlos auch die schnellste verfügbare Hardware ans absolute Limit - das ist der Preis, den man für maximalen Grafikgenuss zahlen muss. Die SinglePlayer Demo bringt den hier genutzten GPU-Benchmark mit sich, welcher die InGame Performance gut abbildet - das eigentliche Spiel läuft allerdings des öfteren rund 20% langsamer als der GPU-Bench..

Einzig die X1900XT erzielt in 1280*1024 noch einigermaßen spielbare Werte mit mittleren Details, Besitzer einer der beiden X1950er müssen sich mit 1024*768 zufrieden geben. Es fällt auf, dass "middle" rund doppelt so schnell läuft wie "high", die Leistungsfresser sind aber schnell gefunden: Senkt man ausgehend von allem auf "high" die für die optische Brillanz sehr entscheidenden Shader und die Schatten auf "middle" (mittlere Schatten sehen kaum schlechter aus als auf "high"), springen die fps um 60%, ergänzt man noch mittlere Objektdetails, sind es gar über 80% mehr fps - die restlichen Optionen sollte man auf "high" lassen, gerade eine verringerte Physik trübt den Spielspaß unverhältnismäßig stark.

Maximale Optik bzw. "very high", welches sonst nur unter DX10 läuft, halbiert die Framerate ausgehend von "high", um diesen Detailreichtum flüssig darzustellen muss ein 8800GTX/Ultra Doppel her, die 8600er Reihe ist selbstredend absolut untauglich für DX10.

! Maximale Details, d.h. "very high", wurden per editierter game.cfg erzielt, diese game.cfg und weitere Benchmarks von CPUs und (V)RAM sowie zusätzliche Bilder und Infos finden sich in Post#26

Einzig die X1900XT erzielt in 1280*1024 noch einigermaßen spielbare Werte mit mittleren Details, Besitzer einer der beiden X1950er müssen sich mit 1024*768 zufrieden geben. Es fällt auf, dass "middle" rund doppelt so schnell läuft wie "high", die Leistungsfresser sind aber schnell gefunden: Senkt man ausgehend von allem auf "high" die für die optische Brillanz sehr entscheidenden Shader und die Schatten auf "middle" (mittlere Schatten sehen kaum schlechter aus als auf "high"), springen die fps um 60%, ergänzt man noch mittlere Objektdetails, sind es gar über 80% mehr fps - die restlichen Optionen sollte man auf "high" lassen, gerade eine verringerte Physik trübt den Spielspaß unverhältnismäßig stark.

Maximale Optik bzw. "very high", welches sonst nur unter DX10 läuft, halbiert die Framerate ausgehend von "high", um diesen Detailreichtum flüssig darzustellen muss ein 8800GTX/Ultra Doppel her, die 8600er Reihe ist selbstredend absolut untauglich für DX10.

! Maximale Details, d.h. "very high", wurden per editierter game.cfg erzielt, diese game.cfg und weitere Benchmarks von CPUs und (V)RAM sowie zusätzliche Bilder und Infos finden sich in Post#26

FEAR

Wer Angst vor kleinen Mädchen hat, sollte Monoliths Schocker im Regal stehen lassen, die Schreckmomente sorgen für eine drastisch erhöhte Pulsfrequenz. Die Grafik lässt das Blut zwar ebenfalls in Wallung geraten, aber nicht aus Angst, sondern vor allem dank der Soft Shadows und den wahnwitzigen Partikeleffekten - nie war der Einsatz der Schrotflinte auf surreale Art und Weise schöner und effektvoller als mit aktivierter Zeitlupe, raumkrümmenden Explosionen samt Druckwelle und sirrenden Kugeln, die satt in Gegner und Wand einschlagen - bröckelnden Putz inklusive.

Die Lith-Tech-Engine frisst Shaderpower zum Frühstück, sämtliche Karten sortieren sich über alle Auflösungen hinweg exakt nach ihrer GFLOP Leistung ein, die X1950GT bildet die Ausnahme. Klarer Spitzenreiter ist die X1900XT, die den kleinen Bruder um satte 29% abhängt. Eben diese X1950Pro liegt bis zu 11% vor der drittplazierten 7950GT und 15% vor der X1950GT, die XFX hat das Nachsehen und reiht sich 10% hinter der 7950GT ein. Spannend ist der Vergleich der 7900GS und 7900GT, letztere verfügt über ein Pixel-Quad und einen Vertex Shader mehr, ist aber ansonsten identisch. Die 20% mehr theoretische GFLOP/s werden in 12% mehr fps umgemünzt. Auch in FEAR gilt, nur die X1900XT schafft es, die hohe Auflösung mit Kantenglättung und anisotroper Filterung einigermaßen flüssig zu bewältigen - deaktiviert man die Soft Shadows, springen bei allen Karten rund 30% mehr fps heraus, nur die 7900GS und 7900GS bieten weiter kaum spielbare Leistung.

Die Lith-Tech-Engine frisst Shaderpower zum Frühstück, sämtliche Karten sortieren sich über alle Auflösungen hinweg exakt nach ihrer GFLOP Leistung ein, die X1950GT bildet die Ausnahme. Klarer Spitzenreiter ist die X1900XT, die den kleinen Bruder um satte 29% abhängt. Eben diese X1950Pro liegt bis zu 11% vor der drittplazierten 7950GT und 15% vor der X1950GT, die XFX hat das Nachsehen und reiht sich 10% hinter der 7950GT ein. Spannend ist der Vergleich der 7900GS und 7900GT, letztere verfügt über ein Pixel-Quad und einen Vertex Shader mehr, ist aber ansonsten identisch. Die 20% mehr theoretische GFLOP/s werden in 12% mehr fps umgemünzt. Auch in FEAR gilt, nur die X1900XT schafft es, die hohe Auflösung mit Kantenglättung und anisotroper Filterung einigermaßen flüssig zu bewältigen - deaktiviert man die Soft Shadows, springen bei allen Karten rund 30% mehr fps heraus, nur die 7900GS und 7900GS bieten weiter kaum spielbare Leistung.

Half Life² - Lost Coast

Die verlorene Küste glänzt im wahrsten Sinne des Wortes - Valve verwendet hier erstmals HDR in der Source-Engine. Zusammen mit hochauflösenden Texturen ist Lost Coast recht anspruchsvoll und stellt anschaulich die Leistung der kommenden Episode Two dar. Die Timedemo deckt die komplette Szenerie ab, los geht es unten bei dem alten Fischer, über die umkämffte Steilwand bis in den lichtdurchluteten Innenhof.

Valves Source Engine liegt den Radeons, das ist altbekannt, doch aufgrund der ebenfalls bekannten und für einen Shooter relativ hohen CPU-Limitierung kann sich die gerade die X1950Pro nicht weit absetzen, die X1950GT liegt sogar minimal hinter der XFX. Doch gerade die 7900GT gewinnt einen klaren Vorsprung vor der 7900GS, die XFX und die 7950GT trennen nur wenige fps zugunsten der 512Mb Karte - die Demo verlangt nach 270Mb VRAM.

Valves Source Engine liegt den Radeons, das ist altbekannt, doch aufgrund der ebenfalls bekannten und für einen Shooter relativ hohen CPU-Limitierung kann sich die gerade die X1950Pro nicht weit absetzen, die X1950GT liegt sogar minimal hinter der XFX. Doch gerade die 7900GT gewinnt einen klaren Vorsprung vor der 7900GS, die XFX und die 7950GT trennen nur wenige fps zugunsten der 512Mb Karte - die Demo verlangt nach 270Mb VRAM.

Prey

Der innovative Shooter rund um den Indianer Tommy, der seine Freundin und sich vor Aliens rettet, basiert auf Doom 3 Engine von id Software, welche erstmals im namensgebenden Horrorspiel zum Einsatz kam. Stencil Shadows und sehr organische Strukturen machen die Hatz durch fremde Welten optisch zu einem Genuss, die verwendete Timedemo führt den Cherokee durch den ersten Level, einige Gänge mit Licht und Schatten

sowie zwei Kämpfe mit kleineren Aliens, zeigen das Potential der OpenGL Engine.

Erwartungsgemäß kann sich die Geforce Riege gegen die X1950Pro gut behaupten und in Führung setzen, die X1950GT ist allerdings genauso wie die 7900GS etwas abgeschlagen. Human Head Studios Werk ist nicht allzu shaderlastig, daher kann sich die 7900GT kaum von der 7900GS absetzen, die XFX aber spielt ihre Rohpower aus und erkämpft sich erstmals den zweiten Platz, jedoch muss sie mit AA/AF Federn lassen. Prey ist zwar selbst mit der schwächsten Karte, der X1950GT, noch bei bester Qualität flüssig spielbar, für kommende Titel mit der Doom 3 Engine sollte es aber eher eine 7950GT oder schneller sein.

sowie zwei Kämpfe mit kleineren Aliens, zeigen das Potential der OpenGL Engine.

Erwartungsgemäß kann sich die Geforce Riege gegen die X1950Pro gut behaupten und in Führung setzen, die X1950GT ist allerdings genauso wie die 7900GS etwas abgeschlagen. Human Head Studios Werk ist nicht allzu shaderlastig, daher kann sich die 7900GT kaum von der 7900GS absetzen, die XFX aber spielt ihre Rohpower aus und erkämpft sich erstmals den zweiten Platz, jedoch muss sie mit AA/AF Federn lassen. Prey ist zwar selbst mit der schwächsten Karte, der X1950GT, noch bei bester Qualität flüssig spielbar, für kommende Titel mit der Doom 3 Engine sollte es aber eher eine 7950GT oder schneller sein.

Unreal Tournament 3

Double Kill, Multi Kill, Monster Kill - das neue Unreal Tournament 3 lässt ein Grinsen übers Gesicht wandern. Das Spielprinzip, die Waffen und der Sound ähneln dem hochgelobten Vorgänger, neu ist die bombastische Unreal Engine 3. Diese bietet dank des Deferred-Shading Renderers, Virtual-Displacement-Mapping, grandiosen Texturen und sanften Schatten eine phänomenale Optik, geht allerdings überraschenderweise nicht allzu Hardwarefressend zu Gange - wohl auch deswegen, weil in der Demo mittlere Details und Texturen das Höchste der Gefühle sind. Auf der Map Shangri La müssen sich fünf Masterfull-Bots vermöbeln lassen - drei Minuten reichen um ihnen zu zeigen, wer's wirklich drauf hat.

UT3 ist eine Bank für die Radeons, vor allem die X1900XT prescht mit bis zu 39% Vorsprung der X1950Pro davon, welche wiederum deutliche 20& vor der X1950GT und ebenso deutliche 25% vor der XFX landet. Die 7950GT muss sich der XFX um 1-2fps geschlagen geben, ist der normalen 7900GS aber um 45% voraus. Mit minimalen Details kratzt die X1900XT bereits an der Obergrenze von 64fps - mehr lässt UT3 aufgrund eines Framelocks ohnehin nicht zu.

UT3 ist eine Bank für die Radeons, vor allem die X1900XT prescht mit bis zu 39% Vorsprung der X1950Pro davon, welche wiederum deutliche 20& vor der X1950GT und ebenso deutliche 25% vor der XFX landet. Die 7950GT muss sich der XFX um 1-2fps geschlagen geben, ist der normalen 7900GS aber um 45% voraus. Mit minimalen Details kratzt die X1900XT bereits an der Obergrenze von 64fps - mehr lässt UT3 aufgrund eines Framelocks ohnehin nicht zu.

World in Conflict

Der kalte Krieg ist vorbei? Mitnichten, World in Conflict macht ihn mit sehenswerten, herrlichen rauchigen Explosionen, grandioser Beleuchtung und knackigen Texturen heiß und aktuell wie nie zuvor. Zusammen mit der ebenfalls gelungenen Physiksimulation ist diese Engine ein harter Brocken für das komplette System.

Der kalte Krieg wird heiß und die Russen stürmen die USA. Und genauso wie die Russen die sonst übermächtige USA überrennt, zeigen die Geforces den bisher oft übermächtigen Radeons wo Hammer und Sichel hängen. Die X1950GT ist in 1024*768 die langsamste Karte, die XFX ist 23% schneller, muss sich aber um ein fps der X1900XT beugen - praktisch ist mit allen Karten aber ohnehin nur die kleinste Auflösung flüssig. Vor allem der "langsame" Prozessor verhindert höhere Ergebnisse, denn wenn die Atombombe einschlägt, verharren alle GPUs bei rund 10fps und staunen ob der Zerstörungsgewalt. Die beiden 512Mb Karten erreichen prozentual gesehen deutlich "höhere" minimum fps, der Benchmark benötigt über 340 Videospeicher - das können die nur mit 256Mb ausgestatteten Karten nicht lokal decken.

Der kalte Krieg wird heiß und die Russen stürmen die USA. Und genauso wie die Russen die sonst übermächtige USA überrennt, zeigen die Geforces den bisher oft übermächtigen Radeons wo Hammer und Sichel hängen. Die X1950GT ist in 1024*768 die langsamste Karte, die XFX ist 23% schneller, muss sich aber um ein fps der X1900XT beugen - praktisch ist mit allen Karten aber ohnehin nur die kleinste Auflösung flüssig. Vor allem der "langsame" Prozessor verhindert höhere Ergebnisse, denn wenn die Atombombe einschlägt, verharren alle GPUs bei rund 10fps und staunen ob der Zerstörungsgewalt. Die beiden 512Mb Karten erreichen prozentual gesehen deutlich "höhere" minimum fps, der Benchmark benötigt über 340 Videospeicher - das können die nur mit 256Mb ausgestatteten Karten nicht lokal decken.

Performancerating

Hier werden nun sämtliche Ergebnisse gemittelt und man kann das durchschnittliche Potenzial der jeweiligen GPU ablesen - der 3D Mark und Crysis bleiben außen vor.

Das Resultat ist eindeutig, die XFX ist einer 7950GT absolut ebenbürtig, beide müssen sich aber um bis zu 12% der X1950Pro geschlagen geben, zur X1900XT fehlen 39%. Letztere kann sich um maximal 24% vom kleinen Bruder X1950Pro lösen, die langsamste X19x0, die GT, ordnet sich maximal 11% hinter der Pro-Version ein. Die normale 7900GS unterliegt aufgrund der fehlenden Funktionseinheiten der 7900GT um rund 9%, die von XFX aufgedonnerte Version schnellt mit 20% weit davon. Auch die 512Mb der 7950GT machen sich dezent bemerkbar, die minimum fps sind mit fordernden Settings etwas höher. Das die Unterschiede nicht deutlicher ausfallen, liegt vor allem an den beiden Spielen UT3 und WiC, hier bremst der verwendete Prozessor alle Karten aus und limitiert die Benchmarks.

5) Schlusswort

XFX hat eine interessante Karte in petto, die Radeon X1950Pro ist rund 15€ teurer, jeodch 12% schneller. Die leicht schlechtere Bildqualität der Geforce verblasst nahezu, denn für anisotrope Filterung und Kantenglättung fehlt ohnehin oft genug die Power, gerade bei aktuellen Titeln. Als Manko bleibt eindeutig der laute Lüfter, ein Zalman VF-700Cu sorgt hier für Ruhe, aber auch einen 15€ höheren Preis - hierfür bekommt man schon eine leise Palöit X1950GT/512. Wer ein klein wenig sparen möchte, ein schwaches Netzteil und schlechte Ohren hat und ohnehin nur in 1024*768 spielt, kann zur XFX greifen, der Rest hält sich an die übliche Antwort: "Kauf dir eine X1950Pro (oder X1950GT^^)".

cYa

Kritik und Feedback wie immer erwünscht!

An dieser Stelle geht noch ein Dankeschön an Felix "BurnoutHerbert" E., John V. und Tom W. für die Bereitstellung ihrer Grafikkarten!

Zuletzt bearbeitet: